面對數據中心高能耗,是“逃離”還是“自我革命”

在許多人看來,IT行業是一個嚴謹、縝密甚至有些死板的行業,但這并不代表IT圈就沒有“腦洞大開”的創意,比如:把數據中心建在海底。

“腦洞大開”背后的功耗成本壓力

2013年,微軟啟動了名為“納提克”的海底數據中心研究計劃。2015年,在加利福尼亞海岸約30英尺深的海底,通過將服務器部署在一個重達38000磅,長10英尺,寬7英尺的集裝箱中,微軟啟動了長達105天的可行性驗證,最終證實“非常成功”。

現實中,不光是海底,在南極和北極都已出現IDC的身影,例如美國國家科學基金會的南極數據中心和Facebook位于北極圈以南100公里的瑞典呂勒奧鎮數據中心。從海底到極地,數據中心這么拼,到底為哪般?

其實這些看似“腦洞大開”的背后,是對數據中心高能耗導致運營成本激增的無奈。

數據中心能耗到底有多高?

目前的數據中心主要是以高密度,大型化為發展趨勢。2016年,超過100個機架以上的數據中心的占比將超過60%.以3000個機架的數據中心為例,以每個機架平均功率如果按照3kW計算,其總負荷就將達到9000kW,全年的耗電量將達到78840000kWh,電費支出超過7800萬元。加之配套設備,電費將接近1.5億。

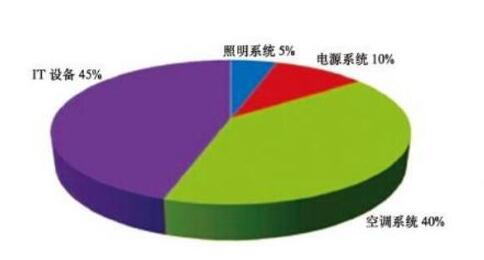

那么數據中心的電都被誰“吃”了?數據中心能耗主要來源于IT 設備、照明系統、空調系統、供配電系統等。其中IT設備的能耗約占總功耗的約45%,空調制冷系統占40%,供電系統10%,照明系統5%左右。可以看到IT設備和制冷系統是用電的大戶,這也是為什么***互聯網企業的數據中心會嘗試進入極地,因為那里的溫度足夠低,可以通過外界的冷空氣或者冷水進行散熱,省去空調制冷的能耗,電力消耗將減少40%,對于擁有海量服務器的數據中心而言,這是何等大的成本節省。

“留守”數據中心的自我革命

雖然將數據中心向極地遷移是節省能耗的有效措施,但是對于絕大多數的企業數據中心而言,這是不可能的。首先,遷移數據中心需要巨大的財力支撐,新建數據中心廠房、建設配套設施、雇傭運維人員等成本可能已經遠超數據中心本身的能耗成本。第二,新風系統或者海水冷卻的設計和可靠性驗證也不是一朝一夕可以完成。因此目前大部分數據中心仍然“留守”在城市的郊區或者稍靠北方的地域。

那么這些“留守”下來的數據中心就無法降低功耗成本了么?從數據中心能耗的占比來看,45%的用電量是由IT設備產生的,雖然作為核心單元,無法將IT設備的功耗將為0,但是盡***可能將IT設備的能耗控制在可接受的范圍內,也是降低數據中心能耗成本的重要手段,這是數據中心內部發起的“自我革命”。

先來看下中國x86服務器的類型占比,我們姑且將單路、雙路的機架式和塔式服務器算作是計算存儲均衡型或偏存儲服務器,將刀片式和高密度服務器算作偏計算型服務器,那么根據IDC 2016Q3的數據顯示,2016Q1-Q3中國市場計算存儲均衡型或偏存儲型服務器的出貨量超過130萬臺,而偏計算型服務器僅為20萬臺。計算密集型服務器依靠高主頻、高密度來實現價值,我們從中降低的能耗較少,而占據市場86%的偏存儲型服務器則大有可為。

如何讓90%的數據降低存儲能耗

據HGST的研究表明,在數據中心里只有10%-15%的數據是被經常訪問的,而其他全部是“冷數據”。對這些海量的“冷數據”,部分企業仍然采用2U機架式服務器進行存儲,但效果往往是“大馬拉小車”。一方面,2U最多支持12塊3.5寸硬盤,均攤到每TB的成本較高;另一方面,“冷數據”的低訪問率意味著其對CPU、內存、網絡、PCIe擴展等性能要求不高。如果將其和溫數據,甚至是熱數據擠在一個“房間”,那么帶來的后果只能是機房投入、功耗及運維成本的居高不下,難以做到資源的***化配置。

因此,對互聯網企業而言,尤其是隨著大數據時代的來臨,如何實現數據的分級存儲,為占據90%數據總量的“冷數據”找到最合適的“家”,是困擾企業已久的難題。而那些具有市場敏感性的服務器廠商,也適時推出了化解“冷存儲”困境的產品.

前金山云CTO楊鋼曾經指出:“作為存儲服務提供商,我們的職責是把用戶的數據存好,并且在用戶想要使用的時候快速拿出來。但同時,我們也要盡可能地降低存儲成本。”可以說,用作“冷存儲”的服務器需要對性能、功耗、成本、安全等每一項指標都做到精打細算,***實現各項指標的平衡,因此其開發難度并不低,這也是為什么業界大多數4U36盤位機型定位在溫熱數據存儲的原因。