10行代碼爬取微信公眾號文章評論

10 行代碼就能把公眾號文章評論爬下來,有點聳人聽聞?如果我跟你說是用 Python 實現(xiàn)的,你可能會信了,因為 Python 確實很強大,寫個簡單爬蟲真的只要幾行代碼就可以搞定,這次爬的是微信的數(shù)據(jù),相對來說要麻煩一點。這里討論的是如何爬自己公眾號下面文章的評論,有人說別人文章能抓取嗎?理論上都可以,但凡是你能看到的都可以爬,不過,這篇文章討論的是自己文章,思路都是相通的,希望本文可以給你一些啟迪。

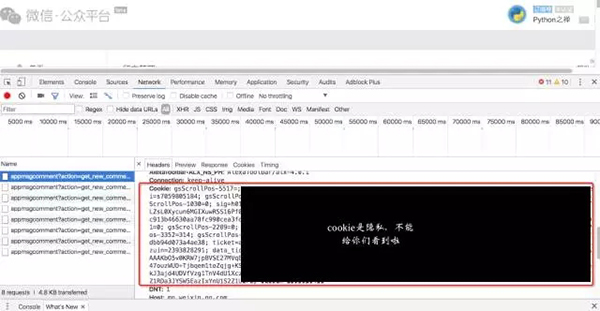

1. 獲取Cookie

因為是爬自己微信號文章里面的評論,首先你需要登錄公眾號后臺,登錄后才能看到文章的評論,登錄就會涉及到 cookie,發(fā)起請求時只有帶上 cookie 才能得到正確的數(shù)據(jù)。所以***步就是把 cookie 信息取到。

打開 Chrome 瀏覽器你會看到發(fā)送請求時會自動把 Cookie 信息發(fā)送給微信,我們就把這段 Cookie 數(shù)據(jù)拷貝出來,用 Python 構(gòu)建一個 Cookie 對象,給 requests 使用。

- from http.cookies import SimpleCookie

- raw_cookie = "gsScrollPos-5517=; ..中間還省略很多... bizuin=2393828"

- cookie = SimpleCookie(raw_cookie)

- requests_cookies = dict([(c, cookie[c].value) for c in cookie])

- r = requests.get(url, cookies=requests_cookies)

2. 構(gòu)造URL

打開任意文章的評論列表,你會發(fā)現(xiàn)它的 URL 結(jié)構(gòu)非常清晰,根據(jù)名字基本能判斷每個參數(shù)的意義,這里比較重要的參數(shù)是 begin,它是作為分頁的起始位置,其實它固定不變就好

- url = "https://mp.weixin.qq.com/misc/appmsgcomment?" \

- "action=list_comment&" \

- "mp_version=7&" \

- "type=0&" \

- "comment_id=2881104117&" \ # 被評論的文章ID

- "begin=0&" \ # 分頁參數(shù)

- "count=10&" \ # 每次返回10條評論

- "token=1300595798&" \

- "lang=zh_CN"

3. 抓取數(shù)據(jù)

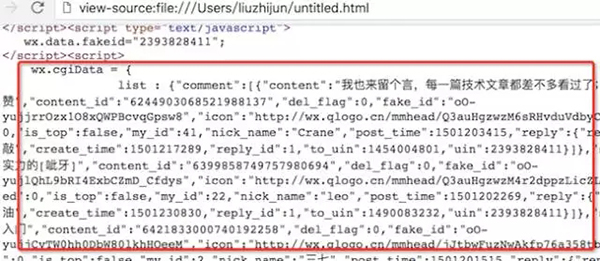

把 Cookie 和 URL 都搞清楚了,就可以把模擬瀏覽器抓取數(shù)據(jù)并進行清洗,開始想著用 BeautifulSoup 來解析網(wǎng)頁,結(jié)果失敗了。

查找了原因,把爬下來的頁面另存為 html 文件,在 html 源代碼文件中找留言里面的關(guān)鍵字,發(fā)現(xiàn)評論并沒有在 div 標簽中,而是存在于一段 JS 代碼塊中,看起來像 JSON 數(shù)據(jù),看來數(shù)據(jù)是在本地用 JavaScript 渲染后顯示的。

于是改用正則表達式,截取需要的數(shù)據(jù),最終存儲數(shù)據(jù)庫,差不多10代碼搞定。

- def main():

- # 普通留言, 精選留言總數(shù)

- normal_count, selected_count = 141, 100

- # 普通留言url

- normal_url = "https://mp.weixin.qq.com/misc/appmsgcomment?"

- dd = dict([(normal_count, selected_url)])

- for k, v in dd.items():

- crawler(k, v)

- def crawler(count, url):

- for i in range(0, count, 10):

- r = requests.get(url.format(begin=i), cookies=requests_cookies)

- match = re.search(r'"comment":(\[\{.*\}\])', r.text, re.S)

- if match:

- data = json.loads(match.group(1), encoding="utf-8")

- conn.insert_many(data)

- time.sleep(1)

【本文是51CTO專欄作者“劉志軍”的原創(chuàng)文章,作者微信公眾號:Python之禪(VTtalk)】