重新審視深度學習時代數據的非理性效果

過去十年里,計算機視覺領域取得了巨大成功,這在很大程度上得直接歸功于深度學習模型在機器感知任務中的應用。

此外,自 2012 年以來,這些系統的表征能力取得了長足的進步,這歸因于:

(a) 極為復雜的更深度模型的建立;

(b) 計算能力不斷提升;

(c) 可獲得大規模的標注數據。

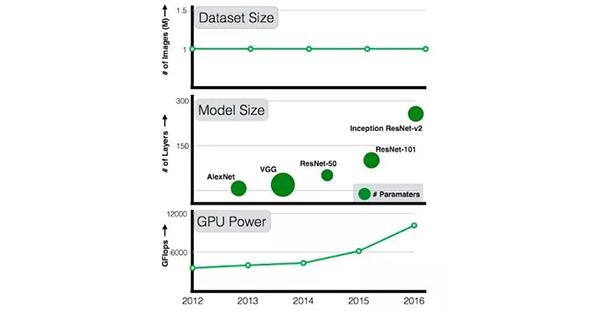

盡管計算能力和模型復雜度每年都在不斷提升(已從 7 層的 AlexNet 提高到 101 層的 ResNet),但可用數據集并未得到相應的擴充。與 AlexNet 相比,101 層的 ResNet 的容量要大得多,但它仍在使用同樣從 ImageNet circa 2011 獲取的 100 萬張圖像進行訓練。作為研究人員,我們一直想知道:如果將訓練數據量擴大 10 倍,準確率是否會翻倍?擴大 100 倍甚或 300 倍,準確率又會如何?準確率是否會遭遇平臺期?還是說數據越多,準確率就越高?

過去五年里,GPU 的計算能力和模型大小在不斷提高,但令人吃驚的是,***的培訓數據集的規模卻停滯不前。

在我們的《重新審視深度學習時代數據的非理性效果》(Revisiting Unreasonable Effectiveness of Data in Deep Learning Era) 這篇論文中,我們在揭開圍繞“海量數據”和深度學習之間關系的謎團方面邁出了***步。我們的目標是探究以下問題:

(a) 向現有算法提供更多帶有噪聲標簽的圖像是否仍可以改善視覺表征;

(b) 分類、對象檢測和圖像分割等標準視覺任務中,數據與性能之間的本質關系;

(c) 通過大規模學習找到適用于計算機視覺領域所有任務的***進模型。

當然,一個無法回避的問題是我們從何處獲取一個比 ImageNet 大 300 倍的數據集?在 Google,我們一直致力于自動構建此類數據集以改善計算機視覺算法。具體而言,我們已構建一個包含 3 億張圖像的內部數據集(我們稱之為 JFT-300M),這些圖像被標記為 18291 個類別。用于標記這些圖像的算法使用了復雜的數據組合,包括原始網絡信號、網頁與用戶反饋之間的聯系等。這為 3 億張圖像生成了 10 億多個標簽(一張圖像可具有多個標簽)。為***程度提高所選圖像的標簽精度,我們通過某個算法從 10 億個圖像標簽中選取了大約 3.75 億個標簽。然而,這些標簽中仍然存在大量噪聲:所選圖像的標簽中約有 20% 帶有噪聲。由于缺乏詳盡的注解,我們無法評估標簽的回想率。

我們的實驗結果證實了部分假設,但也產生了一些意外的驚喜:

- 更好的表征學習確實大有裨益。 我們的***個觀察結果是大規模數據有助于表征學習,進而改善了我們研究的每個視覺任務的性能表現。我們的研究發現表明:共同構建一個大規模數據集進行預訓練非常重要。同時,實驗也表明,無監督和半監督表征學習方法的前景非常光明。數據規模似乎可克服標簽方面的噪聲問題。

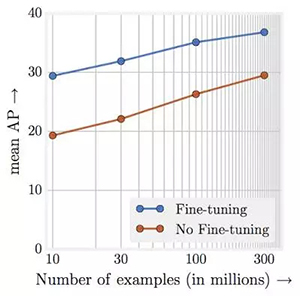

- 表現與訓練數據的數量級呈線性遞增關系。 也許整個實驗最驚人的發現就是視覺任務的表現和用于表征學習的訓練數據量(對數)之間的關系了。我們發現它們之間的關系竟然是線性的!即使訓練圖像達到 3 億張,我們也并未觀察到對所研究的任務產生任何平臺效應。

通過針對 JFT-300M 的不同子集從零開始進行預訓練時的對象檢測性能。X 軸是以對數表示的數據集大小,y 軸代表針對 COCO-minival 子集的 mAP@[.5,.95] 檢測性能。

- 容量至關重要。我們同樣觀察到:為了充分利用 3 億張圖像,我們需要更高的容量(更深的)模型。例如,就 ResNet-50 而言,其在 COCO 對象檢測基準測試中的增益 (1.87%) 大大低于使用 ResNet-152 時的增益 (3%)。

- 新的***結果。我們的論文展示了通過使用從 JFT-300M 學到的模型在多個基準中取得了新的***結果。例如,單一模型(沒有任何不必要的花哨功能)在 COCO 檢測基準測試中從原來的 34.3 AP 提高到現在的 37.4 AP。

請注意,我們使用的訓練機制、學習安排和參數都是基于我們使用來自 ImageNet 的 100 萬張圖像對 ConvNets 進行訓練后所獲得的認識。由于我們在此項工作中并未搜索***超參數集(這需要極為龐大的計算量),所以在使用這種規模的數據時,這些結果很可能并不是您能夠取得的***結果。因此,我們認為報告的量化表現低估了數據的實際影響。

這項工作并不會關注特定任務的數據,例如探究更多的邊界框是否會影響模型表現等。我們認為,雖然獲取大規模特定于任務的數據非常困難,但它應該成為未來研究的重點。此外,構建包含 3 億張圖像的數據集不應該是我們的***目標,作為一個社區,我們要探索的是,在采用更大規模的數據集(擁有 10 億張以上的圖像)時,是否可以繼續改善模型。

【本文是51CTO專欄機構“谷歌開發者”的原創稿件,轉載請聯系原作者(微信公眾號:Google_Developers)】