Docker Compose + GPU + TensorFlow 所產生的奇妙火花

Docker 很棒——越來越多的人在開發與分布中使用它。Docker 有很多優勢:即時環境設置、獨立于平臺的 app、現成的解決方案、更好的版本控制、簡化的維護。

但是在數據科學和深度學習方面,使用 Docker 有一些阻礙。你必須記住所有的 Docker 標志,以在主機和容器之間共享端口和文件,創建不必要的 run.sh 腳本,并處理 CUDA 版本和 GPU 共享。如果你曾經見過下面這個錯誤,你就會明白這種痛苦:

- $ nvidia-smi

- Failedto initialize NVML:Driver/library version mismatch

我們的目標

本文的目的在于為你介紹一系列 Docker 實用工具,以及我們經常在公司使用的 GPU-ready 樣板文件。

因此,以下結果將不會出現:

- docker run

- --rm

- --device /dev/nvidia0:/dev/nvidia0

- --device /dev/nvidiactl:/dev/nvidiactl

- --device /dev/nvidia-uvm:/dev/nvidia-uvm

- -p 8888:8888

- -v `pwd`:/home/user

- gcr.io/tensorflow/tensorflow:latest-gpu

取而代之的是這種結果:

- doc up

酷!

我們實際上想要達到的:

- 通過一個指令管理我們的應用程序狀態(運行、停止、移除)

- 把所有的運行標志保存到我們能夠提交到 git repo 的單個配置文件

- 忘記 GPU 驅動程序版本不匹配和共享

- 在生產工具比如 Kubernetes 或 Rancher 中使用 GPU-ready 的容器

因此,這里是我們強烈推薦給每個深度學習者的工具清單:

1. CUDA

首先,你需要 CUDA 工具包,如果你打算自己動手訓練模型,那這是必須要有的。我們推薦使用 runfile 安裝程序類型而不是 deb,因為它不會在以后的更新中混淆依賴關系。

(可選)如何檢查它是否工作:

- cd /usr/local/cuda/samples/1_Utilities/deviceQuery

- make

- ./deviceQuery #Shouldprint "Result = PASS"

2. Docker

你不想讓海量的庫污染你的計算機,也害怕版本出現問題。同樣,你不必親自構建和安裝——通常,軟件已為你創建好了,并包裝在圖像中。安裝 Docker 很簡單:

- curl -sSL https://get.docker.com/ | sh

3. Nvidia Docker

如果使用 Docker,必須有來自英偉達的實用程序(https://github.com/NVIDIA/nvidia-docker),它真正簡化了在 Docker 容器內使用 GPU 的步驟。

安裝非常簡單:

- wget -P /tmp https://github.com/NVIDIA/nvidia-docker/releases/download/v1.0.1/nvidia-docker_1.0.1-1_amd64.deb

- sudo dpkg -i /tmp/nvidia-docker*.deb

現在,不用每次都用下列方式來共享英偉達設備:

- docker run --rm --device /dev/nvidia0:/dev/nvidia0 --device /dev/nvidiactl:/dev/nvidiactl --device /dev/nvidia-uvm:/dev/nvidia-uvm nvidia/cuda nvidia-smi

你可以使用 nvidia-docker 命令:

- nvidia-docker run --rm nvidia/cuda nvidia-smi

同樣,你也無需擔心驅動程序版本不匹配:英偉達的 docker 插件將會幫你解決問題。

4. Docker Compose

超級有用的實用程序,允許你在文件中存儲 docker run 配置,并更輕松地管理應用程序狀態。盡管它的設計目的是組合多個 docker 容器,但 docker compose 在你只有一個服務的時候依然非常有用。這里有一個穩定版本

(https://github.com/docker/compose/releases):

- curl -L https://github.com/docker/compose/releases/download/1.15.0/docker-compose-`uname -s`-`uname -m` > /usr/local/bin/docker-compose

- chmod +x /usr/local/bin/docker-compose

5. Nvidia Docker Compose

不幸的是,Docker Compose 并不知道 Nvidia Docker 的存在。幸運的是,有一個解決方法:有一個小的 Python 腳本,可以用 nvidia-docker 驅動程序生成配置。通過 pip 安裝 Nvidia Docker Compose:

- pip install nvidia-docker-compose

現在你可以使用 nvidia-docker-compose 命令,而不是 docker-compose 了。

替代選擇

如果你不想使用 nvidia-docker-compose,你可以手動傳遞音量驅動程序,只需把這些選項添加到 docker-compose.yml:

- #Yournvidia driver version here

- volumes:

- nvidia_driver_375.26:

- external:true

- ...

- volumes:

- -nvidia_driver_375.26:/usr/local/nvidia:ro

6. Bash 別名

但是 nvidia-docker-compose 需要輸入 21 個字符,這太多了。

很幸運我們可以使用 bash 別名。在你最喜愛的編輯器打開~/.bashrc(有時是~/.bash_profile),輸入以下代碼行:

- alias doc='nvidia-docker-compose'

- alias docl='doc logs -f --tail=100'

通過運行 source ~/.bashrc 更新你的設置。

開始 TensorFlow 服務

現在我們準備好利用上述所有工具的優點。比如,我們運行一個 Tensorflow GPU 啟用的 Docker 容器。

在項目目錄中創建具有以下內容的 docker-compose.yml 文件:

- version:'3'

- services:

- tf:

- image:gcr.io/tensorflow/tensorflow:latest-gpu

- ports:

- -8888:8888

- volumes:

- -.:/notebooks

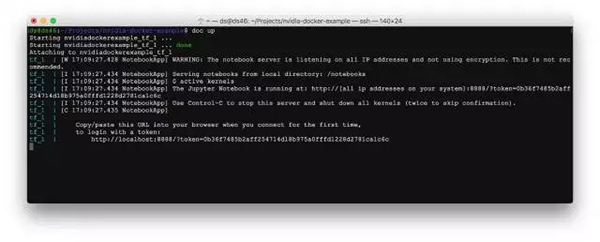

現在我們可以使用單個命令開始 TensorFlow Jupiter:

- doc up

doc 是 nvidia-docker-compose 的別名——它將使用正確的 volume-driver 生成已修改的配置文件 nvidia-docker-compose.yml,然后運行 docker-compose。

你可以使用相同的命令管理你的服務:

- doc logs

- doc stop

- doc rm

- #...etc

結論

但是這值得嗎?下面讓我們看一下其優缺點。

優點

- 無需考慮 GPU 設備共享

- 不必再為英偉達驅動程序版本擔憂

- 擺脫了偏愛干凈、簡單配置的命令標志

- 再也不需要--name 標志管理容器狀態

- 眾所周知已記錄并得到廣泛使用的實用程序

- 你的配置已為編制工具做好準備,比如理解 docker-compose 文件的編制工具 Kubernetes

缺點

- 你不得不安裝更多工具

它是生產就緒(production-ready)的嗎

是的。在電影推薦應用 Movix 中,我們使用 GPU 加速的 TensorFlow 網絡基于用戶輸入計算實時的電影選擇。

我們在 Proxy API 的 Rancher 集群中有三臺帶有 Nvidia Titan X 的電腦。配置儲存在常規 docker-compose.yml 文件中:因此在一個新服務器上部署應用程序或者設置開發環境變得很輕松。目前為止它的表現堪稱***。

為機器學習的未來做好準備吧!

原文:https://hackernoon.com/docker-compose-gpu-tensorflow-%EF%B8%8F-a0e2011d36

【本文是51CTO專欄機構“機器之心”的原創譯文,微信公眾號“機器之心( id: almosthuman2014)”】