SDN云數據中心網絡異常行為的智能處理實踐

摘要:云數據中心的網絡異常行為不僅對網絡設備造成嚴重業務負荷,同時也顯著影響云用戶使用感知。云計算環境中的共享資源模式和云用戶迥然不同的業務形態,使得云網絡分析和異常行為定位極為困難。南方基地移動云網絡運維團隊針對云數據中心的網絡異常行為進行特征提取和分析,并基于移動云sdn數據中心的網絡架構和原理進行深度剖析,總結出一套“流表流量粗細結合”的分析策略,成功實現低成本高效率的網絡異常行為發現。同時基于devops理念,制定了一套網絡異常行為自動化檢測和封堵的智能系統,實現對網絡異常行為的快速處理。

Introduction

前言

在集團公司的大連接戰略中,云管端服務體系是數字化轉型的關鍵技術。作為云管端體系的重要環節,云計算得到大力發展。移動云(ecloud.10086.cn)是總部級公有云,其在南方基地節點具備2400臺物理主機、450臺網絡設備的硬件規模。移動云采用前沿的openstack+SDN架構,為客戶提供快捷、可靠的云服務。為實現海量的不同用戶之間相互隔離,SDN在原有基礎網絡之上構建overlay網絡來承載用戶流量。在數據中心中,海量的用戶雖相互獨立,卻共享著相同的網絡架構與基礎設施資源。在如此復雜的網絡架構下,面對用戶形態各異的業務,想要從網絡層面分析客戶的流量與業務行為,愈發困難。

1.1 客戶投訴頻發

針對云網絡投訴工單分析時發現,網絡異常行為引發的投訴占比較大。這類投訴主要有以下幾類常見形態,如云主機密碼被攥改 后無法登錄、云主機被攻擊導致拒絕服務,或者懷疑云主機被植入未知東西請求定位分析等。處理這類問題極為棘手,從回溯云主機過往流量來定位網絡異常行為,進階追蹤異常流量來源,并提供有效數據讓客戶配合整改等,每個環節不僅需要依賴于昂貴的專業網絡分析工具,同時還耗費較多的運維時間和人力。在網絡分析工具未采集和保存相關異常流量的情況,異常流量無法深層次展開分析,會出現問題無法解決的極端情況。

1.2 網絡設備負荷大且網絡使用感知差

在云網絡環境中倘若沒有及時發現并封堵某個云主機的網絡異常行為,不僅會導致同一區域內的其它虛擬機有感染病毒的風險,還會對給數據中心的網絡設備帶來較重的業務負荷。前期云數據中心出現過云主機發出大量小包攻擊導致出口云防火墻達到處理能力極限引發設備模塊異常宕機,云主機發出大量無效填充數據包導致接入網絡設備鏈路達到最大閾值等多起網絡故障。網絡異常行為的連鎖影響,會降低數據中心提供的網絡服務質量,在行業和客戶中帶來負面印象。及時發現并有效封堵這類網絡異常行為,是云計算網絡運維需要盡快解決的迫切難題。

Nature

問題本質分析

從攻擊方向上來區分,云數據中心的網絡異常行為可以分為外網攻擊和內網攻擊。外網攻擊是指攻擊源來自于外網,與此相反,內網攻擊是指攻擊源來自數據中心內部。云數據中心外網攻擊問題的風險相對可控,可以通過加強邊界安全防護來應對;內網攻擊問題的風險和影響范圍則要嚴重得多。云數據中心提供的安全可靠的云主機無故變成攻擊源,用戶會質疑云服務的可靠性,引發信任危機。為什么云主機變成了攻擊源且沒有手段及時主動發現內部攻擊源,是問題關鍵。

2.1 客戶行為空間大,安全意識薄弱

首先,云數據中心提供給用戶的網絡編排服務是極為靈活的,尤其是公有云數據中心,用戶可以按需訂購路由器和防火墻等網元,也可以自由定義外部的防火墻規則和內部的云主機安全組規則。不同云租戶業務形態及重要性不同,負責運維的IT人員水平也不同。倘若有部分用戶的安全防護意識不高,例如未設置合適的安全防御規則或是操作行為管控不嚴格,其云主機可能因植入木馬或感染病毒而成為網絡攻擊源。由于云里面虛擬化層面的許多資源是共享的,內網IP主機受感染后會對其他內網主機、外網IP進行感染和攻擊,會進一步擴大感染范圍。

2.2 現有安全防護設計集中在出口

其次,受限于技術發展制約,現有安全設備虛擬化的進展相對較慢。目前較多的安全設備仍然采用傳統模式且較為集中部在數據中心出口邊界處。這種部署模式更多的是進行數據中心南北向流量的安全防御,針對數據中心內部的安全防御能力則較為薄弱。例如內網龐大的流量里遭遇小包攻擊或者是一臺虛機中了病毒開始做慢速掃描,這類網絡異常行為一般很難發現和引流出來,這樣就會把一些非常嚴重的安全事件忽略掉。

2.3 傳統網絡分析手段的制約

最后,采用傳統的網絡流量采集分析系統(包含數據中心內部的流量),通過其回溯和分析能力可以清晰定位網絡異常行為,但這是一個昂貴的解決方案。大多數云數據中心內部都是使用的萬兆以上的網絡,服務器與服務器之間的通信流量很龐大,在上百個機柜上千臺服務器的情況下,數據中心內部流量極其龐大。傳統網絡分析系統通常是幾十G的處理能力,難以滿足內部大流量需求。

Measure

云網絡異常行為的處理手段

在云數據中心構建內部和出口側全方位一體的網絡異常行為檢測系統,是解決問題的第一步,也是尤為關鍵的一步。南方基地針對網絡異常行為進行特征提取和分析,并基于移動云數據中心的網絡架構和原理進行深度剖析,總結出一套“流表流量粗細結合”的分析策略,成功實現低成本高效率的網絡異常行為發現。在云數據中心內部,數據量極為龐大的云主機數據發送端,通過匹配虛擬交換機的流表特征,初步篩選出異常虛擬機;在云數據中心核心層和出口側,數據量相對較少的網絡節點上,基于傳統網絡分析系統匹配用戶數據包的特征,精準篩選出異常虛擬機的可疑行為,并進行深層次的問題分析。

3.1 SDN組網環境介紹

移動云數據中心在四期項目中采用了SDN的網絡解決方案,以滿足網絡全自動化部署、快速配置等數據中心網絡新需求。在網絡管理平面引入了openflow流表,實現控制器對虛擬交換機的靈活控制;在網絡業務平面引入了vxlan技術,即在原有underlay網絡之上構建了一層overlay網絡,打破vlan數量制約,顯著擴展業務隔離域數量。

3.2 新的發現手段:源+出口兩手結合

我們從物理機上虛擬交換機的流表和移動云核心、出口側的流量這兩個點出發,可以實現對數據中心內部流量的全方位覆蓋,并能針對具體網絡流量進行全面。

3.2.1 虛擬交換機的流表分析

傳統數據中心內,硬件服務器是最小的計算單元;云數據中心內,虛擬機才是最小的計算單元。與傳統數據中心組網不同,云數據中心內虛擬交換機是名副其實的接入交換機,是網絡接入的第一線。采用傳統的網絡分析方法,需要通過端口鏡像的方式將流量引出到外部的網絡分析系統進行異常行為的判斷。端口鏡像的方式,會對硬件服務器的網卡性能進行對半消耗,同時對虛擬交換機的性能也有較大影響。能否在虛擬交換機上通過其它的方式來進行網絡異常行為的發現呢?剖析虛擬交換機的工作原理成為關鍵。

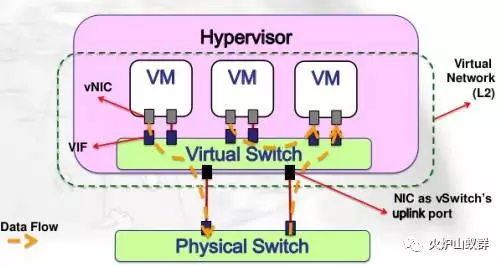

OpenvSwitch,簡稱OVS,是一個虛擬交換軟件。OVS的連接著物理網卡和多塊虛機的虛擬網卡,并根據內部的 MAC地址映射表完成數據轉發。在SDN架構下,控制器下發openflow流表指導OVS進行實現交換策略。

ovs核心工作包括數據轉發和實現交換策略。數據交換工作,即負責從設備入端口接收數據包并依據流表信息對其進行管理。而OVS的OpenFlow協議支持則用于實現交換策略,即通過增加、刪除、修改流表項的方式告訴數據轉發通路針對不同的數據流采用不同的動作

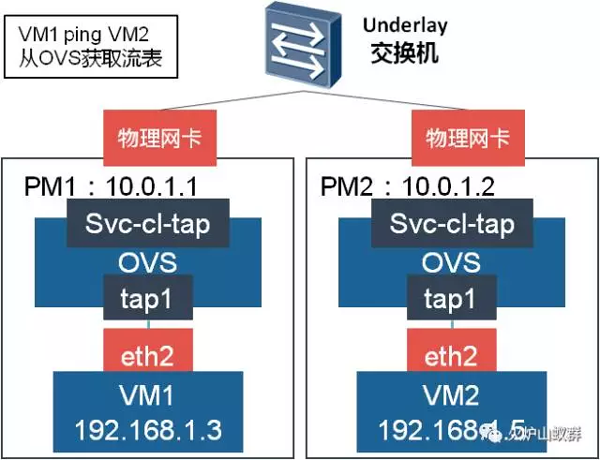

虛擬交換機的內核流表,能夠較為直觀的反應出實時流量的關鍵信息,如虛擬交換機端口,源目的ip,源目的端口,數據包類型等。若此時有一個ping數據包,其相對應的流表如下如示。

獲取到以下對應的流表:

- ·skb_priority(0),tunnel(tun_id=0x31b3f5/0xffffffffffffffff,src=10.0.1.2/255.255.255.255,dst=10.0.1.1/255.255.255.255,tos=0/0xff,ttl=64/0xff,flags(key)),in_port(6),skb_mark(0),eth(src=fa:16:3e:eb:2b:1e,dst=fa:16:3e:79:b7:62),eth_type(0x0800),ipv4(src=192.168.1.5/255.255.255.255,dst=192.168.1.3/255.255.255.255,proto=1/0xff,tos=0/0,ttl=64/0,frag=no/0xff), packets:7, bytes:686, used:0.882s, actions:5

- ·skb_priority(0),in_port(5),eth(src=fa:16:3e:79:b7:62,dst=fa:16:3e:eb:2b:1e),eth_type(0x0800),ipv4(src=192.168.1.3/255.255.255.255,dst=192.168.1.5/255.255.255.255,proto=1/0xff,tos=0/0x3,ttl=64/0,frag=no/0xff), packets:7, bytes:686, used:0.883s, actions:set(tunnel(tun_id=0x31b3f5,src=0.0.0.0,dst=10.0.4.84,tos=0x0,ttl=64,flags(key))),6

表1:流表數據

虛擬機的每一個實時會話都會以一個流表項的方式呈現出來。只要針對流表項進行深度分析,就能真實復原云主機的會話詳情。虛擬交換機的下聯端口與云主機一一關聯,若是虛擬交換機某個下聯端口的流表提取特征有異常,則可以判斷出該端口對應的云主機有可能存在網絡異常行為。

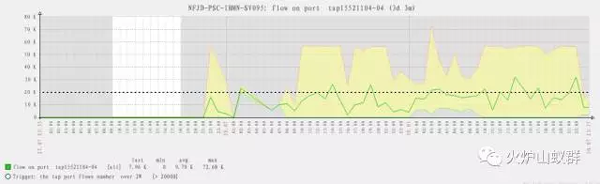

- 流表數量過大:單臺云主機對應的流表數量超出10000條/秒。

- 流表方向不對稱:單臺虛機對應的出方向流表數量大于2000條/秒,且入方向流表小于50條/秒。

我們采用了開源監控工具zabbix設置好告警規則,包括某段時間內的平均流表數量、某段時間內的流表變化速率、收發比閾值等告警條件。在某一臺虛機或物理機流表數據匹配上規則時,發出相應的告警。

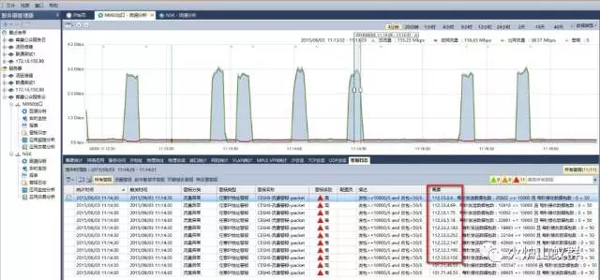

3.2.2 數據中心核心和出口側的流量分析

數據中心的核心層和出口側均進行端口鏡像將流量引入到后端的網絡分析系統。核心層和出口側的流量雖然相對較少,但卻是數據中心的關鍵流量信息,例如數據中心與外部網絡的交互,數據中心內部跨匯聚交換機的交互流量均能被有效采集。針對網絡分析系統獲取到的數據包進行下述關鍵特征匹配。

數據包收發比:正常通訊過程中,通訊雙發的數據會維持在特定的收發比例,即使下載數據過程中,數個下載數據包后總會有一個ACK包維持通信過程;根據移動云用戶歷史數據基準,定義符合“單臺主機發包大于10000個/秒,收到小于50個/秒”的條件時,是填充數據包攻擊的網絡異常行為。該行為對網絡影響嚴重,數個這樣的客戶端可使一條10G鏈路超載;通過該策略找出的異常客戶端,經過事后驗證,從未錯誤識別過一臺正常主機,屬于適合云環境的有效預警策略。

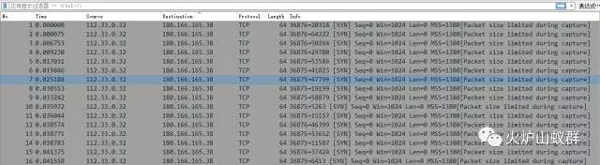

tcp同步數據包收發比:云內部不正常的SYN掃描總伴隨著安全攻擊和泛洪攻擊。根據移動云歷史基準,正常的云端主機的TCP連接行為會維持在一個穩定水平,定義符合“單臺主機tcp第一個請求數據包的發包大于2000個/秒,ack應答包收到小于50個/秒”的條件時,是泛洪攻擊的網絡異常行為。

若是數據包匹配上述規則,則觸發告警,通過實時對監控鏈路的流量異常變化進行預警,發現異常虛機,在用戶體驗感受下降前,主動出擊解決問題,實現運營的主動化。

Intelligent means

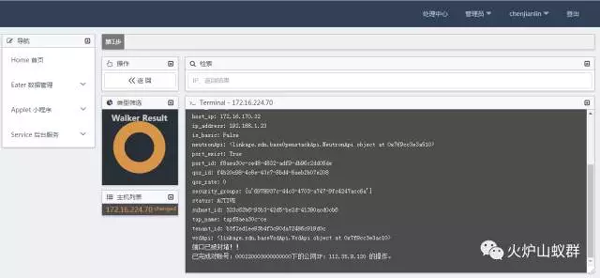

云網絡異常行為的智能處理

在云數據中心流程化、自動化處理網絡異常行為,是抑制網絡異常行為帶來的影響,也是徹底刨除問題源頭的重要環節。南方基地結合開源監控軟件及自行開發的運維平臺,自動化采集流表及流量數據,智能化告警監控,定制化開發異常流量的封堵手段。在抑制病毒擴散,清理病毒源的同時,實現自動化運維,提高運維效率。從被動運維,被動接投訴、接故障,到主動運維,及時發現問題,實時處理問題,實現運維角色的轉換。

4.1 自動化處理流程

處理流程:采集---告警---封堵---整改---整體提升。對于網絡異常行為,我們采用了智能化、自動化的處理方式。

首先,對物理機上虛擬交換機的流表和移動云核心、出口側的流量信息進行數據采集。采用zabbix自動獲取物理機上虛擬交換機的流表數據,采用科來系統鏡像引流核心層及出口側的流量。其次,分別在zabbix、科來系統上設置閾值及關鍵特征等告警條件,及時發現網絡異常的公網IP或客戶虛機。然后,調用云數據中心openstack的API接口,為云管理平臺定制化開發流量封堵功能,對網絡異常的流量進行封堵。最后,在核實客戶已完成整改后,由云管理平臺解封客戶虛機,整體提升數據中心的網絡環境。

4.2 數據采集

4.2.1 zabbix工具

流表數據采集使用zabbix系統,zabbix是一套具備分布式系統監控及網絡監控功能的開源軟件。為解決云環境下,客戶虛機動態創建,端口流表數據采集無法提前配置的問題,我們采用zabbix自動發現規則,在物理機上配置好key,并結合OVS,實時發現虛機及對應的虛擬端口,定時收集每臺虛機的流表數量、數據收發等關鍵數據。

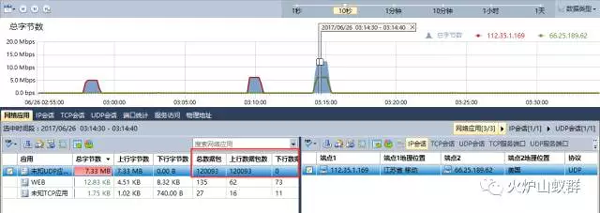

4.2.2 科來系統

出口側流量采集使用科來系統,科來網絡回溯分析系統是一款集成數據包采集和智能分析硬件平臺,分布部署在網絡的關鍵節點,實現對數據包級的實時智能分析。我們采用端口鏡像的方式,通過分光器將出口側及核心層的業務流量復制到后端分析節點,從而獲取出口側流量數據。

4.3 告警閾值設置

依據上一章節的OVS流表規范及出口側流量規范設置zabbix及科來系統的告警規則,智能發現網絡行為異常的虛機和公網IP。利用其圖形界面展示某段時間內虛機的流表數量、變化速率及收發比變化,以及公網IP的數據包內容及連接數量等信息,協助甄別客戶虛機是否正對外發起攻擊。

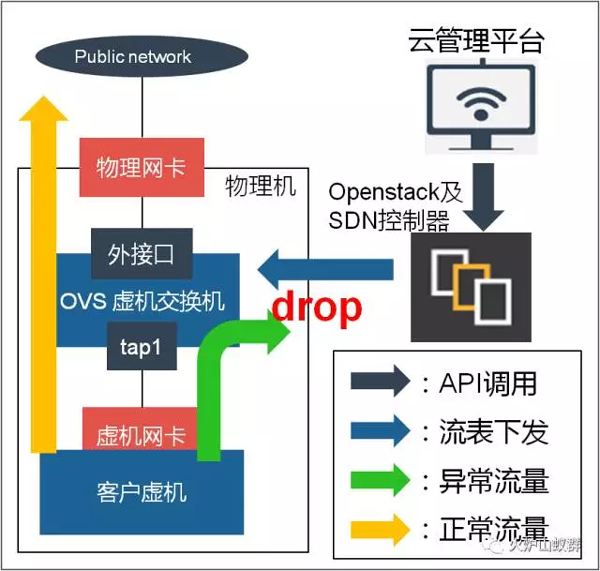

4.4 定制化開發流量封堵功能

在openstack與SDN的云環境中,端口分為內網端口和外網端口,虛機對外訪問的流量先經內網端口轉發到外網端口后再通過外網。為保證網絡異常行為不影響數據中心內部網絡環境,我們需在內網端口進行流量封堵。同時,為保證客戶能有特殊通道進入虛機進行安全整改,我們使用安全組放通特定流量。調用openstack API及監控系統API,在云管理平臺定制化開發行為異常封堵功能。在發生行為異常告警時,可由云管理平臺直接完成流量封堵并通知客戶。

正常的流量途徑是:虛機——>虛機網卡——>虛擬交換機——>物理網卡——>外部網絡,其中,在虛擬交換機上經控制器下發流表對流量進行nat或隧道封裝。簡單地對虛機網卡進行流量封堵,會因客戶行為引發openstack系統狀態恢復而導致虛機網卡封堵失敗。在物理網卡上進行流量封堵,則會導致移動云系統前后臺配置不一致。為了精確區分每一個虛機的流量,保證封堵的效果與穩定性,采用自定義開發的腳本,通過API接口調用控制器下發openflow流表丟棄異常的虛機流量是最佳的選擇。

封堵邏輯如下:云管理平臺通過api接口查詢openstack系統,確定網絡行為異常虛機的端口信息。同時,預先定義好限速為100k的QOS及放通特定端口的安全組規則。確定端口信息后,云管理平臺將預設的QOS、安全組及虛機端口下發給SDN控制器。SDN控制器自動生成openflow流表,并下發到流量異常虛機所在物理機,由流表實現異常流量的封堵。

4.5 自動化處理思路

移動云數據中心采用了SDN的網絡解決方案,引入openflow流表、vxlan等新技術,帶來網絡全自動化部署等新功能,但也增加運維的復雜度。為了減少重復、繁多的運維工作,自動化是必然的發展方向。深入剖析openflow流表、客戶網絡行為、數據包結構三者之間的關系,挖掘到這些離散數據背后的規則,使自動化處理網絡異常行為成為可能。移動云使用的開源軟件openstack、zabbix等,更便捷地對接數據采集、監控告警、系統封堵各環節,是流程自動化的保證。

將重復的故障處理腳本化,能為自動化平臺提供原子腳本支撐,并豐富平臺功能;而自動化平臺的開放性與完整體系,保證大多數的運維工作都能在平臺上實現。兩者相輔相成,最終實現平臺自動化完成重復性、規律性工作,提高整體運維效率。

Achievements and Extend

效益及推廣分析

5.1 網絡攻擊有效遏制

采用該套異常流量分析系統后,網絡安全事件工單數量從平均每周13單,下降了80%。安全事件工單處理時長從8小時,縮短了95%,半小時便能走完以下步驟:智能發現異常流量、歷史數據判斷,專業分析確定異常,自動化封堵流量。使得數據中心的異常流量得到有效控制,網絡安全環境大為改善。

5.2 發現新的分析手段

結合ovs的流表匹配規則,不僅能收集全網虛機的網絡流量數據,同時也不會侵犯客戶數據隱私。該分析策略用于故障預防和快速定位,可實現運維可視化管理,用量化數據指導云數據中心建設,從科學的角度去規劃、優化網絡與業務系統,不僅是保證網絡業務正常,還能為產品運營提供支撐,擴大運營收入。

作者簡介:

陳健林,中移動網絡運維工程師,入網維坑已有三年,負責云數據中心SDN網絡架構設計、運維、優化等工作。

劉瑛,中國移動高級網絡運維工程師,負責云數據中心的SDN網絡架構設計、運維、優化等工作,具有豐富的運維實戰經驗。