TensorFlow官方發(fā)布剪枝優(yōu)化工具:參數(shù)減少80%,精度幾乎不變

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

去年TensorFlow官方推出了模型優(yōu)化工具,最多能將模型尺寸減小4倍,運行速度提高3倍。

最近現(xiàn)又有一款新工具加入模型優(yōu)化“豪華套餐”,這就是基于Keras的剪枝優(yōu)化工具。

訓(xùn)練AI模型有時需要大量硬件資源,但不是每個人都有4個GPU的豪華配置,剪枝優(yōu)化可以幫你縮小模型尺寸,以較小的代價進(jìn)行推理。

什么是權(quán)重剪枝?

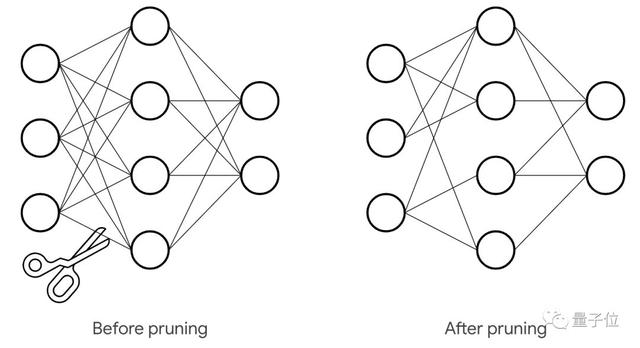

權(quán)重剪枝(Weight Pruning)優(yōu)化,就是消除權(quán)重張量中不必要的值,減少神經(jīng)網(wǎng)絡(luò)層之間的連接數(shù)量,減少計算中涉及的參數(shù),從而降低操作次數(shù)。

這樣做的好處是壓縮了網(wǎng)絡(luò)的存儲空間,尤其是稀疏張量特別適合壓縮。例如,經(jīng)過處理可以將MNIST的90%稀疏度模型從12MB壓縮到2MB。

此外,權(quán)重剪枝與量化(quantization)兼容,從而產(chǎn)生復(fù)合效益。通過訓(xùn)練后量化(post-training quantization),還能將剪枝后的模型從2MB進(jìn)一步壓縮到僅0.5MB 。

TensorFlow官方承諾,將來TensorFlow Lite會增加對稀疏表示和計算的支持,從而擴(kuò)展運行內(nèi)存的壓縮優(yōu)勢,并釋放性能提升。

優(yōu)化效果

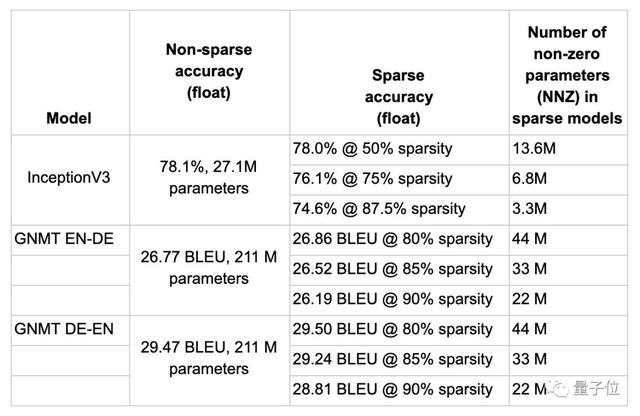

權(quán)重剪枝優(yōu)化可以用于不同任務(wù)、不同類型的模型,從圖像處理的CNN用于語音處理的RNN。下表顯示了其中一些實驗結(jié)果。

以GNMT從德語翻譯到英語的模型為例,原模型的BLEU為29.47。指定80%的稀疏度,經(jīng)優(yōu)化后,張量中的非零參數(shù)可以從211M壓縮到44M,準(zhǔn)確度基本沒有損失。

使用方法

現(xiàn)在的權(quán)重剪枝API建立在Keras之上,因此開發(fā)者可以非常方便地將此技術(shù)應(yīng)用于任何現(xiàn)有的Keras訓(xùn)練模型中。

開發(fā)者可以指定最終目標(biāo)稀疏度(比如50%),以及執(zhí)行剪枝的計劃(比如2000步開始剪枝,在4000步時停止,并且每100步進(jìn)行一次),以及剪枝結(jié)構(gòu)的可選配置。

- import tensorflow_model_optimization as tfmot

- model = build_your_model()

- pruning_schedule = tfmot.sparsity.keras.PolynomialDecay(

- initial_sparsity=0.0, final_sparsity=0.5,

- begin_step=2000, end_step=4000)

- model_for_pruning = tfmot.sparsity.keras.prune_low_magnitude(model, pruning_schedule=pruning_schedule)

- ...

- model_for_pruning.fit

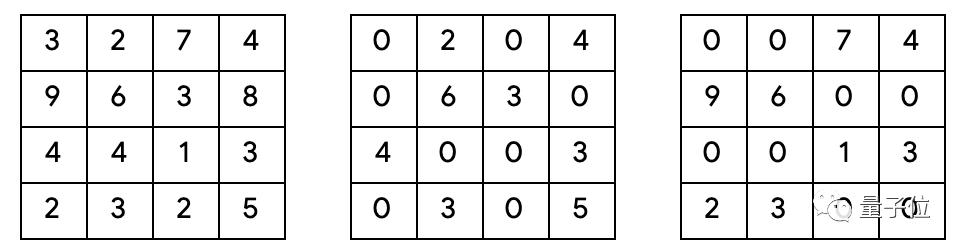

△ 三個不同張量,左邊的沒有稀疏度,中心的有多個單獨0值,右邊的有1x2的稀疏塊。

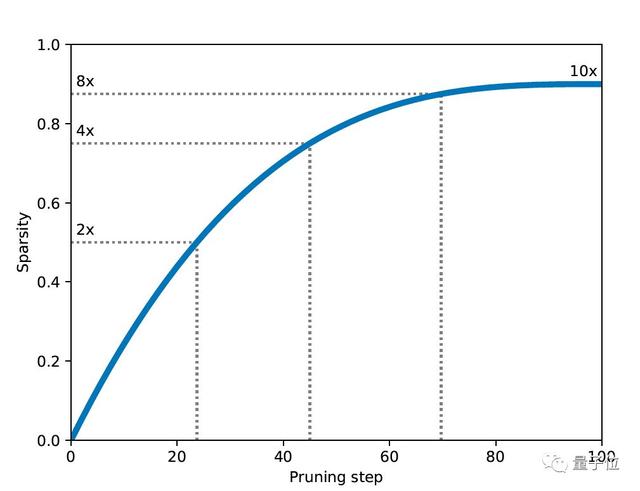

隨著訓(xùn)練的進(jìn)行,剪枝過程開始被執(zhí)行。在這個過程中,它會消除消除張量中最接近零的權(quán)重,直到達(dá)到當(dāng)前稀疏度目標(biāo)。

每次計劃執(zhí)行剪枝程序時,都會重新計算當(dāng)前稀疏度目標(biāo),根據(jù)平滑上升函數(shù)逐漸增加稀疏度來達(dá)到最終目標(biāo)稀疏度,從0%開始直到結(jié)束。

用戶也可以根據(jù)需要調(diào)整這個上升函數(shù)。在某些情況下,可以安排訓(xùn)練過程在某個步驟達(dá)到一定收斂級別之后才開始優(yōu)化,或者在訓(xùn)練總步數(shù)之前結(jié)束剪枝,以便在達(dá)到最終目標(biāo)稀疏度時進(jìn)一步微調(diào)系統(tǒng)。

△權(quán)重張量剪枝動畫,黑色的點表示非零權(quán)重,隨著訓(xùn)練的進(jìn)行,稀疏度逐漸增加

GitHub地址:

https://github.com/tensorflow/model-optimization

官方教程:

https://www.tensorflow.org/model_optimization/guide/pruning/pruning_with_keras