明年1月1日起,AI造假視頻不得隨意發布

新規來了。

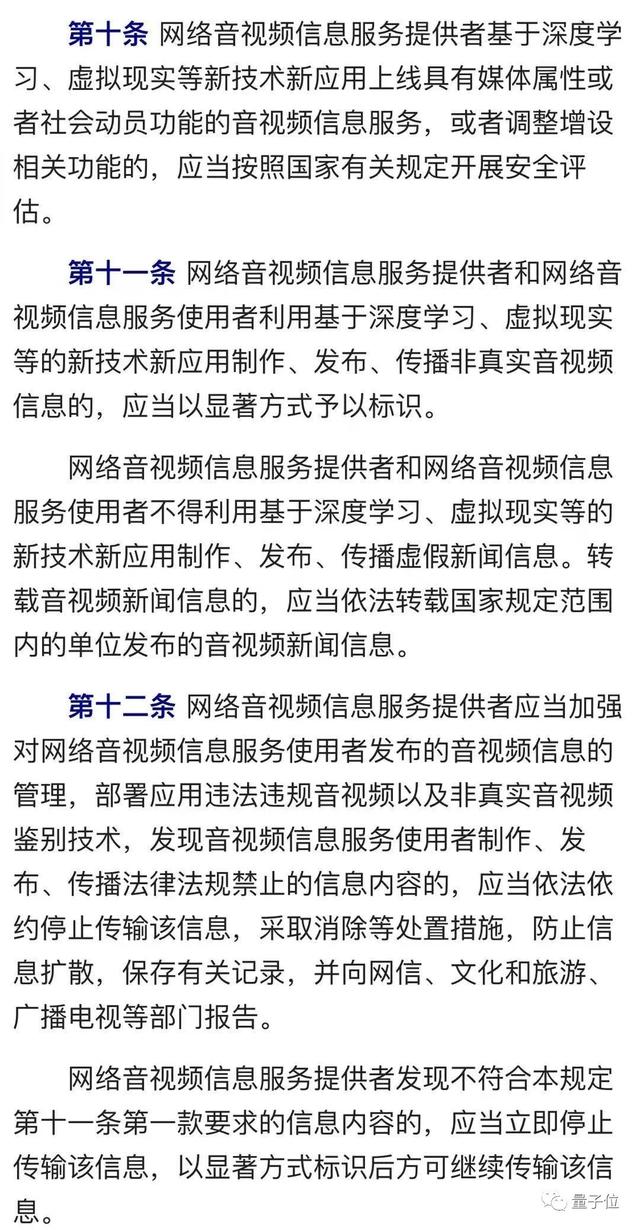

在這份剛剛印發的《網絡音視頻信息服務管理規定》中,四次直接提及深度學習,基本可以看做是針對AI造假視頻的一次針對性管控。

2017年底,deepfake換臉技術出現以來,各種使用AI技術造假的視頻層出不窮。而且隨著技術的進步,造假視頻已經變得越來越真假難辨,也引發了全球范圍內的擔憂。

現在,不能使用AI技術亂來了。

國內的各位朋友,再搞AI換臉的視頻等操作,請注意這些新規定。

對普通用戶:

- 發布非真實AI音視頻時,要以顯著方式標識出來。

- 不得使用AI技術制作假新聞。

對于服務商,除了上述要求還有:

- 上線AI音視頻服務,應展開安全評估。

- 部署非真實音視頻鑒別技術。

- 及時停止傳播未顯著標識的非真實AI音視頻內容。

- 建立健全辟謠機制。

相關規定條款,我們截圖如下。

新規定將于明年1月1日起施行。

《網絡音視頻信息服務管理規定》的詳細內容,可以訪問這個頁面查看:http://www.cac.gov.cn/2019-11/29/c_1576561820967678.htm

deepfake“改變”世界

對于deepfake等基于深度學習的AI技術,全球都在想辦法應對。

畢竟這種技術,可以用來換臉:

還能用來給身體造假:

本月,推特發布了首個反deepfake策略草案,并征集公眾意見。根據這個草案,如果一份deepfake偽造的內容威脅到某人的人身安全或可能造成嚴重傷害,將會被刪除。

包括微軟、Google等國外公司也在研究如何自動鑒別換臉視頻。

AI造假視頻,也是最近幾個月美國國會中最有爭議的話題之一。此前,美國國際戰略研究中心(CSIS)發布報告稱,偽造信息正在通過互聯網迅速傳播,破壞了民主進程。

來自人民看點的報道中寫道:

- Deepfake被認為是一種破壞民主的工具。美國情報界發布的2019年全球威脅評估(Worldwide Threat Assessment)中就警告稱,惡意攻擊者或戰略競爭對手可能會使用deepfake技術或類似的機器學習技術來創建看似逼真但其實是偽造的圖片、音頻和視頻文件來加大針對美國和其盟友的活動的影響。

- CNBC網站在其報道中稱,“deepfake”將成為“2020年美國總統選舉中的大事件”。就像2016年的“虛假新聞”一樣,“deepfake”視頻將在2020年的美國大選中,掀起更強大的血雨腥風。

2019年10月,美國加州州長Gavin Newsom簽署AB-730法令,明確指出,如果散布偽造的信息使公眾對政治人物的言論、行動產生錯誤或有害的印象,將是犯罪行為。

7月,美國弗吉尼亞州也發布了禁止deepfake濫用的禁令:未經當事人允許分享他人的裸露視頻、照片屬于違法行為,無論該照片或視頻是真實的還是偽造的。

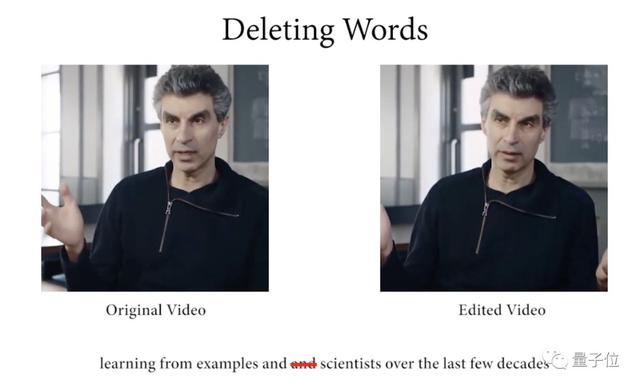

今年6月,斯坦福、普林斯頓等大學發布了一項最新研究:給定任意文本,就能隨意改變一段視頻里人物說的話。并且,改動關鍵詞后人物口型還能對得奇準無比,絲毫看不出篡改的痕跡。

除了視頻造假,AI在音頻造假方面也不在話下。

來看一個真實的案例。

有人用AI技術偽造老板的聲音,打電話要求轉賬,結果一家公司上當了,損失了173萬元。這家公司,是總部位于英國的一家能源公司。

要不是因為騙了一次還想立刻騙第二次,這個騙局可能也不會馬上曝光。

毫無破綻的變臉

如果你還沒見識過deepfake的威力,以下是一些網友的大作。

此前,有一個名為“換臉哥”的B站用戶將《射雕英雄傳》中朱茵飾演的黃蓉換成了楊冪的臉,并且把處理過的視頻發在了B站。

類似的還有,徐錦江換臉海王。

把《回家的誘惑》里男主的臉換到了“穿著品如衣服”的女性角色艾莉臉上:

更多例子就先不舉了。

如果你想試試AI模仿聲音的感覺,可以試試搜狗輸入法里的“變聲”功能。

如果你想試試AI換臉的感覺,可以試試此前曾在國內外掀起一陣旋風、繼而引發廣泛爭議的App:ZAO。