谷歌用AI訓(xùn)練“耳機線”,實現(xiàn)了觸摸屏大多數(shù)功能

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

谷歌在開發(fā)可穿戴設(shè)備上從未停歇,比如和李維斯合作推出的智能夾克衫Commuter Trucker。

衣服上的袖口加裝一塊傳感器,用戶可以通過藍牙鏈接與之進行交互。

可以通過雙擊、滑動等操作進行切歌等操作。

再接再厲,谷歌希望能夠把設(shè)備做的小一點,功能更豐富一點。

谷歌隨后盯上了耳機線。

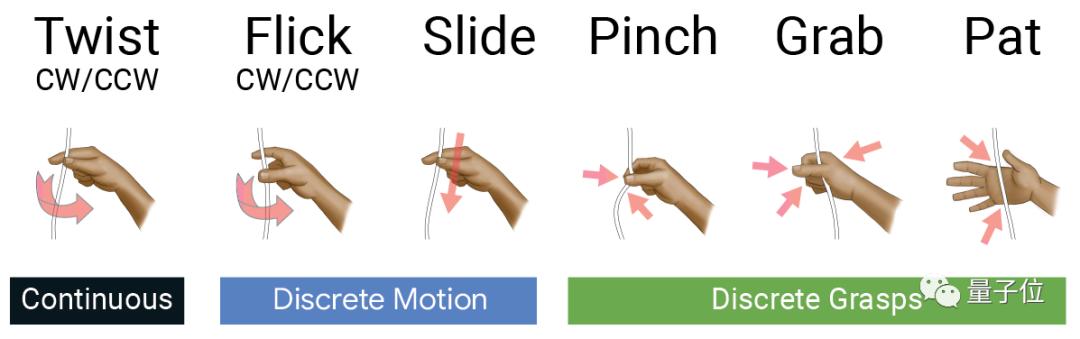

谷歌AI工程師開發(fā)了一款電子交互式編織物(E-Textile),可以讓人通過捏、搓、握、拍等手勢實現(xiàn)以往觸摸屏的大部分功能。

音量控制、切歌換歌等操作更是不在話下,谷歌的新功能指向的是下一步的感知交互,最終目的解放我們的雙手。

手勢數(shù)據(jù)集的訓(xùn)練過程

谷歌開發(fā)的此款設(shè)備是機器學(xué)習(xí)算法和傳感器硬件的結(jié)合,而耳機線只是承載物。

實際上線不是普通的耳機線,是柔性電子材料,并且將傳感器編織進內(nèi),因此可以進行人機交互。

如果你喜歡,連帽衫也可以改造。

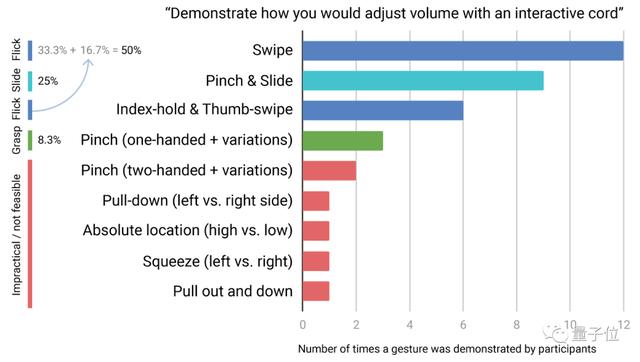

首先谷歌招募12名參與者進行數(shù)據(jù)采集,各做8個手勢,重復(fù)9次,共計864個實驗樣本。

為解決樣本量過小的弊端,研究者使用線性插值對每個手勢時間序列進行再采樣。

每個樣本提取16個特征,最終得到80個觀察結(jié)果。

每位用戶經(jīng)過訓(xùn)練的手勢識別可啟用8個新的離散手勢。

不僅有定量的數(shù)字,還有參與者的切身感受,研究者希望提供以人為本的交互體驗。

參與者還通過排名和評論提供了定性反饋,參與者還提出了多種交互方式,包括滑動、彈指、按壓、捏、拉、擠等。

定量分析結(jié)果表明,交互式編織品的感知速度比現(xiàn)有的耳機按鈕控件要快,并且速度可與觸摸屏媲美。

而定性反饋還表明,與耳機線控相比,電子紡織交互更受青睞。

考慮到不同的使用場景,研究者為不同的使用場景開發(fā)了不同的設(shè)備:

電子紡織USB-C耳機,用于控制手機上的媒體播放;帽衫抽繩,以無形地向衣服添加音樂控制。

算法對手勢的精準(zhǔn)識別

谷歌能做出電子編織物,難點并不在于機器學(xué)習(xí)的算法,而在于如何在耳機線上進行手勢捕捉和交互。

耳機線等編織物出于體積考慮,無法安裝大型和眾多的傳感器,感知和分辨能力非常受限。

其次是人手姿態(tài)的曖昧性和多義性,比如捏和抓到底怎么區(qū)分,拍擊和上拉怎么分辨?

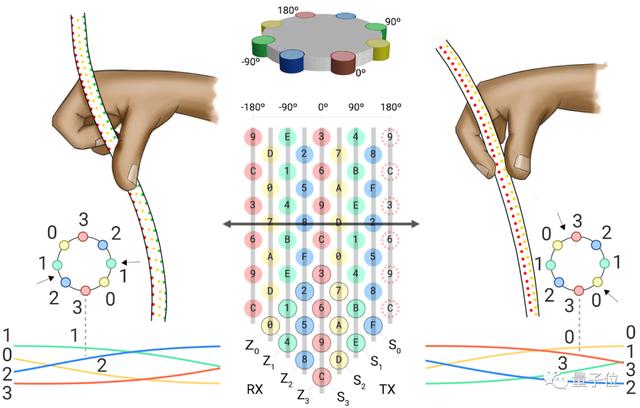

谷歌工程師用8個電極組成傳感器矩陣,對數(shù)據(jù)集進行劃分為8次為訓(xùn)練數(shù)據(jù),1次為測試數(shù)據(jù),得到9個手勢的變換。

他們發(fā)現(xiàn)傳感矩陣中存在固有關(guān)系,非常適合機器學(xué)習(xí)分類算法,這使得分類算法可以運用有限數(shù)據(jù)集進行訓(xùn)練,大約只需要30s,便可實現(xiàn)一個手勢識別。

最終準(zhǔn)確率為93.8%,考慮到他們所使用的數(shù)據(jù)集規(guī)模和訓(xùn)練時間,這個精度足夠日常使用了。

耳機操控的下一步

谷歌此次對耳機線的訓(xùn)練,涉及手勢姿態(tài)識別和微觀互動兩個內(nèi)容。

在觸摸屏設(shè)備上,屏幕下方空間可容納眾多傳感器,比如蘋果的3D Touch識別模塊。

但在諸如耳機線等體外設(shè)備上,可能就沒有這么輕松了,因為傳感器數(shù)量和體積要受到限制。

實驗過程中,工程師們發(fā)現(xiàn)需要對多種手勢的多次訓(xùn)練,而且不同個體手勢需要多次捕捉動作。

這項研究顯示了一種可以在一個緊湊的外形尺寸物體中實現(xiàn)精確的小規(guī)模運動可能,我們可以期待智能可交互編織物的發(fā)展。

有一天。可穿戴式界面和智能織物的微交互可以任意使用,最終讓體外設(shè)備如影隨形,隨時交互,最終解放我們的雙手。

你期待這一天嗎?