為什么信不過AI看病?數據集小、可靠性差,AI醫療任重道遠

近年來,AI 在醫療診斷中的應用受到了越來越多的關注,也出現了一些實際的應用場景,如藥物篩選、AI 診斷。但似乎正確的 AI 醫療診斷難以實現,這是哪些原因造成的呢?本文探討并匯總了人們對 AI 醫療診斷的一些獨到見解。

AI 與醫療融合作為近年來興起的一種新領域,具有巨大的發展潛力。用于醫療的 AI 算法正在不斷涌現,在看到領域前景的同時,我們也發現了一些問題。

例如,為了協助醫生篩查潛在新冠患者,AI 領域的研究者們研發了多種機器學習算法,以根據胸部 X 光片和 CT 圖像快速準確地檢測和預測新冠肺炎。然而,劍橋大學的一項研究發現:這些算法存在嚴重的算法缺陷和偏見,無法用于實際的臨床應用。

實際上,致力于 AI 與醫療融合的研究者并不在少數,也有很多項目為此投資,但該領域仍然存在一些實際問題。近日,Reddit 上的一篇帖子將 AI 醫療與 AlphaZero 進行了對比,引發了關于 AI 醫療問題的諸多討論。

數據集小、需要認證、容錯成本高……

有網友從數據集大小、人機交互、認證和容錯成本四個方面與 DeepMind 的 AlphaZero 進行了全方位的對比,指出了現有 AI 醫療診斷系統存在的一些基本問題。

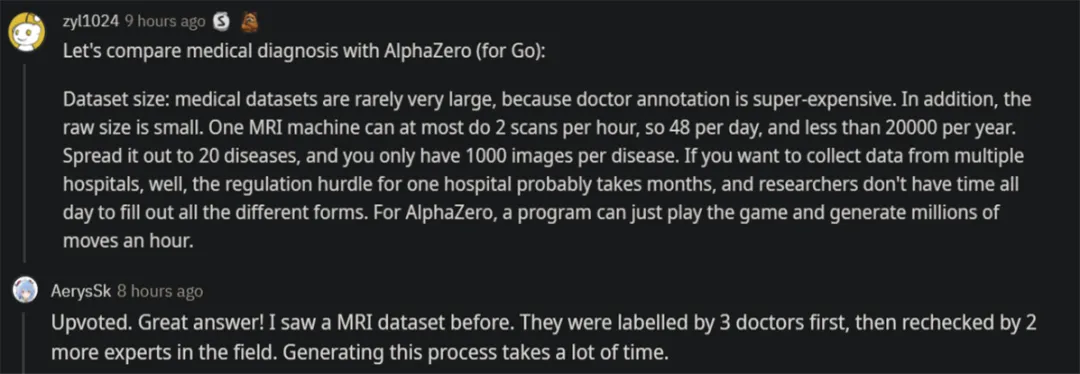

首先,醫療數據集一般不太大,這是醫生注釋成本高昂造成的。此外,醫療過程也非常緩慢。例如,一臺核磁共振機器每小時最多只能進行兩次掃描,每天至多 48 次,每年不到 20000 次。如果存在 20 種疾病,分攤下來每種疾病只能得到 1000 張掃描圖像。如果想要從多家醫院收集數據,每家醫院走流程都可能花費數月時間,并且研究人員也沒有大把的時間來填寫不同的表格。相比之下,AlphaZero 的數據收集就容易多了,只需要進行游戲,每小時就能生成數百萬個數據。

關于這一點,有其他用戶深表贊同。ta 曾見過一個 MRI 數據集,首先由 3 個醫生進行標注,然后由領域專家重新檢查,這一過程就需要大量的時間。

其次是人機交互方面,至少在可預見的未來,醫療診斷系統需要人類醫生的參與。所以,除了進行預測之外,醫療診斷系統還應該輸出置信度、其他可能的結果以及任何有用的輔助信息。在很大程度上,如何正確處理這些仍是一個未解決的問題。而 AlphaZero 只需要輸出單一動作就行了。

再次,認證。你需要向決策者或醫療許可委員會「證明」醫療診斷系統有效。目前,解釋神經網絡仍是一個懸而未決的問題,一些人甚至質疑是否存在解釋的可能。AlphaZero 不需要任何批準認可,只需在游戲服務器上部署或者找人類玩家測試就行了。

最后,容錯成本。如果醫療診斷系統出錯了,研發者可能會面臨數百萬美元的索賠。因此,你必須保證系統運行正確。AlphaZero 在圍棋游戲中輸了,那真是太糟糕了,僅此而已。

醫療診斷不是「一錘子買賣」

除了數據集大小、醫療認證、容錯成本等這些宏觀的問題,有網友還提到了另一個問題。不同情況的病患可能在診斷圖像上呈現出完全相同的癥狀,因此醫療診斷系統有時可能會做出誤判。

此外,不同機器或不同成像裝置生成圖像的分布有時大不相同,在一臺機器上正常運行的算法可能完全不適用于另一臺機器。可解釋性也是一個問題。即使你的算法給出了正確的醫療結果,醫生也往往會詢問算法如何給出結論的。

的確,診斷是一個極其困難的 AI 或 ML 問題。病患的情況遠不止一種,也會出現不同的癥狀。因此,除了醫療診斷系統的初次診斷之外,還需要為進一步診斷、治療方案、預后以及康健日程等提供智能支持。

作為與健康安全息息相關的領域,AI 醫療的可靠性是最重要的一個問題,但卻經常被忽略。即使是病理樣本分析,也常常存在一定程度的不確定性。僅對圖像加標簽會引入各種偏見。即使經過多位專家達成共識,結果也會是如此,并且這還會導致成本的成倍增加。

醫療保健方面的問題非常復雜,AI 目前更適用于日常生活,而不是提供醫療上的最終診斷和預測。有位醫生網友表示:「在 AI 醫療領域發表的大部分論文是完全沒有用的,但這些研究提供了很多可能性。未來幾年,這一領域中炒作宣傳的泡沫將會破裂,并且將會由相關法規提高臨床實踐中引入 AI 工具的門檻。目前,已經有一些產品獲得了 EU 或 FDA 支持,但尚不存在臨床支持。」

看來,將 AI 真正用于醫療還有很長的路要走。

參考鏈接:

https://www.reddit.com/r/MachineLearning/comments/mkol81/why_are_correct_ai_medical_diagnoses_seemingly_so/

【本文是51CTO專欄機構“機器之心”的原創譯文,微信公眾號“機器之心( id: almosthuman2014)”】