如何三步搭建一套聲紋系統

背景介紹

聲紋檢索,顧名思義就是說話人識別,通過聲音來驗證或者識別說話人的聲音。聲紋識別的關鍵步驟就是聲音向量化,將說話人的聲音將其轉化成結構化的向量。阿里云AnalyticDB向量版,提供了一套聲紋驗證檢索的解決方案。用戶只需要使用簡單的幾條SQL命令,三步之內就可以搭建一套高精度的聲紋檢索驗證服務。

聲紋識別技術

1)聲紋檢索演示

圖1展示了AnalyticDB向量數據庫的聲紋檢索系統的演示界面。為了方便用戶體驗,我們將380個人的聲音信息,轉化成向量存儲在系統中。當前演示系統分成兩部分,第一部分是檢索部分,用戶輸入錄制好的聲音文件或者用戶現場進行錄音上傳聲音文件,提交到聲紋庫進行聲音的匹配檢索。第二部分是注冊部分,用戶可以注冊上傳自己的聲音到當前的聲紋庫里面,方便后期的查詢驗證。在接下來的章節中,我們分別介紹各個功能。

圖1. 聲紋演示系統

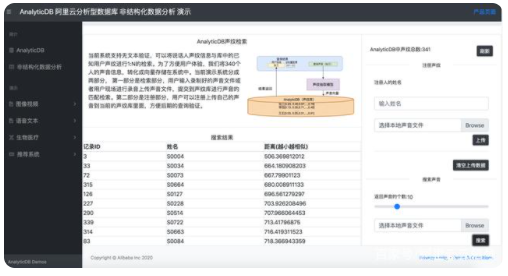

圖2上傳一段S0004的測試音頻“BAC009S0004W0486.wav”到聲紋庫里面進行檢索,可以看到TOP1的結果S0004就會在最上面進行展示。

圖2. 查詢聲音

圖3展示了聲紋注冊系統,用戶可以注冊自己的聲音到后臺聲紋庫里面,方便檢索。比方說,用戶Hanchao注冊自己的聲音(只有7s長度),到當前的系統里面來。當前系統支持無文本注冊,用戶可以說任何話來進行注冊。

圖3. 注冊聲音

圖4演示用戶現場錄制聲音,上傳到系統中,進行檢索。比方說,“Hanchao”錄制了一段5秒的語音到聲紋系統中進行檢索。之前注冊過“Hanchao”的聲音,當前系統可以看到排名第一的聲音就是“Hanchao”的聲音。

圖4. 錄制并檢索聲音

當前對于聲紋演示,我們采用的是1:N的演示結果,可以用在會議室中的識別,通過聲音可以找到相關的會議說話人。當前,對于身份驗證,這種1:1的演示,我們只用限制距離小于550,就可以方便的進行身份驗證。

2)應用結構總體設計

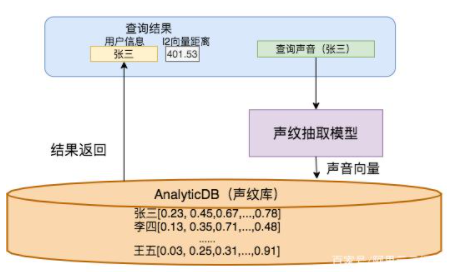

阿里云聲紋庫檢索的系統框架的總體架構如圖5所示,AnalyticDB(聲紋庫)負責整個聲紋檢索應用的全部結構化信息(用戶注冊標識,用戶姓名,以及其他的用戶信息)和非結構化信息(聲音產生的向量)的存儲和查詢。在查詢的過程中,用戶通過聲紋抽取模型,將聲音轉成向量,在AnalyticDB中進行查詢。系統返還回來相關的用戶信息,以及l2向量距離[5]。其中聲音抽取模型的訓練和測試,我們在下一章進行講解。

圖5. 聲紋檢索庫

3)系統精度

當前演示聲紋系統,采用的是GMM-UMB模型抽取的i-vector作為檢索向量[3]。另外,我們還訓練了精度更高的深度學習聲紋識別模型(x-vector[4])。并且,可以針對特定的場景,比方說電話通話場景,手機APP場景,嘈雜噪聲場景等相關的場景進行聲紋模型訓練,詳細信息可以加我們的群進行了解。

聲紋識別在學術界常用的數據集(Aishall.v1 [1]數據集和TIMIT [2]數據集)上面的(1:N)的準確率(>99.5%,見表1)。

表1. Top 1 精度測試結果

三步搭建一個聲紋系統

第一步,初始化。

當前系統實現了聲音轉向量的函數,用戶將前端得到的聲音通過POST請求,發給阿里云服務系統,選擇對應的聲紋模型,就可以將聲音轉成對應的向量。

import requestsimport jsonimport numpy as np# sound: 聲音二進制文件。# model_id:模型id。def get_vector(sound, model_id='i-vector'): url = 'http://47.111.21.183:18089/demo/vdb/v1/retrieve' d = {'resource': sound, 'model_id': model_id} r = requests.post(url, data=d) js = json.loads(r.text) return np.array(js['emb'])# 讀取用戶文件。file = 'xxx.wav'data = f.read()print(get_vector(data))f.close()

在初始化的過程中,用戶創建相關的用戶聲紋表。同時,給表的向量列加入向量索引,來加速查詢過程。當前聲紋模型輸出的都是400維的向量,所以索引參數dim設置為400。

--創建用戶聲紋表CREATE TABLE person_voiceprint_detection_table( id serial primary key, name varchar, voiceprint_feature float4[]);--創建向量索引CREATE INDEX person_voiceprint_detection_table_idx ON person_voiceprint_detection_table USING ann(voiceprint_feature) WITH(distancemeasure=L2,dim=400,pq_segments=40);

第二步,注冊用戶聲音。

在注冊的過程中,注冊一個用戶,插入一條記錄到當前系統中。

--注冊用戶'張三'到當前的系統中。--通過HTTP服務,將聲紋轉化成相關的向量。INSERT INTO person_voiceprint_detection_table(name, voiceprint_feature)SELECT '張三', array[-0.017,-0.032,...]::float4[])

第三步,檢索或驗證用戶聲音。

聲紋門鎖驗證(1:1 驗證):在驗證系統中,系統會得到用戶的標識信息(user_id),在聲紋庫中計算輸入的聲音向量和庫里該用戶的聲音向量的距離。一般系統會設置一個距離閾值(threshold=550),如果向量之間的距離大于這個閾值,說明驗證失敗。如果小于閾值,說明聲紋驗證成功。

-- 聲紋門鎖檢測(1:1)驗證SELECT id, -- 用戶id信息 name, -- 用戶姓名 l2_distance(voiceprint_feature, ARRAY[-0.017,-0.032,...]::float4[]) AS distance -- 向量距離 FROM person_voiceprint_detection_table -- 用戶聲音表WHERE distance < threshold -- 通常情況下,threshold為550 AND id = 'user_id' -- 用戶要驗證的id;

會議聲紋檢索(1:N 檢測):系統通過識別當前講話人的聲音,會返回最相關的注冊用戶信息。如果沒有返回結果,說明當前會議說話人不在聲紋庫里面。

-- 聲紋會議人員識別(1:N)驗證SELECT id, -- 用戶id信息 name, -- 用戶姓名 l2_distance(voiceprint_feature, ARRAY[-0.017,-0.032,...]::float4[]) AS distance -- 向量距離 FROM person_voiceprint_detection_table -- 用戶聲音表WHERE distance < threshold -- 通常情況下,threshold為550 ORDER BY voiceprint_feature <-> ARRAY[-0.017,-0.032,...]::float4[] -- 利用向量進行排序LIMIT 1; -- 返回最相似的結果