給一個(gè)詞就能模仿你的筆跡,F(xiàn)acebook這個(gè)AI強(qiáng)大到不敢開源代碼

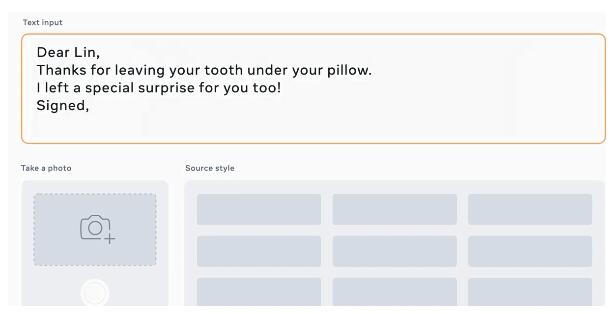

Facebook 近日公布了一項(xiàng)新的圖像 AI——TextStyleBrush,該技術(shù)可以復(fù)制和再現(xiàn)圖像中的文本風(fēng)格。

借助該技術(shù),你只需要輸入一個(gè)詞作為「標(biāo)準(zhǔn)」,AI 就能全篇模仿你的書寫風(fēng)格,一鍵執(zhí)行,效果可謂驚艷。

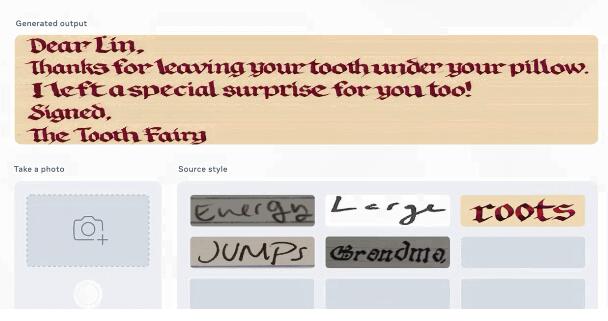

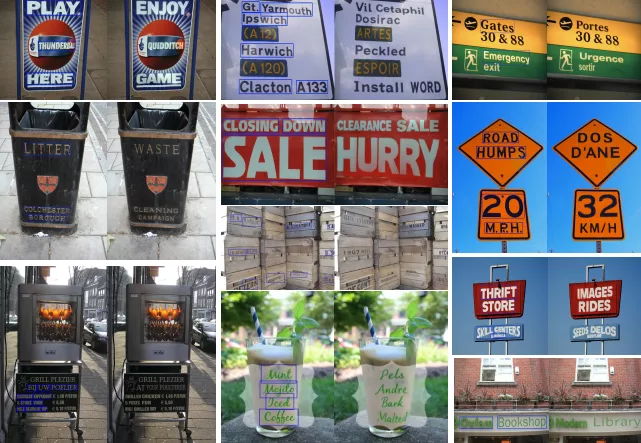

此外,你還可以用它替換不同場景中的文字(比如海報(bào)、垃圾桶、路標(biāo)等)。下圖中左側(cè)為原始場景圖像,單詞顯示在藍(lán)色矩形中;右側(cè)為文本替換后的圖像。

從圖中可以看出,各種風(fēng)格的字體 AI 幾乎都能 hold 住。下圖中每個(gè)圖像對(duì)在左邊顯示輸入源樣式,在右邊顯示新內(nèi)容(字符串),左右兩端字體看起來風(fēng)格完全相同。與源圖像相比,輸出的圖像在外觀上似乎都有些模糊,但我們可以看到,在大多數(shù)情況下,該技術(shù)似乎工作得很好。

與其他字跡模仿 AI 相比,TextStyleBrush 功能更強(qiáng)大,可以從更細(xì)微的角度分析文字樣式,從而做到在各種角度和背景下進(jìn)行字跡模仿。

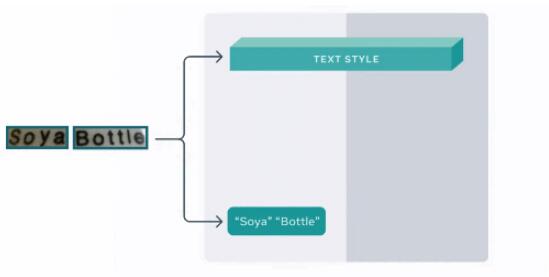

下圖是醬油瓶(Soya)替換為茶瓶(Tea)的實(shí)現(xiàn)過程:

這款強(qiáng)大的模仿神器正是 Facebook AI 推出的「TextStyleBrush」,只需輸入一個(gè)單詞,就能完美復(fù)現(xiàn)筆跡。這項(xiàng)技術(shù)的原理類似于文字處理 APP 中的樣式筆刷工具,可以將文字和風(fēng)格分開。

- 論文地址:https://scontent-sjc3-1.xx.fbcdn.net/v/t39.8562-6/10000000_944085403038430_3779849959048683283_n.pdf?_nc_cat=108&ccb=1-3&_nc_sid=ae5e01&_nc_ohc=Jcq0m5jBvK8AX--fG2A&_nc_ht=scontent-sjc3-1.xx&oh=8b7e8221bba5aba6b6331c643764dec5&oe=60EF2B81

- 數(shù)據(jù)集地址:https://github.com/facebookresearch/IMGUR5K-Handwriting-Dataset

它具有以下特點(diǎn):

- 只需要一個(gè)單詞,就能復(fù)制照片中的文字風(fēng)格。使用該 AI 模型,你可以編輯和替換圖像中的文本。

- 與大多數(shù) AI 系統(tǒng)不同的是,TextStyleBrush 是首個(gè)自監(jiān)督的 AI 模型,使用單個(gè)示例詞一次性替換手寫和圖像中的文本。

- 將來它會(huì)在個(gè)性化信息和字幕等領(lǐng)域釋放新的潛力,比如在增強(qiáng)現(xiàn)實(shí) (AR) 中實(shí)現(xiàn)逼真的語言翻譯。

- 通過公布這項(xiàng)研究所具有的能力、方法和結(jié)果,研究者希望推動(dòng)對(duì)話和研究,以發(fā)現(xiàn)這類技術(shù)的潛在應(yīng)用,如深度假文本攻擊——這是人工智能領(lǐng)域的一大挑戰(zhàn)。

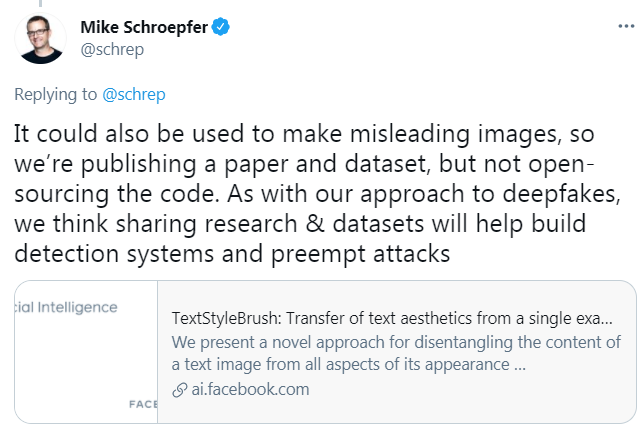

由于 TextStyleBrush 也可能被用來制作誤導(dǎo)性的圖像,所以 Facebook 的 CTO 在個(gè)人社交網(wǎng)站表示,他們只發(fā)布了論文和數(shù)據(jù)集,但沒有公開代碼。并表示正如我們對(duì) deepfakes 的方法一樣,我們認(rèn)為共享研究和數(shù)據(jù)集將有助于構(gòu)建檢測系統(tǒng)并提前預(yù)防攻擊。

可以學(xué)習(xí)文本風(fēng)格表征的 TextStyleBrush

用 AI 生成圖像一直在以驚人的速度發(fā)展,這種生成技術(shù)能夠重現(xiàn)歷史場景,或者將照片變成梵高等繪畫風(fēng)格。現(xiàn)在,F(xiàn)acebook AI 已經(jīng)建立了一個(gè)可以替換場景和手寫文本風(fēng)格的 AI,只需要一個(gè)單詞作為輸入。

雖然大多數(shù) AI 系統(tǒng)都可以完成定義明確的、專門的任務(wù),但構(gòu)建一個(gè)足夠靈活的 AI 系統(tǒng),以理解現(xiàn)實(shí)場景中文本和手寫體的細(xì)微差別,具有很大的挑戰(zhàn)。這意味著需要了解眾多的文本樣式,不僅包括不同的字體和書寫風(fēng)格,而且也包括不同的轉(zhuǎn)換,如旋轉(zhuǎn)、彎曲的文字以及圖像噪聲等問題。

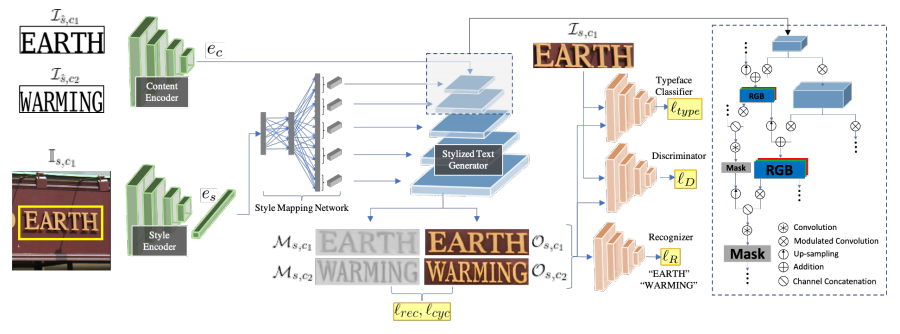

Facebook AI 提出了 TSB(TextStyleBrush)架構(gòu)。該架構(gòu)以自監(jiān)督的方法進(jìn)行訓(xùn)練,沒有使用目標(biāo)風(fēng)格監(jiān)督,只使用了原始風(fēng)格圖像。該框架可以自動(dòng)地尋找圖片真實(shí)風(fēng)格。在訓(xùn)練時(shí),它假設(shè)每個(gè)詞框有真實(shí)值(出現(xiàn)在框中的文本);推理時(shí),它采用單一源樣式圖像和新內(nèi)容(字符串),并生成帶有目標(biāo)內(nèi)容的源樣式的新圖像。

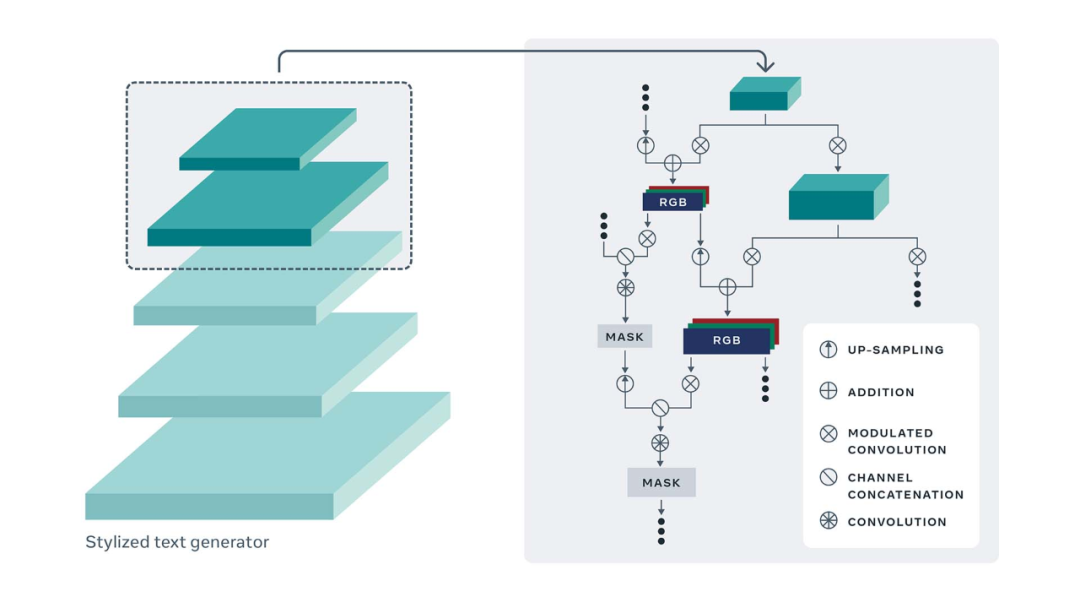

該生成器架構(gòu)是基于 StyleGAN2 模型。然而,它有兩個(gè)重要的限制:

首先,StyleGAN2 是一個(gè)無條件模型,這意味著它通過對(duì)一個(gè)隨機(jī)的潛在向量進(jìn)行采樣來生成圖像。但 TextStyleBrush 必須要生成指定文本的圖像。

其次,TextStyleBrush 生成的文本圖像風(fēng)格不受控制。文本風(fēng)格涉及全局信息(例如調(diào)色板和空間變換),以及精細(xì)的比例信息組合(例如單個(gè)筆跡的細(xì)微變化。

研究者通過內(nèi)容和風(fēng)格表征來調(diào)節(jié)生成器以解決上述限制。通過提取特定于層的風(fēng)格信息并將其注入到生成器的每一層來處理文本風(fēng)格的多尺度特性。除了以期望的風(fēng)格生成目標(biāo)圖像外,生成器還生成表示前景像素 (文本區(qū)域) 的軟蒙版圖像。通過這種方式,生成器可以控制文本的低分辨率和高分辨率細(xì)節(jié),以匹配所需的輸入風(fēng)格。

該研究還引入了一種新的自監(jiān)督訓(xùn)練準(zhǔn)則,該準(zhǔn)則使用字體(typeface)分類器、文本識(shí)別器和對(duì)抗式鑒別器來保留源風(fēng)格和目標(biāo)內(nèi)容。首先,研究者通過使用預(yù)訓(xùn)練的字體分類網(wǎng)絡(luò)來評(píng)估生成器捕獲輸入文本風(fēng)格的能力。另外,他們使用預(yù)訓(xùn)練文本識(shí)別網(wǎng)絡(luò)來評(píng)估生成圖像的內(nèi)容,以反映生成器捕獲目標(biāo)內(nèi)容的效果。總而言之,這種方法能夠?qū)τ?xùn)練進(jìn)行有效的自監(jiān)督。

實(shí)驗(yàn)

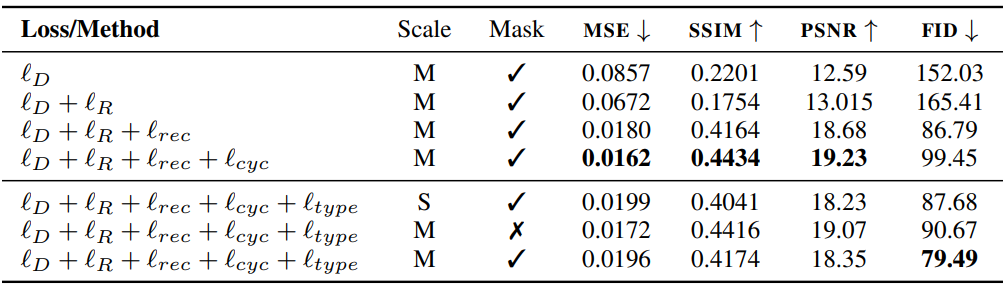

表 2 提供了評(píng)估不同損失函數(shù)、風(fēng)格特征擴(kuò)展以及訓(xùn)練 TSB 時(shí) mask 的作用消融實(shí)驗(yàn)結(jié)果。實(shí)驗(yàn)結(jié)果顯示,TextStyleBrush 生成的圖片在 MSE(合成誤差)上大幅降低,PSNR(峰值信噪比)、SSIM(結(jié)構(gòu)相似性)均獲得了提高。

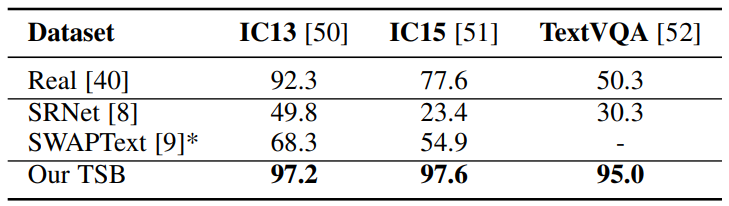

表 3 是在三種數(shù)據(jù)集圖像上測得的文本識(shí)別準(zhǔn)確率。實(shí)驗(yàn)結(jié)果顯示,TSB 的識(shí)別效果最好,在 IC13 上的識(shí)別準(zhǔn)確率為 97.2%,IC15 上的識(shí)別準(zhǔn)確率為 97.6%,TextVQA 上的識(shí)別準(zhǔn)確率為 95.0%。

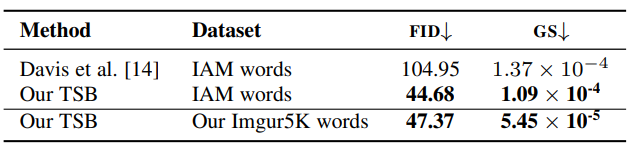

表 4 提供了生成的手寫文本的定量比較,將 TSB 方法與 Davis 等人 [14] 專門為生成手寫文本而設(shè)計(jì)的 SotA 方法進(jìn)行了比較。FID 分?jǐn)?shù)越低,生成質(zhì)量越好。顯然,TSB 方法優(yōu)于以前的工作。

TextStyleBrush 證明了 AI 在文字上面可以比過去更加靈活、準(zhǔn)確地識(shí)別,但這項(xiàng)技術(shù)仍然存在許多問題,如無法模仿金屬表面的字符或彩色字符等, Facebook 希望這項(xiàng)研究能繼續(xù)擴(kuò)展,突破翻譯、自主表達(dá)和 deepfake 研究之間的障礙等。

失敗案例