效果爆炸的漫畫變身AI,火到服務器幾度擠爆

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

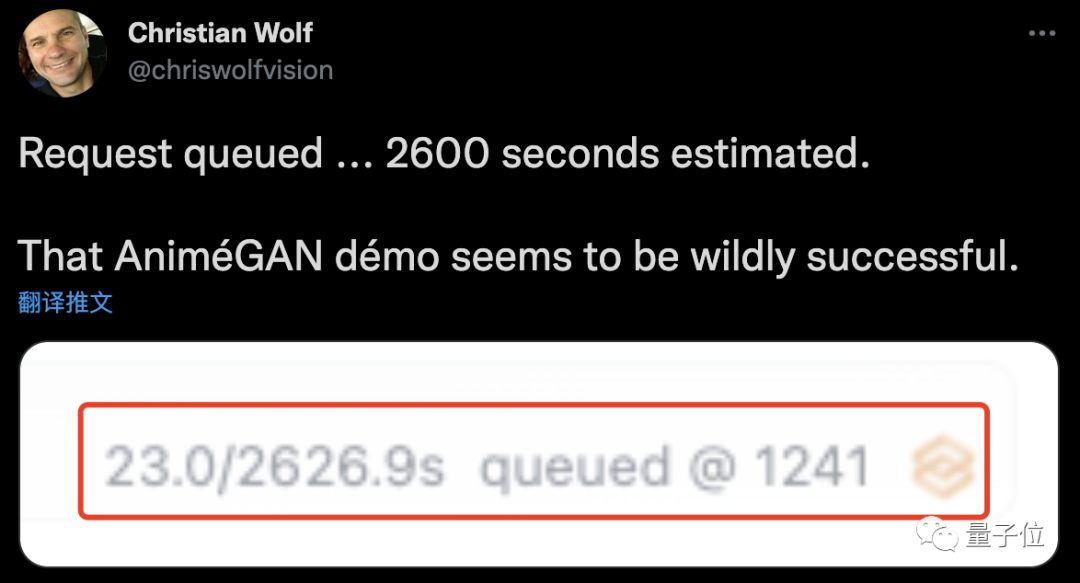

排隊1241人,等待2600秒……”

——這屆網友為了看一眼自己在動漫里的樣子,可真是拼了!

“始作俑者”是一款可以把人像變動漫的生成器。

只需一張圖片或一段視頻,無論男女老少、明星素人都可以一睹自己的“動漫風采”~

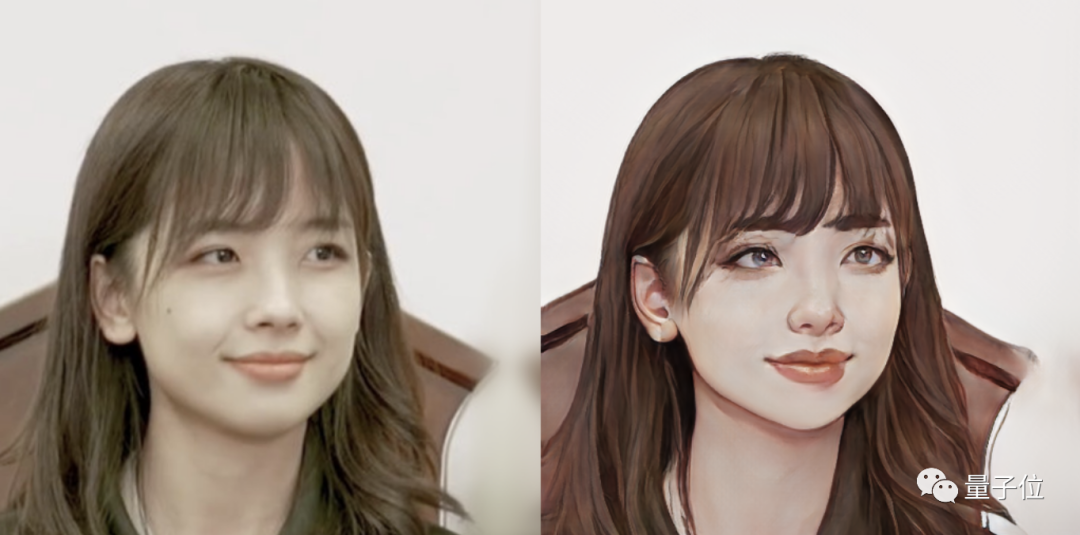

什么“國民老婆”王冰冰:

什么“國民妹妹”IU:

什么科技圈大佬、EDG成員、金發美女、容嬤嬤……

發絲、眉宇,甚至眼神里流露出來的情緒,都給你“描繪”得淋漓盡致……

△ 視頻效果

這也難怪網友把服務器都給擠爆了。

隨便翻翻大家的作品,簡直是深不見底。

再看看GitHub上的相關項目,果然也沖上了趨勢榜第一名。

這個AnimeGAN,真是厲害了!

如何給自己捏一個動漫臉?

看完展示的效果,你是不是也想打造一個自己專屬的漫畫臉了呢?

這個可以有,現在就手把手教你。

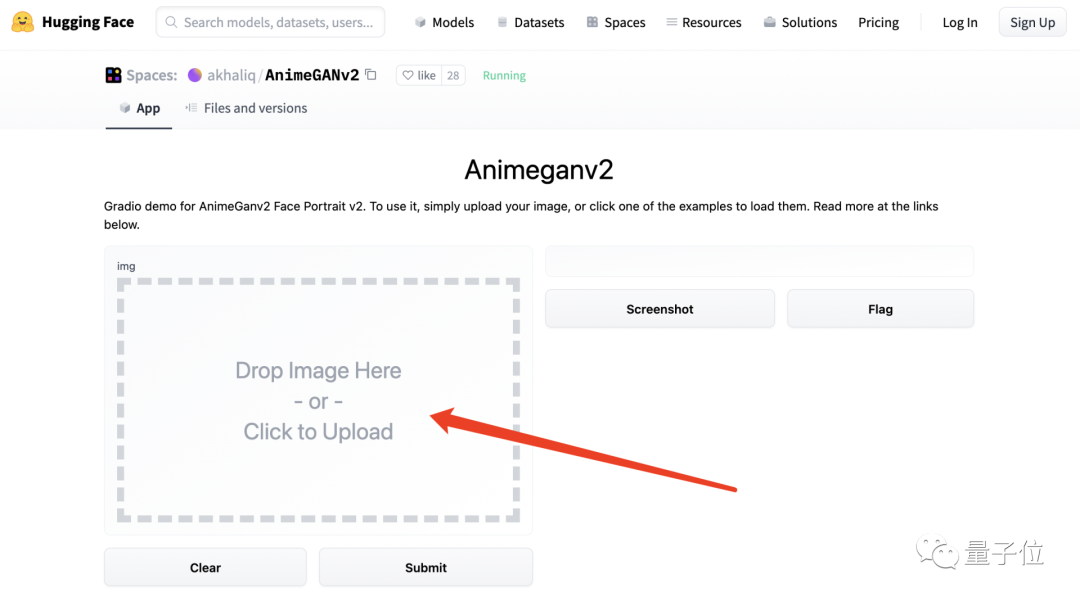

第一種方法就very very簡單了,只需要上傳一張照片就可以。

提供在線玩法的網站(鏈接見文末),就是那個著名的抱抱臉 (Hugging Face)。

它專門開設了一個在線AnimeGANv2的App,直接把圖片“丟”進去就好。

BUT!!!

也正如剛才提到的,現在這個AI著實有點太火了,簡單的在線方法,就等同于排大隊。

這不,等了5259秒之后,前面還有15人……

如果不想排隊怎么辦?

接下來,就是第二種方法了——上代碼!

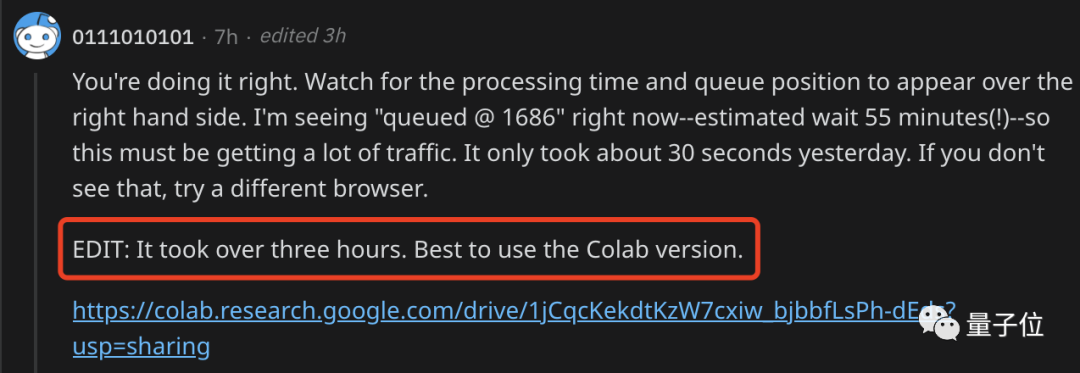

熱心網友在苦等了3小時之后,終于還是忍不住了,強烈安利Colab版本(鏈接見文末):

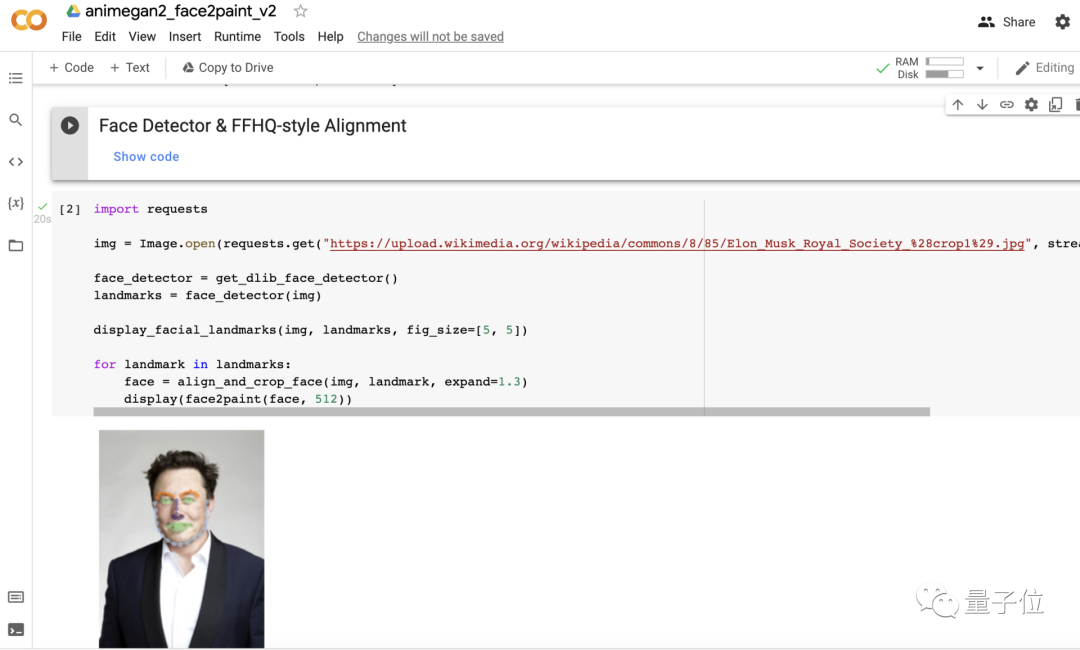

先運行一下文檔里的前兩段代碼,然后只需要簡單修改照片路徑即可。

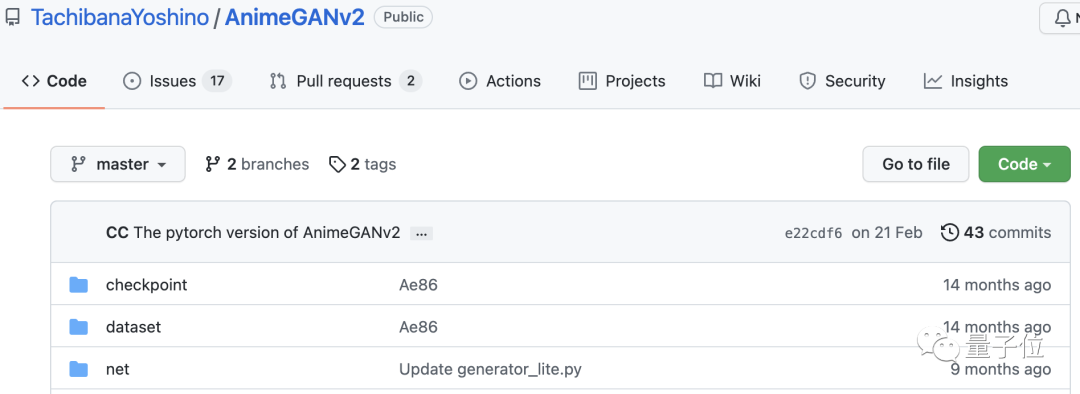

當然,如果想加大難度挑戰一下,AnimeGANv2的GitHub項目也是有的哈:

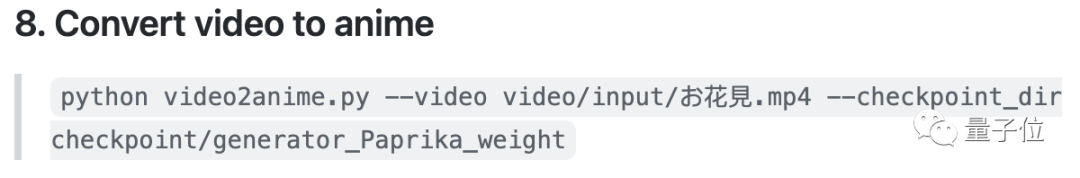

以上介紹的方法都是用圖片轉換,如果你想用視頻的話,在AnimeGANv2項目中執行下面這兩條命令就OK:

當然,該項目的Pytorch實現也有,不過Pytorch版本目前只支持圖片轉換;如果想轉視頻,暫時就需要你自己寫個腳本了~

風格遷移+GAN

那么,如此效果的背后,到底是用了什么原理呢?

AnimeGAN是來自武漢大學和湖北工業大學的一項研究,采用的是神經風格遷移 + 生成對抗網絡(GAN)的組合。

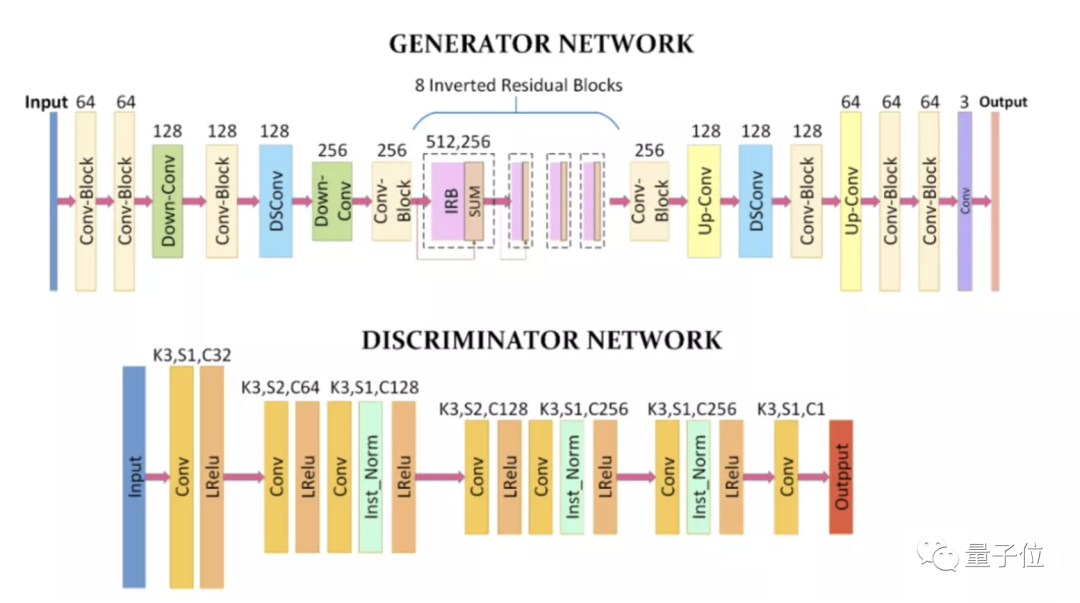

它其實是基于CartoonGAN的改進,并提出了一個更加輕量級的生成器架構。

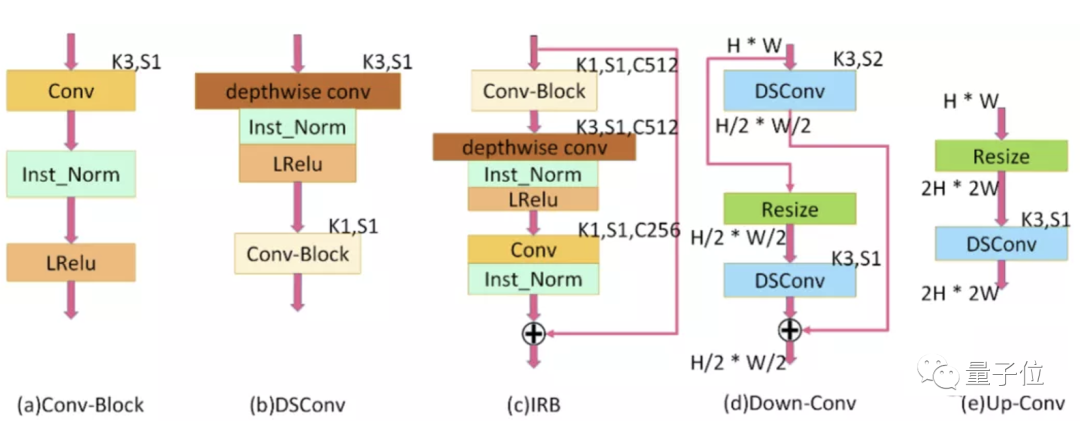

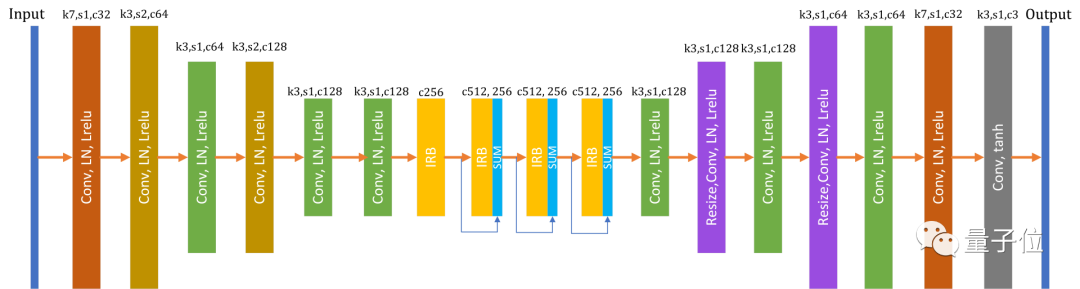

AnimeGAN的生成器可以視作一個對稱的編碼器-解碼器網絡,由標準卷積、深度可分離卷積、反向殘差塊、上采樣和下采樣模塊組成。

為了有效減少生成器的參數數量,AnimeGAN的網絡中使用了8個連續且相同的IRB(inverted residual blocks)。

在生成器中,具有1×1卷積核的最后一個卷積層不使用歸一化層,跟隨其后的是tanh非線性激活函數。

上圖中,K為內核大小,C為特征圖數量,S為每個卷積層的跨度,H是特征圖的高度,W是特征圖的寬度,Resize值用于設置特征圖大小的插值方法,⊕表示逐元素加法。

而此次的V2版本,是基于第一代AnimeGAN的升級,主要解決了模型生成的圖像中存在高頻偽影的問題。

具體而言,所采取的措施是使用特征的層歸一化(layer normalization),來防止網絡在生成的圖像中產生高頻偽影。

作者認為,層歸一化可以使feature map中的不同通道,具有相同的特征屬性分布,可以有效地防止局部噪聲的產生。

AnimeGANv2的生成器參數大小為8.6MB,而AnimeGAN的生成器參數大小為15.8MB。

它倆使用的鑒別器大致相同,區別在于AnimeGANv2使用的是層歸一化,而不是實例歸一化(instance normalization)。

網友:我變漂亮了

這個AI可算是圈了一眾粉絲。

有些網友“沖進二次元”之后,發現了自己驚人的美貌:

它把我變漂亮了!

而且非常驕傲的曬出了自己的漫畫臉。

還有網友看完比爾蓋茨的效果之后,直呼:

天!蓋茨看起來聰明又性感。

作者:生成效果更好的AnimeGANv3也快來了

AnimeGAN的原作者一共有3位,分別是湖北工業大學的劉罡副教授,陳頡博士,以及他們的學生Xin Chen。

這個項目的誕生主要出于團隊成員的個人興趣,也就是對二次元宅文化和對藝術的熱愛。

作者之一陳同學介紹,AnimeGAN和AnimeGANv2分別耗時2-3個月完成,其中遇到了不少困難。

其中就包括硬件資源的極度匱乏,比如當時做AnimeGAN用到的英偉達單卡服務器還是由該校藝術設計學院的院長饒鑒教授提供,而他負責的研究也曾依賴于向其他同學借機器跑實驗。

到了AnimeGANv2時,就只剩一臺單卡2080ti服務器供使用了。

不過,所有努力都沒有白費,如今AnimeGAN已受到非常多人的關注和喜歡,這讓陳同學和他的導師團隊都非常有成就感。

要知道,就連新海誠導演都曾轉發過AnimeGAN的作品呢。

但,這項以興趣愛好為驅動的科研項目并不只是“圖個好玩”。

在我們與該團隊的交流當中,他們表示:

主要目標還是以學術論文為里程牌,以項目能工程化落地到實際應用中為最大期待。

而接下來,AnimeGANv3也快來了。

它到時會采用更小的網絡規模,大概縮減到只有4M左右;同時解決AnimeGANv2的一些不足(比如v2保留了原圖過多的細節),讓生成的動漫效果質量更高。

這也意味著AnimeGANv3將具備商業化的能力。

而在AnimeGANv3完成之后,他們還會對人臉到動漫的算法進行不斷地優化。

One More Thing

最后,大家上手之前一定要注意,雖然AnimeGAN展示的效果都是比較好的,但這有一個大前提:

照片一定要高清、五官盡量要清晰!

不然畫風可能就會變得詭異(作者親測,欲哭無淚)……

那么,你在漫畫里是什么樣子?

快去試試吧~

在線Demo:

https://huggingface.co/spaces/akhaliq/AnimeGANv2

Colab版本:

https://colab.research.google.com/drive/1jCqcKekdtKzW7cxiw_bjbbfLsPh-dEds?usp=sharing#scrollTo=niSP_i7FVC3c

GitHub地址:

https://github.com/TachibanaYoshino/AnimeGANv2

https://github.com/bryandlee/animegan2-pytorch