谷歌年度AI技術總結!Jeff Dean執筆,附贈20+開源工具數據大禮包

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

Jeff Dean親筆盤點谷歌AI研究成果,已經成了一年一度的保留節目。

今年也不例外,還是他抽出一部分假期時間完成的。

過去一年,谷歌研發投入依然是全球最高,在一整年的時間里產出不少成果。

光論文數就達750+篇,讓人眼花繚亂。

如果你擔心自己錯過了一些的話也不用擔心,這位谷歌AI掌門人都幫你總結好了。

Jeff本人親眼目睹了AI過去幾十年的諸多進展,對當下最大的感觸是:

早期機器學習方法往往不盡如人意,不過終于催生出了很多非常成功的現代方法,這些進步最終將惠及數十億人的生活。

他把2021年機器學習進展總結成五大趨勢,另外還給讀者送上一份大禮包——

一年來谷歌發布的27個開源工具和數據集匯總。

涵蓋多語言文本、醫學、建筑、舞蹈動作、電影標題、文本到表格生成等眾多領域。

如果你有需要可在公眾號后臺回復關鍵詞“姐夫2021”獲取。

下面就先來看一下,這個被譽為行業風向標,Jeff眼中的機器學習五大趨勢都有哪些。

簡單速覽:

- 趨勢1:模型更大讓AI能力更通用

- 趨勢2:機器學習效率持續提高

- 趨勢3:AI應用對個人更有益

- 趨勢4:AI推動科學研究和醫學健康

- 趨勢5:對機器學習的理解加深

趨勢1:模型更大讓AI能力更通用

過去一年中,語言模型的參數規模仍在不斷增長,紛紛超過1750億的GPT-3。

例如DeepMind的Gopher有2800億,微軟英偉達聯合推出的威震天-圖靈到了5300億。

谷歌自己的GShard和GLaM模型更是達到6千億和1.2萬億。

訓練這些模型用到的數據集規模也在同步增長。

數據集和模型大小的增加讓AI在傳統NLP任務上的準確性顯著提高,還在更多新能力上有所突破。

代表性的研究有Quoc Le團隊提出新的微調方法Instruction Tuning。

新模型FLAN在沒訓練過的任務上的零樣本學習能力超過GPT-3少樣本版本的表現。

以及谷歌I/O大會上所演示的LaMDA模型,在開放式多輪對話上有所突破。

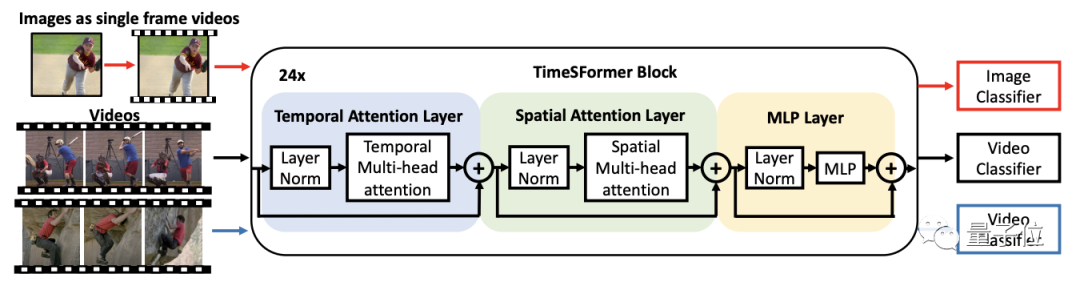

除了語言模型,圖像、視頻方面這一年都被Transformer架構同時刷新了模型規模和性能基準。

谷歌在這方面代表性的研究便是Vision Transformer(ViT)以及Video ViT。

另外還有一個重要的結論是,同時用圖像和視頻數據訓練可以提高模型在視頻任務的性能。

圖像生成上,這一年里擴散模型 (Difusion Model)成了GAN的有力競爭對手。

級聯(Cacade)擴散模型SR3以低分辨率圖像為輸入,便可從純噪聲中構建出對應的高分辨率圖像。

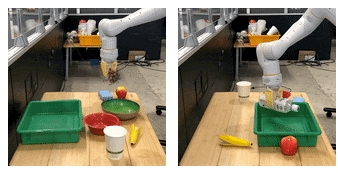

多模態模型方面,模型規模的增大還讓機器人get新能力。

機械臂只需要學會自然語言描述的“把葡萄放在碗中”這項任務,便可執行“把水瓶放在托盤中”的全新任務。

Jeff總結到,這些大模型通常使用自監督學習方法,這個趨勢令人興奮。

一方面可以大大減少工作量,另一方面在長尾任務中也能取得更好表現。

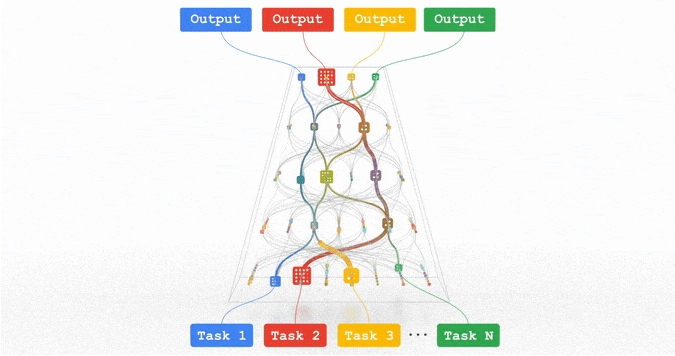

谷歌AI下一步的努力方向是研發一個叫Pathway的稀疏模型新架構,把它訓練成可以執行成千上萬種任務的通用模型。

趨勢2:機器學習效率持續提高

參數規模和數據量的擴大,對模型的訓練效率提出了新的挑戰。

作為應對,谷歌在加速芯片、編譯器、模型架構和算法方面分別取得了進展。

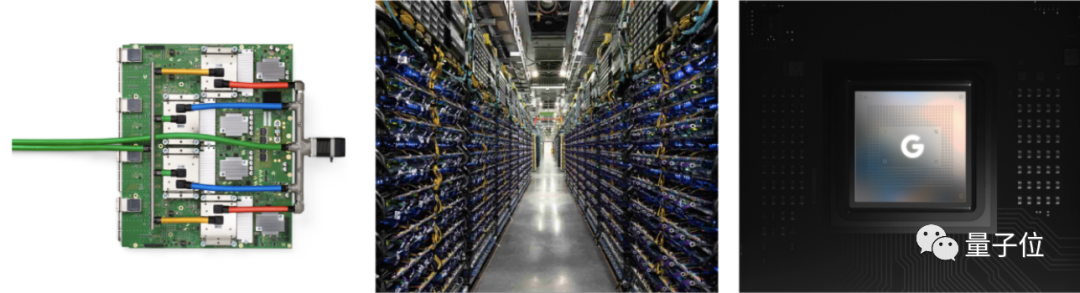

芯片方面,新發布的TPUv4與上一代相比性能提高2.7倍,用高速網絡連接在一起可以支持超大模型的訓練。

移動設備上,新一代Pixel6手機上搭載全新的Tensor處理器,在手機上做到4k60幀視頻處理,以及實時機器翻譯。

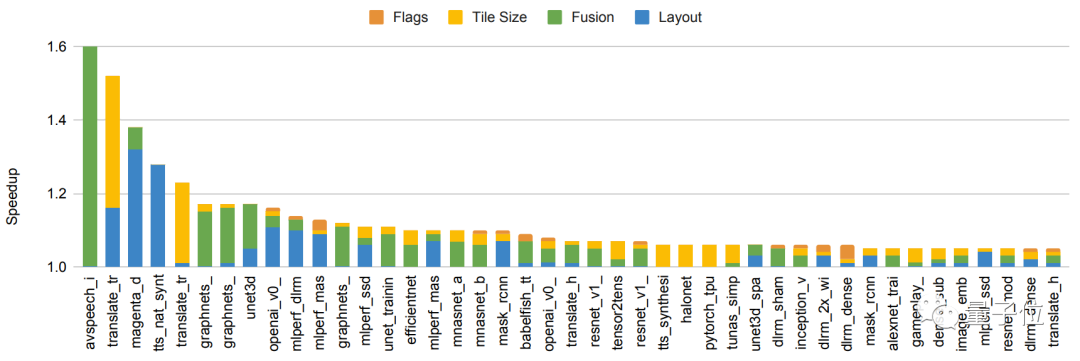

編譯器方面,谷歌推出基于XLA編譯器的自動并行化系統GSPMD。

即使硬件沒有進步,也能做到在150種模型上性能全面提高5%-15%,甚至個別情況下提高了2.4倍。

這一成果已經用在了GShard-M4、LaMDA、ViT等多個大模型上。

架構方面,一種提升效率的方法是靠人類的創造力設計。

這里還是要說到Transformer的各類變體在這一年中大放異彩,同時在NLP和CV領域頻頻刷榜。

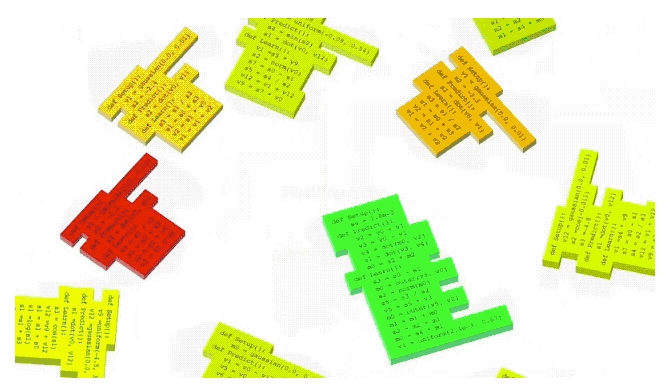

另一種方法便是機器驅動的神經架構搜索(NAS),大大減少算法開發的工作量。

雖然NAS本身的計算量很大、成本高昂,但總體上可以顯著降低下游開發和生產環境中的計算量。

如NAS方法搜索出來的Evovled Transformer,在參數減少37.6%的情況下獲得0.7%的英德翻譯性能提升。

視覺任務上,NAS方法得到的Efficientnetv2模型訓練速度比之前的SOTA模型提高了5-11倍。

除了模型架構,AutoML-Zero還使用NAS方法來尋找新的、更有效的強化學習/監督學習算法。

算法方面,增加對稀疏性(Sparsity)的利用是一個重要進展。

谷歌稀疏的Switch Transformers與密集的T5模型相比,訓練效率提高了7倍。

GLaM模型把Transformer與Mixer of Expert風格的層結合起來,訓練和推理成本與GPT-3相比分別減少了3倍和2倍。

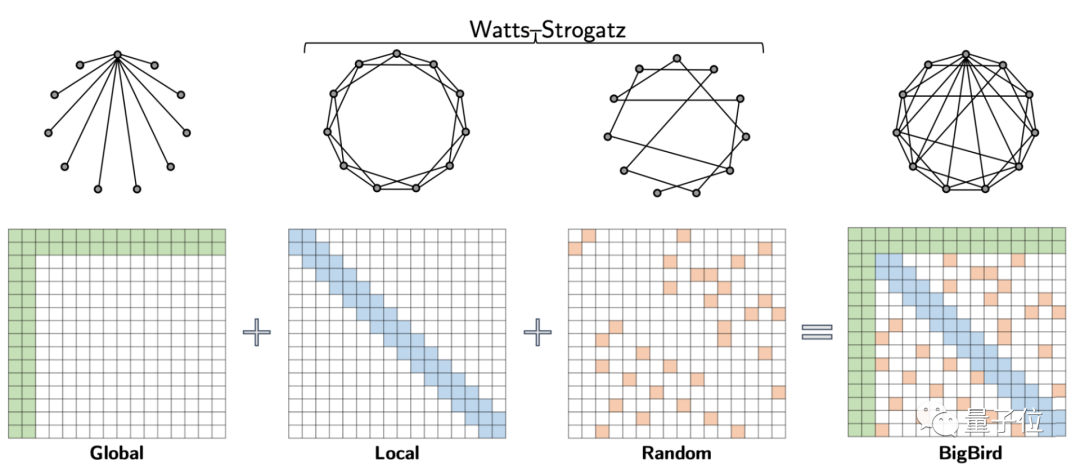

另外,BigBird模型用稀疏性降低了Transformer的核心機制——注意力模塊的計算成本。

盡管稀疏性取得如此多成績,Jeff Dean還是認為目前的研究僅觸及了這個方向上的皮毛。

未來更繼續深入研究還有更高的潛在回報。

趨勢3:AI應用對個人更有益

除此之外,Jeff Dean還關注到移動設備上的個性化AI應用。

得益于ML的發展與處理器的創新,手機可以更加連續有效地感知周圍環境,用戶體驗也更加豐富。

對一些日常使用的功能,比如計算攝影、實時翻譯等都帶來了改變。與此同時,還加強了隱私保護。

以計算攝影HDR+功能為例,即便在非常暗的光線下拍照,也能展現更真實的情況。

跨語言實時交流也成為一大趨勢。由于自監督學習、noisy student training自訓練算法等技術的發展,語音識別的準確性繼續取得重大進展,嘈雜、重疊語音等環境以及跨語言的效果有了明顯改善。

日常交互也變得越來越自然,比如自動呼叫、機器學習代理,即使經常執行的簡短任務,也可通過智能文本選擇工具進行改進。

還有一些小例子也體現出AI的有益之處,比如注視識別技術,防止你看手機屏幕時變暗。

機器學習在確保個人和社區安全上也提供新方法。

比如“可疑信息警告”來應對疑似網絡釣魚攻擊,“安全路線”可以幫助識別和檢測什么時候該踩剎車,提示備用路線。

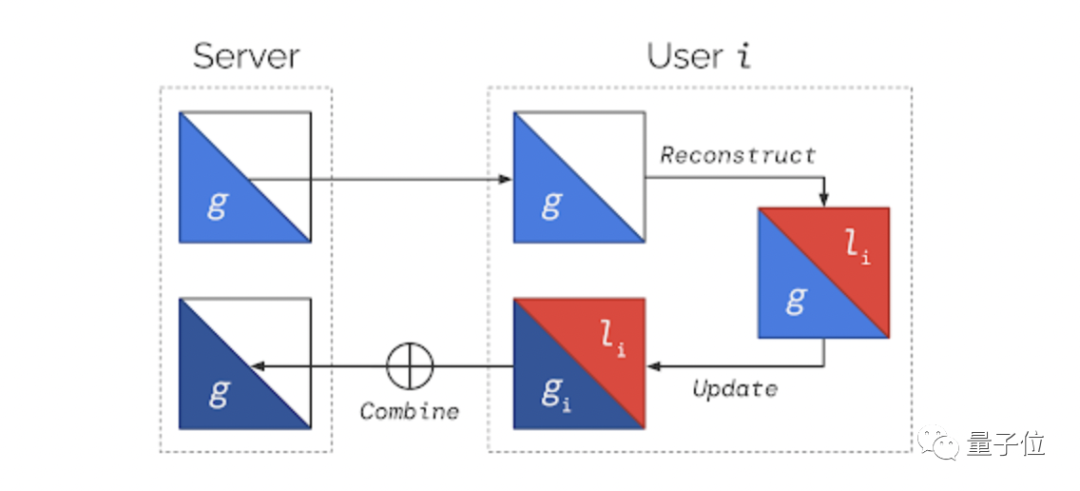

鑒于構成這些新功能的數據具有敏感性,隱私計算也就搬到了臺前。

安卓系統可確保私有計算核心處理的數據不被任何APP共享,與此同時還阻止了其內部的任何功能直接訪問網絡。

趨勢4:AI推動科學研究和醫學健康

近年來,我們已經看到機器學習對基礎科學的影響越來越大,從物理學到生物學,有很多令人興奮的實際應用。

計算機視覺作為典型,已經應用于解決個人和全球范圍的問題。

它既可以幫助醫生進行日常工作,擴展對神經生理學的理解,也可以提供天氣預報預測以及救災工作的優化。

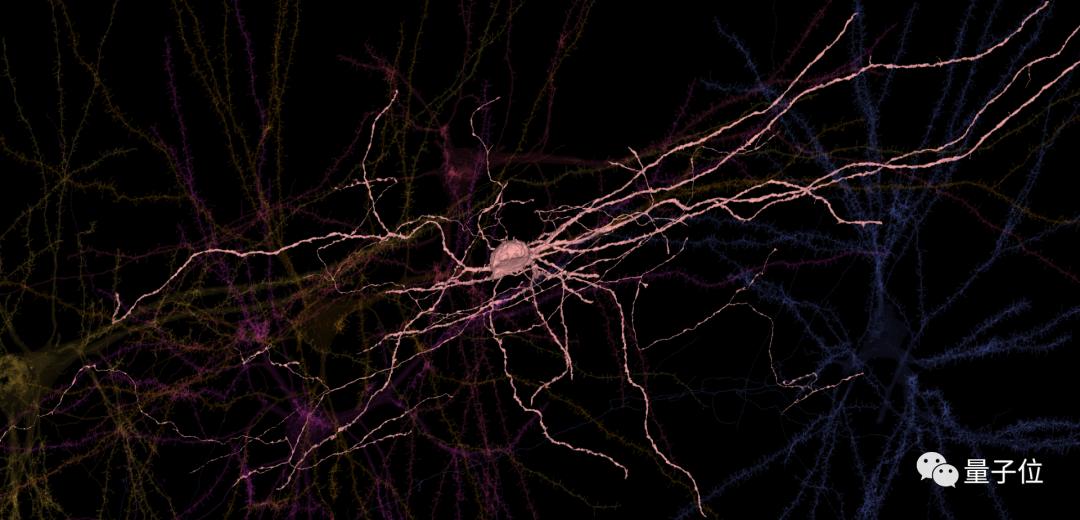

去年,谷歌與哈佛合作展開了第一個大規模人類大腦皮層突觸連接的研究,重建了人類大腦組織成像。

ps:圖中顯示了成人大腦860億個神經元中的6個

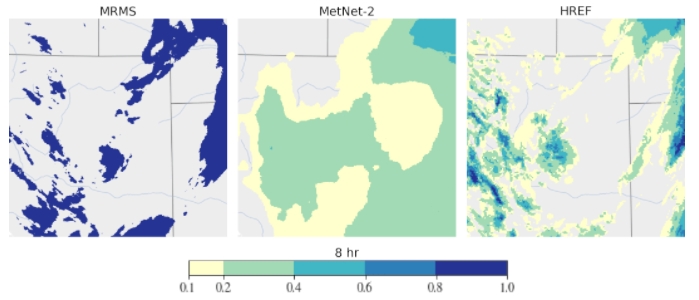

而若向外延伸,計算機視覺在應對全球挑戰上也有突出的作用,比如基于深度學習的天氣預測,預報12小時內的天氣和降水,比傳統的物理模型更準確。

還有像在文檔、游戲,包括芯片上的自動化設計布局,以及在醫學、人類健康、應對氣候變化上的關鍵作用也不容忽視。

以醫學健康為例,在基因組學的研究中機器學習可以幫助處理序列數據,看到基因組數據的隱藏特征,還能加速對個性化、健康的基因組信息的使用。

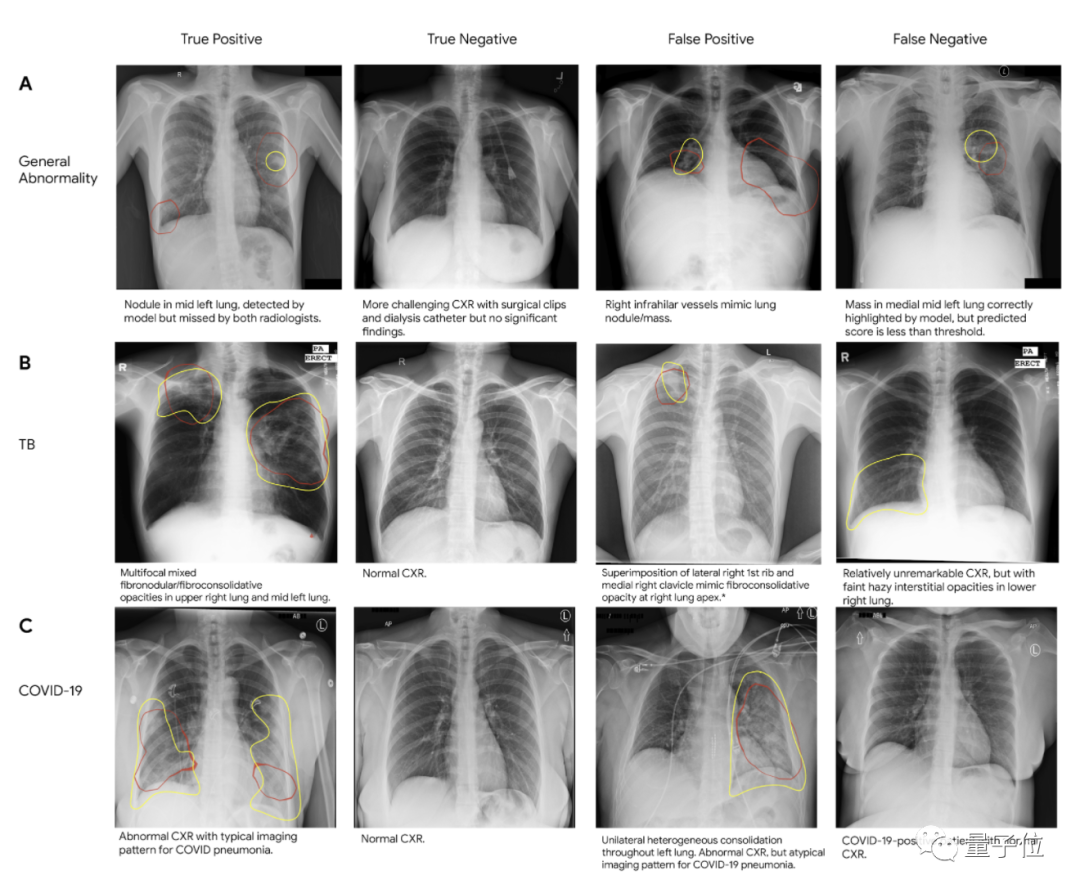

Jeff Dean還強調在疾病診斷,尤其是在醫學成像上的應用,比如在改善乳腺癌篩檢、檢測肺癌、加速癌癥的放射治療、標記異常X射線和前列腺癌期活檢等領域。

另一個值得關注的方向就是利用NLP技術來分析結構化數據與醫療記錄,輔助臨床醫生提供更準確的診斷護理。

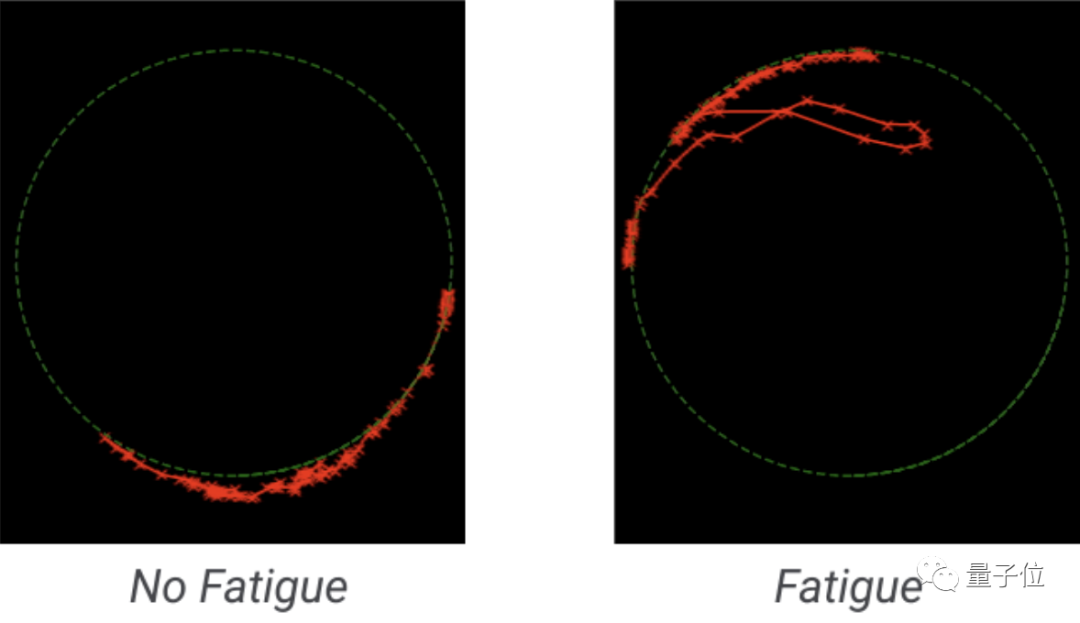

盡管機器學習對于擴大獲取途徑和提高臨床診斷的準確性非常重要,但我們看到一個同樣重要的新趨勢正在出現:智能手機上的健康功能,幫助用戶對自己的健康狀況進行評估。

趨勢5:做負責任的人工智能

隨著機器學習越來越廣泛地應用于社會中去,保證其更公平公正的使用正成為下一個技術出發點。

一個重點領域就是基于用戶活動的推薦系統,最近工作揭示了如何提高單個組件和整個推薦系統的公平性。

在機器翻譯上的應用也同樣重要,因為大多數機器翻譯系統是孤立地翻譯單個句子的,沒有附加的語境。

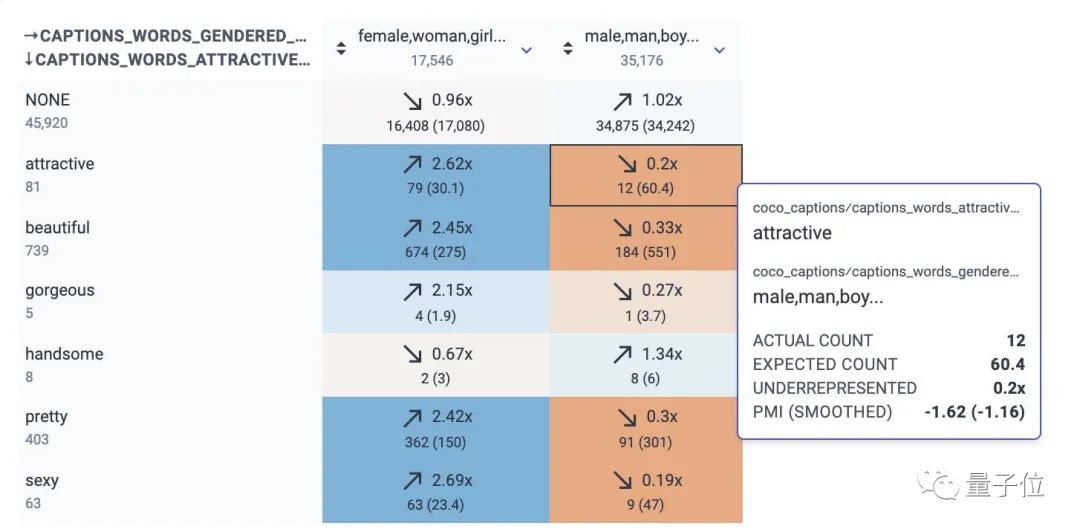

它們往往會加強與性別、年齡或其他領域有關的偏見。去年谷歌發布了個數據集,用于研究翻譯維基百科傳記時的性別偏見。

部署機器學習模型的另一個常見問題是分布轉移。如果模型所依據的數據統計分布與所輸入的數據統計分布不一致,那么模型的行為可能是不可預測的。

在最近的工作中,谷歌Deep Bootstrap框架可以幫助比較、理解模型在這兩種情況下的表現,使得模型更好適應未知環境,并對固定的訓練數據集不會產生太大的偏見。

除此之外在機器學習上游——數據收集和數據集管理上,也有相應的探索。

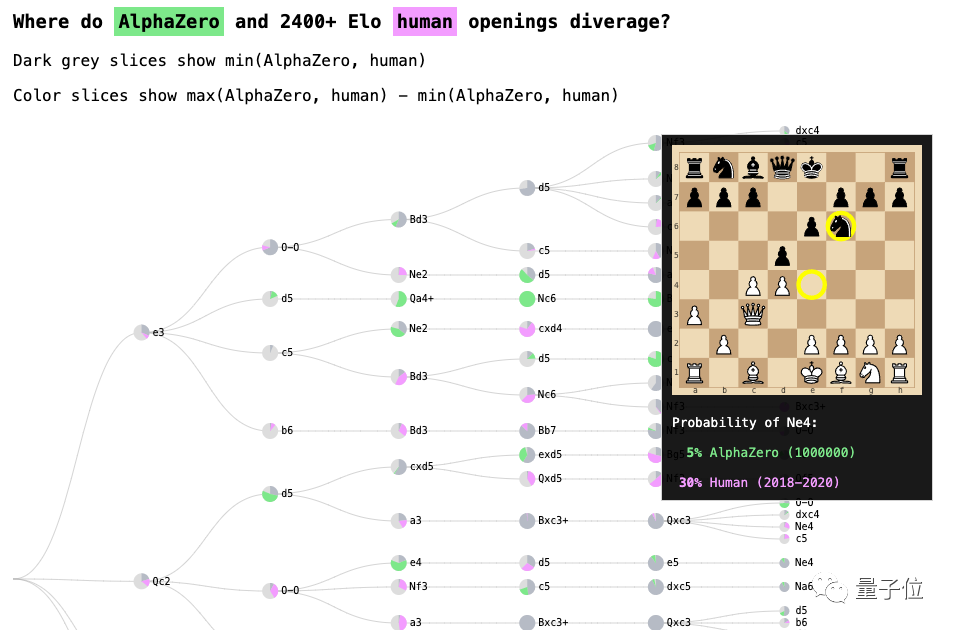

還有像處理網上辱罵行為、模型的交互式分析和調試、機器學習的可解釋性(以AlphaZero國際象棋系統為典型),以及改善社區生活等維度都是谷歌解決的方向。

總之,再三強調一個愿景:做負責任的人工智能。

One More Thing

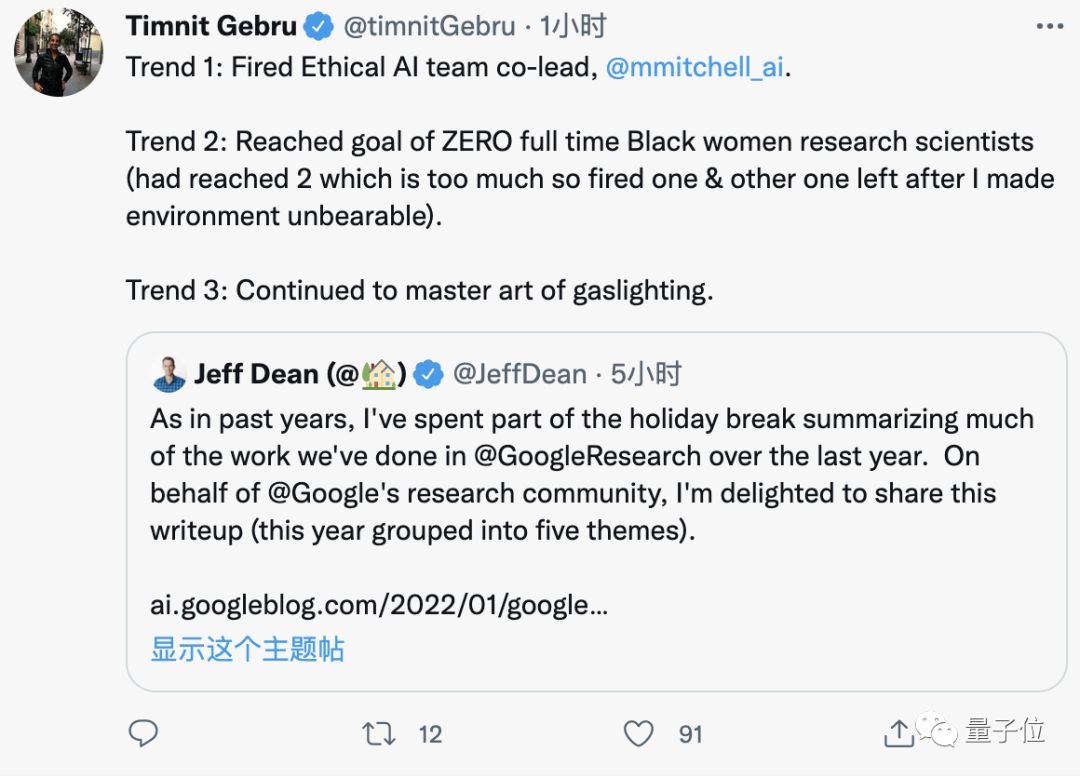

在這篇博文下互動區,看到了熟悉的身影。

那就是讓Jeff Dean陷入歧視風波的那位前員工Timnit Gebru,她也轉發了一波~

不過,這畫風……嗯,就有點尷尬。

好了,感興趣的旁友,可戳下方鏈接看詳細報告~

以及別忘了到公眾號后臺回復“姐夫2021”,獲取27個谷歌開源工具及數據集匯總。

直達鏈接:

https://ai.googleblog.com/2022/01/google-research-themes-from-2021-and.html