Richard Sutton:經(jīng)驗是AI的終極數(shù)據(jù),四個階段通向真正AI的發(fā)展之路

導讀:強人工智能的發(fā)展是近年來關注的話題。讓AI從人類的感知和行為,而非單純的標注數(shù)據(jù)中學習,成為許多研究者關注的重點。其中,如何利用人類習得的日常生活經(jīng)驗,啟發(fā)構建能夠適應不同環(huán)境,與外部世界交互的人工智能這成為一些領域探索的新路。

被譽為強化學習之父的Richard Sutton近日提出了利用經(jīng)驗啟發(fā)AI發(fā)展的思路。他將AI從利用數(shù)據(jù)到利用經(jīng)驗的過程分為四個發(fā)展階段,提出了未來構建真正AI(Real AI)的發(fā)展方向。2022年5月31日,Richard Sutton在2022北京智源大會上發(fā)表了題為“The Increasing Role of Sensorimotor Experience in AI”的主題演講,對利用經(jīng)驗啟發(fā)AI發(fā)展的方法進行了總結和展望。

講者簡介:理查德·薩頓(Richard Sutton),現(xiàn)代計算型強化學習創(chuàng)始人之一,是 DeepMind 的杰出研究科學家,阿爾伯塔大學計算科學系教授,也是英國皇家學會、加拿大皇家學會、人工智能促進會、阿爾伯塔機器智能研究所 (AMII) 和 CIFAR 的研究員。

01. 背景:經(jīng)驗對智能發(fā)展的重要意義

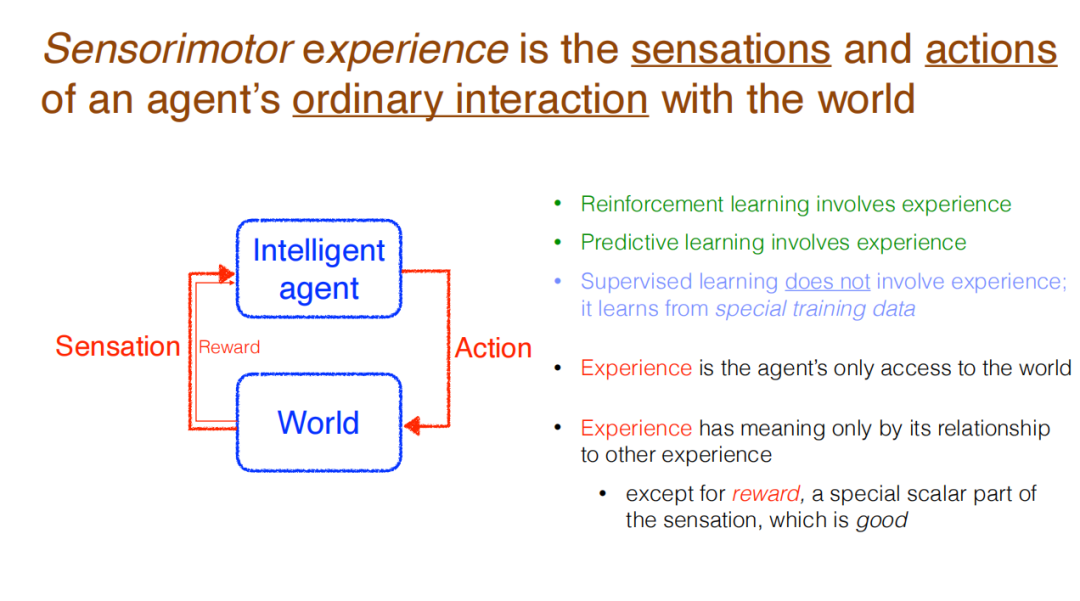

Sutton認為,智能體與外部世界發(fā)生交互,向其發(fā)出動作,并接收感知(帶來的反饋)。這種涉及到經(jīng)驗的交互,是強化學習中正常的感知方式。也是讓智能體嘗試預測外部世界時所采用的正常途徑。然而,這種方法在監(jiān)督學習中并不多見,而監(jiān)督學習是當前最為常見的機器學習類型。機器學習中并不涉及普通經(jīng)驗(Ordinary Experience),模型也不會從不同于普通經(jīng)驗的特殊訓練數(shù)據(jù)中學習。事實上,在運行時,監(jiān)督學習系統(tǒng)根本不學習。

所以說,經(jīng)驗是互動(帶來)的數(shù)據(jù),是與外部世界溝通的途徑。經(jīng)驗沒有任何意義,除非與其他經(jīng)驗之間產(chǎn)生聯(lián)系。當然,有一個例外:經(jīng)由特殊信號所表示獎勵。獎勵代表著好的目標,智能體當然希望能夠最大化獎勵。

演講中,Sutton提出了一個核心問題:智能最終是可以被什么來解釋?是客觀的術語(Objective terms),還是經(jīng)驗的術語(Experiential terms)?前者包含外部世界的狀態(tài)、目標、人、地點、關系、空間、動作、距離等不在智能體中的事物,后者則包含感知、動作、獎勵、時間步等智能體內部的事物。Sutton認為,盡管研究者通常會在交流和寫論文時思考客觀的概念,但是現(xiàn)在應當更加關注有關智能體與外部世界交互過程中產(chǎn)生的經(jīng)驗。

為了進一步介紹經(jīng)驗對于智能體的重要意義,Richard Sutton 提出,隨著經(jīng)驗逐漸被重視,一共經(jīng)歷了四個階段。分別為:智能體(Agenthood ),獎勵(Reward),經(jīng)驗狀態(tài)(Experiential State),以及可預測知識(Predictive Knowledge)。經(jīng)過這四個階段的發(fā)展,AI逐漸擁有經(jīng)驗,變得更加實際、可學習且易于擴展。

02. 經(jīng)驗在AI發(fā)展的歷程

1.智能體(Agenthood)

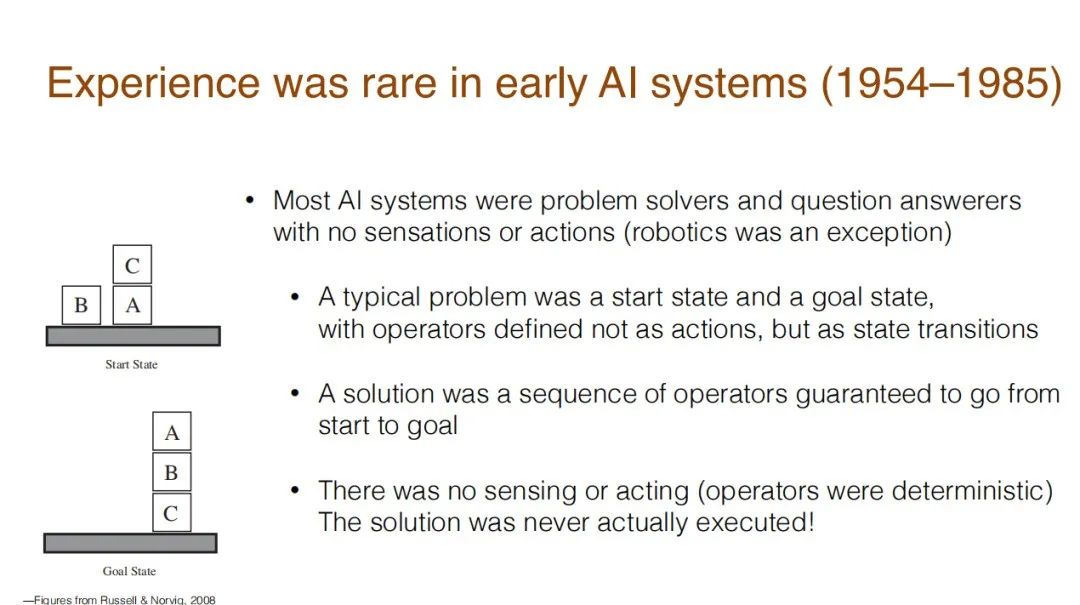

智能體的含義是擁有/獲得經(jīng)驗(的AI)。可能令人驚訝的是,早期的AI系統(tǒng)確實沒有任何經(jīng)驗。在人工智能發(fā)展的早期階段(1954-1985年),大多數(shù)AI系統(tǒng)只是用來解決問題或回答問題,他們沒有感知能力,也不會行動。機器人是一個例外,但傳統(tǒng)的系統(tǒng)只有啟動狀態(tài)和目標狀態(tài),如同下圖中要堆疊的積木塊一樣。

如果要達到恰當?shù)哪繕藸顟B(tài),其解決方案就是一個行動序列,確保AI能夠從啟動狀態(tài)達到目標狀態(tài)。這其中沒有感知和行動的存在,因為整個外部世界是已知、確定、封閉的,所以并不需要讓AI感知和行動。研究者知道什么事情會發(fā)生,所以只需要構建一個解決問題的計劃,讓AI來執(zhí)行即可,人類知道這樣就能解決問題。

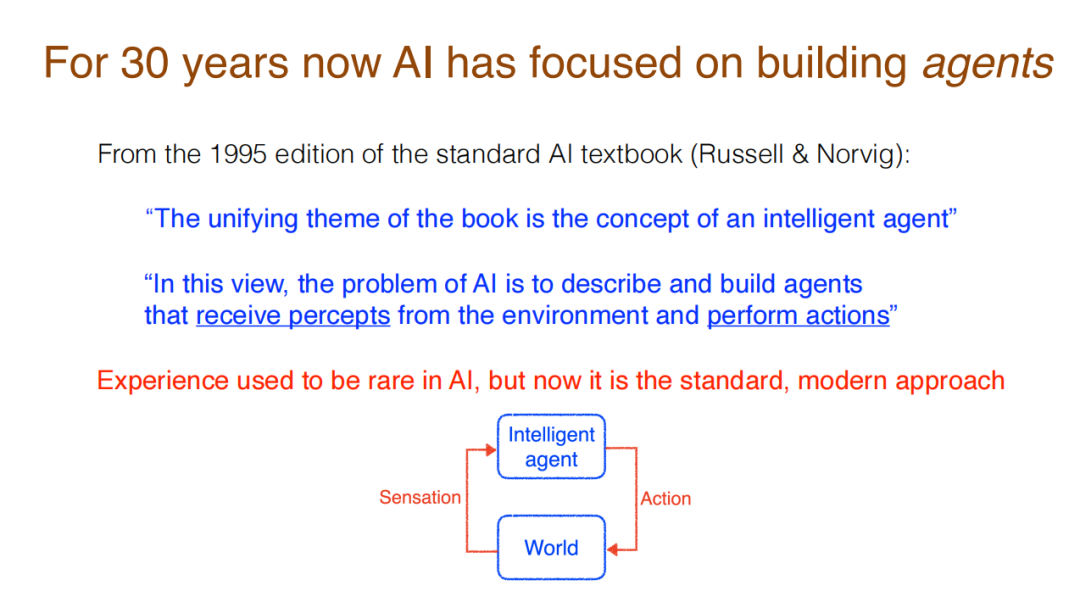

在過去30年的發(fā)展中,人工智能的研究關注構建智能體。這種轉變可以體現(xiàn)在這一點:人工智能的標準教科書囊括了智能體的概念,將其作為基礎。例如,1995年版本的《人工智能:一種現(xiàn)代的方法》中提到,全書的統(tǒng)一主題在于介紹智能體(Intelligent Agent)的概念。在這種視角下,AI的問題在于描述和構建智能體,并從環(huán)境中獲得認知,并采取行動。隨著研究的發(fā)展,標準、現(xiàn)代的方法是構建一個能夠和外部世界交互的智能體。Sutton認為可以從這個視角看待AI。

2.獎勵(Reward)

獎勵(Reward)是以經(jīng)驗的形式來描述AI的目標。這也是當前提出的一種有效方法,能夠構建AI的所有目標。這也是Sutton與其合作者提出的方法。

獎勵被認為是目前較為充分的一種假說——智能及其相關的能力都可以被理解為是服務于最大化獎勵的結果。所以有說法認為,獎勵對于智能體而言已經(jīng)足夠了。

然而Sutton認為,這一思路是需要被挑戰(zhàn)的。獎勵并不足夠實現(xiàn)智能。獎勵僅僅只是一個數(shù)字、一個標量,它并不足以解釋智能的目標。來自頭腦之外,僅用單一數(shù)字表達的目標,顯得太小、太還原,甚至太貶低(人類的目標)了。人類喜歡把目標想象得更宏大,如照顧家庭、拯救世界、世界和平、讓世界更美好。人類的目標比最大化快樂和舒適更為重要。

正如研究者發(fā)現(xiàn)獎勵并不是很好的構建目標的方法,研究者也發(fā)現(xiàn)了通過獎勵構建目標的優(yōu)勢。獎勵構建的目標太小,但是人們可以在其中取得進展——目標可以被良好、清晰地定義,且易于學習。這對于通過經(jīng)驗構建目標而言反而是個挑戰(zhàn)。

Sutton認為,想象通過經(jīng)驗來充分地構建目標,這是有挑戰(zhàn)的。回顧歷史可以看到,AI原本也不是對獎勵有興趣的,即使是現(xiàn)在也是如此。所以,不管是早期的問題解決系統(tǒng),還是當前最新版的AI教科書,其依然將目標定義為需要達到的世界狀態(tài)(World State),而非經(jīng)驗性的(定義)。這種目標可能依然是特定的一系列“積木”,不是一種需要達到的感知結果。

當然,最新的教科書中已經(jīng)有章節(jié)提到強化學習,并提及這些AI使用的是獎勵機制。此外,構建目標的過程中,獎勵已是一種常規(guī)的做法,可以使用馬爾科夫決策過程來實現(xiàn)。對于批評獎勵不能夠充分構建目標的研究者(如Yann LeCun)來說,獎勵已經(jīng)是智能這塊“蛋糕”頂端的“櫻桃”了,它很重要。

在接下來的兩個階段,Sutton將介紹應當怎樣從經(jīng)驗的角度來理解外部世界,但在此之前,他將首先介紹經(jīng)驗指代的是什么。

3.插曲:什么是經(jīng)驗

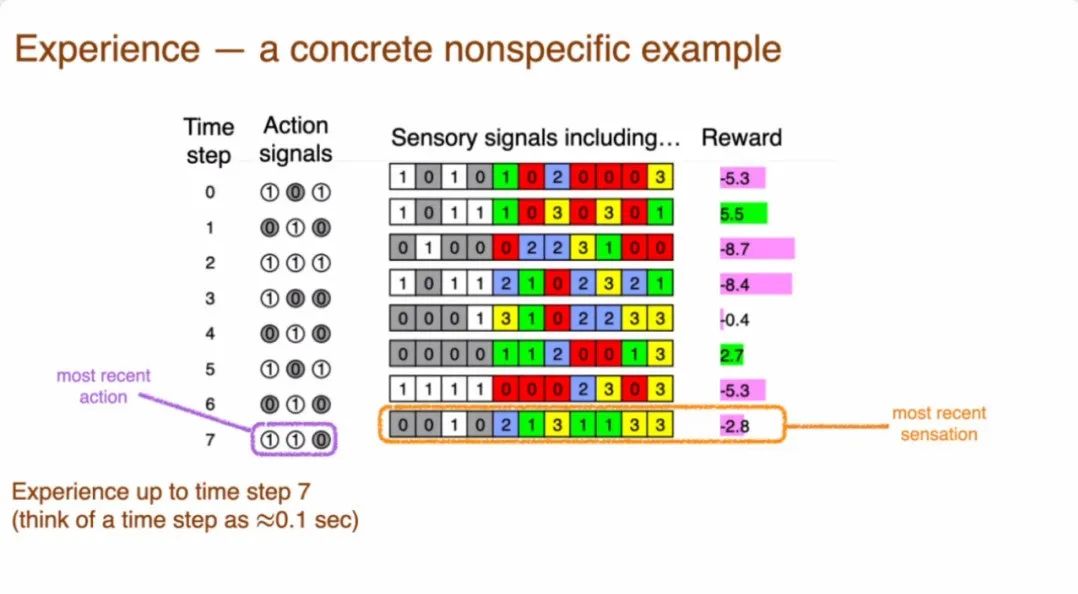

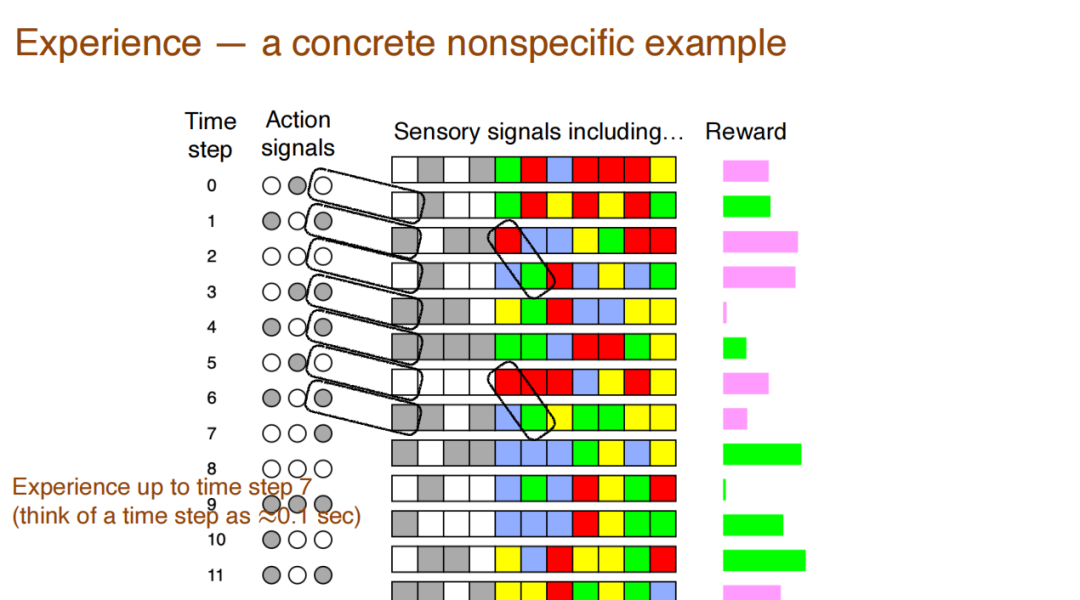

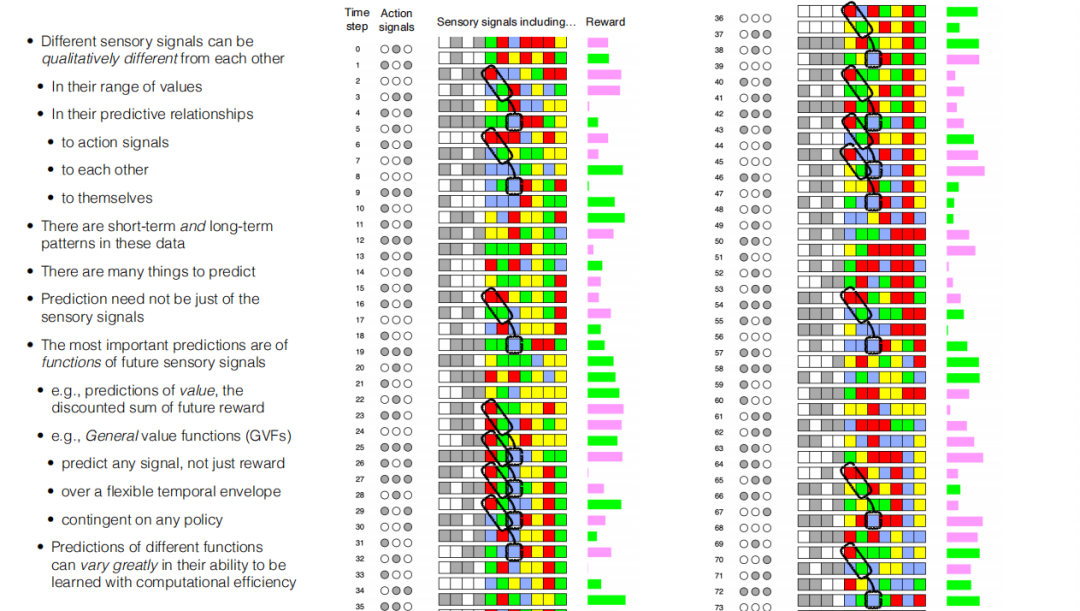

如下圖的序列(非真實數(shù)據(jù))所示,當時間步啟動的時候,系統(tǒng)會得到感知信號,而且也會發(fā)出信號和行動。所以感知信號可能會引起一些動作,而這些動作會引起下一個感知信號。在任何時候,系統(tǒng)都需要關注關注最近的行動和最近的信號,這樣才能決定接下來將會發(fā)生什么,應當怎樣去做。

如圖所示,這是一個智能體執(zhí)行程序的輸入輸出信號陣列。第一列是時間步,每一步可認為是0.1秒或0.01秒的瞬間。行動信號列則采用二級制表示,由灰白兩色表示。之后是感知信號列,其中前四列是二進制值(也使用灰白兩色),后四列則采用0-3的四種取值,用紅黃藍綠四種顏色表示,最后一列則是連續(xù)變量,代表獎勵。在實驗中,研究者將數(shù)字去掉,只留下顏色,以便于在其中尋找模式。Sutton認為,經(jīng)驗,是指對感覺-運動經(jīng)驗的數(shù)據(jù)中發(fā)現(xiàn)的模式產(chǎn)生的知識和理解。

在本案例中,Sutton列舉了四個典型的模式:

1.行動的最后一位,和緊隨其后的感知信號是相同的。如果某一時間步的行動是白色的,其后的第一個感知信號也是白色,灰色亦然。

2.當出現(xiàn)紅像素時,緊隨其后的一個時間步是綠色像素。擴大數(shù)據(jù)范圍后可以發(fā)現(xiàn),在紅綠像素先后出現(xiàn)后,隔一個時間步會出現(xiàn)藍色像素。

3.數(shù)據(jù)的最后三列往往會出現(xiàn)一長串同樣顏色,保持不變。一種顏色一旦開始,會持續(xù)多個時間周期,最終形成條紋。如很長的一串紅色、綠色、藍色等。

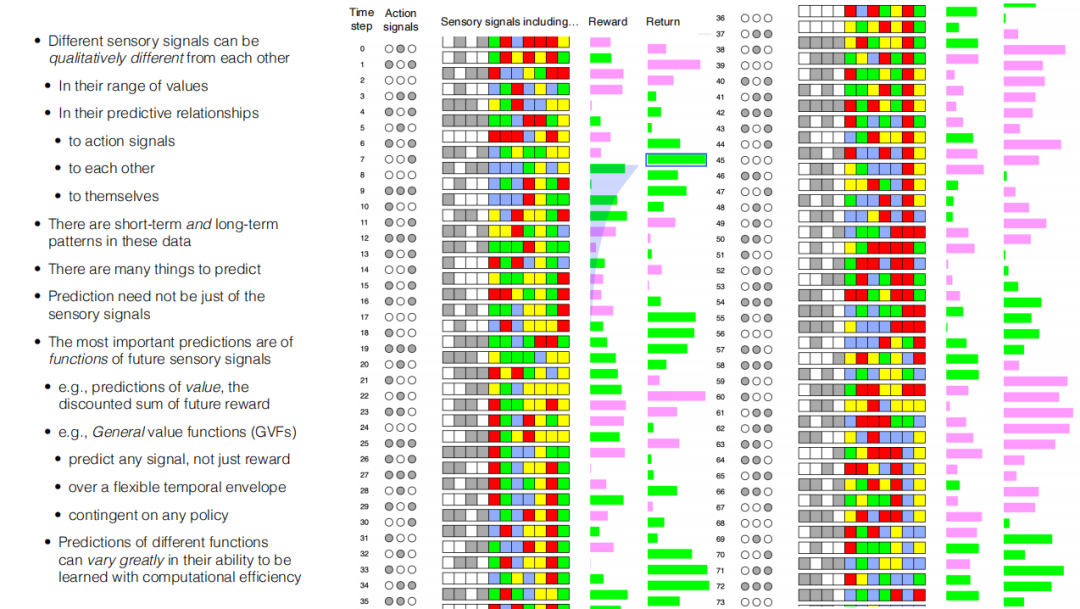

4.如果展示AI預測的特定感知數(shù)據(jù),很多時候這是無法立刻被觀察到的,因此在本數(shù)據(jù)中增加返回值(Return),其代表著對將會到來的獎勵的預測。框中的綠色條帶代表了隨后的獎賞中,綠色會比紅色多。這代表著當前對于獎勵的預測。

特殊的陰影區(qū)域則表示等待函數(shù)。等待函數(shù)的陰影區(qū)域中會有綠色和紅色的條帶。在這里,研究者將越早返回的,帶有顏色獎勵給予更高的權重。當隨著返回值根據(jù)時間移動時,就可以看到預測結果和實際獎勵之間的顏色和值的對應變化,這種返回值便是一種預測——其可以從經(jīng)驗中學習到。

Sutton認為,這種返回值本質上并不是從已經(jīng)發(fā)生的事件中學習的,而是從時間差信號中學到的。其中最重要的信號就是價值函數(shù)。在本例中,返回值實際上是一個價值函數(shù),代表的是對于未來獎勵的總和。如果想要一個一般形式的,復雜的,能夠指代未來值的函數(shù),可采用名為一般價值函數(shù)(General Value Functions GVFs)的方法。一般價值函數(shù)包括了各種信號,不僅僅是獎勵;可以是任何時間包絡形式,而不僅僅是指數(shù)。一般價值函數(shù)還可以包括任何隊列的策略,可以預測數(shù)量非常多,范圍很廣的事情。當然,Sutton認為,通過計算進行預測,其難易程度取決于被預測對象的形式。當使用一般價值函數(shù)進行預測時,被預測對象的表達形式需要被設計成易于學習的形式,且需要很高的計算效率。

4.經(jīng)驗狀態(tài)(Experiential State)

提到“狀態(tài)”這個詞,很多研究會提到的是世界狀態(tài)(World State),這是一個屬于客觀概念之下的詞語。狀態(tài)指的是對客觀世界的一種符號化的描述(反映),能夠和世界本身的情況匹配。例如,對于積木塊的位置信息(C在A上)等。在最近的一段時間,一些研究者(如Judea Pearl)提出了概率圖模型,其表示的是世界狀態(tài)的概率分布。一些事件,如“外面下雨,草地是否是濕的?”等,這些事件之間都存在概率關系。

另一種狀態(tài)是信念狀態(tài)(Belief State),在這種概念中,狀態(tài)是一種概率分布,表示的是離散世界的狀態(tài),其對應的方法被稱為POMDPs(Partially observable Markov decision process)——存在隱藏狀態(tài)變量,其中部分是可觀察到的,可以使用馬爾科夫決策過程進行建模。

以上的方法均是客觀的狀態(tài),與經(jīng)驗相距甚遠,是研究者一開始嘗試描述世界狀態(tài)的方法。

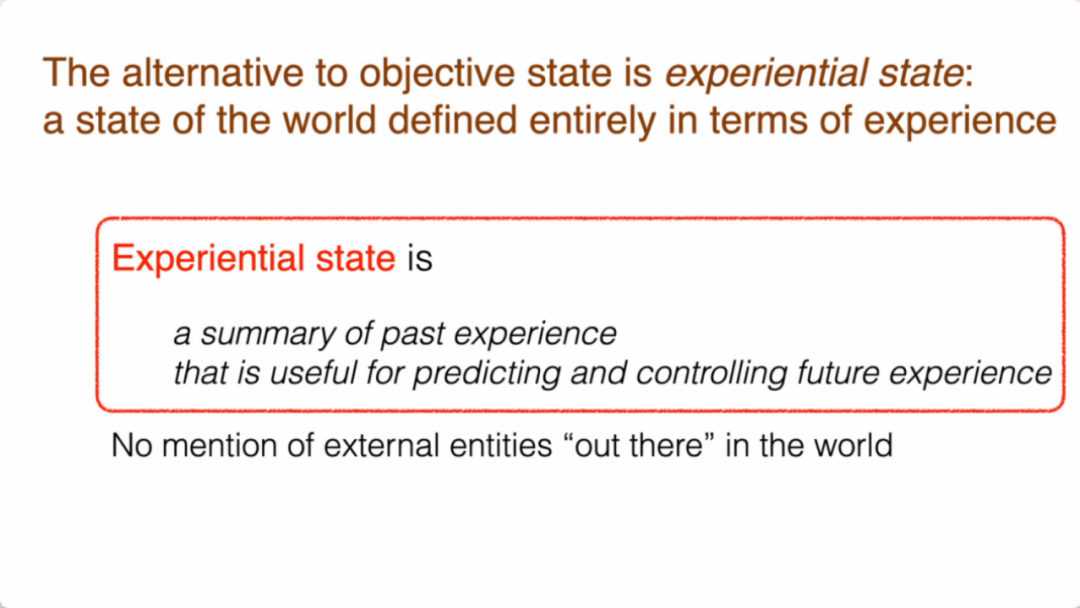

而與之不同的,是經(jīng)驗狀態(tài)。Sutton認為,經(jīng)驗狀態(tài)指的是整個世界的狀態(tài)根據(jù)經(jīng)驗來定義。經(jīng)驗狀態(tài)是過去經(jīng)驗的總結,能夠預測和控制未來將會獲得的經(jīng)驗。

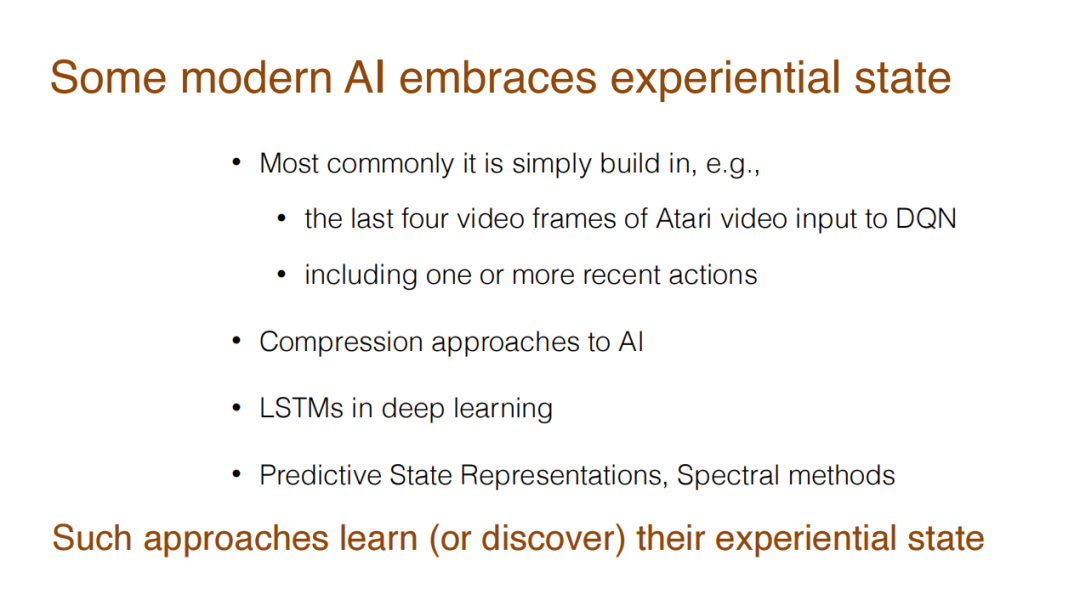

這種構造過去經(jīng)驗,預測未來的做法,在研究中已有體現(xiàn)。例如,強化學習任務之一——雅達利游戲中,研究者會用最后四幀的視頻構建經(jīng)驗狀態(tài),然后預測之后的行為。LSTM網(wǎng)絡中的一些方法,也可以被認為是從某種經(jīng)驗狀態(tài)中進行預測。

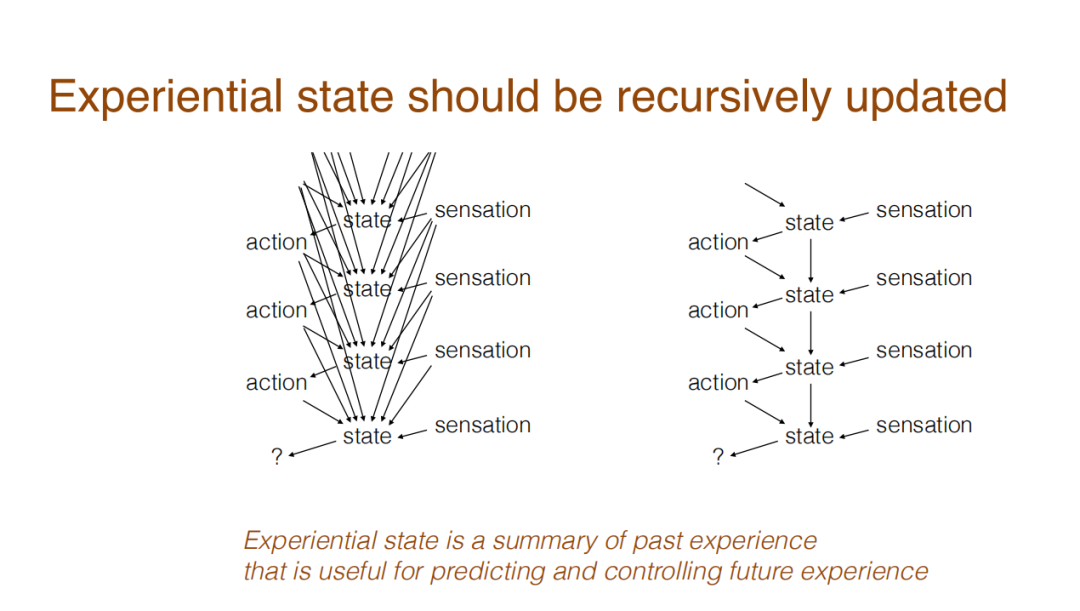

回看經(jīng)驗狀態(tài),它是可以遞歸更新的。經(jīng)驗狀態(tài)是整個過去發(fā)生事情總結的函數(shù),由于AI需要每時每刻訪問經(jīng)驗狀態(tài),實現(xiàn)對接下來發(fā)生事件的預測,所以經(jīng)驗狀態(tài)的更新是遞歸式的:當前時刻只訪問上一時刻的經(jīng)驗狀態(tài),而上一時刻經(jīng)驗狀態(tài)是對過去所有發(fā)生過的事件的總結。到了下一個時刻,也只訪問此時此刻的經(jīng)驗狀態(tài),而這個經(jīng)驗狀態(tài)也是對過去發(fā)生的所有事件的總結。

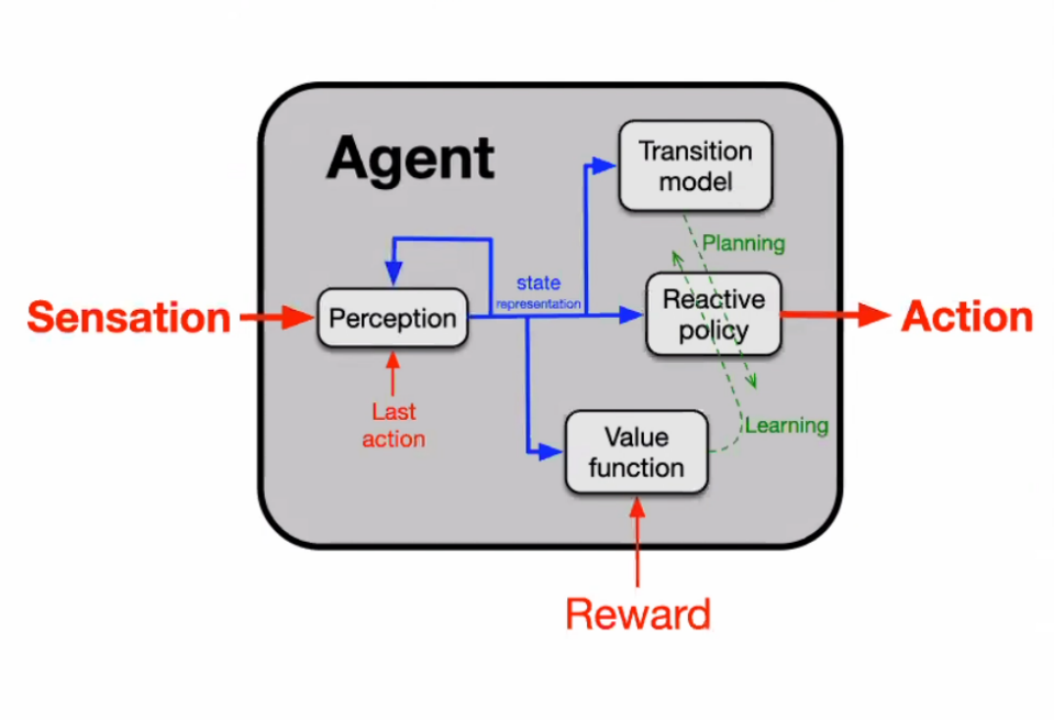

下圖顯示了智能體經(jīng)驗狀態(tài)的構造過程。其中,紅色箭頭表明智能體的基礎工作信號,包括:感覺、行動、獎勵等。藍箭頭標注的是經(jīng)驗狀態(tài)(表征)的方向,從感知中輸出,其負責對每個時間步更新其經(jīng)驗狀態(tài)。更新的狀態(tài)會被用來為行動制定策略,或進行其他更新。

5.預測性知識(Predictive Knowledge)

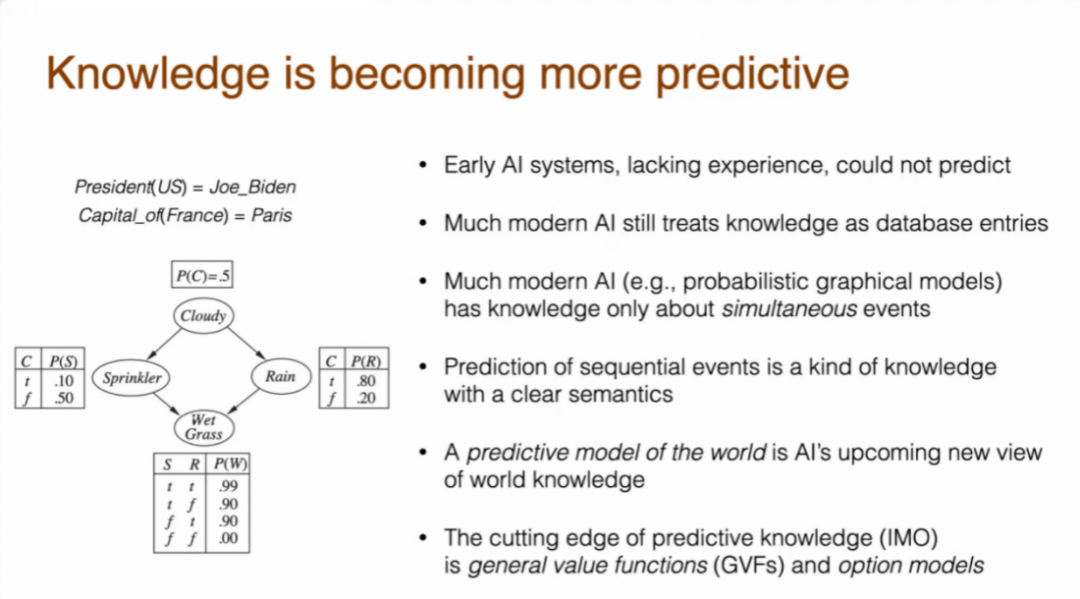

知識,如“喬拜登是美國總統(tǒng)”,“埃菲爾鐵塔在巴黎”等,都是對于外部客觀世界的一種描述,并不是經(jīng)驗性的。但是,類似于“做某事預計花費X小時”這類知識,是經(jīng)驗知識。經(jīng)驗知識和客觀知識之間存在著巨大的差異,這也是對于AI研究具有挑戰(zhàn)性的一點。

以往的AI研究傾向于將知識視為一種客觀項,盡管近期已經(jīng)有一些研究從經(jīng)驗的角度來看待問題。早期的AI系統(tǒng)沒有經(jīng)驗,也就無法進行預測。而更現(xiàn)代一些的AI將知識視為客觀的存在。更為先進一些的是概率圖模型,但是很多時候其研究的是兩件同時發(fā)生的事情之間的概率,而預測面向的應該是一連串序列事件。

基于對序列事件的預測是具有明確語義屬性的知識。如果某事情被預測會發(fā)生,AI就可以將預測和實際結果對比。而這種預測模型,可以被認為是一種新的世界知識,即預測性知識。而在預測性知識中,Sutton認為最前沿的就是通用價值函數(shù)(General Value Function)和選擇模型(Option Model)。

Sutton 把世界知識分為兩類,一是關于世界狀態(tài)的知識;二是關于世界狀態(tài)轉換的知識。有關世界狀態(tài)轉換知識的案例是世界預測模型。此處的的世界預測模型,并不是初級形態(tài)的馬科夫決策過程或差分方程。它可以是抽象的狀態(tài),在經(jīng)驗狀態(tài)中可以被抽取出來。由于預測是以整個行為為條件進行的,所以在選擇模型中,智能體也可以選擇停止某個策略,終結某種條件。有時候,使用對于旋律的遷移模型,可以預測進行了某個行動后的狀態(tài)。以日常生活為例,假設某人要去城里,他/她會對前往市中心的距離、時間進行一個預測,對于超過某個閾值的行為(如步行10分鐘進城),就會進一步預測出一個狀態(tài),如疲憊等。

有了這種能夠延伸行為的模型,其知識所表示的規(guī)模也可以非常的大。例如,可以根據(jù)一個行為,預測世界狀態(tài),然后根據(jù)狀態(tài)再預測下一個行為......以此類推。

總結經(jīng)驗在AI研究中的發(fā)展歷程,Sutton表示,經(jīng)驗是世界知識的基礎,人類本身是通過感知和行動來認識和影響世界的,經(jīng)驗是人類獲得信息、采取行動的的唯一方式,而且是人類離不開的。遺憾的是,由于經(jīng)驗過于主觀化和個人化,人類仍然不喜歡用經(jīng)驗的方式去思考和表達。經(jīng)驗對于人類太過陌生、反直覺、短暫、復雜。而經(jīng)驗也是主觀、私人的,與他人進行交流,或者進行驗證幾乎是不可能的。

Sutton認為,經(jīng)驗對于AI十分重要,有以下幾個原因。一是經(jīng)驗來自于AI的日常運行過程,獲得這些經(jīng)驗是無成本的、自動的。同時,AI領域有大量的數(shù)據(jù)用于計算,因此經(jīng)驗提供了通向了解世界的道路,如果世界中的任何事實都是經(jīng)驗性的,那么AI可以從經(jīng)驗中學習對世界的認識,并在經(jīng)驗中進行驗證。

總結而言,Sutton認為,過去70年的AI發(fā)展歷程中,AI逐漸在增加對經(jīng)驗的重視——獲得經(jīng)驗、根據(jù)經(jīng)驗設定目標、并根據(jù)經(jīng)驗獲得狀態(tài)和知識。在每一個階段,對于人類更為陌生的經(jīng)驗研究正在變得更加重要,而且其具有接地氣(Grounding)、可學習和可擴展的優(yōu)勢。

03. 未來AI利用經(jīng)驗的方法

Sutton認為,目前對于經(jīng)驗利用方面,AI還未完成階段三和四,但是這種趨勢向前會越走越遠。Sutton認為,將一切都歸于經(jīng)驗,是通向真正AI的可行路徑。盡管非常具有挑戰(zhàn)性,但這是能夠理解數(shù)據(jù)流,實現(xiàn)智能的圖景。最后,Sutton進一步凝煉重視感知運動經(jīng)驗的四個階段,形成一句標語:“數(shù)據(jù)驅動著人工智能,而經(jīng)驗就是終極的數(shù)據(jù)。如果能利用好經(jīng)驗,我們就可以更快速有力地推動人工智能發(fā)展。”