給我一張圖,生成30秒視頻!

AI又進階了?

而且是一張圖生成連貫30秒視頻的那種。

emm....這質量是不是有點太糊了

要知道這只是從單個圖像(第一幀)生成的,而且沒有任何顯示的幾何信息。

這是DeepMind最近提出的一種基于概率幀預測的圖像建模和視覺任務的通用框架——Transframer。

簡單講,就是用Transframer來預測任意幀的概率。

這些幀可以以一個或者多個帶標注的上下文幀為條件,既可以是先前的視頻幀、時間標記或者攝像機標記的視圖場景。

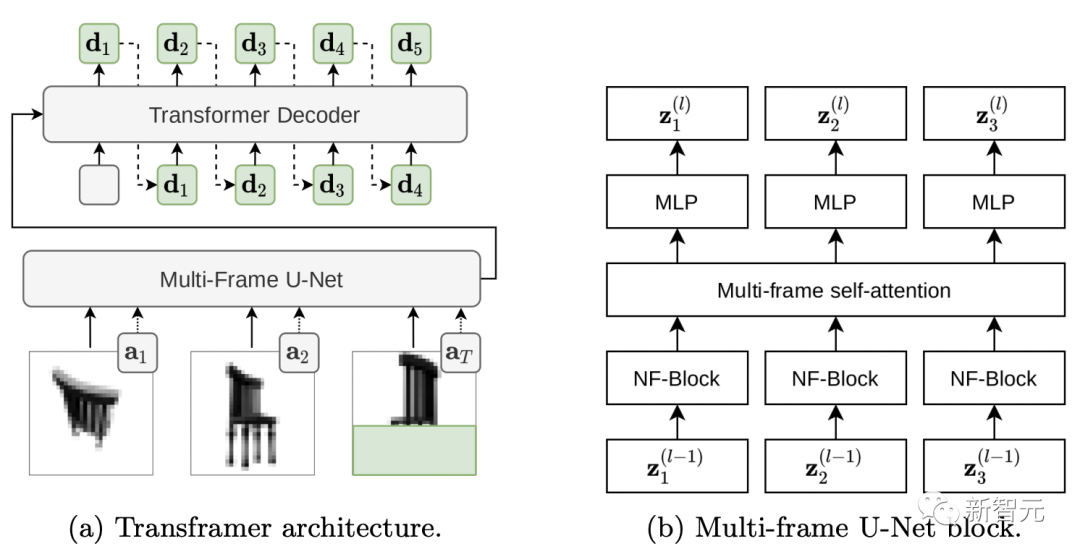

Transframer架構

先來看看這個神奇的Transframer的架構是怎么運作的。

論文地址就貼在下面了,感興趣的童鞋可以看看~https://arxiv.org/abs/2203.09494

為了估計目標圖像上的預測分布,我們需要一個能夠生產多樣化、高質量輸出的表達生成模型。

盡管DC Transformer在單個圖像域上的結果可以滿足需求,但并非以我們需要的多圖像文本集 {(In,an)}n 為條件。

因此,我們對DC Transformer進行了擴展,以啟用圖像和注釋條件預測。

我們替換了DC Transformer 的Vision-Transformer風格的編碼器,該編碼器使用多幀 U-Net 架構對單個DCT圖像進行操作,用于處理一組帶注釋的幀以及部分隱藏的目標DCT圖像。

下面看看Transframer架構是如何工作的。

(a)Transframer將DCT圖像(a1和a2)以及部分隱藏的目標DCT圖像(aT)和附加注釋作為輸入,由多幀U-Net編碼器處理。接下來,U-Net輸出通過交叉注意力傳遞給DC-Transformer解碼器,該解碼器則自動回歸生成與目標圖像的隱藏部分對應的DCT Token序列(綠色字母)。(b)多幀U-Net block由NF-Net卷積塊、多幀自注意力塊組成,它們在輸入幀之間交換信息和 Transformer式的殘差MLP。

再來看看處理圖像輸入的Multi-Frame U-Net。

U-Net的輸入是由N個DCT幀和部分隱藏目標DCT幀組成的序列,注釋信息以與每個輸入幀相關聯的向量的形式提供。

U-Net的核心組件是一個計算塊,它首先將一個共享的NF-ResNet 卷積塊應用于每個輸入幀,然后應用一個Transformer樣式的自我注意塊來聚合跨幀的信息。(圖2 b)

NF-ResNet塊由分組卷積和擠壓和激發層組成,旨在提高TPU的性能。

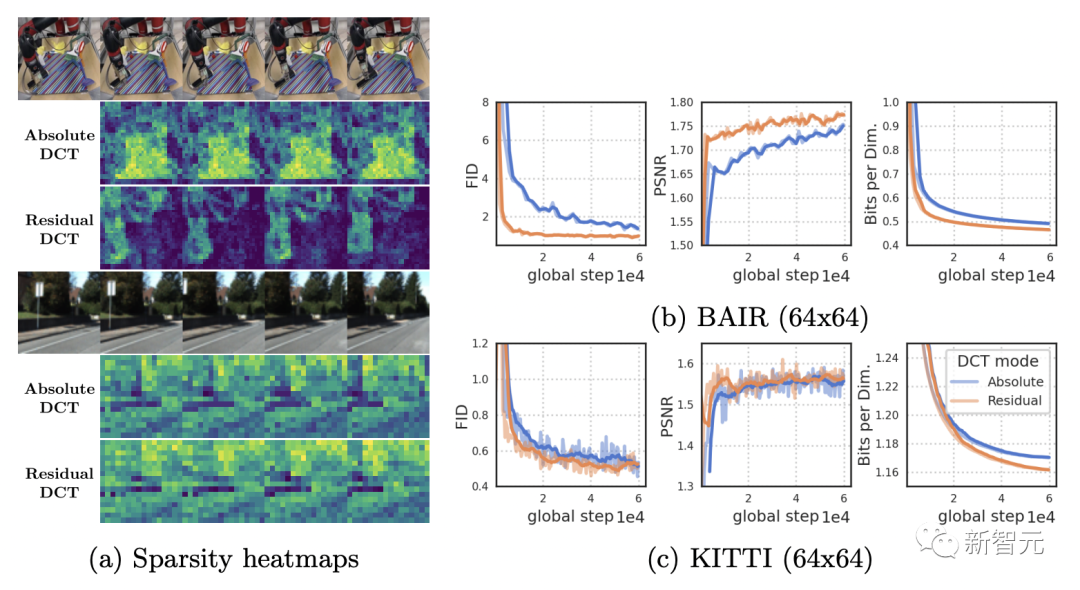

下面,圖(a)比較了RoboNet (128x128) 和KITTI視頻的絕對和殘差DCT表征的稀疏性。

由于RoboNet由只有少數運動元素的靜態視頻組成,因此殘差幀表征的稀疏性顯著增加。

而KITTI視頻通常具有移動攝像頭,導致連續幀中幾乎所有地方都存在差異。

但在這種情況下,稀疏性小帶來的好處也隨之弱化。

多視覺任務強者

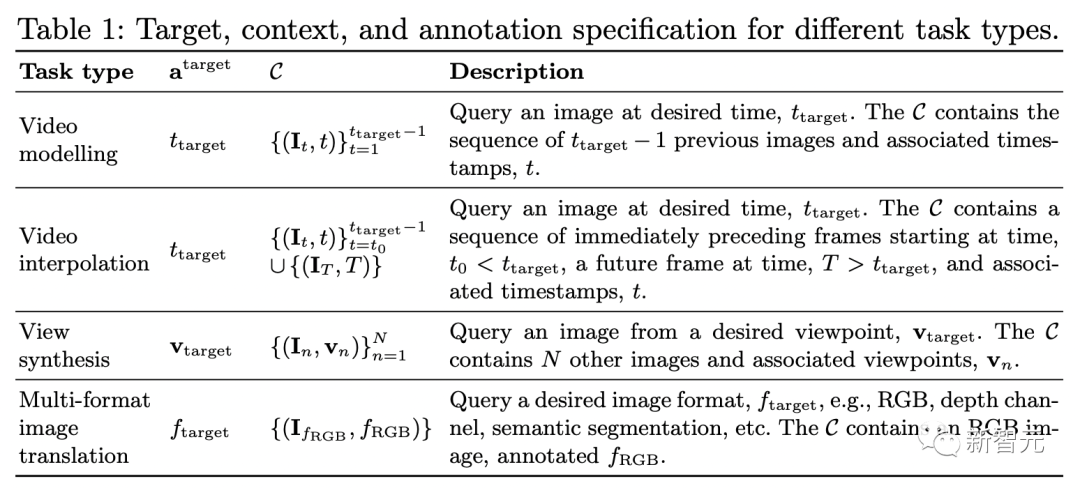

通過一系列數據集和任務的測試,結果顯示Transframer可以應用在多個廣泛任務上。

其中就包括視頻建模、新視圖合成、語義分割、對象識別、深度估計、光流預測等等。

視頻建模

通過Transframer在給定一系列輸入視頻幀的情況下預測下一幀。

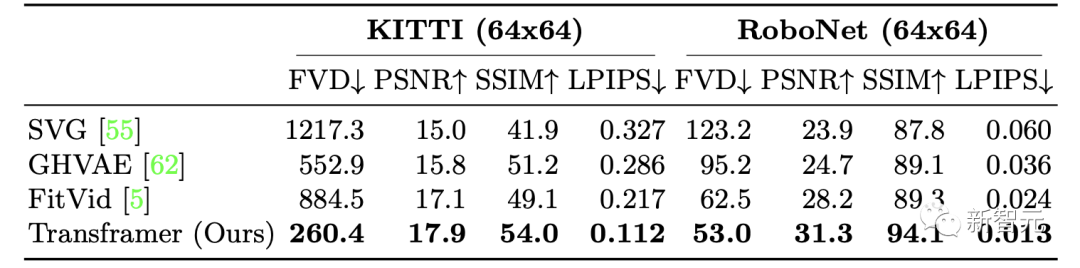

研究人員分別在KITTI和RoboNet兩個數據集上,訓練了Transframer在視頻生成上的性能如何。

對于KITTI,給定5個上下文幀和25采樣幀,結果顯示,Transframer模型在所有指標上的性能都有所提高,其中LPIPS和FVD的改進是最顯而易見的。

在RoboNet上,研究人員給定2個上下文幀和10個采樣幀,分別以64x64 和 128x128 的分辨率進行訓練,最終也取得了非常好的結果。

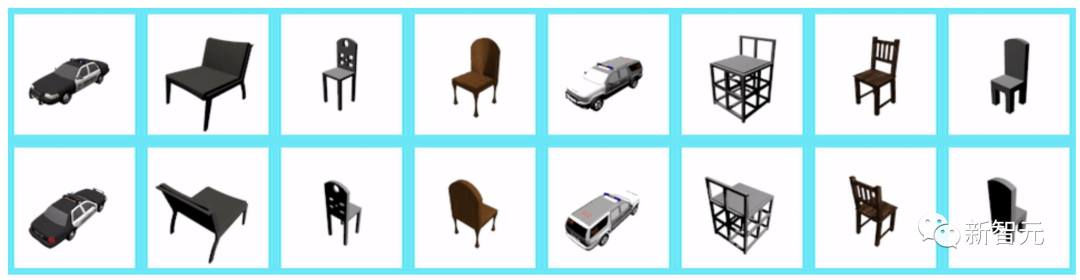

視圖合成

在視圖合成方面,研究者通過提供相機視圖作為表 1(第 3 行)中描述的上下文和目標注釋,以及 統一采樣多個上下文視圖,直到指定的最大值。

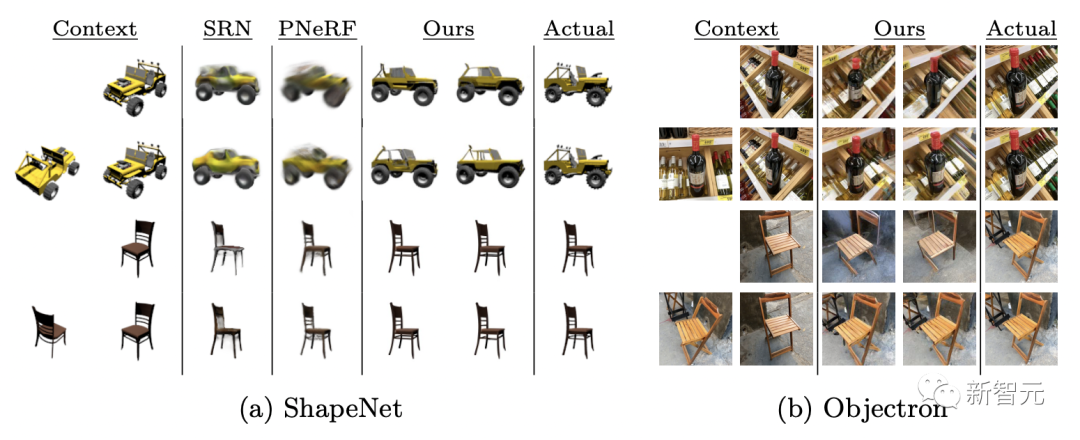

通過提供1-2個上下文視圖,在ShapeNet 基準上評估模型Transframer,明顯優于PixelNeRF和SRN。

此外在數據集Objectron進行評估后,可以看出當給定單個輸入視圖時,模型會產生連貫的輸出,但會遺漏一些特征,比如交叉的椅子腿。

當給出1個上下文視圖,以128×128分辨率合成的視圖如下:

當再給出2個上下文視圖,以128×128分辨率合成的視圖如下:

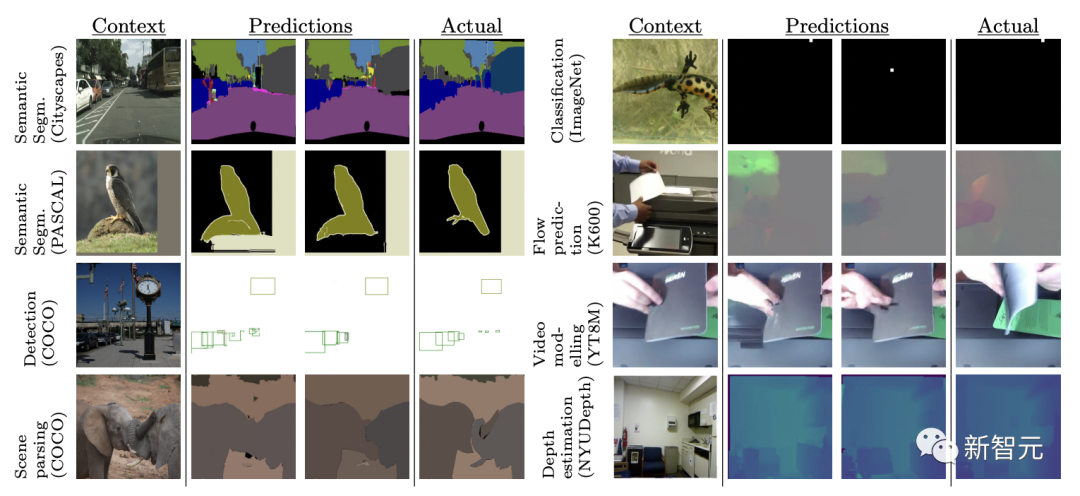

多視覺任務

不同的計算機視覺任務通常使用復雜的架構和損失函數來處理。

這里,研究人員在8個不同的任務和數據集上使用相同的損失函數聯合訓練了Transframer模型。

這8個任務分別是:單個圖像的光流預測、對象分類、檢測和分割、語義分割(在2個數據集上)、未來幀預測和深度估計。

結果顯示,Transframer學會在完全不同的任務中生成不同的樣本,在某些任務中,比如 Cityscapes,該模型產生了質量上好的輸出。

但是,在未來幀預測和邊界框檢測等任務上的模型輸出質量參差不齊,這表明在此設置中建模更具挑戰性。

?