ython 語言向來以豐富的第三方庫而聞名,今天來介紹幾個非常nice的庫,有趣好玩且強大!

數(shù)據(jù)采集

在當今互聯(lián)網(wǎng)時代,數(shù)據(jù)實在是太重要了,首先我們就來介紹幾個優(yōu)秀的數(shù)據(jù)采集項目

AKShare

AKShare 是基于 Python 的財經(jīng)數(shù)據(jù)接口庫,目的是實現(xiàn)對股票、期貨、期權(quán)、基金、外匯、債券、指數(shù)、加密貨幣等金融產(chǎn)品的基本面數(shù)據(jù)、實時和歷史行情數(shù)據(jù)、衍生數(shù)據(jù)從數(shù)據(jù)采集、數(shù)據(jù)清洗到數(shù)據(jù)落地的一套工具,主要用于學術(shù)研究目的。

import akshare as ak

stock_zh_a_hist_df = ak.stock_zh_a_hist(symbol="000001", period="daily", start_date="20170301", end_date='20210907', adjust="")

print(stock_zh_a_hist_df)

Output:

日期 開盤 收盤 最高 ... 振幅 漲跌幅 漲跌額 換手率

0 2017-03-01 9.49 9.49 9.55 ... 0.84 0.11 0.01 0.21

1 2017-03-02 9.51 9.43 9.54 ... 1.26 -0.63 -0.06 0.24

2 2017-03-03 9.41 9.40 9.43 ... 0.74 -0.32 -0.03 0.20

3 2017-03-06 9.40 9.45 9.46 ... 0.74 0.53 0.05 0.24

4 2017-03-07 9.44 9.45 9.46 ... 0.63 0.00 0.00 0.17

... ... ... ... ... ... ... ... ...

1100 2021-09-01 17.48 17.88 17.92 ... 5.11 0.45 0.08 1.19

1101 2021-09-02 18.00 18.40 18.78 ... 5.48 2.91 0.52 1.25

1102 2021-09-03 18.50 18.04 18.50 ... 4.35 -1.96 -0.36 0.72

1103 2021-09-06 17.93 18.45 18.60 ... 4.55 2.27 0.41 0.78

1104 2021-09-07 18.60 19.24 19.56 ... 6.56 4.28 0.79 0.84

[1105 rows x 11 columns]

https://github.com/akfamily/akshare

TuShare

TuShare 是實現(xiàn)對股票/期貨等金融數(shù)據(jù)從數(shù)據(jù)采集、清洗加工到數(shù)據(jù)存儲過程的工具,滿足金融量化分析師和學習數(shù)據(jù)分析的人在數(shù)據(jù)獲取方面的需求,它的特點是數(shù)據(jù)覆蓋范圍廣,接口調(diào)用簡單,響應(yīng)快速。

不過該項目有一部分功能是收費的,大家選擇使用哦

import tushare as ts

ts.get_hist_data('600848') #一次性獲取全部數(shù)據(jù)

Output:

open high close low volume p_change ma5 \

date

2012-01-11 6.880 7.380 7.060 6.880 14129.96 2.62 7.060

2012-01-12 7.050 7.100 6.980 6.900 7895.19 -1.13 7.020

2012-01-13 6.950 7.000 6.700 6.690 6611.87 -4.01 6.913

2012-01-16 6.680 6.750 6.510 6.480 2941.63 -2.84 6.813

2012-01-17 6.660 6.880 6.860 6.460 8642.57 5.38 6.822

2012-01-18 7.000 7.300 6.890 6.880 13075.40 0.44 6.788

2012-01-19 6.690 6.950 6.890 6.680 6117.32 0.00 6.770

2012-01-20 6.870 7.080 7.010 6.870 6813.09 1.74 6.832

ma10 ma20 v_ma5 v_ma10 v_ma20 turnover

date

2012-01-11 7.060 7.060 14129.96 14129.96 14129.96 0.48

2012-01-12 7.020 7.020 11012.58 11012.58 11012.58 0.27

2012-01-13 6.913 6.913 9545.67 9545.67 9545.67 0.23

2012-01-16 6.813 6.813 7894.66 7894.66 7894.66 0.10

2012-01-17 6.822 6.822 8044.24 8044.24 8044.24 0.30

2012-01-18 6.833 6.833 7833.33 8882.77 8882.77 0.45

2012-01-19 6.841 6.841 7477.76 8487.71 8487.71 0.21

2012-01-20 6.863 6.863 7518.00 8278.38 8278.38 0.23

https://github.com/waditu/tushare

GoPUP

GoPUP 項目所采集的數(shù)據(jù)皆來自公開的數(shù)據(jù)源,不涉及任何個人隱私數(shù)據(jù)和非公開數(shù)據(jù)。不過同樣的,部分接口是需要注冊 TOKEN 才能使用的。

import gopup as gp

df = gp.weibo_index(word="疫情", time_type="1hour")

print(df)

Output:

疫情

index

2022-12-17 18:15:00 18544

2022-12-17 18:20:00 14927

2022-12-17 18:25:00 13004

2022-12-17 18:30:00 13145

2022-12-17 18:35:00 13485

2022-12-17 18:40:00 14091

2022-12-17 18:45:00 14265

2022-12-17 18:50:00 14115

2022-12-17 18:55:00 15313

2022-12-17 19:00:00 14346

2022-12-17 19:05:00 14457

2022-12-17 19:10:00 13495

2022-12-17 19:15:00 14133

https://github.com/justinzm/gopup

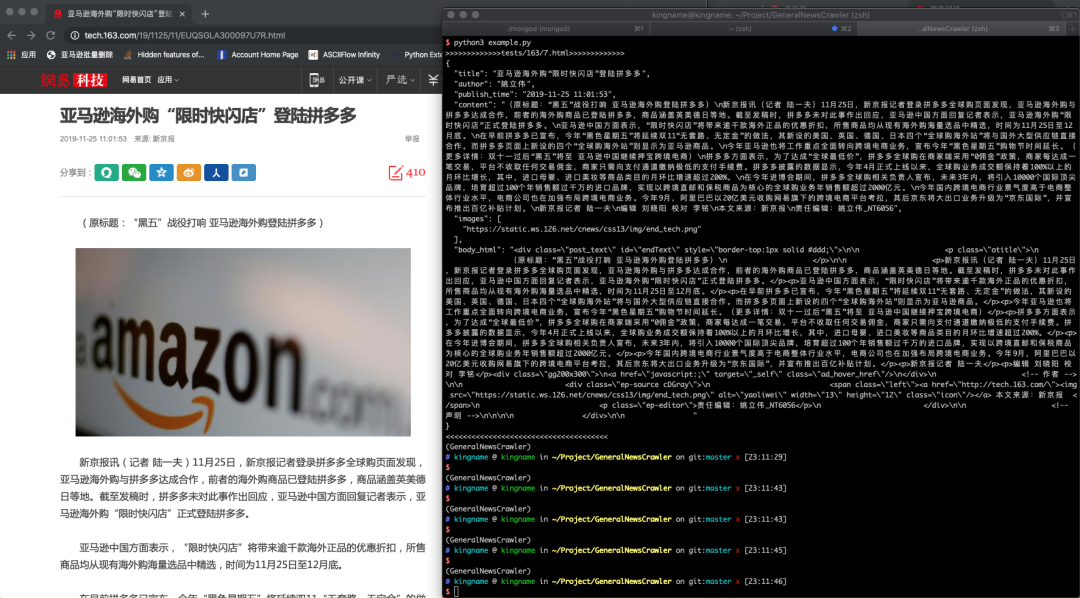

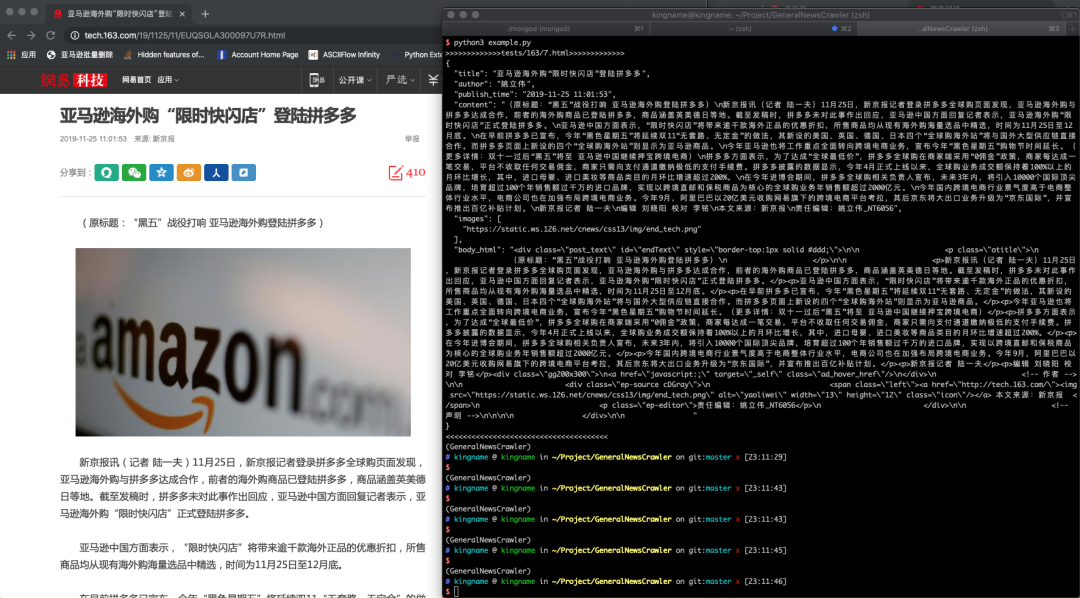

GeneralNewsExtractor

該項目基于《基于文本及符號密度的網(wǎng)頁正文提取方法》論文,使用 Python 實現(xiàn)的正文抽取器,可以用來提取 HTML 中正文的內(nèi)容、作者、標題。

>>> from gne import GeneralNewsExtractor

>>> html = '''經(jīng)過渲染的網(wǎng)頁 HTML 代碼'''

>>> extractor = GeneralNewsExtractor()

>>> result = extractor.extract(html, noise_node_list=['//div[@class="comment-list"]'])

>>> print(result)

Output:

{"title": "xxxx", "publish_time": "2019-09-10 11:12:13", "author": "yyy", "content": "zzzz", "images": ["/xxx.jpg", "/yyy.png"]}新聞頁提取示例

https://github.com/GeneralNewsExtractor/GeneralNewsExtractor

爬蟲

爬蟲也是 Python 語言的一大應(yīng)用方向,很多朋友也都是以爬蟲來入門的,我們來看看有哪些優(yōu)秀的爬蟲項目吧

playwright-python

微軟開源的瀏覽器自動化工具,可以用 Python 語言操作瀏覽器。支持 Linux、macOS、Windows 系統(tǒng)下的 Chromium、Firefox 和 WebKit 瀏覽器。

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

for browser_type in [p.chromium, p.firefox, p.webkit]:

browser = browser_type.launch()

page = browser.new_page()

page.goto('http://whatsmyuseragent.org/')

page.screenshot(path=f'example-{browser_type.name}.png')

browser.close()

https://github.com/microsoft/playwright-python

awesome-python-login-model

該項目收集了各大網(wǎng)站登陸方式和部分網(wǎng)站的爬蟲程序。登陸方式實現(xiàn)包含 selenium 登錄、通過抓包直接模擬登錄等。有助于新手研究、編寫爬蟲。

不過眾所周知,爬蟲是非常吃后期維護的,該項目已經(jīng)很久沒有更新了,所以各種登錄接口是否還能正常使用,還存在疑問,大家選擇使用,或者自行二次開發(fā)。

https://github.com/Kr1s77/awesome-python-login-model

DecryptLogin

相比于上一個,該項目則還在持續(xù)更新,同樣是模擬登錄各大網(wǎng)站,對于新手還是非常有研究價值的。

from DecryptLogin import login

# the instanced Login class object

lg = login.Login()

# use the provided api function to login in the target website (e.g., twitter)

infos_return, session = lg.twitter(username='Your Username', password='Your Password')

https://github.com/CharlesPikachu/DecryptLogin

Scylla

Scylla 是一款高質(zhì)量的免費代理 IP 池工具,當前僅支持 Python 3.6。

http://localhost:8899/api/v1/stats

Output:

{

"median": 181.2566407083,

"valid_count": 1780,

"total_count": 9528,

"mean": 174.3290085201

}https://github.com/scylladb/scylladb

ProxyPool

爬蟲代理IP池項目,主要功能為定時采集網(wǎng)上發(fā)布的免費代理驗證入庫,定時驗證入庫的代理保證代理的可用性,提供API和CLI兩種使用方式。同時也可以擴展代理源以增加代理池IP的質(zhì)量和數(shù)量。該項目設(shè)計文檔詳細、模塊結(jié)構(gòu)簡明易懂,同時適合爬蟲新手更好的學習爬蟲技術(shù)。

import requests

def get_proxy():

return requests.get("http://127.0.0.1:5010/get/").json()

def delete_proxy(proxy):

requests.get("http://127.0.0.1:5010/delete/?proxy={}".format(proxy))

# your spider code

def getHtml():

# ....

retry_count = 5

proxy = get_proxy().get("proxy")

while retry_count > 0:

try:

html = requests.get('http://www.example.com', proxies={"http": "http://{}".format(proxy)})

# 使用代理訪問

return html

except Exception:

retry_count -= 1

# 刪除代理池中代理

delete_proxy(proxy)

return None

https://github.com/Python3WebSpider/ProxyPool

getproxy

getproxy 是一個抓取發(fā)放代理網(wǎng)站,獲取 http/https 代理的程序,每 15 min 更新數(shù)據(jù)。

(test2.7) ? ~ getproxy

INFO:getproxy.getproxy:[*] Init

INFO:getproxy.getproxy:[*] Current Ip Address: 1.1.1.1

INFO:getproxy.getproxy:[*] Load input proxies

INFO:getproxy.getproxy:[*] Validate input proxies

INFO:getproxy.getproxy:[*] Load plugins

INFO:getproxy.getproxy:[*] Grab proxies

INFO:getproxy.getproxy:[*] Validate web proxies

INFO:getproxy.getproxy:[*] Check 6666 proxies, Got 666 valid proxies

...

https://github.com/fate0/getproxy

freeproxy

同樣是一個抓取免費代理的項目,該項目支持抓取的代理網(wǎng)站非常多,而且使用簡單。

from freeproxy import freeproxy

proxy_sources = ['proxylistplus', 'kuaidaili']

fp_client = freeproxy.FreeProxy(proxy_sources=proxy_sources)

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/98.0.4758.102 Safari/537.36'

}

response = fp_client.get('https://space.bilibili.com/406756145', headers=headers)

print(response.text)

https://github.com/CharlesPikachu/freeproxy

fake-useragent

偽裝瀏覽器身份,常用于爬蟲。這個項目的代碼很少,可以閱讀一下,看看ua.random是如何返回隨機的瀏覽器身份的。

from fake_useragent import UserAgent

ua = UserAgent()

ua.ie

# Mozilla/5.0 (Windows; U; MSIE 9.0; Windows NT 9.0; en-US);

ua.msie

# Mozilla/5.0 (compatible; MSIE 10.0; Macintosh; Intel Mac OS X 10_7_3; Trident/6.0)'

ua['Internet Explorer']

# Mozilla/5.0 (compatible; MSIE 8.0; Windows NT 6.1; Trident/4.0; GTB7.4; InfoPath.2; SV1; .NET CLR 3.3.69573; WOW64; en-US)

ua.opera

# Opera/9.80 (X11; Linux i686; U; ru) Presto/2.8.131 Version/11.11

ua.chrome

# Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.2 (KHTML, like Gecko) Chrome/22.0.1216.0 Safari/537.2'

ua.google

# Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_4) AppleWebKit/537.13 (KHTML, like Gecko) Chrome/24.0.1290.1 Safari/537.13

ua['google chrome']

# Mozilla/5.0 (X11; CrOS i686 2268.111.0) AppleWebKit/536.11 (KHTML, like Gecko) Chrome/20.0.1132.57 Safari/536.11

ua.firefox

# Mozilla/5.0 (Windows NT 6.2; Win64; x64; rv:16.0.1) Gecko/20121011 Firefox/16.0.1

ua.ff

# Mozilla/5.0 (X11; Ubuntu; Linux i686; rv:15.0) Gecko/20100101 Firefox/15.0.1

ua.safari

# Mozilla/5.0 (iPad; CPU OS 6_0 like Mac OS X) AppleWebKit/536.26 (KHTML, like Gecko) Version/6.0 Mobile/10A5355d Safari/8536.25

# and the best one, get a random browser user-agent string

ua.random

https://github.com/fake-useragent/fake-useragent

Web 相關(guān)

Python Web 有太多優(yōu)秀且老牌的庫了,比如 Django,F(xiàn)lask 就不說了,大家都知道,我們介紹幾個小眾但是好用的。

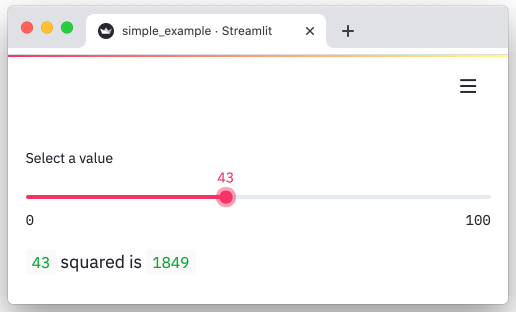

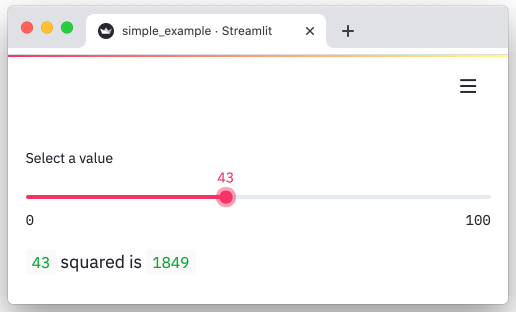

streamlit

streamlit 能夠快速地把數(shù)據(jù)制作成可視化、交互頁面的 Python 框架。分分鐘讓我們的數(shù)據(jù)變成圖表。

import streamlit as st

x = st.slider('Select a value')

st.write(x, 'squared is', x * x)

Output:

https://github.com/streamlit/streamlit

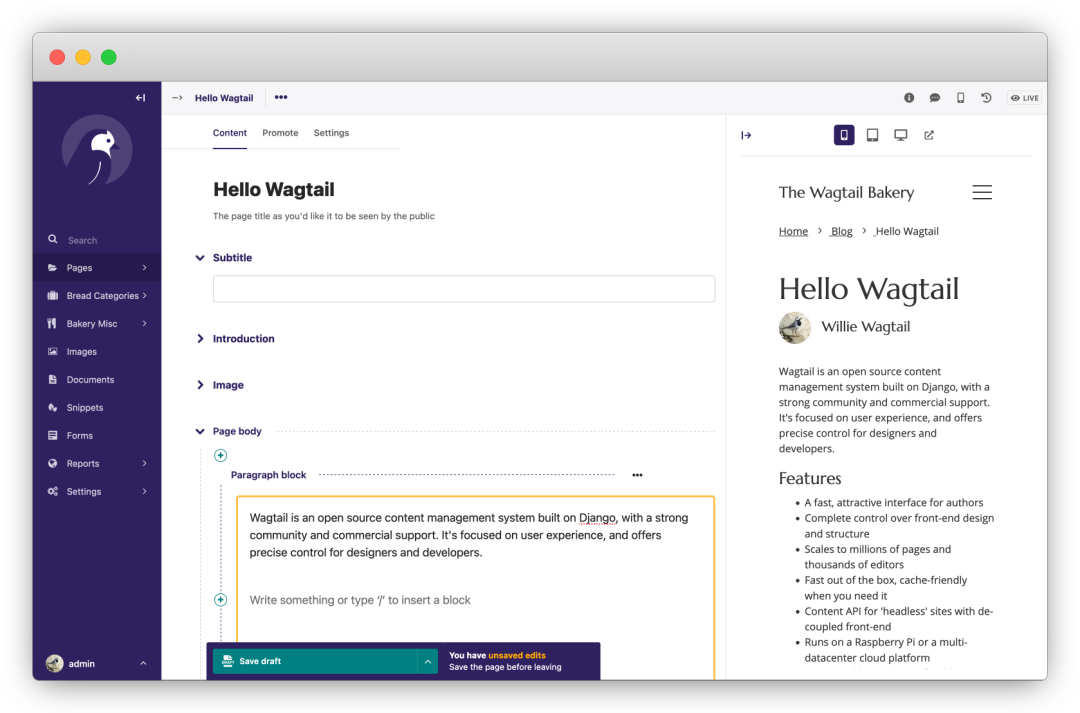

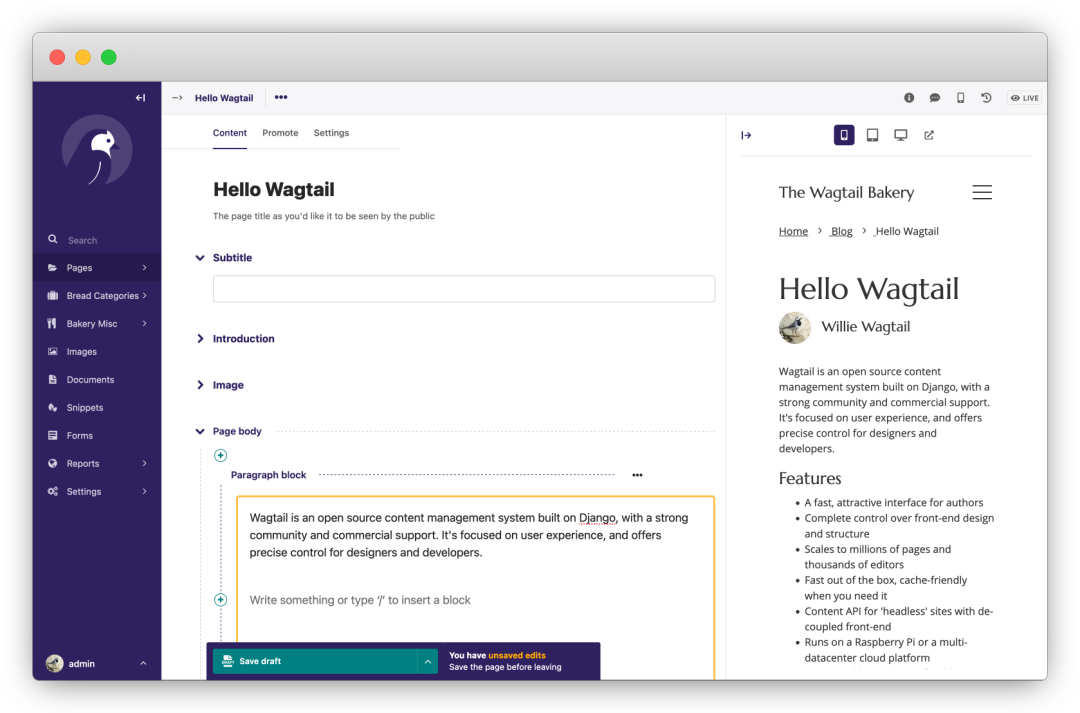

wagtail

是一個強大的開源 Django CMS(內(nèi)容管理系統(tǒng))。首先該項目更新、迭代活躍,其次項目首頁提到的功能都是免費的,沒有付費解鎖的騷操作。專注于內(nèi)容管理,不束縛前端實現(xiàn)。

https://github.com/wagtail/wagtail

fastapi

基于 Python 3.6+ 的高性能 Web 框架。“人如其名”用 FastAPI 寫接口那叫一個快、調(diào)試方便,Python 在進步而它基于這些進步,讓 Web 開發(fā)變得更快、更強。

from typing import Union

from fastapi import FastAPI

app = FastAPI()

@app.get("/")

def read_root():

return {"Hello": "World"}

@app.get("/items/{item_id}")

def read_item(item_id: int, q: Union[str, None] = None):

return {"item_id": item_id, "q": q}

https://github.com/tiangolo/fastapi

django-blog-tutorial

這是一個 Django 使用教程,該項目一步步帶我們使用 Django 從零開發(fā)一個個人博客系統(tǒng),在實踐的同時掌握 Django 的開發(fā)技巧。

https://github.com/jukanntenn/django-blog-tutorial

dash

dash 是一個專門為機器學習而來的 Web 框架,通過該框架可以快速搭建一個機器學習 APP。

https://github.com/plotly/dash

PyWebIO

同樣是一個非常優(yōu)秀的 Python Web 框架,在不需要編寫前端代碼的情況下就可以完成整個 Web 頁面的搭建,實在是方便。

https://github.com/pywebio/PyWebIO

Python 教程

practical-python

一個人氣超高的 Python 學習資源項目,是 MarkDown 格式的教程,非常友好。

https://github.com/dabeaz-course/practical-python

learn-python3

一個 Python3 的教程,該教程采用 Jupyter notebooks 形式,便于運行和閱讀。并且還包含了練習題,對新手友好。

https://github.com/jerry-git/learn-python3

python-guide

Requests 庫的作者——kennethreitz,寫的 Python 入門教程。不單單是語法層面的,涵蓋項目結(jié)構(gòu)、代碼風格,進階、工具等方方面面。一起在教程中領(lǐng)略大神的風采吧~

https://github.com/realpython/python-guide

其他

pytools

這是一位大神編寫的類似工具集的項目,里面包含了眾多有趣的小工具。

截圖只是冰山一角,全貌需要大家自行探索了

import random

from pytools import pytools

tool_client = pytools.pytools()

all_supports = tool_client.getallsupported()

tool_client.execute(random.choice(list(all_supports.values())))

https://github.com/CharlesPikachu/pytools

amazing-qr

可以生成動態(tài)、彩色、各式各樣的二維碼,真是個有趣的庫。

#3 -n, -d

amzqr https://github.com -n github_qr.jpg -d .../paths/

https://github.com/x-hw/amazing-qr

sh

sh 是一個成熟的,用于替代 subprocess 的庫,它允許我們調(diào)用任何程序,看起來它就是一個函數(shù)一樣。

$> ./run.sh FunctionalTests.test_unicode_arg

https://github.com/amoffat/sh

tqdm

強大、快速、易擴展的 Python 進度條庫。

from tqdm import tqdm

for i in tqdm(range(10000)):

...

https://github.com/tqdm/tqdm

loguru

一個讓 Python 記錄日志變得簡單的庫。

from loguru import logger

logger.debug("That's it, beautiful and simple logging!")

https://github.com/Delgan/loguru

click

Python 的第三方庫,用于快速創(chuàng)建命令行。支持裝飾器方式調(diào)用、多種參數(shù)類型、自動生成幫助信息等。

import click

@click.command()

@click.option("--count", default=1, help="Number of greetings.")

@click.option("--name", prompt="Your name", help="The person to greet.")

def hello(count, name):

"""Simple program that greets NAME for a total of COUNT times."""

for _ in range(count):

click.echo(f"Hello, {name}!")

if __name__ == '__main__':

hello()

Output:

$ python hello.py --count=3

Your name: Click

Hello, Click!

Hello, Click!

Hello, Click!

KeymouseGo

Python 實現(xiàn)的精簡綠色版按鍵精靈,記錄用戶的鼠標、鍵盤操作,自動執(zhí)行之前記錄的操作,可設(shè)定執(zhí)行的次數(shù)。在進行某些簡單、單調(diào)重復(fù)的操作時,使用該軟件可以十分省事兒。只需要錄制一遍,剩下的交給 KeymouseGo 來做就可以了。

https://github.com/taojy123/KeymouseGo