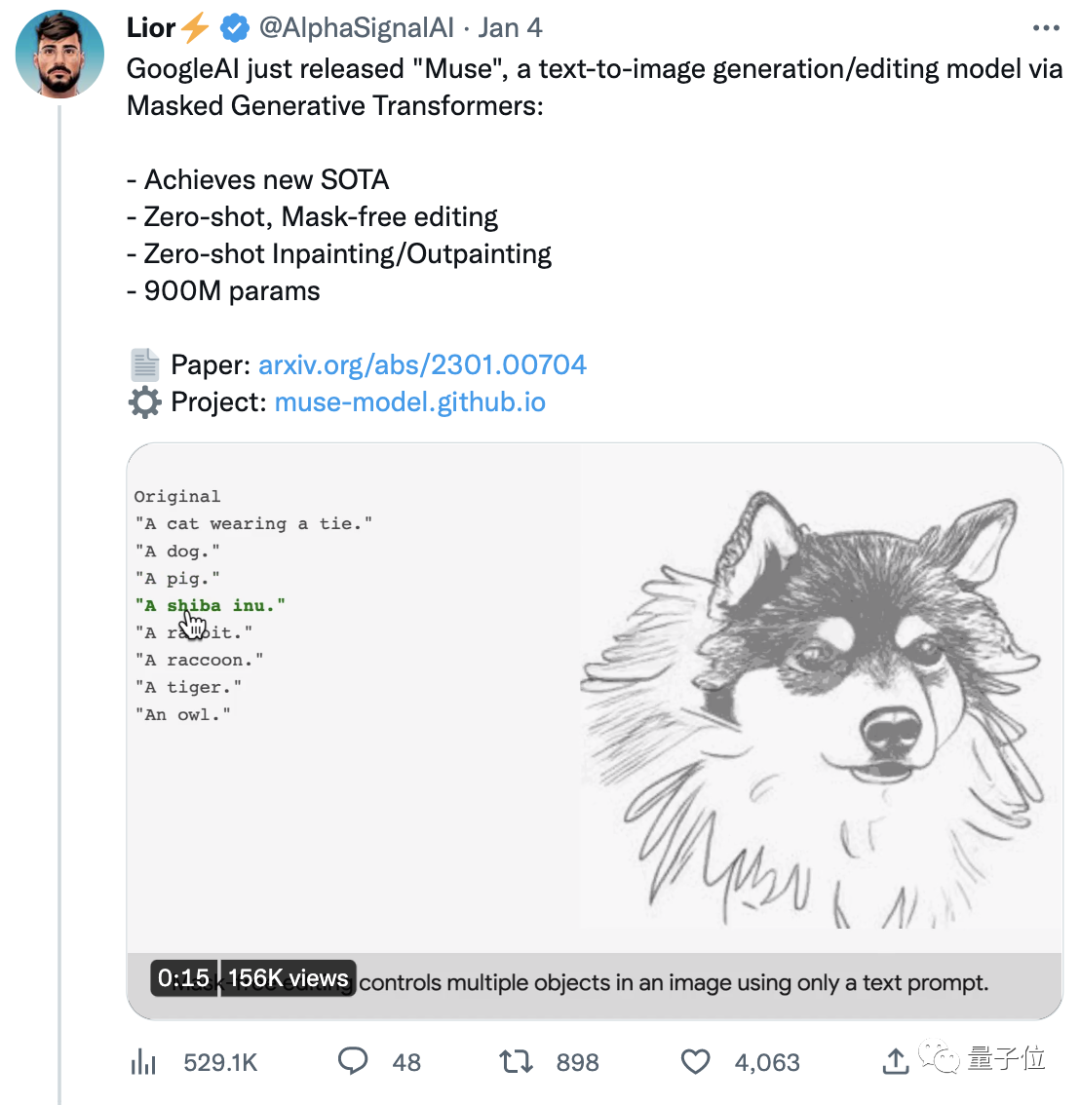

效率碾壓DALL·E 2和Imagen,谷歌新模型達成新SOTA,還能一句話搞定PS

新年伊始,谷歌AI又開始發力文字-圖像生成模型了。

這次,他們的新模型Muse(繆斯)在CC3M數據集上達成了新SOTA(目前最佳水平)。

而且其效率遠超火爆全球的DALL·E 2和Imagen (這倆都屬于擴散模型),以及Parti (屬于自回歸模型)。

——單張512x512分辨率圖像的生成時間被壓縮到僅1.3秒。

在圖像編輯方面,只需一句文字指令,就可以對原始圖像進行編輯。

(貌似不用再為學ps頭禿了~)

如果想要效果更精準,還能選定遮罩位置,編輯特定區域。比如,把背景的建筑換成熱氣球。

Muse一經官宣,很快吸引了大波關注,目前原貼已收獲4000+點贊。

看到谷歌的又一力作,有人甚至已經開始預言:

現在AI開發者的競爭非常激烈,看來2023將是非常精彩的一年。

比DALL·E 2和Imagen更高效

說回谷歌剛剛公開的Muse。

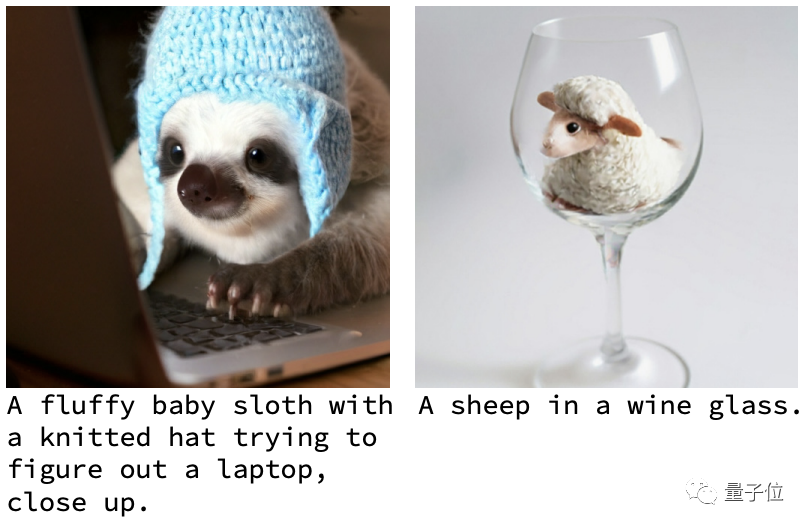

首先,就生成圖片的質量來說,Muse的作品大都畫質清晰、效果自然。

來看看更多例子感受一下~

比如戴著毛線帽的樹懶寶寶正在操作電腦;再比如酒杯中的一只羊:

平時八竿子打不著的各種主體,在一張圖里和諧共存,沒啥違和感。

要是你覺得這些還只能算AIGC的基操,那不妨再看看Muse的編輯功能。

比如一鍵換裝(還能換性別):

這既不需要加什么遮罩,還能一句話搞定。

而如果用上遮罩的話,就能實現更6的操作,包括一鍵切換背景,從原地切換到紐約、巴黎、再到舊金山。

還能從海邊到倫敦、到花海,甚至飛到太空中的土星環上,玩一把刺激的滑板海豚跳。

(好家伙,不僅能輕松云旅游,還能一鍵上天......)

效果著實挺出色。那Muse背后都有哪些技術支持?為什么效率比DALL·E 2和Imagen更高?

一個重要的原因是,DALL·E 2和Imagen在訓練過程中,需要將所有學到的知識都存儲在模型參數中。

于是,它們不得不需要越來越大的模型、越來越多的訓練數據來獲取更多知識——將Better和Bigger綁在了一起。

代價就是參數量巨大,效率也受到了影響。

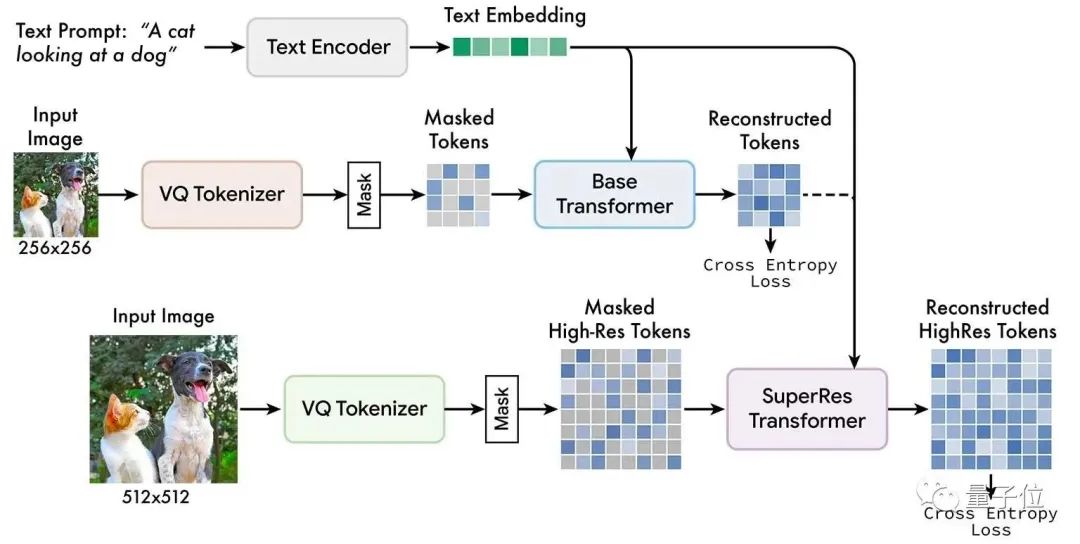

而據谷歌AI團隊介紹,他們采用的主要方法名曰:掩碼圖像建模 (Masked image modeling)。

這是一種新興的自監督預訓練方法,其基本思想簡單來說就是:

輸入圖像的一部分被隨機屏蔽掉,然后通過預訓練文本任務進行重建。

Muse模型在離散標記的空間掩碼上訓練,并結合從預訓練語言大模型中提取的文本,預測隨機遮蔽的圖像標記。

從上到下依次為:預訓練的文本編碼器、基礎模型、超分辨率模型

谷歌團隊發現,使用預先訓練好的大語言模型,可以讓AI對語言的理解更加細致透徹。

就輸出而言,由于AI對物體的空間關系、姿態等要素把握得很不錯,所以生成的圖像可以做到高保真。

與DALL·E 2、Imagen等像素空間的擴散模型相比,Muse用的是離散的token,并且采樣迭代較少。

另外,和Parti等自回歸模型相比,Muse使用了并行解碼,效率也更高。

FID上獲SOTA得分

前文提到,Muse不僅在效率上取得了提升,在生成圖像質量上也非常優秀。

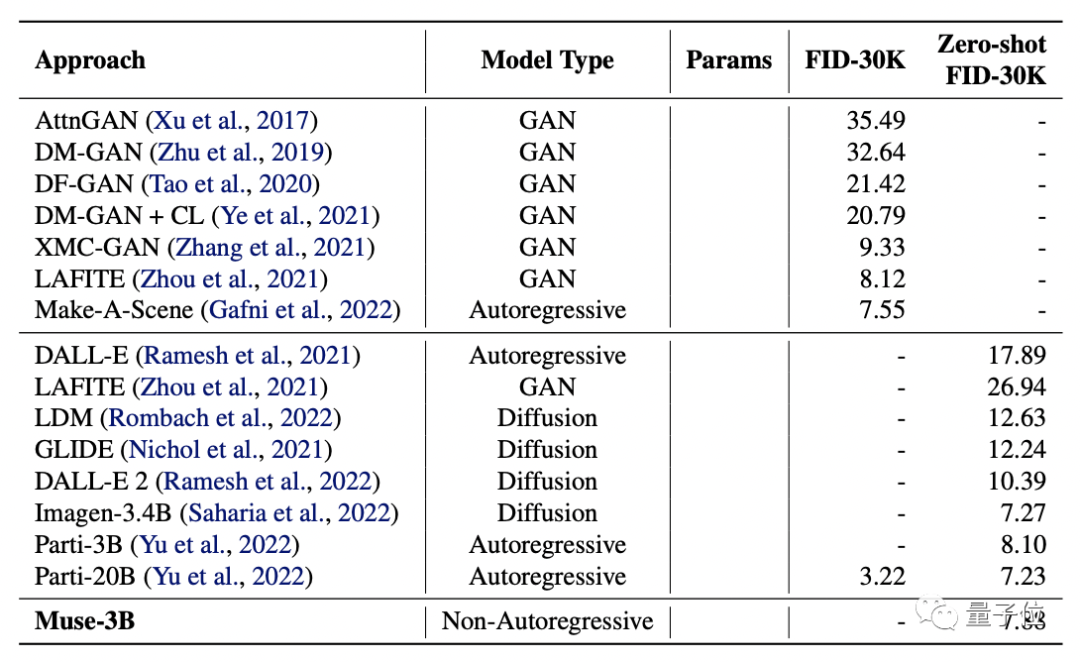

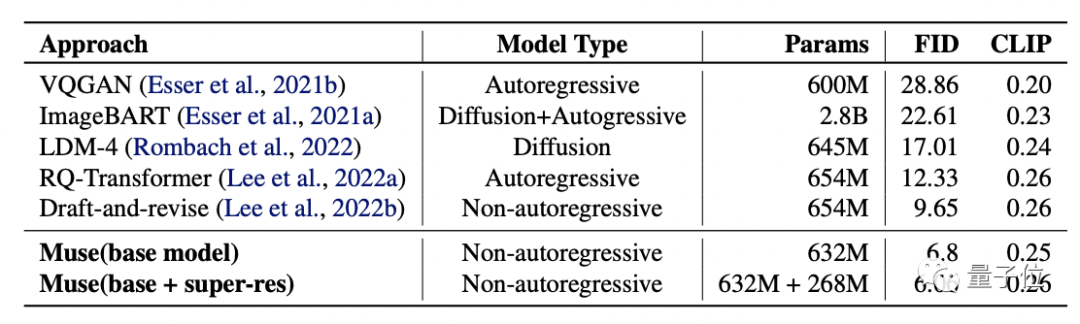

研究者把它與DALL·E、LAFITE、LDM、GLIDE、DALL·E 2,以及谷歌自家的Imagen和Parti進行PK,測試了它們的FID和CLIP分數。

(FID分數用于評估生成圖像的質量,分數越低質量越高;CLIP分數則代表文本與圖像的契合程度,分數越高越好。)

結果顯示,Muse-3B模型在COCO驗證集中的zero-shot FID-30K得分為7.88,僅次于參數更大的Imagen-3.4B和Parti-20B模型。

更優秀的是,Muse-900M模型在CC3M數據集上實現了新的SOTA,FID得分為6.06,這也意味著它與文字的匹配度是最高的。

同時,該模型的CLIP分數為0.26,也達到了同期最高水平。

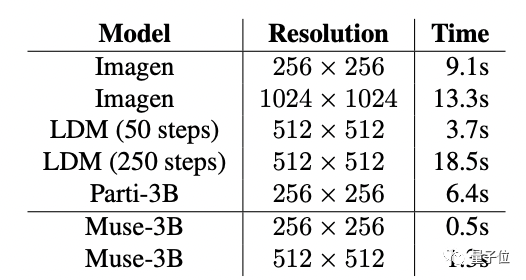

除此之外,為了進一步證實Muse的出圖效率,研究者還對比了Muse與其他模型的單張圖像生成時間:

在256x256、512x512的分辨率上Muse均達到了最快速度:0.5s和1.3s。

研究團隊

Muse的研究團隊來自谷歌,兩位共同一作分別是Huiwen Chang和Han Zhang。

Huiwen Chang,現為谷歌高級研究員。

她本科就讀于清華大學,博士畢業于普林斯頓大學,有過在Adobe、Facebook等的實習經歷。

Han Zhang,本科畢業于中國農業大學,碩士就讀于北京郵電大學,后在羅格斯大學取得了計算機科學博士學位。

其研究方向是計算機視覺,深度學習和醫學圖像分析等。

不過值得一提的是,目前Muse還沒有正式發布。

有網友調侃,雖然它應該很香,但以谷歌的“尿性”,Muse離正式發布可能還有很長時間——畢竟他們還有18年的AI都沒發呢。

話說回來,你覺得Muse的效果怎么樣?

對于其正式發布之事,有木有一點期待?

傳送門:??https://muse-model.github.io/??

參考鏈接:https://twitter.com/AlphaSignalAI/status/1610404589966180360?