使用 eBPF 技術實現更快的網絡數據包傳輸

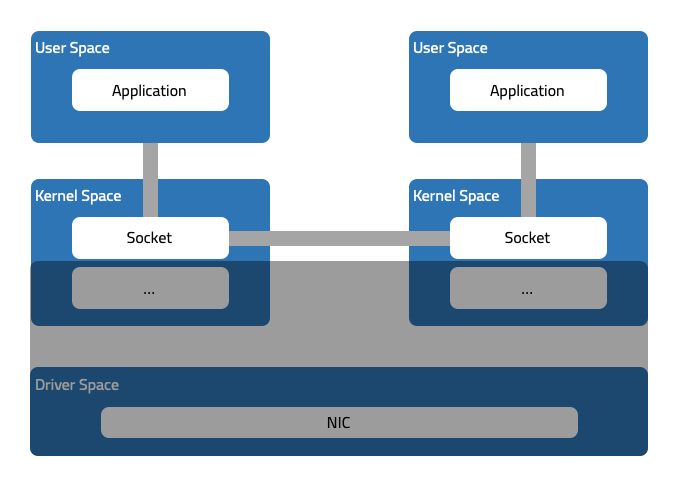

在 上篇文章 用了整篇的內容來描述網絡數據包在 Kubernetes 網絡中的軌跡,文章末尾,我們提出了一種假設:同一個內核空間中的兩個 socket 可以直接傳輸數據,是不是就可以省掉內核網絡協議棧處理帶來的延遲?

不論是同 pod 中的兩個不同容器,或者同節點的兩個 pod 間的網絡通信,實際上都發生在同一個內核空間中,互為對端的兩個 socket 也都位于同一個內存中。而在上篇文章的開頭也總結了數據包的傳輸軌跡實際上是 socket 的尋址過程,可以進一步將問題展開:同一節點上的兩個 socket 間的通信,如果可以 快速定位到對端的 socket -- 找到其在內存中的地址,我們就可以省掉網絡協議棧處理帶來的延遲。

互為對端的兩個 socket 也就是建立起連接的客戶端 socket 和服務端 socket,他們可以通過 IP 地址和端口進行關聯。客戶端 socket 的本地地址和端口,是服務端 socket 的遠端地址和端口;客戶端 socket 的遠端地址和端口,則是服務端 socket 的本地地址和端口。

當客戶端和服務端的完成連接的建立之后,如果可以使用本地地址 + 端口和遠端地址 + 端口端口的組合 指向socket 的話,僅需調換本地和遠端的地址 + 端口,即可定位到對端的 socket,然后將數據直接寫到對端 socket(實際是寫入 socket 的接收隊列 RXQ,這里不做展開),就可以避開內核網絡棧(包括 netfilter/iptables)以及 NIC 的處理。

如何實現?看標題應該也猜出來了,這里借助 eBPF 技術。

eBPF 是什么?

Linux 內核一直是實現監控/可觀測性、網絡和安全功能的理想地方。不過很多情況下這并非易事,因為這些工作需要修改內核源碼或加載內核模塊, 最終實現形式是在已有的層層抽象之上疊加新的抽象。eBPF 是一項革命性技術,它能在內核中運行沙箱程序(sandbox programs), 而無需修改內核源碼或者加載內核模塊。

將 Linux 內核變成可編程之后,就能基于現有的(而非增加新的)抽象層來打造更加智能、 功能更加豐富的基礎設施軟件,而不會增加系統的復雜度,也不會犧牲執行效率和安全性。

應用場景

下面截取了 eBPF.io[1] 網站的介紹。

在 網絡 方面,在不離開內核空間的情況下使用 eBPF 可以加快數據包處理速度。添加額外的協議解析器并輕松編寫任何轉發邏輯以滿足不斷變化的需求。

在 可觀測性 方面,使用 eBPF 可以自定義指標的收集和內核聚合,以及從眾多來源生成可見性事件和數據結構,而無需導出樣本。

在 鏈路跟蹤與分析 方面,將 eBPF 程序附加到跟蹤點以及內核和用戶應用程序探測點,可以提供強大的檢查能力和獨特的洞察力來解決系統性能問題。

在 安全 方面,將查看和理解所有系統調用與所有網絡的數據包和套接字級別視圖相結合,來創建在更多上下文中運行并具有更好控制級別的安全系統。

事件驅動

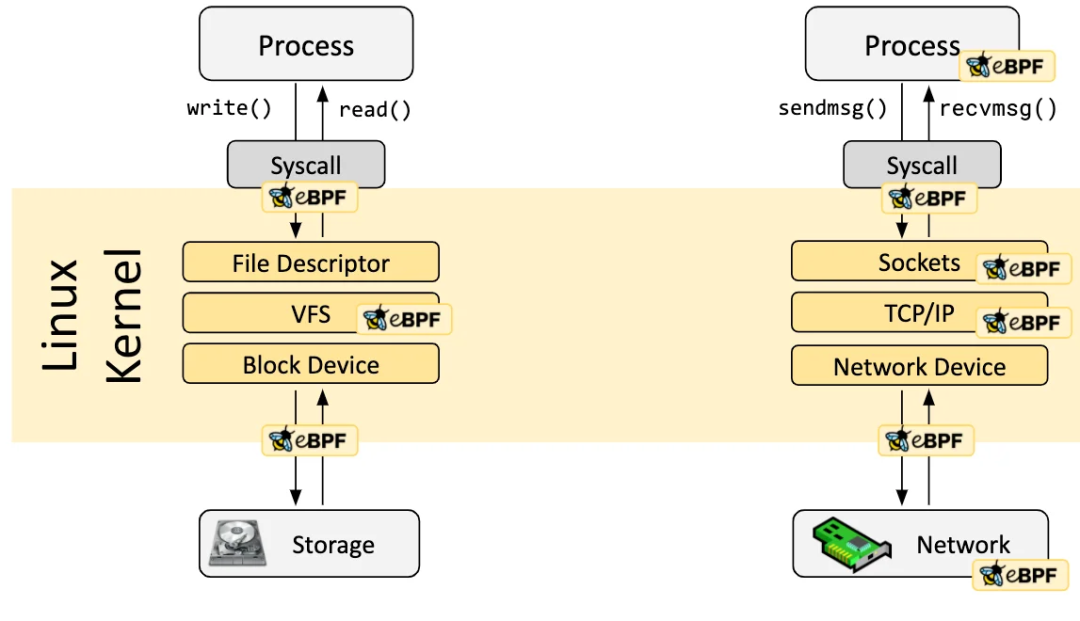

eBPF 程序是事件驅動的,當內核或應用程序通過某個 hook(鉤子) 點時運行。預定義的鉤子類型包括系統調用、函數進入/退出、內核跟蹤點、網絡事件等。

Linux 的內核在系統調用和網絡棧上提供了一組 BPF 鉤子,通過這些鉤子可以觸發 BPF 程序的執行,下面就介紹常見的幾種鉤子。

- XDP:這是網絡驅動中接收網絡包時就可以觸發 BPF 程序的鉤子,也是最早的點。由于此時還沒有進入內核網絡協議棧,也未執行高成本的操作,比如為網絡包分配 `sk_buff`[2],所以它非常適合運行刪除惡意或意外流量的過濾程序,以及其他常見的 DDOS 保護機制。

- Traffic Control Ingress/Egress:附加到流量控制(traffic control,簡稱 tc)ingress 鉤子上的 BPF 程序,可以被附加到網絡接口上。這種鉤子在網絡棧的 L3 之前執行,并可以訪問網絡包的大部分元數據。可以處理同節點的操作,比如應用 L3/L4 的端點策略、轉發流量到端點。CNI 通常使用虛擬機以太接口對 veth將容器連接到主機的網絡命名空間。使用附加到主機端 veth 的 tc ingress 鉤子,可以監控離開容器的所有流量(當然也可以附加到容器的 eth0 接口上)。也可以用于處理跨節點的操作。同時將另一個 BPF 程序附加到 tc egress 鉤子,Cilium 可以監控所有進出節點的流量并執行策略。

上面兩種屬于網絡事件類型的鉤子,下面介紹同樣是網絡相關的,套接字的系統調用。

- Socket operations:套接字操作鉤子附加到特定的 cgroup 并在套接字的操作上運行。比如將 BPF 套接字操作程序附加到 cgroup/sock_ops,使用它來監控 socket 的狀態變化(從 `bpf_sock_ops`[3] 獲取信息),特別是 ESTABLISHED 狀態。當套接字狀態變為 ESTABLISHED 時,如果 TCP 套接字的對端也在當前節點(也可能是本地代理),然后進行信息的存儲。或者將程序附加到 cgroup/connect4 操作,可以在使用 ipv4 地址初始化連接時執行程序,對地址和端口進行修改。

- Socket send:這個鉤子在套接字執行的每個發送操作上運行。此時鉤子可以檢查消息并丟棄消息、將消息發送到內核網絡協議棧,或者將消息重定向到另一個套接字。這里,我們可以使用其完成 socket 的快速尋址。

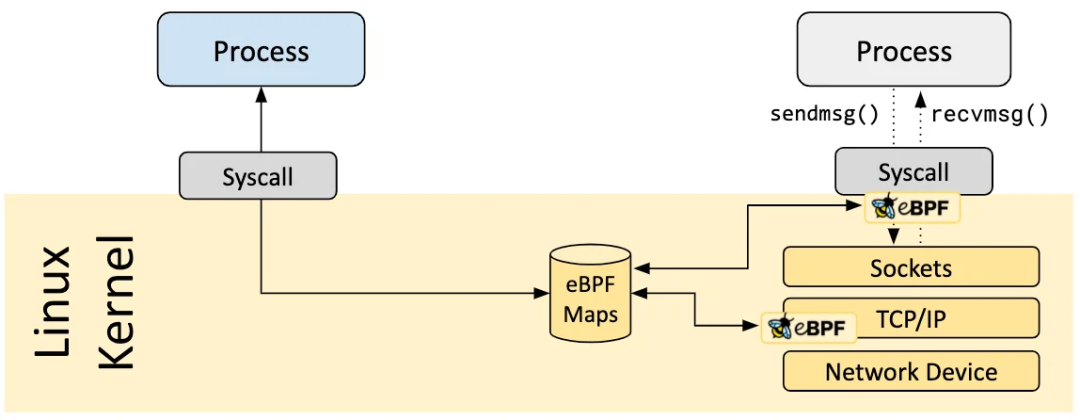

Map

eBPF 程序的一個重要方面是共享收集的信息和存儲狀態的能力。為此,eBPF 程序可以利用 eBPF Map 的概念存儲和檢索數據。eBPF Map 可以從 eBPF 程序訪問,也可以通過系統調用從用戶空間中的應用程序訪問。

Map 有多種類型:哈希表、數組、LRU(最近最少使用)哈希表、環形緩沖區、堆棧調用跟蹤等等。

比如上面附加到 socket 套接字上用來在每次發送消息時執行的程序,實際上是附加在 socket 哈希表上,socket 就是鍵值對中的值。

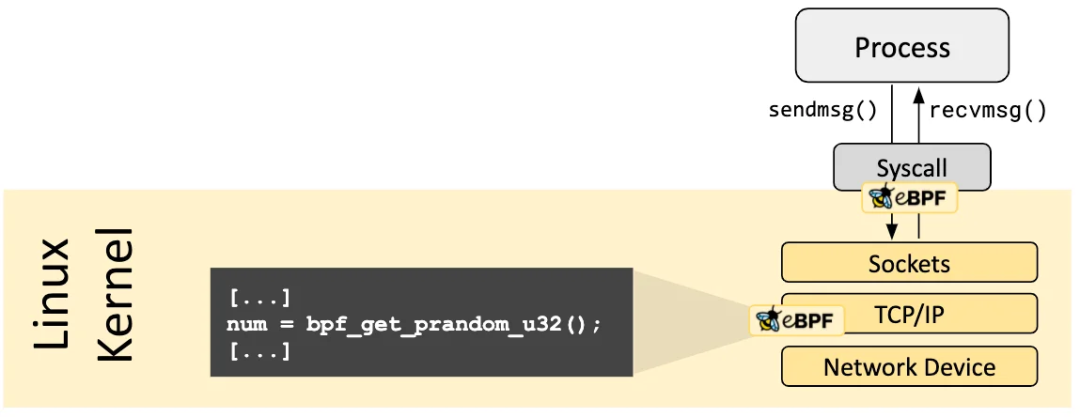

輔助函數

eBPF 程序不能調用任意內核函數。如果這樣做會將 eBPF 程序綁定到特定的內核版本,并會使程序的兼容性復雜化。相反,eBPF 程序可以對輔助函數進行函數調用,輔助函數是內核提供的眾所周知且穩定的 API。

這些 輔助函數[4] 提供了不同的功能:

- 生成隨機數

- 獲取當前時間和日期

- 訪問 eBPF Map

- 獲取進程/cgroup 上下文

- 操縱網絡數據包和轉發邏輯

實現

講完 eBPF 的內容,對實現應該會有一個大概的思路了。這里我們需要兩個 eBPF 程序分別維護 socket map 和將消息直通對端的 socket。這里感謝 Idan Zach 的示例代碼 ebpf-sockops[5],我將代碼做了 簡單的修改[6],讓可讀性更好一點。

原來代碼用使用了 16777343 表示地址 127.0.0.1?,4135 表示端口 10000,二者是網絡 字節序列轉換后的值。

socket map 維護:sockops

附加到 sock_ops? 的程序:監控 socket 狀態,當狀態為 BPF_SOCK_OPS_PASSIVE_ESTABLISHED_CB? 或者 BPF_SOCK_OPS_ACTIVE_ESTABLISHED_CB? 時,使用輔助函數 bpf_sock_hash_update?[^1] 將 socket 作為 value 保存到 socket map 中,key

消息直通:sk_msg

附加到 socket map 的程序:在每次發送消息時觸發該程序,使用當前 socket 的遠端地址 + 端口和本地地址 + 端口作為 key 從 map 中定位對端的 socket。如果定位成功,說明客戶端和服務端位于同一節點上,使用輔助函數 bpf_msg_redirect_hash[^2] 將數據直接寫入到對端 socket。

這里沒有直接使用 bpf_msg_redirect_hash?,而是通過自定義的 msg_redirect_hash 來訪問。因為前者無法直接訪問,否則校驗會不通過。

測試

環境

- Ubuntu 20.04

- Kernel 5.15.0-1034

安裝依賴。

克隆代碼。

編譯并加載 BPF 程序。

安裝 iperf3。

啟動 iperf3 服務端。

運行 iperf3 客戶端。

運行 trace.sh 腳本查看打印的日志,可以看到 4 條日志:創建了 2 個連接。

如何確定跳過了內核網絡棧了,使用 tcpdump 抓包看一下。從抓包的結果來看,只有握手和揮手的流量,后續消息的發送完全跳過了內核網絡棧。

總結

通過 eBPF 的引入,我們縮短了同節點通信數據包的 datapath,跳過了內核網絡棧直接連接兩個對端的 socket。

這種設計適用于同 pod 兩個應用的通信以及同節點上兩個 pod 的通信。

[^1]: 該輔助函數將引用的 socket 添加或者更新到 sockethash map 中,程序的輸入 bpf_sock_ops? 作為鍵值對的值。詳細信息可參考 https://man7.org/linux/man-pages/man7/bpf-helpers.7.html 中的 bpf_sock_hash_update。

[^2]: 該輔助函數將 msg 轉發到 socket map 中 key

參考資料

[1] eBPF.io: https://ebpf.io

[2] sk_buff?: https://atbug.com/tracing-network-packets-in-kubernetes/#sk_buff

[3] bpf_sock_ops?: https://elixir.bootlin.com/linux/latest/source/include/uapi/linux/bpf.h#L6377

[4] 輔助函數: https://man7.org/linux/man-pages/man7/bpf-helpers.7.html

[5] Idan Zach 的示例代碼 ebpf-sockops: https://github.com/zachidan/ebpf-sockops

[6] 簡單的修改: https://github.com/zachidan/ebpf-sockops/pull/3/commits/be09ac4fffa64f4a74afa630ba608fd09c10fe2a