vivo全球商城:電商交易平臺設計

一、背景

vivo官方商城經過了七年的迭代,從單體架構逐步演進到微服務架構,我們的開發團隊沉淀了許多寶貴的技術與經驗,對電商領域業務也有相當深刻的理解。

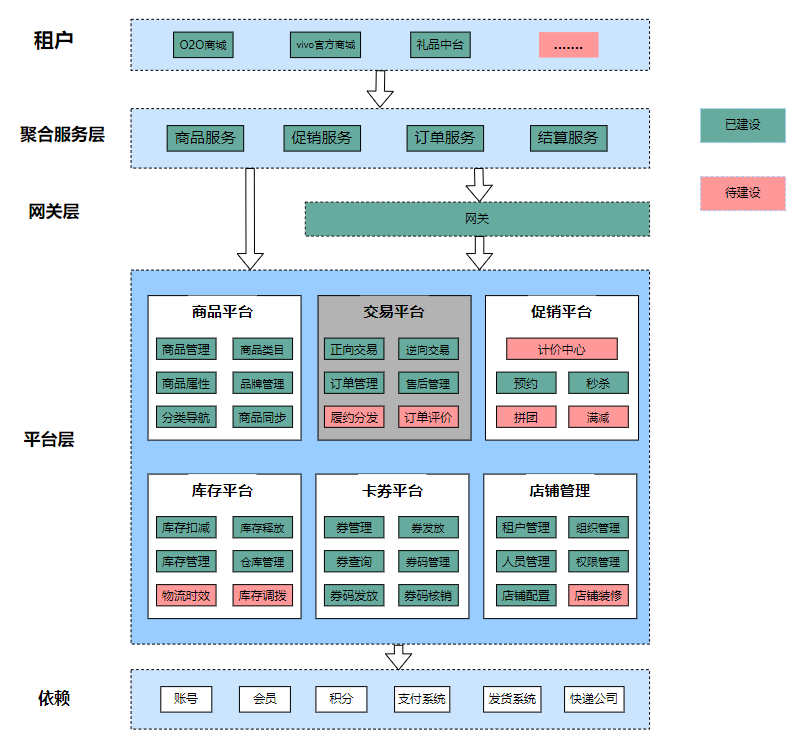

去年初,團隊承接了O2O商城的建設任務,還有即將成立的禮品中臺,以及官方商城的線上購買線下門店送貨需求,都需要搭建底層的商品、交易和庫存能力。

為節約研發與運維成本,避免重復造輪子,我們決定采用平臺化的思想來搭建底層系統,以通用能力靈活支撐上層業務的個性化需求。

包括交易平臺、商品平臺、庫存平臺、營銷平臺在內的一整套電商平臺化系統應運而生

本文將介紹交易平臺的架構設計理念與實踐,以及上線后持續迭代過程中的挑戰與思考。

二、整體架構

2.1 架構目標

除了高并發、高性能、高可用這三高外,還希望做到:

- 低成本

注重模型與服務的可重用性,靈活支撐各業務的個性化需求,提高開發效率,降低人力成本。 - 高擴展

系統架構簡單清晰,應用系統間耦合低,容易水平擴展,業務功能增改方便快捷。

2.2 系統架構

(1)電商平臺整體架構中的交易平臺

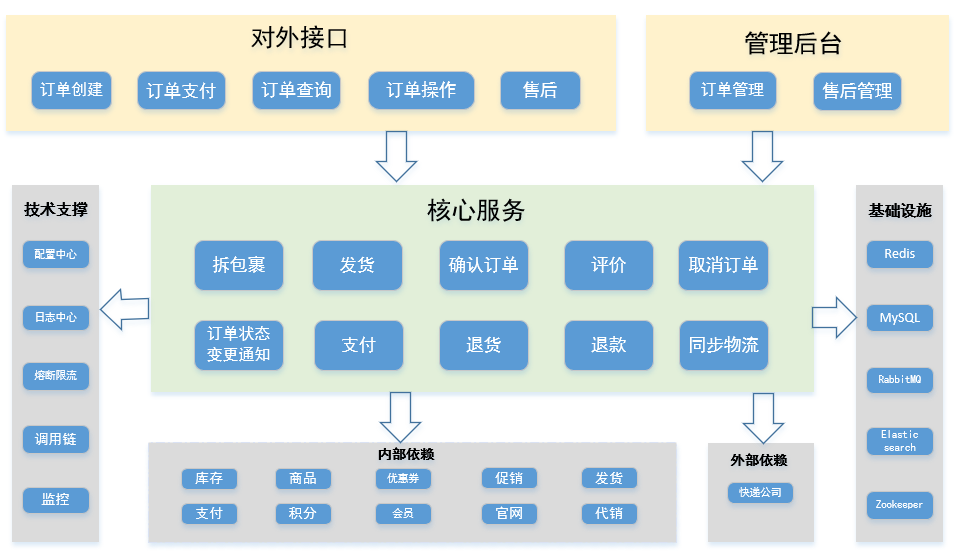

(2)交易平臺系統架構

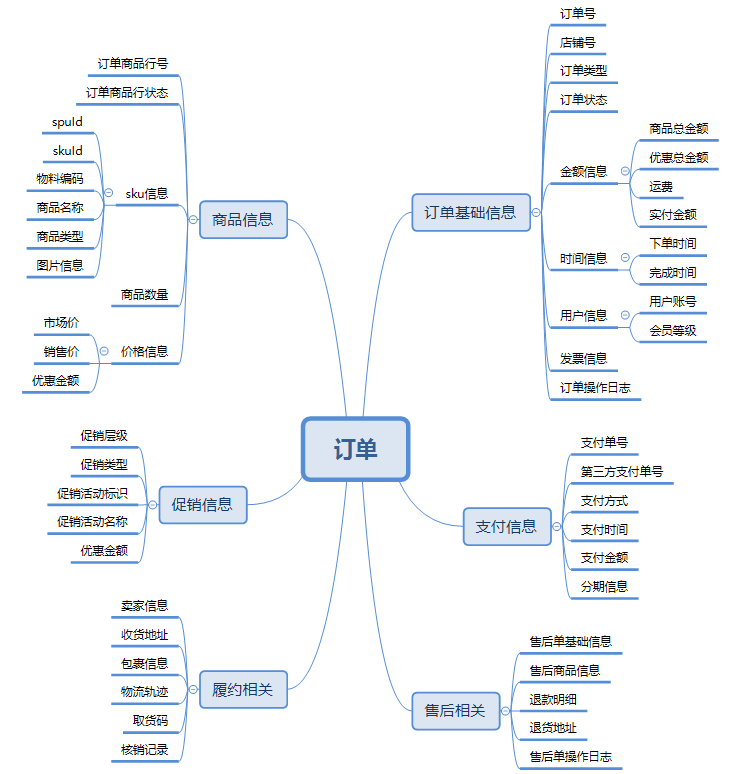

2.3 數據模型

三、關鍵方案設計

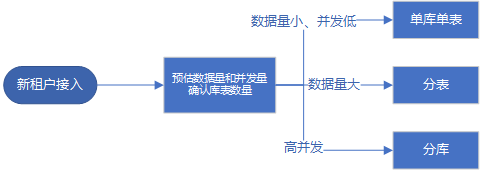

3.1 多租戶設計

(1)背景和目標

- 交易平臺面向多個租戶(業務方),需要能夠存儲大量訂單數據,并提供高可用高性能的服務。

- 不同租戶的數據量和并發量可能有很大區別,要能根據實際情況靈活分配存儲資源。

(2)設計方案

- 考慮到交易系統OLTP特性和開發人員熟練程度,采用MySQL作為底層存儲、ShardingSphere作為分庫分表中間件,將用戶標識(userId)作為分片鍵,保證同一個用戶的訂單落在同一個庫中。

- 接入新租戶時約定一個租戶編碼(tenantCode),所有接口都要帶上這個參數;租戶對數據量和并發量進行評估,分配至少滿足未來五年需求的庫表數量。

- 租戶與庫表的映射關系:租戶編碼 -> {庫數量,表數量,起始庫編號,起始表編號}。

通過上面的映射關系,可以為每個租戶靈活分配存儲資源,數據量很小的租戶還能復用已有的庫表。

示例一:

新租戶接入前已有4庫*16表,新租戶的訂單量少且并發低,直接復用已有的0號庫0號表,映射關系是:租戶編碼-> 1,1,0,0

示例二:

新租戶接入前已有4庫*16表,新租戶的訂單量多但并發低,用原有的0號庫中新建8張表來存儲,映射關系是:租戶編碼-> 1,8,0,16

示例三:

新租戶接入前已有4庫*16表,新租戶的訂單量多且并發高,用新的4庫*8表來存儲,映射關系是:租戶編碼-> 4,8,4,0

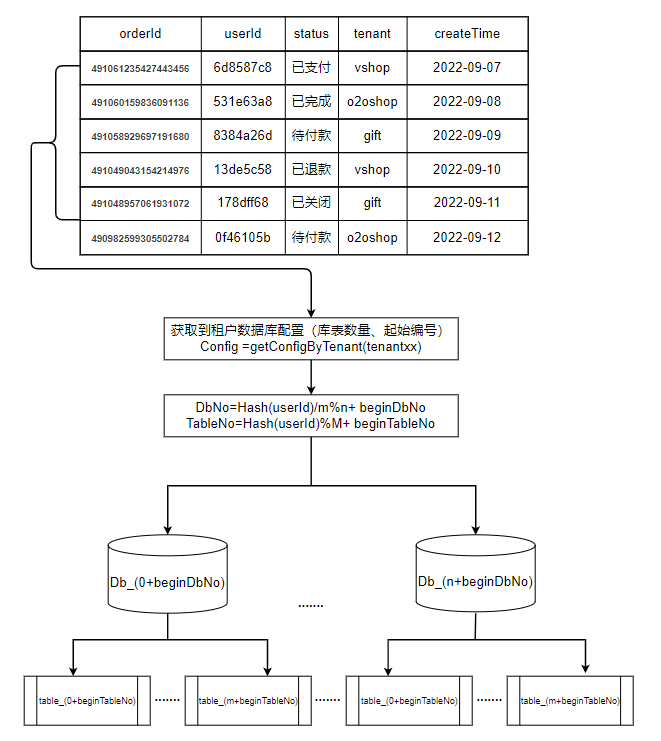

用戶訂單所屬庫表計算公式

庫序號 = Hash(userId) / 表數量 % 庫數量 + 起始庫編號

表序號 = Hash(userId) % 表數量 + 起始表編號

可能有小伙伴會問:為什么計算庫序號時要先除以表數量?下面的公式會有什么問題?

庫序號 = Hash(userId) % 庫數量 + 起始庫編號

表序號 = Hash(userId) % 表數量 + 起始表編號

答案是,當庫數量和表數量存在公因數時,會存在傾斜問題,先除以表數量就能剔除公因數。

以2庫4表為例,對4取模等于1的數,對2取模也一定等于1,因此0號庫的1號表中不會有任何數據,同理,0號庫的3號表、1號庫的0號表、1號庫的2號表中都不會有數據。

路由過程如下圖所示:

(3)局限性和應對辦法

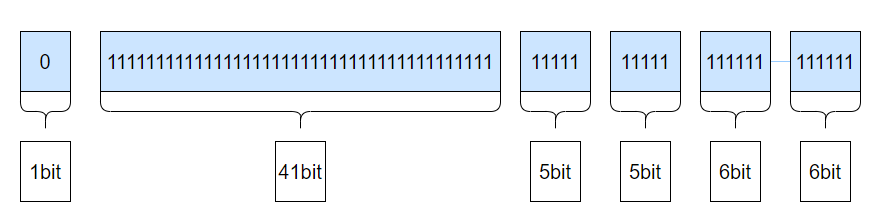

- 全局唯一ID

問題:分庫分表后,數據庫自增主鍵不再全局唯一,不能作為訂單號來使用。且很多內部系統間的交互接口只有訂單號,沒有用戶標識這個分片鍵。

方案:如下圖所示,參考雪花算法來生成全局唯一訂單號,同時將庫表編號隱含在其中(兩個5bit分別存儲庫表編號),這樣就能在沒有用戶標識的場景下,從訂單號中獲取庫表編號。

- 全庫全表搜索

問題:管理后臺需要根據各種篩選條件,分頁查詢所有滿足條件的訂單。

方案:將訂單數據冗余存儲一份到搜索引擎Elasticsearch中,滿足各種場景下的快速靈活查詢需求。

3.2 狀態機設計

(1)背景

- 之前做官方商城時,由于是定制化業務開發,各類型的訂單和售后單的狀態流轉都是寫死的,比如常規訂單在下單后是待付款,付款后是待發貨,發貨后是待收貨;虛擬商品訂單不需要發貨,沒有待發貨狀態。

- 現在要做的是平臺系統,不可能再為每個業務方做定制化開發,否則會導致頻繁改動發版,代碼錯綜冗余。

(2)目標

- 引入訂單狀態機,能為每個業務方配置多套差異化的訂單流程,類似于流程編排。

- 新增訂單流程時,盡可能不改動代碼,實現狀態和操作的可復用性。

(3)方案

- 在管理后臺為每個租戶維護一系列訂單類型,數據轉化為JSON格式存儲在配置中心,或存儲在數據庫并同步到本地緩存中。

- 每個訂單類型的配置包括:初始訂單狀態,以及每個狀態下允許的操作和操作之后的目標狀態。

- 當訂單在執行某個動作時,使用訂單狀態機來修改訂單狀態。

訂單狀態機的公式是:

StateMachine(E,S —> A , S’)

表示訂單在事件E的觸發下執行動作A,并從原狀態S轉化為目標狀態S’ - 每個訂單類型配置完成后,生成數據的結構是

- 訂單商品行狀態機、售后單狀態機,也用同樣的方式實現

3.3 通用操作觸發器

(1)背景

業務中通常都會有這樣的延時需求,我們之前往往通過定時任務來掃描處理。

- 下單后多久未支付,自動關閉訂單

- 申請退款后商家多久未審核,自動同意申請

- 訂單簽收后多久未確認收貨,自動確認收貨

(2)目標

- 業務方有類似的延時需求時,能夠有通用的方式輕松實現

(3)方案

設計通用操作觸發器,具體步驟為:

- 配置觸發器,粒度是狀態機的流程類型。

- 創建訂單/售后單時或訂單狀態變化時,如果有滿足條件的觸發器,發送延遲消息。

- 收到延遲消息后,再次判斷執行條件,執行配置的操作。

觸發器的配置包括:

- 注冊時間:可選訂單創建時,或訂單狀態變化時

- 執行時間:可使用JsonPath表達式選取訂單模型中的時間,并可疊加延遲時間

- 注冊條件:使用QLExpress配置,滿足條件才注冊

- 執行條件:使用QLExpress配置,滿足條件才執行操作

- 執行的操作和參數

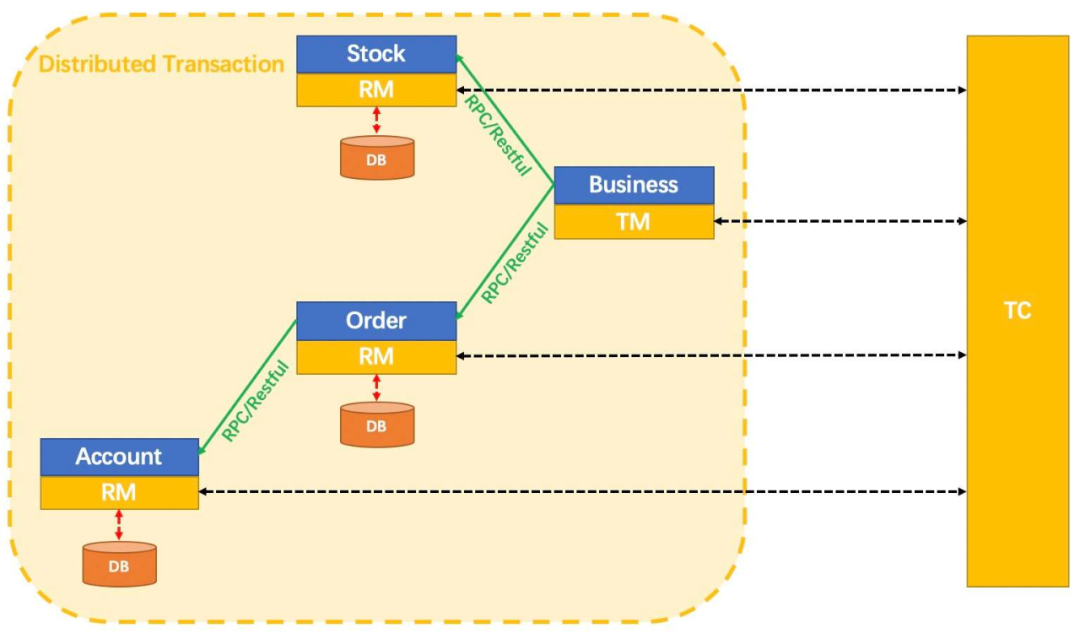

3.4 分布式事務

對交易平臺而言,分布式事務是一個經典問題,比如:

- 創建訂單時,需要同時扣減庫存、占用優惠券,取消訂單時則需要進行回退。

- 用戶支付成功后,需要通知發貨系統給用戶發貨。

- 用戶確認收貨后,需要通知積分系統給用戶發放購物獎勵的積分。

我們是如何保證微服務架構下數據一致性的呢?首先要區分業務場景對一致性的要求。

(1)強一致性場景

比如訂單創建和取消時對庫存和優惠券系統的調用,如果不能保證強一致,可能導致庫存超賣或優惠券重復使用。

對于強一致性場景,我們采用Seata的AT模式來處理,下面的示意圖取自seata官方文檔。

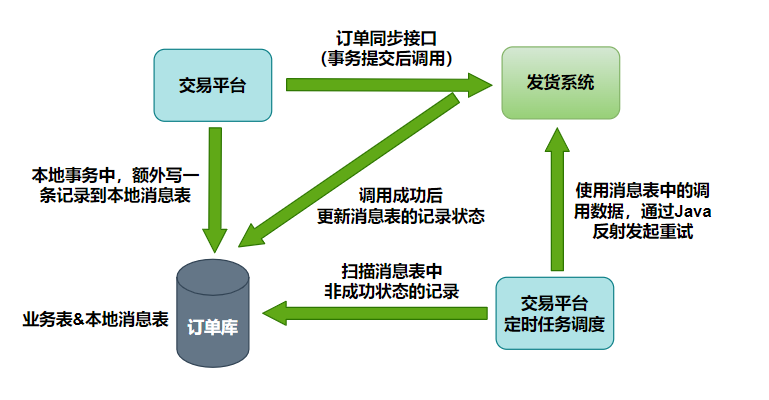

(2)最終一致性場景

比如支付成功后通知發貨系統發貨,確認收貨后通知積分系統發放積分,只要保證能夠通知成功即可,不需要同時成功同時失敗。

對于最終一致性場景,我們采用的是本地消息表方案:在本地事務中將要執行的異步操作記錄在消息表中,如果執行失敗,可以通過定時任務來補償。

3.5 高可用與安全設計

- 熔斷

使用Hystrix組件,對依賴的外部系統添加熔斷保護,防止某個系統故障的影響擴大到整個分布式系統中。

- 限流

通過性能測試找出并解決性能瓶頸,掌握系統的吞吐量數據,為限流和熔斷的配置提供參考。

- 并發鎖

任何訂單更新操作之前,會通過數據庫行級鎖加以限制,防止出現并發更新。

- 冪等性

所有接口均具備冪等性,上游調用我們接口如果出現超時之類的異常,可以放心重試。

- 網絡隔離

只有極少數第三方接口可通過外網訪問,且都有白名單、數據加密、簽名驗證等保護,內部系統交互使用內網域名和RPC接口。

- 監控和告警

通過配置日志平臺的錯誤日志報警、調用鏈的服務分析告警,再加上公司各中間件和基礎組件的監控告警功能,讓我們能夠能夠第一時間發現系統異常。

3.6 其他考慮

- 是否用領域驅動設計

考慮到團隊非敏捷型組織架構,又缺少領域專家,因此沒有采用

- 高峰期性能瓶頸問題

大促和推廣期間,特別是爆款搶購時的流量可能會觸發限流,導致部分用戶被拒之門外。因為無法準確預估流量,難以提前擴容。

可以通過主動降級方案增加并發量,比如同步入庫切為異步入庫、db查詢轉為cache查詢、只能查到最近半年的訂單等。

考慮到業務復雜度和數據量級還處在初期,團隊規模也難以支撐,這些設計有遠期計劃,但暫時還沒做。(架構的合適性原則,殺雞用牛刀,你愿意也行)。

四、總結與展望

我們在設計系統時并沒有一味追求前沿技術和思想,面對問題時也不是直接采用業界主流的解決方案,而是根據團隊和系統的實際狀況來選取最合適的辦法。好的系統不是在一開始就被大牛設計出來的,而是隨著業務的發展和演進逐漸被迭代出來的。

目前交易平臺已上線一年多,接入了三個業務方,系統運行平穩,公司內有交易/商品/庫存等需求的新業務,以及存量業務在遇到系統瓶頸需要升級時,都可以復用這塊能力。

上游業務方數量的增加和版本的迭代,對平臺系統的需求源源不斷,平臺的功能得到逐漸完善,架構也在不斷演進,我們正在將履約模塊從交易平臺中剝離出來,進一步解耦,為業務持續發展做好儲備。