“AI教父”警告:開源大型語言模型可能會讓AI變得更加危險

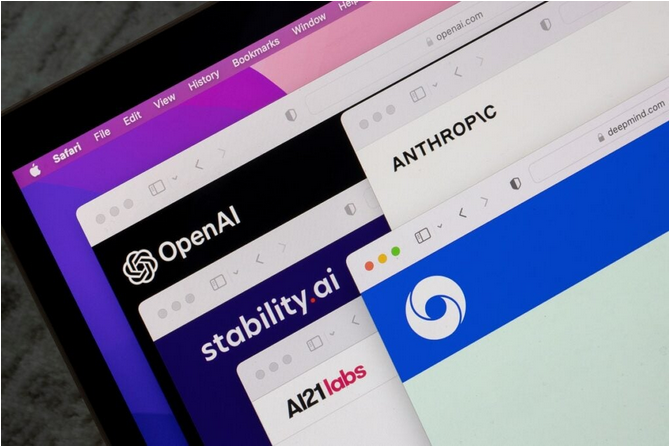

近幾個月來,世界各地的AI實驗室開發了多個大型語言模型

開源大型語言模型可能帶來的問題

OpenAI的GPT-4或谷歌的PaLM等大型語言模型為ChatGPT等生成式AI系統提供技術支撐。近幾個月來,ChatGPT等AI系統在企業和消費者中迅速普及,這些工具能夠在幾秒鐘內自動生成詳細的圖像和文本,這對許多行業來說可能是革命性的技術,但AI模型的封閉性以及高昂的開發成本,意味著用戶采用這些系統面臨高昂的成本。

為此許多人認為,大型語言模型可以提供更具成本效益的替代方案,特別是對于希望利用AI的力量并使用ChatGPT等工具的中小公司,開源正是其中的一個方案。

但Hinton認為,不斷發展和增長的大型語言模型可能會帶來問題。Hinton于上個月辭去了在谷歌的職位,聲稱這樣他就可以自由地表達自己對AI發展的擔憂。

Hinton日前在劍橋大學生存風險研究中心發表演講時說:“開源大型語言模型的危險在于,它使更多的瘋子能夠用AI做瘋狂的事情。”

把大型語言模型“關進籠子”可能是有益的

Hinton認為,大型語言模型繼續局限在OpenAI等公司的實驗室開發,可能最終證明是有益的。

他表示,“如果這些AI技術是危險的,那么最好由幾個不同國家的幾家大公司來開發,同時找到控制它的方法。一旦開源了代碼,有些人就會開始用它做各種瘋狂的事情。”

Hinton在演講中稱,相信GPT-4已經顯示出智慧涌現的跡象。他重申了自己的信念,即所謂的超級智能AI的能力超越人類智能的時刻已經不遠了。

“這些AI系統將變得比我們更聰明,這可能很快就會發生。我過去認為這可能50到100年之后發生的事情,但現在我認為可能是未來5到20年。如果它將在5年內發生,我們不能讓哲學家來決定該怎么做,而是需要有實踐經驗的人員來說決定。”他強調。

他補充說,“關于如何處理AI,我希望有一個簡單的答案。我認為最好的一個辦法是,AI開發商在開發AI模型時,應該必須投入大量人力和資源來檢查它們的安全性。我們需要獲得這些方面的經驗,了解它們可能會如何失控,以及如何控制它們。”

Hinton原來所在的谷歌旗下AI實驗室DeepMind于5月26日表示,該公司已經開發出一個早期預警系統,可以發現AI帶來的潛在風險。

一些大型語言模型已經開源并產品化

如今有一些大型語言模型已經發布在網上,特別是今年3月Meta的大型語言模型LLaMa的源代碼,已被泄露到網上。

軟件供應商也試圖從企業對可安裝的、有針對性的、個性化的大型語言模型日益增長的需求中獲利。今年4月,Databricks發布了一個名為Dolly2.0的大型語言模型,將其標榜為第一個指定用于商業用途的開源、遵循指令的大型語言模型,聲稱其具有類似ChatGPT的功能,并且可以在企業內部運行。

開源模型的支持者表示,它們有可能使ChatGPT等AI系統的使用“民主化”。本月早些時候,軟件開發人員Keerthana Gopalakrishnan在接受媒體采訪時表示:“我認為降低實驗的進入門檻很重要。有很多人對這項技術感興趣,他們真的希望通過AI進行創新。”