Open Interpreter 一款通過讓大語言模型在本地運行代碼的開源神器

最近在逛 Github 的時候發現了一款神器,叫做 Open Interpreter,主要是用來實現在本地和大語言模型進行交互的,通過大語言模型將自然語言轉換為腳本代碼,然后在本地執行從而實現目標。

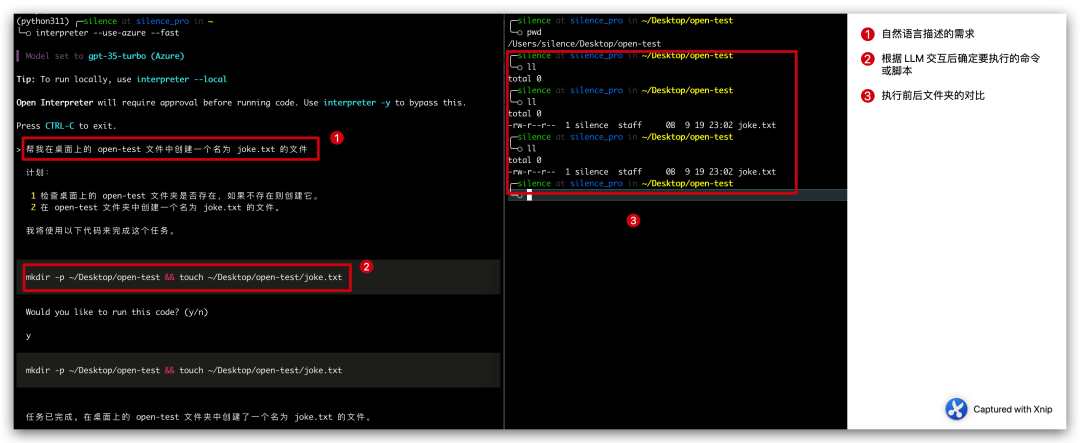

簡單來說比如你想在桌面上創建一個名為 joke.txt 文件,你不在需要手動創建,而是通過自然語言告訴 Open Interpreter,讓它幫我們生成創建文件的腳本,然后在本地執行,從而生成一個 joke.txt 文件。

我們要做的就是告訴它我們的需求是什么,以及允許它在本地執行代碼即可。

如下所示

圖片

圖片

上面的 case 整個過程分三步:

- 我們通過自然語言描述一個需求:幫我在桌面上的 open-test 文件中創建一個名為 joke.txt 的文件

- Open Interpreter 會將我們的需求進行拆解,并且列出它的執行計劃和要執行的命令。

計劃:

1 檢查桌面上的 open-test 文件夾是否存在,如果不存在則創建它。

2 在 open-test 文件夾中創建一個名為 joke.txt 的文件。

我將使用以下代碼來完成這個任務。

mkdir -p ~/Desktop/open-test && touch ~/Desktop/open-test/joke.txt- 在經過我們的人工確認后進行執行,最終成功的創建出的文件。

這個項目剛剛起步,這個 case 也很簡單,但是我們要知道這仿佛打開了另一扇大門,以后只要是通過代碼能實現的功能,我們都可以通過自然語言來實現了,想想都很激動(可怕)。

官方的介紹這個工具都可以用來編輯視頻以及發送郵件,只能說很有前景。

安裝和配置

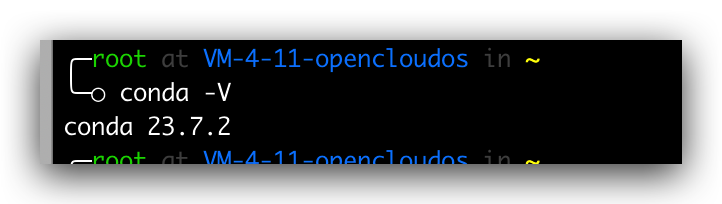

安裝 conda

這個項目的安裝也非常簡單,正常我們只要在命令行中執行 pip install open-interpreter 即可,但是為了保證環境的穩定,我們這邊準備用 conda 進行環境隔離,所以我們首先安裝 conda,依次執行下面的命令

# 獲取腳本

wget https://repo.anaconda.com/archive/Anaconda3-2023.07-2-Linux-x86_64.sh

# 增加可執行權限

chmod +x Anaconda3-2023.07-2-Linux-x86_64.sh

# 運行安裝腳本

./Anaconda3-2023.07-2-Linux-x86_64.sh

# 查詢版本

conda -V如何能正常輸出版本號,則表明安裝成功,如果提示命令不存在,那我們就需要配置一下環境變量,在

vim .bash_profile

# 加入下面一行

PATH=$PATH:$HOME/bin:$NODE_PATH/bin:/root/anaconda3/bin

# 再次執行

conda -V 圖片

圖片

創建隔離環境

安裝完成 conda 過后,我們就創建指定 Python 版本的隔離環境了,通過如下命令

conda create -n python311 pythnotallow=3.11這行代碼的含義是通過 conda create 創建一個名字叫 python311 的隔離環境,隔離環境的 python 版本指定為 3.11,創建完成過后我們可以通過下面的命令查詢隔離環境的列表。

conda env list 圖片

圖片

安裝 open-interpreter

然后我們進入到隔離環境中,在隔離環境中安裝 open interpreter,命令如下

conda activate python311

pip install open-interpreter等待一會即可安裝成功,安裝成功過后輸入下面命令,即可開啟本地大語言模型交互。

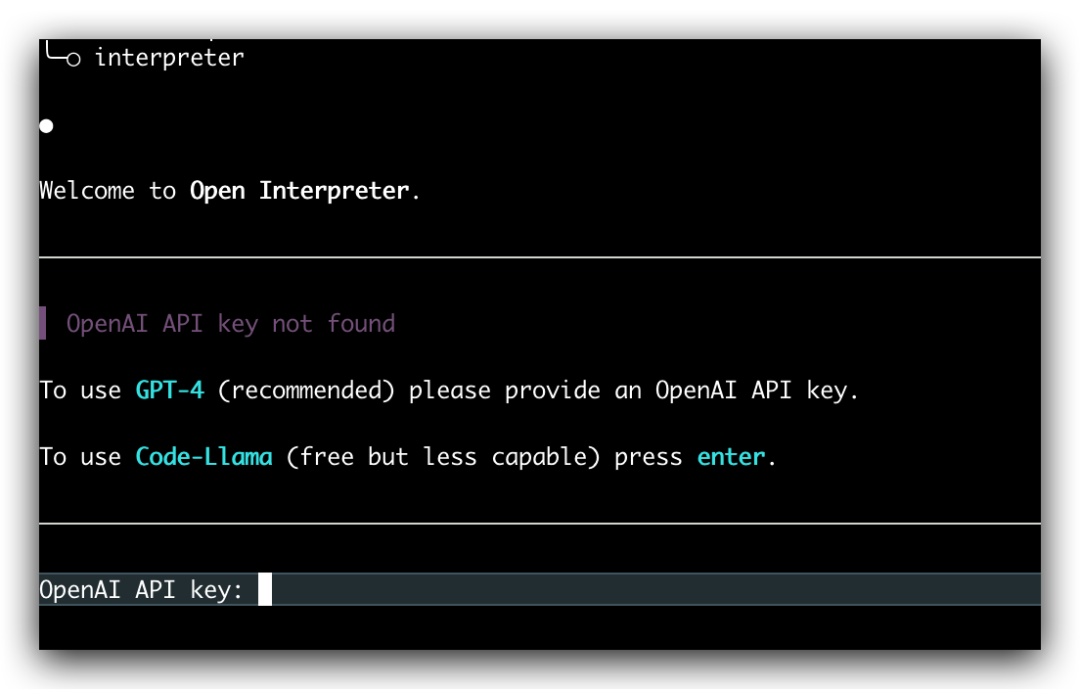

interpreter 圖片

圖片

直接輸入 interpreter 命令會要求我們輸入自己的 OpenAI API key,此時默認使用的 GPT-4 模型,我們可以通過增加 --fast 參數來使用 GPT-3.5,

interpreter --fast這里我們每次執行都需要手動填入 OpenAI API key 比較麻煩,可以配置一下環境變量

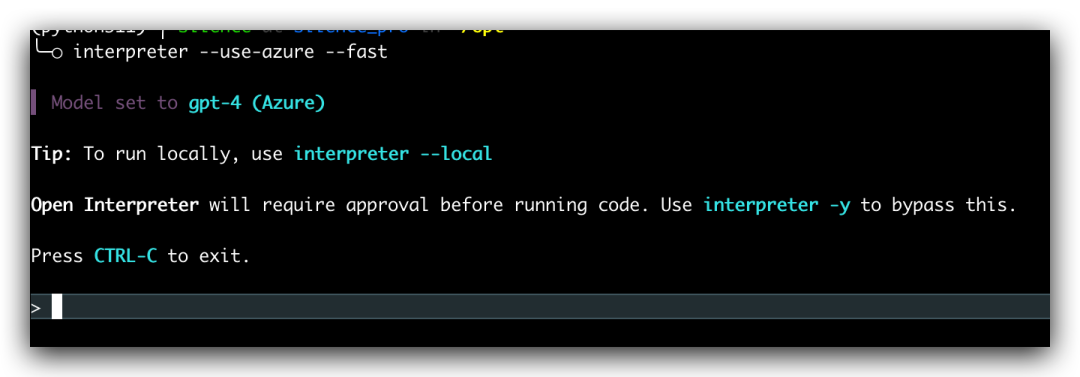

export OPENAI_API_KEY=skxxxx這樣我們后續執行就不用在手動填 OpenAI 的API key 了,如果想用微軟的 Azure OpenAI 的話,也是支持的,只要配置下面的環境變量,然后在啟動的時候增加 --use-azure 參數就可以了

export AZURE_API_KEY=

export AZURE_API_BASE=

export AZURE_API_VERSION=

export AZURE_DEPLOYMENT_NAME=interpreter --use-azure 圖片

圖片

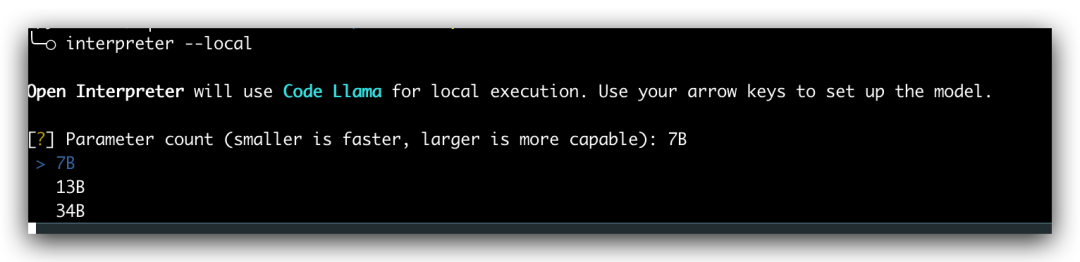

本地啟動

上面的操作都需要我們有對應 OpenAI 的 API Key 或者 Azure 的 OpenAI 的 endpoint,其實 open interpreter 還支持本地運行,只要在啟動的時候增加 --local 參數,然后就讓我們選擇對應的模型。不過對于本地運行需要我們的電腦配置支持才行,感興趣的小伙伴可以參考官方文檔實踐一下,我這邊的配置不允許~~

圖片

圖片

總結

今天給大家介紹了一下 Open interpreter 的安裝方法和簡單玩法,這個項目還在高速的迭代中,相信不久的將來將會帶來一場變革,不得不說 AI 的時代是真正的到來了,未來幾年將會是 AI 產品的井噴時代,作為程序員我們要緊跟時代的步伐不掉隊。