可與H100一戰,微軟首款5納米自研芯片震撼發布!Copilot引爆辦公全家桶,Bing Chat改名

微軟深夜炸場,萬物皆可Copilot!

Bing Chat,從此更名Copilot。

登錄微軟賬號,就可以在Copilot專屬網站上免費使用GPT-4、DALL·E 3。

圖片

圖片

OpenAI的全新王牌爆款——自定義GPT,也被塞進Copilot宇宙,變身為Copilot Studio。

打工人利器Office,也在Copilot的加持下全面升級。

而且,微軟終于也開始制造定制芯片了!兩款為云基礎結構設計的定制芯片——Azure Maia 100和Azure Cobalt 100在昨晚閃亮登場。

圖片

圖片

全線改名Copilot,自定義GPT來了

今天,微軟Copilot全面迎來了新時代。

在Ignite 2023 大會上,納德拉宣布Bing Chat和Bing Chat for Enterprise,正式更名為Copilot!

除了Edge,Copilot可以在Chrome,Safari瀏覽器上網頁運行,并且很快上線移動設備。

圖片

圖片

當然,Copilot免費版可以在必應和Windows中直接訪問,還有一個專門入口(https://copilot.microsoft.com/)。

Microsoft 365中的Copilot依舊需要付費。

圖片

圖片

Microsoft 365的Copilot目前僅限于微軟最大的客戶,企業必須至少達到300個用戶,才能進入AI驅動的Office助手的名單,每位用戶每月收費30美元。

今年年初,微軟還曾提到與谷歌搜索競爭的AI野心,但現在看起來,這家老牌巨頭顯然把目光投向了ChatGPT。

在OpenAI宣布每周有1億人使用ChatGPT后,Bing Chat直接更名。

這不得不讓外界猜想,盡管有價值數十億美元的密切合作關系,但微軟和OpenAI仍在爭奪相同客戶,而Copilot,就是微軟試圖拋給消費者和企業的最佳選擇。

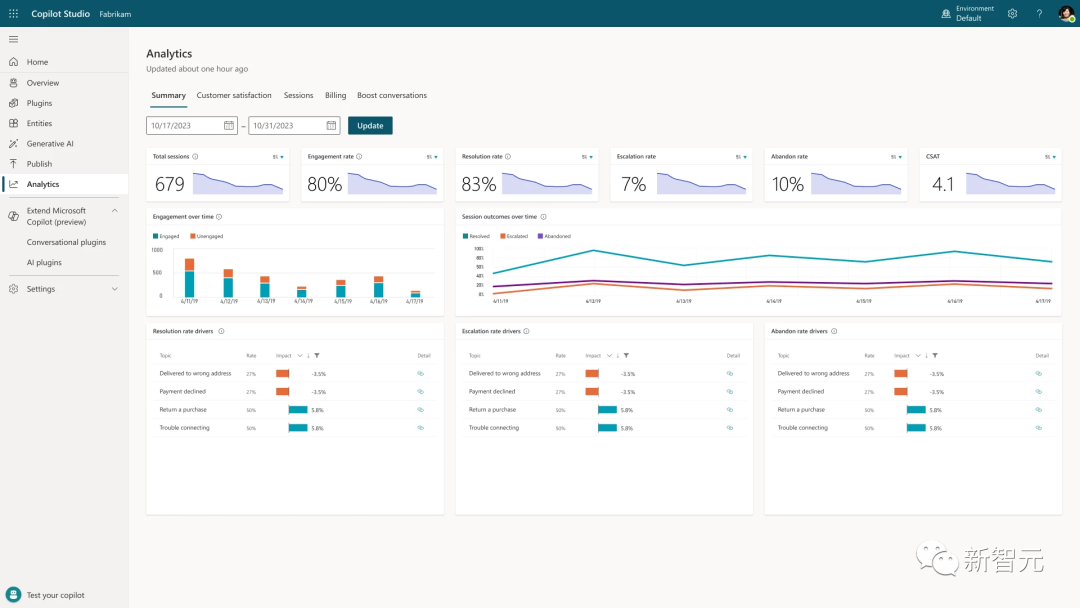

值得一提的是,微軟大會還發布了低代碼工具——Microsoft Copilot Studio。

與OpenAI可以定制的GPT還是有所不同,它是可以擴展到Microsoft 365。

其優勢在于,Copilot Studio可以在同一網頁上進行構建、部署、分析、管理內容。

圖片

圖片

更重磅的是,Copilot Studio無縫集成OpenAI的GPTs,允許開發者構建自己的GPT。

另外,Copilot Studio還有一個可以分析的儀表板,管理員可以集中監視使用情況并進行分析,在管理中心內控制訪問權限。

圖片

圖片

微軟還在Dynamics 365 Guides集成了Copilot,將生成式AI與混合現實相結合,幫助一線員工完成復雜的任務。

未來,工程師無需搜索大量文檔或紙質手冊,僅通過自然語言和手勢就能查詢信息。

圖片

圖片

微軟自研芯片來了

此前,坊間曾傳出傳言:微軟在悄悄構建自己的芯片,用于訓練大語言模型,避免對英偉達過度依賴。

現在證實了——傳言是真的!

今年的大模型熱,讓H100的需求激增,單塊甚至在eBay上賣出了超過4w美元的價格。

這塊大蛋糕,微軟絕對不會放下,Azure Maia和Azure Cobalt CPU明年就會上市。

圖片

圖片

SemiAnalysis深度分析:https://www.semianalysis.com/p/microsoft-infrastructure-ai-and-cpu

Azure Maia GPU(Athena/雅典娜)

雖然微軟是四巨頭(亞馬遜、谷歌、Meta、微軟)里最后一個發布產品的,但這次的Maia 100 GPU卻毫不遜色——

在算力方面能與英偉達(H100)和AMD(MI300X)一戰,在網絡IO方面遙遙領先,而在顯存帶寬方面則稍顯落后。與目前使用第二代Trainium/Inferentia2芯片的亞馬遜相比,紙面上的各項指標都實現了碾壓。

圖片

圖片

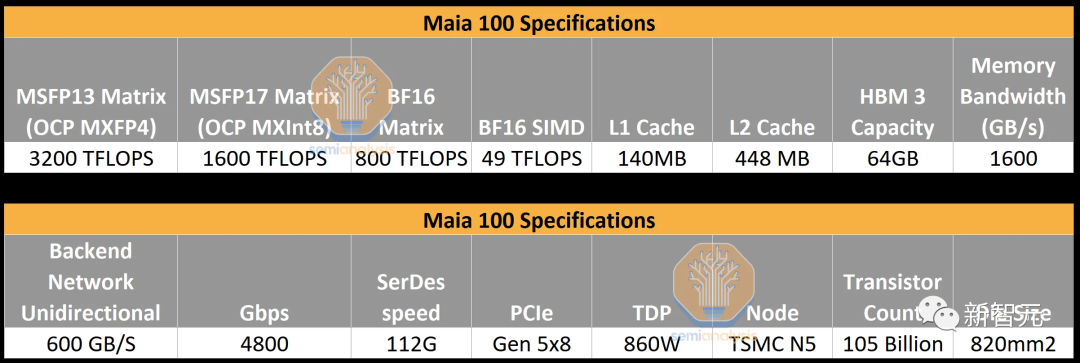

具體來說,Maia采用的是臺積電5nm節點工藝,擁有1050億個晶體管的單片芯片。并支持微軟首次實現的8位以下數據類型,即MX數據類型。

算力方面,Maia在MXInt8格式下,算力可以達到1600 TFLOPS,在MXFP4格式下則為3200 TFLOPS。

由于是在LLM熱潮出現之前設計的,Maia的顯存帶寬只有1.6TB/s。雖然這比Trainium/Inferentia2高,但明顯低于TPUv5,更不用說H100和MI300X了。此外,微軟采用的是4層HBM,而不是英偉達的6層,甚至AMD的8層。

據業內人士分析,微軟當時在芯片上加載了大量的SRAM,從而幫助減少所需的顯存帶寬,但這似乎并不適用于現在的大語言模型。

圖片

圖片

Maia的另一個有趣之處,便是微軟對網絡的處理。

就AMD和英偉達而言,它們都有自己的Infinity Fabric和NVLink,用于小范圍芯片的高速連接(通常為8個)。如果要將數以萬計的GPU連接在一起,則需要將以太網/InfiniBand的PCIe網卡外接。

對此,微軟采取了完全不同的方式——每個芯片都有自己的內置RDMA以太網IO。這樣,每個芯片的IO總量就達到了4.8Tbps,超過了英偉達和AMD。

圖片

圖片

為了充分發揮出Maia的性能,微軟專門打造了名為Ares的機架和集群,并首次采用了「Sidekick」全液冷設計。

這些機架是為Maia高度定制的,比標準的19"或OCP機架更寬。

具體來說,微軟在一個機架上搭載了8臺服務器,其中每臺服務器有4個Maia加速器,也就是共計32個Maia芯片。除此之外,還會配備網絡交換機。

此外,Maia機架的功率可以達到約40KW,這比大多數仍只支持約12KW機架的傳統數據中心也要大得多。

Maia 100服務器機架和「Sidekick」液卻

Maia 100服務器機架和「Sidekick」液卻

值得注意的是,微軟使用的是自己從第三方獲得SerDes授權,并直接向臺積電提交設計,而不是依賴Broadcom或Marvell這樣的后端合作伙伴。

Sam Altman表示,第一次看到微軟Maia芯片的設計時,自己和同事感到非常興奮。而OpenAI也已經用自己的模型(GPT-3.5 Turbo)對Maia進行了改進和測試。

圖片

圖片

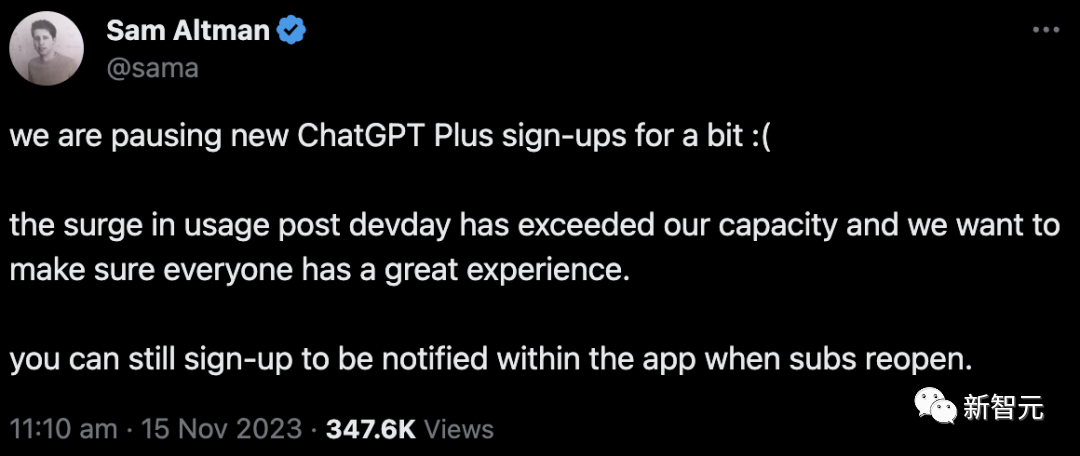

就在昨天 ,Sam Altman剛剛宣布訪問量激增超出承受能力,Plus賬號注冊暫停

Azure Cobalt CPU

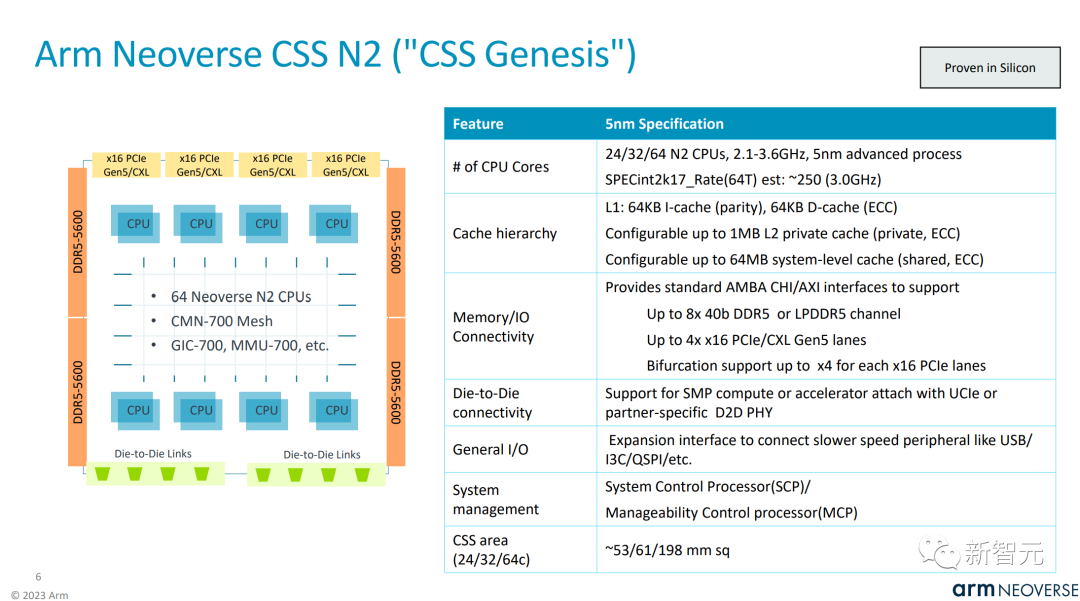

CPU方面,Microsoft Azure Cobalt是一款基于Armv9架構的云原生芯片,針對通用工作負載的性能、功率和成本效益進行了優化。

具體來說,Azure Cobalt 100 CPU共有128個核心,并支持12條DDR5通道。

與微軟第一款基于Neoverse N1的Arm CPU相比,基于Neoverse N2的Cobalt 100在性能上提升了40%。

圖片

圖片

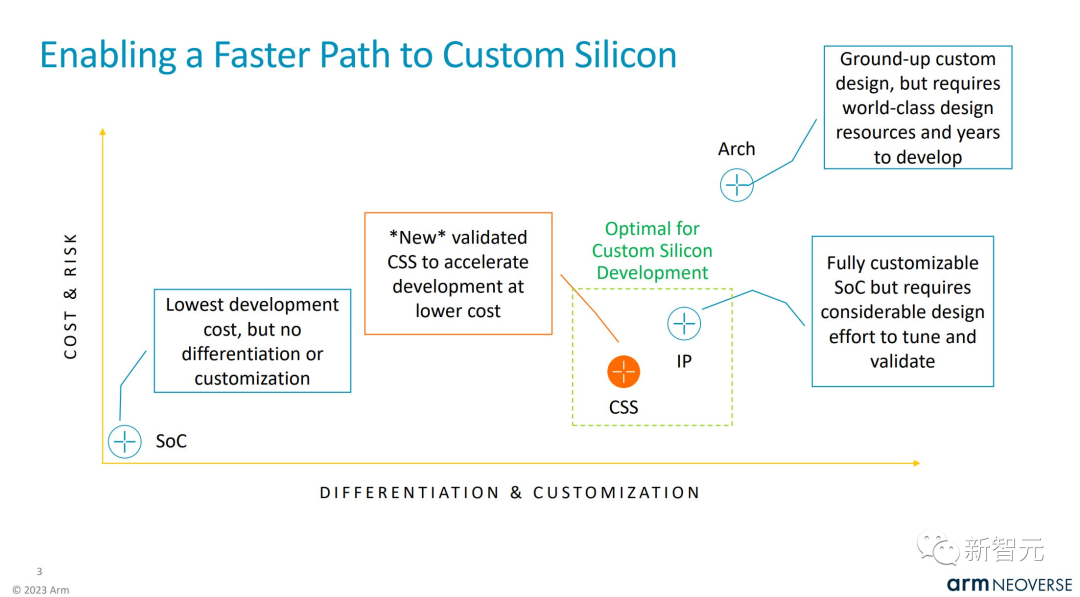

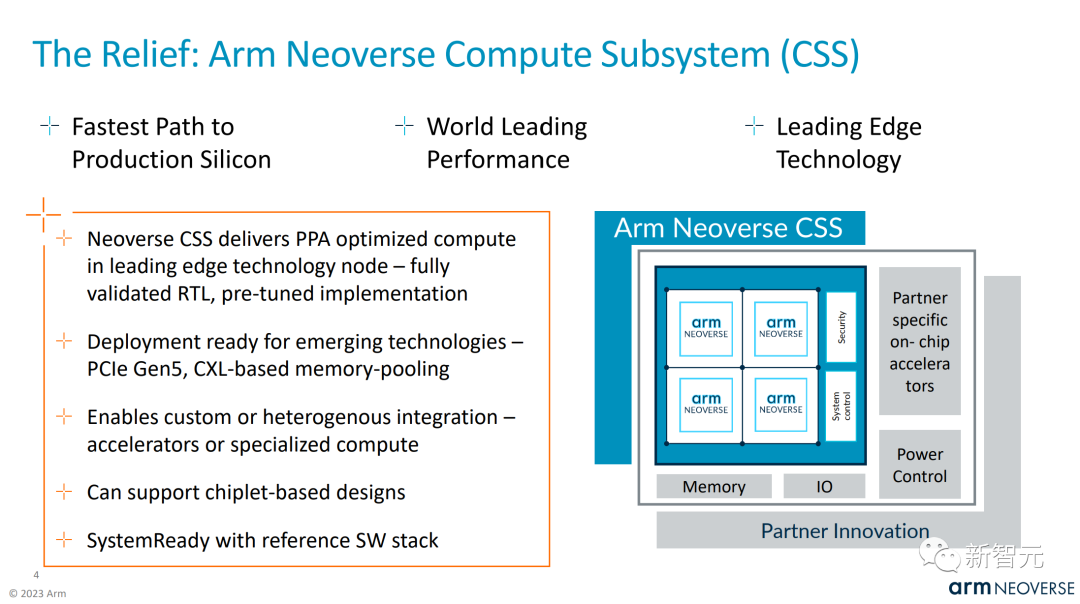

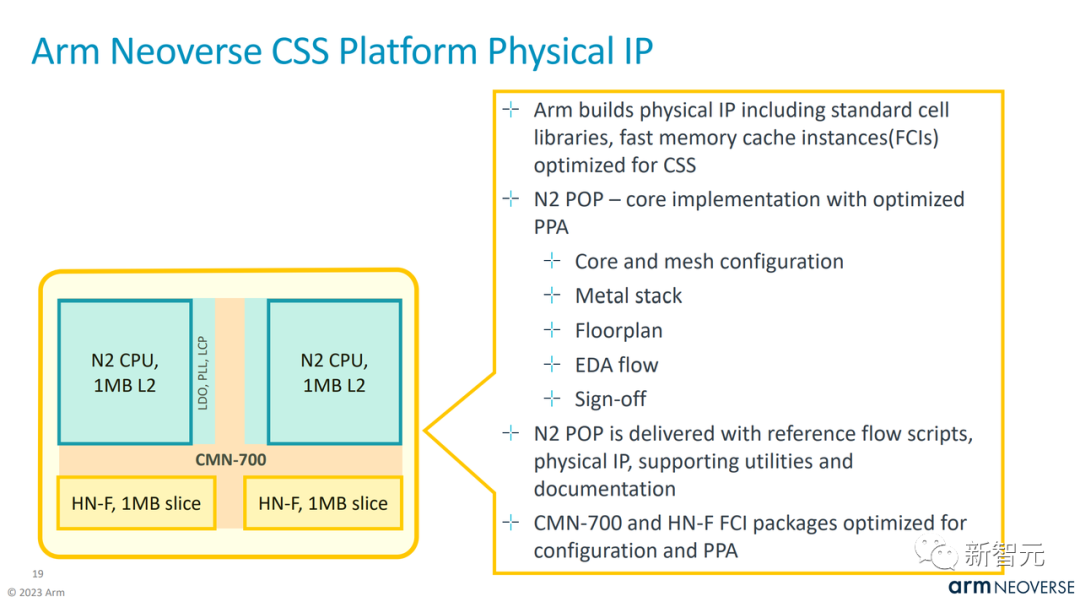

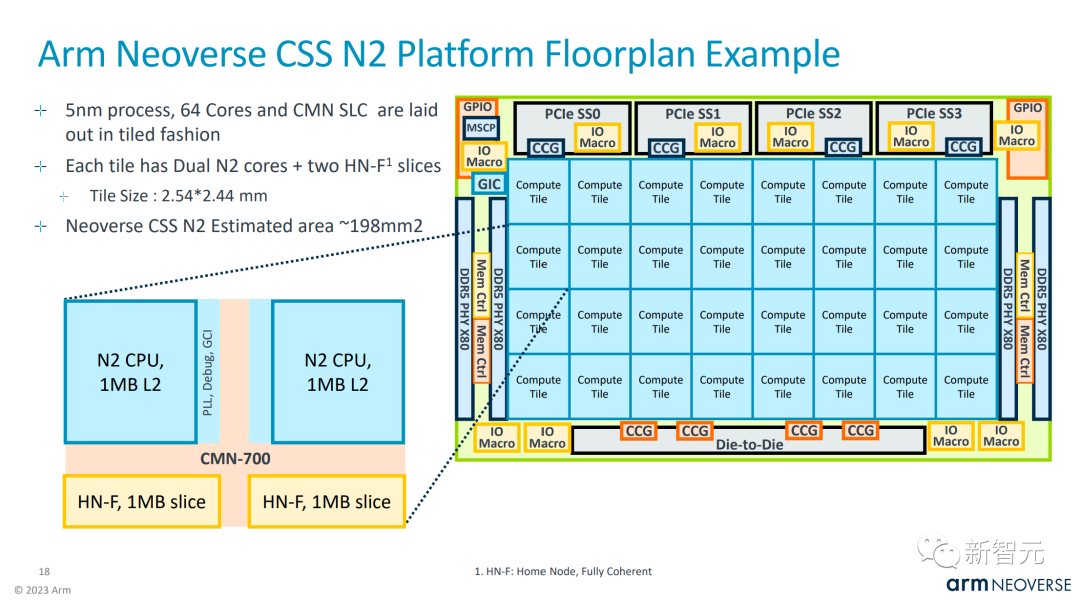

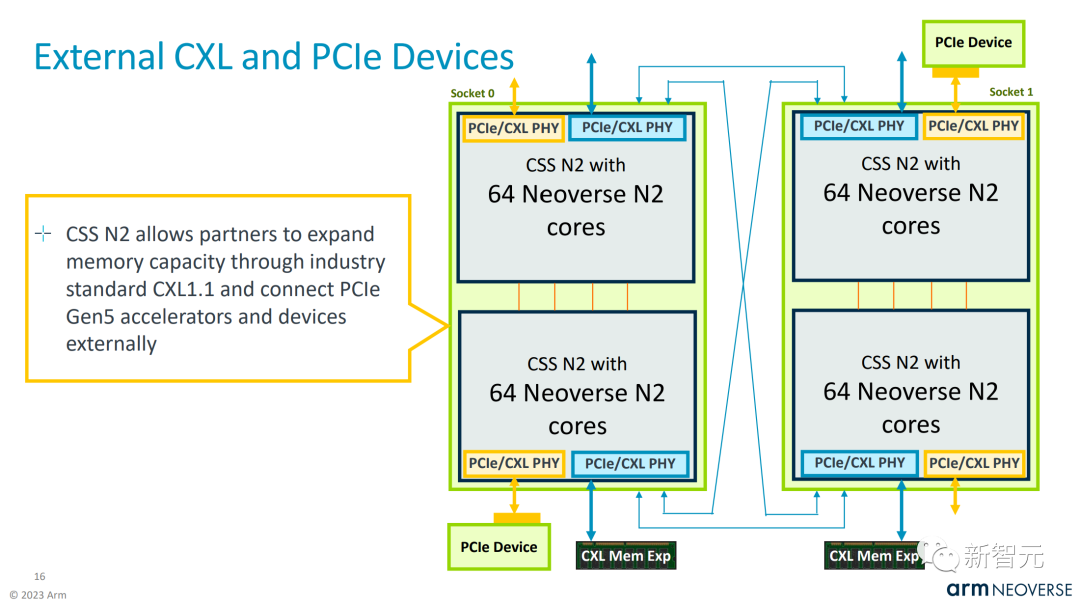

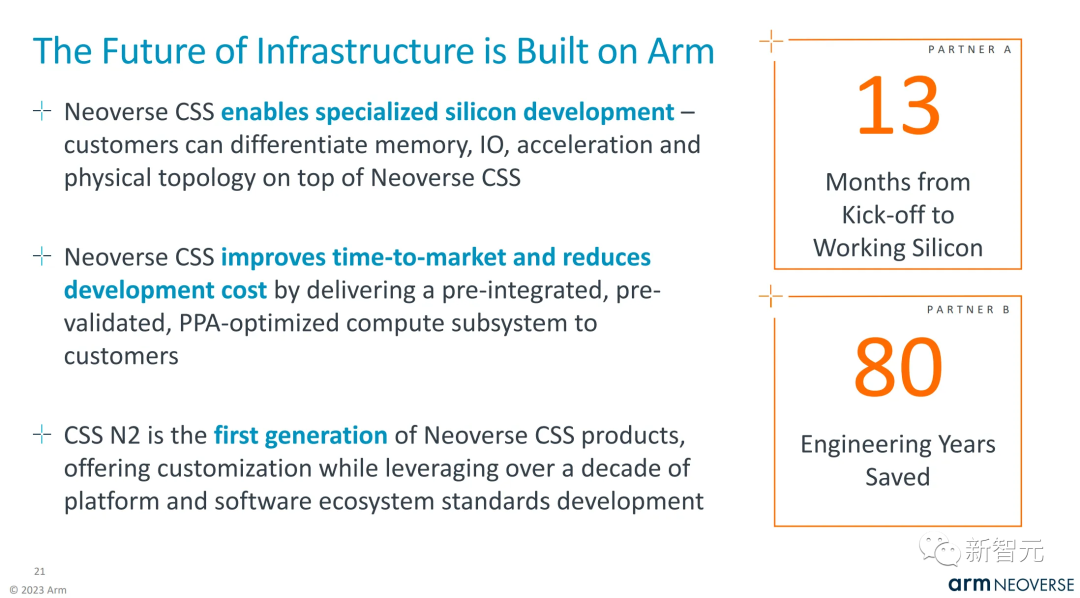

與Arm傳統的只授權IP的商業模式不同,Neoverse Genesis CSS(計算子系統)平臺可以使CPU的開發更快、更容易,且成本更低。

圖片

圖片

圖片

圖片

圖片

圖片

就Cobalt 100而言,微軟采用的是2個Genesis計算子系統,并將它們連接成1個CPU。

圖片

圖片

圖片

圖片

圖片

圖片

Arm此前曾表示,有一個項目從啟動到完成芯片只用了13個月。根據業界推測,這里提到的很可能就是微軟。

圖片

圖片

可以說,微軟花了許多心思。在設計上的獨具匠心,不僅讓它具有高性能,還能控制每個內核和每個虛擬機的性能和功耗。

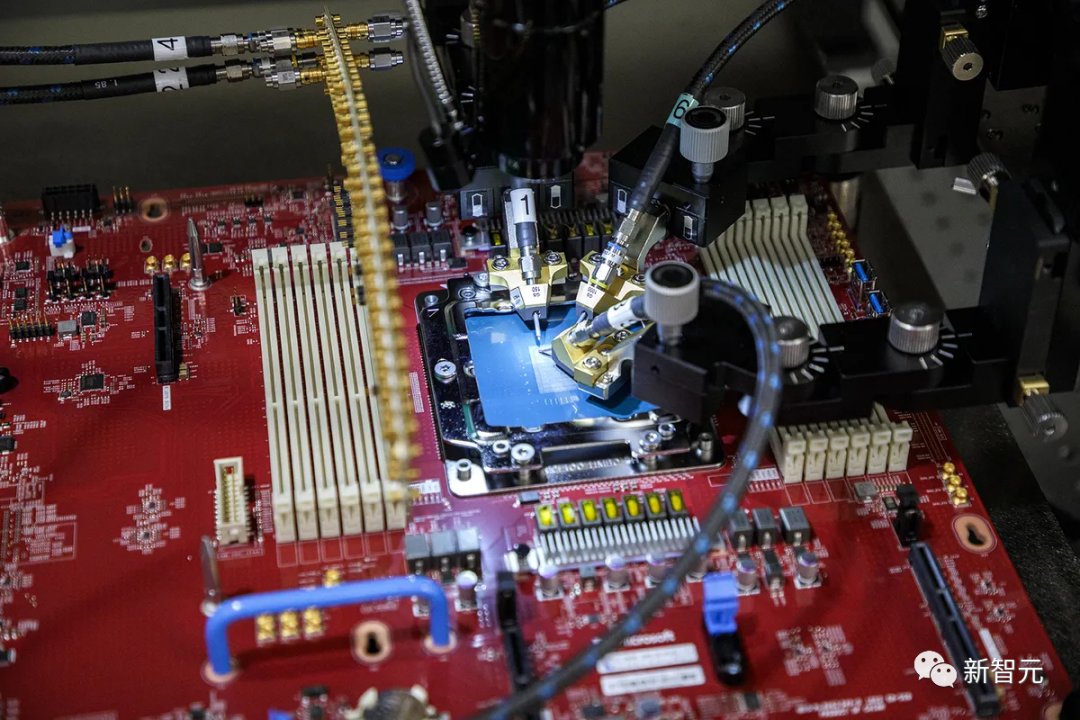

用于測試Microsoft Azure Cobalt片上系統的探針臺

用于測試Microsoft Azure Cobalt片上系統的探針臺

目前,微軟正在Microsoft Teams和SQL Server等工作負載上測試Cobalt CPU,計劃明年向客戶提供用于各種工作負載的虛擬機。

重新思考AI時代的云基礎設施

實際上,微軟在芯片開發上有著悠久的歷史。

20多年前,微軟就和Xbox合作,還為Surface設備共同設計了芯片。17年,微軟就開始構建云硬件堆棧。

Azure Maia AI芯片和Azure Cobalt CPU都是在微軟內部構建的,微軟對整個云服務器堆棧進行了深入檢修,以優化性能,功耗和成本。

用微軟硬件系統負責人Rani Borkar的話說,「我們正在重新思考人工智能時代的云基礎設施,并從字面上優化該基礎設施的每一層。」

現在,微軟、AMD、Arm、英特爾、Meta、英偉達和高通在內的集團,都在標準化AI模型的下一代數據格式。

圖片

圖片

微軟:我們和英偉達是互補,不是競爭

跟H100、H200,甚至是AMD最新的MI300X比較,Maia的性能如何呢?

Borkar回避了這個問題,而是重申微軟與英偉達和AMD的合作對于Azure AI云的未來很重要。

「重要的是,在云運行的規模上優化和集成堆棧的每一層、最大限度地提高性能、使供應鏈多樣化,為客戶提供基礎設施的選擇。」

據悉,要實現ChatGPT的商業化,OpenAI需要30,000塊A100,如果用微軟自研的芯片,顯然會降低AI成本。

圖片

圖片

考慮到目前AI領域的速度,Maia 100的繼任者很可能會和H200相同的速度推出,也就是大概20個月后。

隨著微軟本周推出更多的Copilot功能和Bing Chat的品牌重塑,Maia必然會大顯身手。

GPT性能/總擁有成本

對于芯片來說,最重要的是性能。

在推理方面,需要注意的是,微軟所做的內存權衡是非常不利的,這使得微軟很難與之競爭。

H100的內存帶寬是其2倍多,H200是其3倍,而MI300X甚至更高。

因此,在LLM推理方面,Maia 100的性能處于劣勢。就每秒處理更大批大小的token而言,GPT-4推理的性能大約是 H100的1/3。

值得注意的是,這本身并不是一個大問題,因為制造成本與英偉達的巨大利潤率彌補了大部分差距。

問題是,電源和散熱仍需要更多成本,而且token到token的延遲更差。

在聊天機器人和許多協同Copliot工具等對延遲敏感的應用中,Maia無法與英偉達和AMD GPU競爭。

后兩種GPU都可以使用更大的批處理量,同時可接受延遲,因此它們的利用率會更高,性能TCO也比Maia高得多。

在GPT-3.5 Turbo等較小的模型中,情況要好一些,但微軟不能只部署針對小模型的優化硬件。因為隨著時間的推移,GPT-3.5 Turbo等小模型將被逐步淘汰。

不僅在硬件上強強聯合,微軟會上還宣布將英偉達AI代工廠服務(Nvidia AI Foundry)引入Azure。

不僅有英偉達的基礎模型、NeMo框架、DGX Cloud AI超算以及服務全部集成到微軟Azure平臺,向企業和開發者開放。

圖片

圖片

數學推理飆升50%,27億參數Phi-2開源

開發者方面,微軟在自家的Azure AI上提供了從數十億到數萬億不等的基礎模型。

納德拉現場激動地表示,OpenAI團隊做了非常出色的工作推動AI的前進,我們將繼續推進深度合作。

他現場承諾:只要OpenAI一更新,微軟就會在平臺全部交付。

圖片

圖片

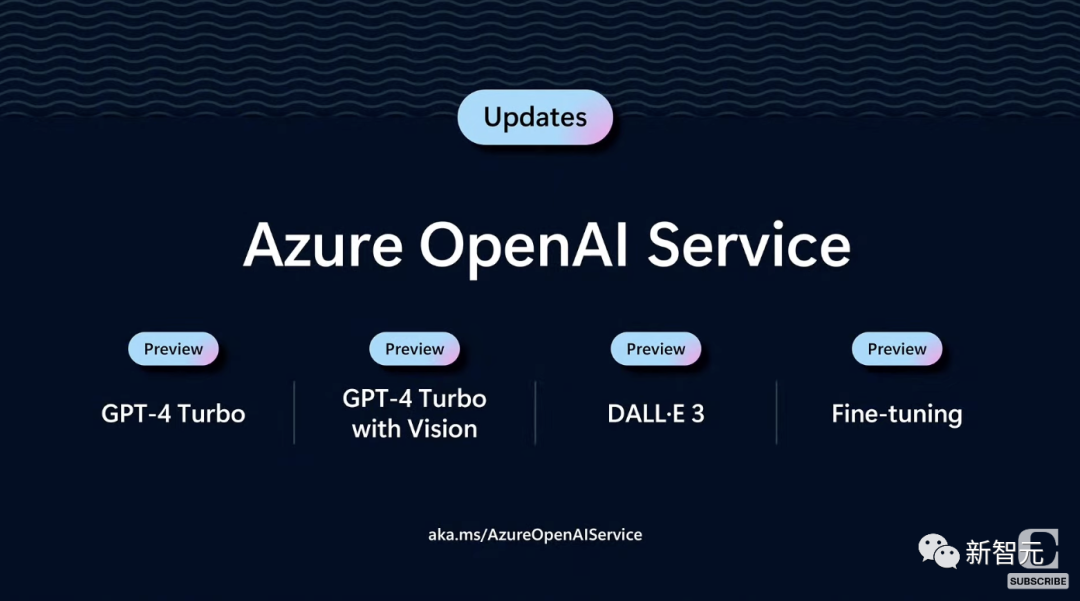

OpenAI首屆開發者大會上的模型更新,同樣上線微軟開發者平臺。其中,包括GPT-4 Turbo,以及GPT-4 Turbo with Vision,DALLE·3。

另外,微軟還將提供GPT-4的微調功能。這樣,開發者可以調用自己的數據去微調自定義的GPT-4。

至于定價,微軟與OpenAI保持一致。

圖片

圖片

同樣,微軟Azure AI還支持開源模型。

開發者能夠輕松地將Stable Diffusion、Llama 2、G42 Jais等最新的模型,通過API集成到應用中。

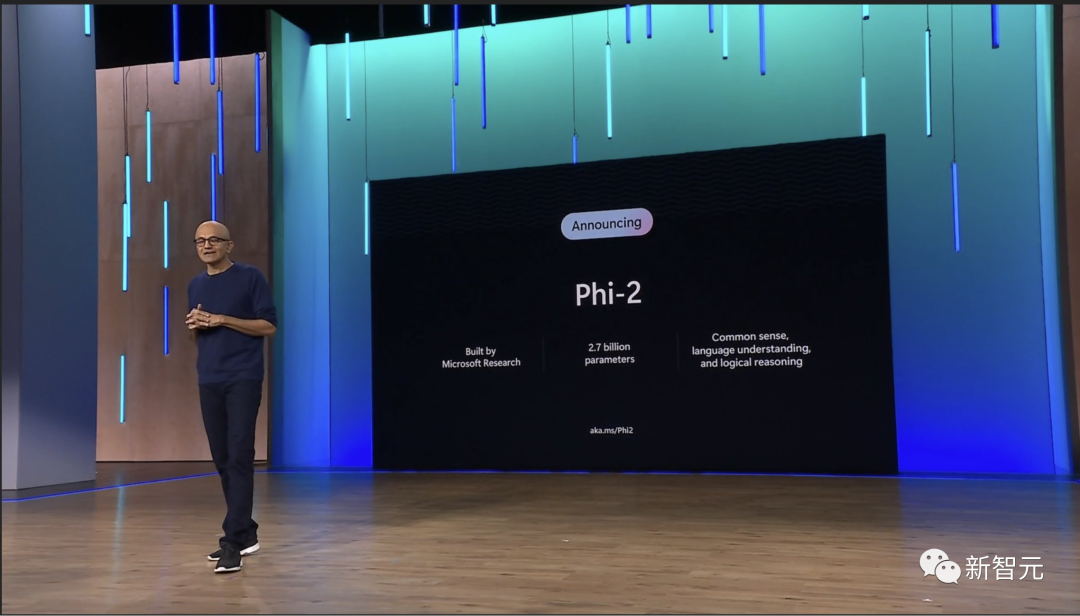

另外,微軟還宣布了全新的小體量模型——Phi-2,僅有27億參數,并將在未來開源。

圖片

圖片

最新Phi-2模型,同樣是在教科書級數據上完成訓練,比前身Phi-1.5更加強大,在數學推理上的性能飆升50%。

圖片

圖片

除了模型,為了進一步降低開發者門檻,微軟還推出了全鏈條開發工具——Azure AI Studio。

它提供了完整周期的工具鏈,是一個端到端的平臺,包括模型的開發、訓練、評估、部署、定制等等。

圖片

圖片

參考資料:

https://www.semianalysis.com/p/microsoft-infrastructure-ai-and-cpu

https://www.theverge.com/2023/11/15/23960517/microsoft-copilot-bing-chat-rebranding-chatgpt-ai