無語!我是來面Java的,你怎么問我大數據的Kafka?

大家好,我是哪吒。前兩天,有個朋友去面試,被問到Kafka事務的問題。她的第一反應是:我是來面試Java的,怎么問我大數據的Kafka?

不過Kafka確實是Java程序員必備的中間件技術了,這點是毋庸置疑的。

Kafka幾乎是當今時代背景下數據管道的首選,無論你是做后端開發、還是大數據開發,對它可能都不陌生。開源軟件Kafka的應用越來越廣泛。

面對Kafka的普及和學習熱潮,哪吒想分享一下自己多年的開發經驗,帶領讀者比較輕松地掌握Kafka的相關知識。

今天系統的說一下Kafka的事務,實現步步為營,逐個擊破,拿下Kafka。

在當今大數據時代,數據的可靠性和一致性變得至關重要。Kafka作為一個分布式流數據平臺,強調了實時數據的高吞吐量傳輸,而Kafka事務性消息則在這個過程中發揮了至關重要的作用。

本文將詳細介紹Kafka事務性消息,探究它們如何確保數據一致性,以及在各種應用場景中的應用。

一、Kafka事務性消息

1、介紹Kafka事務性消息

Kafka事務性消息是一項關鍵的功能,為確保數據一致性提供了重要的支持。在本部分,我們將深入了解Kafka事務性消息的基本概念。

Kafka事務性消息的概念

為什么需要事務性消息?

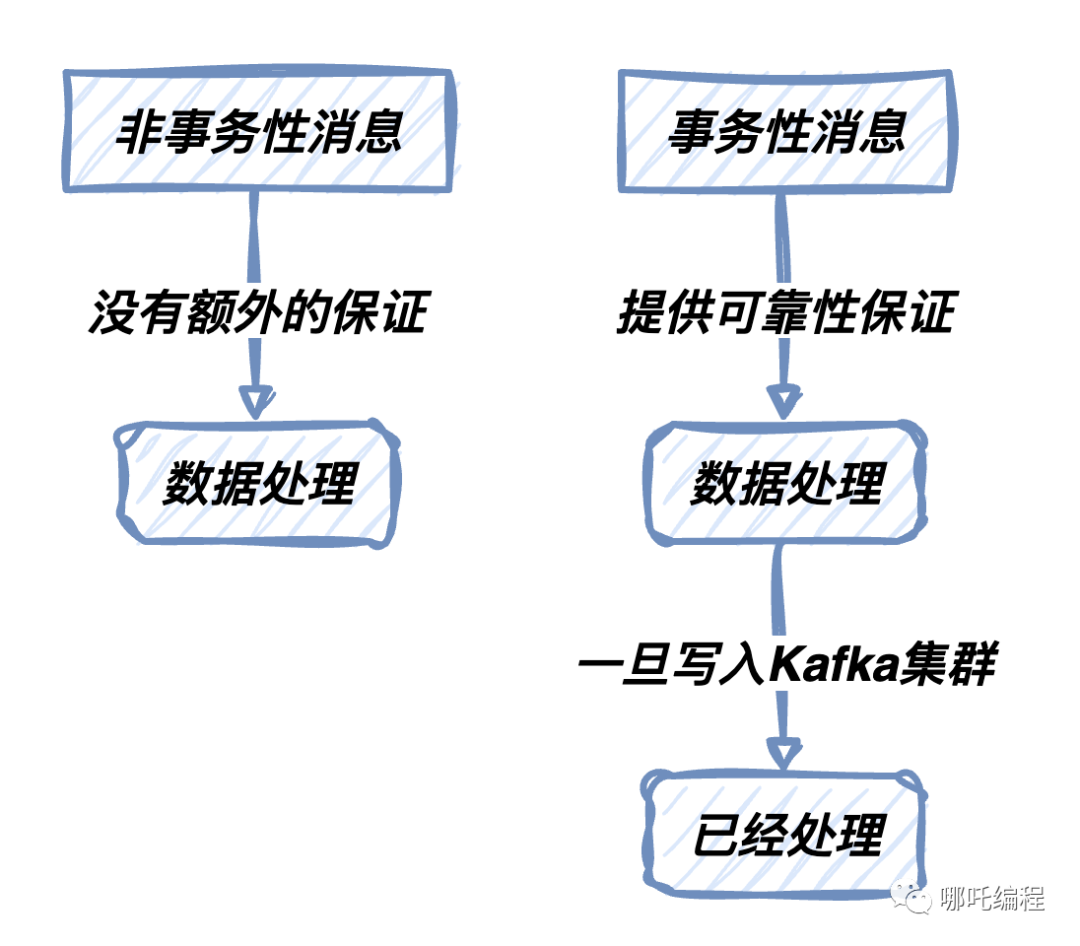

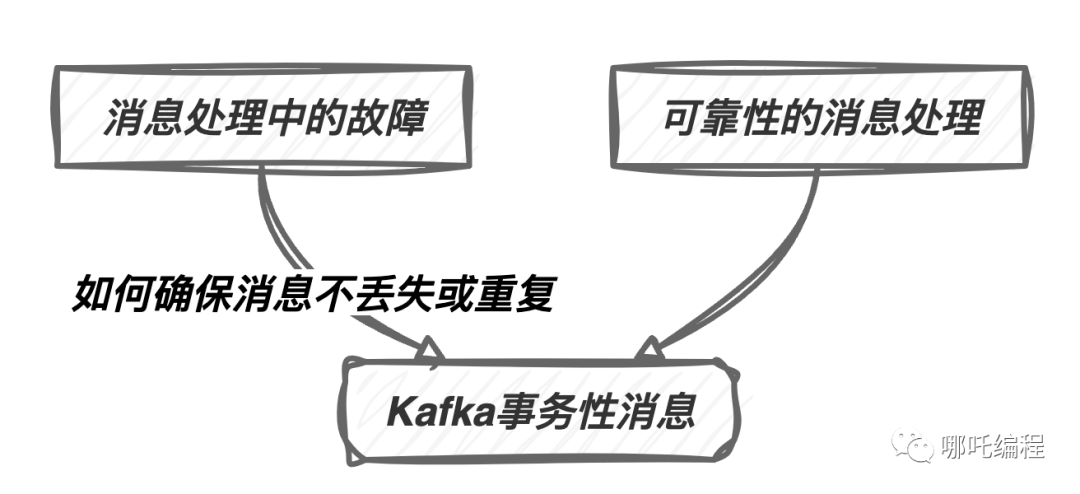

事務性消息對于確保數據一致性至關重要。在某些應用程序中,消息的完整性和可靠性至關重要。如果在消息處理期間發生故障,如何保證消息不會丟失或重復是一個復雜的問題。Kafka事務性消息提供了解決這些問題的方式,使得消息處理更加可控和可靠。

事務性消息的特性

Kafka事務性消息具有以下關鍵特性:

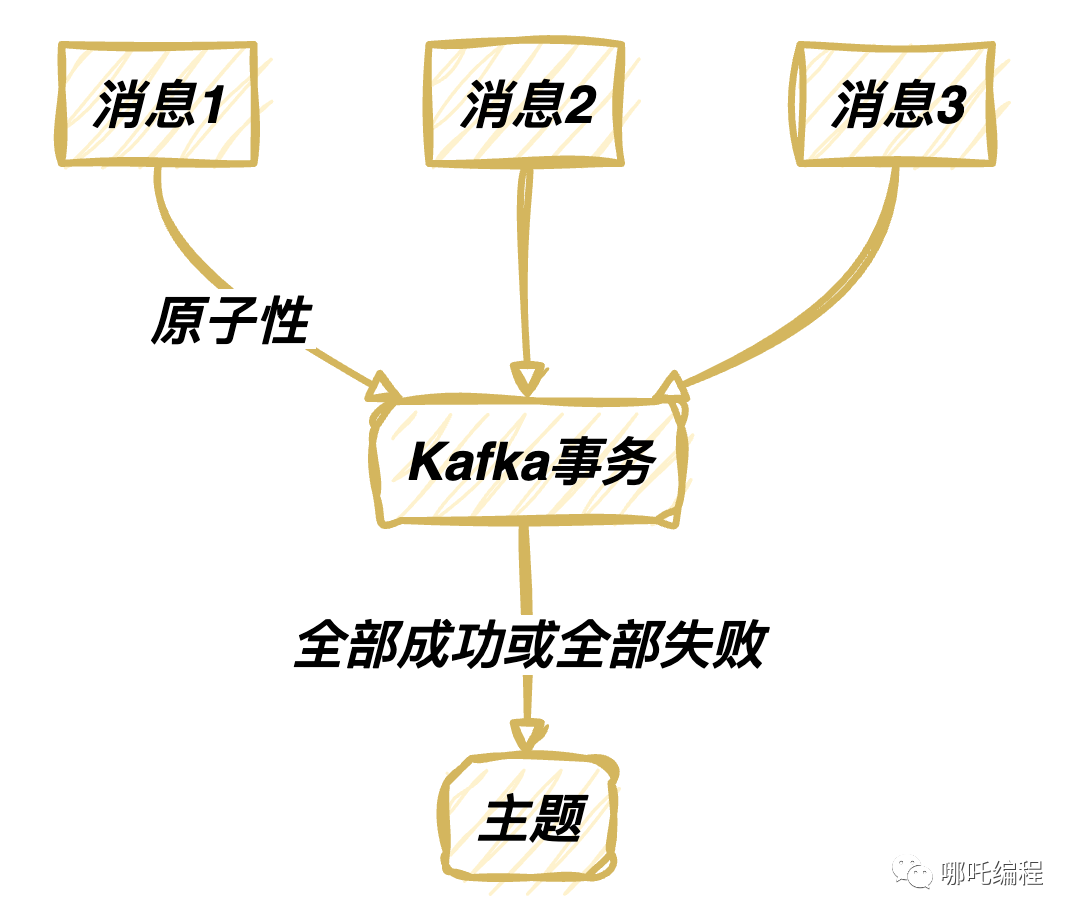

- 原子性:事務性消息要么完全成功,要么完全失敗。這確保了消息不會被部分處理。

- 可靠性:一旦消息被寫入Kafka,它們將被視為已經處理,即使發生了應用程序或系統故障。

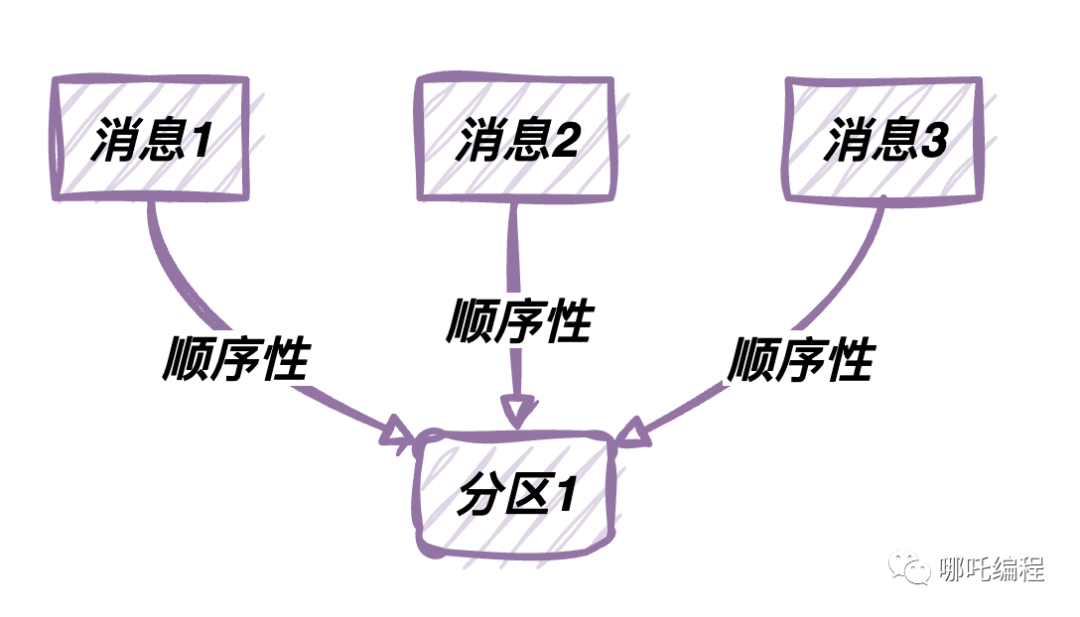

- 順序性:事務性消息在單個分區內保持順序。這對于需要按順序處理的應用程序至關重要。

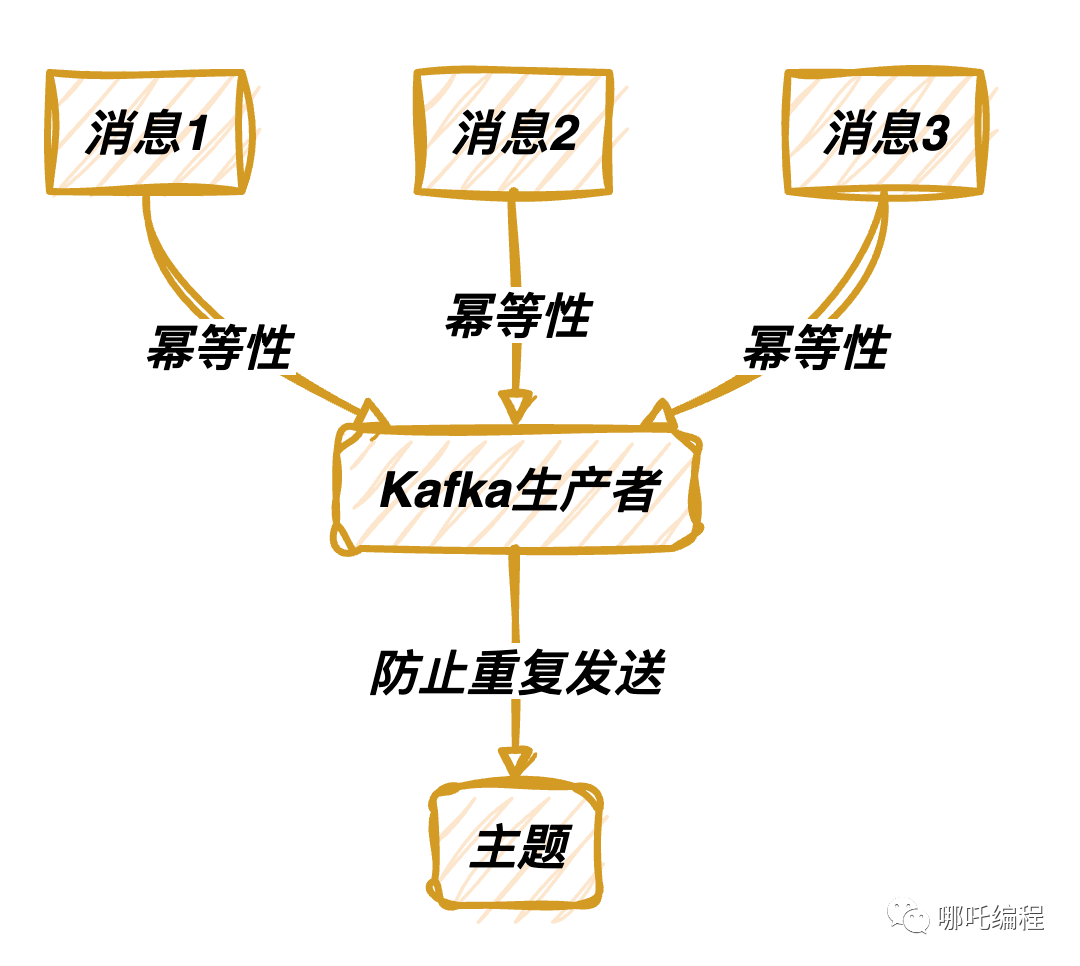

- 冪等性:Kafka生產者可以配置為冪等,確保相同的消息不會被重復發送。

- Exactly Once語義:事務性消息支持"僅一次"語義,即消息要么完全到達一次,要么不到達。

本節的目標是幫助您理解Kafka事務性消息的核心概念。接下來,我們將探討它們的應用場景以及相對于非事務性消息的優勢。

2、事務性消息的應用場景

事務性消息在多種應用場景中發揮著關鍵作用。以下是一些常見的應用場景,其中事務性消息特別有用:

金融交易處理:在金融領域,每筆交易都必須具備原子性,確保不發生不一致或重復的交易。事務性消息可用于記錄和處理金融交易,保證交易的完整性。

訂單處理:在電子商務平臺上,訂單處理必須是可靠的,以確保訂單的創建、支付和發貨不會出現問題。事務性消息可用于跟蹤和處理訂單的不同階段,從而確保訂單流程的一致性。

庫存管理:對于企業,庫存管理是至關重要的。事務性消息可用于跟蹤庫存的變化,以確保庫存的準確性和可靠性。

日志記錄:在大數據和日志記錄應用中,日志的完整性是至關重要的。事務性消息可用于確保日志的完整性,即使在日志處理集群發生故障時也能保持一致性。

系統通知:對于需要向用戶發送通知或提醒的應用程序,確保通知的可靠發送至關重要。事務性消息可用于實現這一目標。

3、Kafka事務性消息的優勢

相對于非事務性消息,Kafka事務性消息具有明顯的優勢,特別是在需要數據一致性的應用場景中。以下是Kafka事務性消息的優勢:

數據一致性:事務性消息可確保消息要么被完全處理,要么不被處理。這消除了數據處理中的不一致性,有助于維護數據一致性。

可靠性:一旦消息被寫入Kafka,它們將被視為已經處理,即使發生了應用程序或系統故障。這確保了消息的可靠傳遞。

冪等性:Kafka生產者可以配置為冪等,這意味著相同的消息不會被重復發送。這有助于減少不必要的消息傳遞,避免數據重復。

Exactly Once語義:事務性消息支持"僅一次"語義,即消息要么完全到達一次,要么不到達。這是某些應用程序所需的高級語義。

錯誤處理:事務性消息提供了一種處理錯誤的機制,以確保消息可以被恢復或重試,而不會丟失。

二、Kafka事務性消息的使用

在這一部分,我們將深入研究如何使用Kafka事務性消息來確保數據的一致性。

1、配置Kafka以支持事務性消息

配置Kafka以支持事務性消息對于確保消息在傳遞和處理過程中的一致性非常重要。在本節中,我們將詳細討論如何配置Kafka以支持事務性消息,包括生產者和消費者的設置。

生產者配置

在生產者端,需要進行一些特定的配置以啟用事務性消息。以下是一些關鍵的配置參數:

- acks:這是有關生產者接收到確認之后才認為消息發送成功的設置。對于事務性消息,通常將其設置為acks=all,以確保消息僅在事務完全提交后才被視為成功發送。

- transactional.id:這是用于標識生產者實例的唯一ID。在配置文件中設置transactional.id是啟用事務性消息的關鍵步驟。

- enable.idempotence:冪等性是指相同的消息不會被重復發送。對于事務性消息,通常將其設置為enable.idempotence=true,以確保消息不會重復發送。

配置示例:

acks=all

transactional.id=my-transactional-id

enable.idempotence=true消費者配置

- isolation.level:這是用于控制消費者的隔離級別的設置。對于事務性消息,通常將其設置為isolation.level=read_committed,以確保只讀取已經提交的事務消息。

- auto.offset.reset:這是消費者啟動時從哪里開始讀取消息的設置。通常將其設置為auto.offset.reset=earliest,以確保不會錯過任何已提交的消息。

配置示例:

isolation.level=read_committed

auto.offset.reset=earliest配置Kafka以支持事務性消息是確保消息可靠傳遞和處理的關鍵步驟。這些配置設置可以確保在生產和消費事務性消息時的正確行為。

2、生產者:發送事務性消息

在這一部分,我們將深入研究如何使用Kafka生產者來發送事務性消息。發送事務性消息是確保數據一致性的關鍵步驟,需要特別小心。以下是詳細的步驟和示例:

創建Kafka生產者

首先,我們需要創建一個 Kafka 生產者的實例。這個生產者實例將負責將消息發送到 Kafka 主題。創建生產者需要配置參數,包括 Kafka 集群的地址、消息的鍵和值的序列化器、事務ID 等。

下面是一個創建 Kafka 生產者的示例:

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerConfig;

import java.util.Properties;

public class MyKafkaProducer {

public static Producer<String, String> createProducer() {

Properties properties = new Properties();

properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");

properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

properties.put(ProducerConfig.TRANSACTIONAL_ID_CONFIG, "my-transactional-id");

return new KafkaProducer<>(properties);

}

}開始事務

在準備發送事務性消息之前,我們需要明確地開始一個事務。這通過調用 beginTransaction 方法來實現。一旦事務開始,所有后續的消息發送將包含在這個事務中。

producer.beginTransaction();發送消息

在事務內,我們可以開始發送消息。這些消息將被包含在事務中,只有在事務成功提交時才會真正寫入 Kafka 主題。

producer.send(new ProducerRecord<>("my-topic", "key1", "value1"));

producer.send(new ProducerRecord<>("my-topic", "key2", "value2"));提交或中止事務

事務性消息的一個關鍵特性是它們要么完全成功,要么完全失敗。因此,在消息發送后,我們需要根據消息的處理結果來決定是提交事務還是中止事務。這可以通過調用 commitTransaction 或 abortTransaction 方法來實現。

try {

producer.commitTransaction();

} catch (ProducerFencedException | OutOfOrderSequenceException | AuthorizationException e) {

// 處理異常,通常中止事務并重試

producer.close();

} catch (CommitFailedException e) {

// 事務提交失敗,通常中止事務并重試

producer.close();

}上述步驟提供了一個基本的示例,演示如何使用 Kafka 生產者發送事務性消息。事務性消息的發送確保了消息的可靠性和一致性,尤其在需要原子性保證的情況下非常有用。

3、消費者:處理事務性消息

在這一部分,我們將深入研究如何使用 Kafka 消費者來處理事務性消息。正確處理事務性消息對于保證數據一致性至關重要。以下是詳細的步驟和示例:

創建 Kafka 消費者

首先,我們需要創建一個 Kafka 消費者的實例。這個消費者實例將負責從 Kafka 主題中讀取消息。創建消費者需要配置參數,包括 Kafka 集群的地址、消息的鍵和值的反序列化器、消費者組 ID 等。

下面是一個創建 Kafka 消費者的示例:

import org.apache.kafka.clients.consumer.Consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.time.Duration;

import java.util.Collections;

import java.util.Properties;

public class MyKafkaConsumer {

public static Consumer<String, String> createConsumer() {

Properties properties = new Properties();

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "my-consumer-group");

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

return new KafkaConsumer<>(properties);

}

}訂閱主題

消費者需要明確地訂閱包含事務性消息的主題。這通過調用 subscribe 方法來實現。一旦訂閱,消費者將開始接收該主題上的消息。

consumer.subscribe(Collections.singletonList("my-topic"));處理消息

一旦事務性消息到達,消費者需要確保消息被正確處理。這通常涉及到處理消息的邏輯,確保數據的一致性。處理消息的邏輯將根據具體的應用和需求而異。

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

String key = record.key();

String value = record.value();

// 處理消息的邏輯

}提交位移

消費者需要負責提交消息的位移,以便正確跟蹤已處理的消息。這通過調用 commitSync 或 commitAsync 方法來實現。位移的提交確保了消息不會被重復處理。

consumer.commitSync();上述步驟提供了一個基本的示例,演示了如何使用 Kafka 消費者處理事務性消息。消費者的正確配置和消息處理確保了消息的可靠性和一致性。在實際應用中,處理消息的邏輯將更加復雜,以滿足特定的需求。

三、事務性消息的最佳實踐

在這一節,我們將提供一些關于如何使用Kafka事務性消息的最佳實踐。這包括如何確保消息的一次交付、監控和故障排查以及性能優化。

1、保障消息的一次交付

(1)生產者冪等性

確保生產者的冪等性是關鍵,以防止消息被重復發送。以下是一些關鍵策略和實踐,可用于確保生產者的冪等性:

- 分配唯一消息ID: 為每條消息分配一個唯一的消息ID。這可以是全局唯一的,也可以是特定于主題的唯一。在發送消息之前,生產者可以檢查已經發送的消息記錄,以確保當前消息的ID不重復。

- 使用冪等性API: Kafka 提供了冪等性的生產者 API。你可以在生產者配置中啟用冪等性,設置

enable.idempotence=true,以確保消息在發送時不會被重復處理。 - 實現自定義冪等性: 在一些情況下,自定義實現冪等性邏輯可能是必要的。這可以涉及到在消息處理端的數據庫或存儲中跟蹤已處理消息的狀態,以確保消息不會被重復處理。

- 設置適當的重試機制: 如果消息發送失敗,生產者應該具備適當的重試機制,以確保消息最終被成功發送。重試機制需要在生產者的配置中進行設置。

(2)消費者去重

保障消息不會被重復處理同樣至關重要。以下是一些策略和最佳實踐,可用于實現消費者的去重:

- 冪等性消息處理邏輯: 消費者的消息處理邏輯應該是冪等的。這意味著無論消息被處理多少次,其結果都應該是相同的。這通常需要在應用程序代碼中進行實施。

- 消息唯一標識: 為每條消息分配一個唯一的標識符,如消息ID。在處理消息前,消費者可以維護一個記錄已處理消息的數據結構,以確保消息不會被重復處理。

- 消費者去重過程: 消費者在處理消息前,可以查詢已處理消息的記錄,如果消息已存在于記錄中,可以選擇跳過處理或進行進一步處理。這可以防止消息的重復處理。

- 消費者庫支持: 一些消息隊列處理庫提供了內置的去重機制,你可以利用這些庫來簡化去重處理。

以上內容提供了詳細的策略和最佳實踐,以確保消息的一次交付。這是保障數據一致性的關鍵步驟,特別適用于事務性消息的處理。這些實踐可以根據具體的應用和需求進行定制化。

2、事務性消息的監控和故障排查

(1)監控工具

監控Kafka事務性消息是確保系統的可靠性的重要部分。以下是一些監控工具和策略:

- Kafka內置指標:Kafka提供了一組內置指標,用于監控事務性消息的性能和狀態。你可以使用這些指標來跟蹤消息的處理情況。

- 日志文件:Kafka的日志文件包含了詳細的事件信息,可以用于故障排查和性能分析。定期檢查日志文件,以查找潛在的問題。

- 監控系統:使用專業的監控系統,如Prometheus和Grafana,來建立實時監控和警報。這些系統可以幫助你及時發現問題并采取措施。

(2)故障排查

當事務性消息出現問題時,需要能夠排查和解決這些問題。以下是一些故障排查策略:

- 日志分析:定期分析Kafka的日志文件,查找異常和錯誤信息。這可以幫助你及早發現問題并采取措施。

- 監控警報:建立監控警報,以便在出現問題時立即收到通知。這有助于快速響應問題。

- 版本和配置管理:確保Kafka和應用程序的版本和配置得到正確管理。不同版本或配置的不一致可能導致問題。

3、事務性消息的性能考量

性能是任何消息系統的關鍵指標,特別是對于高吞吐量和低延遲的需求。以下是一些性能考量和優化策略:

- 生產者性能調整:通過調整生產者的配置參數,如batch.size、acks等,可以優化消息發送性能。

- 消費者性能調整:消費者的性能也可以通過配置參數,如max.poll.records、fetch.min.bytes等進行調整。

(2)吞吐量優化

- 分區和并

行度**:合理地選擇分區數量和消費者的并行度,以確保系統能夠處理大量事務性消息。

- 水平擴展:如果系統負載增加,考慮進行水平擴展,增加Kafka代理和消費者實例,以提高吞吐量。

- 網絡和存儲優化:確保網絡和存儲基礎設施足夠快,以支持高吞吐量的消息傳遞。

上述最佳實踐策略和性能優化建議可以幫助你更好地使用Kafka事務性消息,確保消息的可靠傳遞和一致性處理,同時滿足性能需求。通過仔細的配置、監控和故障排查,你可以建立一個可靠和高性能的消息處理系統。

四、示例:生產和消費Kafka事務性消息

在這一節,我們將提供兩個示例,詳細展示如何生產和消費Kafka事務性消息。

1、示例1:生產事務性消息

示例1代碼:生產者

import org.apache.kafka.clients.producer.*;

import java.util.Properties;

public class TransactionalProducerExample {

public static void main(String[] args) {

String bootstrapServers = "localhost:9092";

String topic = "my-transactional-topic";

Properties properties = new Properties();

properties.put("bootstrap.servers", bootstrapServers);

properties.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

properties.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

properties.put("acks", "all");

properties.put("enable.idempotence", "true");

properties.put("transactional.id", "my-transactional-id");

Producer<String, String> producer = new KafkaProducer<>(properties);

producer.initTransactions();

try {

producer.beginTransaction();

ProducerRecord<String, String> record = new ProducerRecord<>(topic, "key", "value");

producer.send(record);

producer.commitTransaction();

} catch (ProducerFencedException | OutOfOrderSequenceException | AuthorizationException e) {

// Fenced, sequence issue, or authorization exception

producer.close();

} catch (KafkaException e) {

// Handle other exceptions

producer.close();

}

producer.close();

}

}代碼說明:

- 這個示例演示了如何創建一個Kafka生產者,配置它以支持事務性消息,并生產一條事務性消息。

- transactional.id是一個用于標識生產者事務的唯一ID。它確保了事務性消息的一致性。

- 在try塊中,我們使用producer.beginTransaction()來啟動一個事務,然后發送一條消息,最后使用producer.commitTransaction()來提交事務。

- 如果在事務期間發生異常,我們在catch塊中處理異常并關閉生產者。

2、示例2:消費事務性消息

示例2代碼:消費者

import org.apache.kafka.clients.consumer.*;

import java.time.Duration;

import java.util.Collections;

import java.util.Properties;

public class TransactionalConsumerExample {

public static void main(String[] args) {

String bootstrapServers = "localhost:9092";

String groupId = "my-consumer-group";

String topic = "my-transactional-topic";

Properties properties = new Properties();

properties.put("bootstrap.servers", bootstrapServers);

properties.put("group.id", groupId);

properties.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

properties.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

Consumer<String, String> consumer = new KafkaConsumer<>(properties);

consumer.subscribe(Collections.singletonList(topic));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

System.out.printf("Consumed record with key %s and value %s%n", record.key(), record.value());

}

}

}

}代碼說明:

- 這個示例演示了如何創建一個Kafka消費者,訂閱一個主題,并消費事務性消息。

- 消費者將持續輪詢主題以獲取新的消息。

- 每當有新消息可用時,它將打印出消息的鍵和值。

五、總結

本文深入探討了Kafka事務性消息的關鍵概念、應用場景、優勢、配置、使用以及最佳實踐。在總結中,讓我們再次強調一些關鍵要點,并展望Kafka事務性消息的未來。

- Kafka事務性消息是一種機制,用于確保消息的可靠性傳遞和處理。它們提供了額外的保證,確保消息要么完全成功,要么完全失敗。

- 應用場景:Kafka事務性消息在金融交易、庫存管理、訂單處理等需要高可靠性和數據一致性的應用中發揮關鍵作用。

- 優勢:事務性消息相對于非事務性消息提供了更高的數據一致性和可靠性,支持原子性、冪等性和"僅一次"語義。

- 配置:配置Kafka以支持事務性消息包括生產者和消費者的設置,如

transactional.id、enable.idempotence等。 - 生產事務性消息:使用Kafka生產者,需要初始化事務、發送消息,然后提交或中止事務,以確保消息的一致性。

- 消費事務性消息:使用Kafka消費者,需要訂閱主題并持續輪詢以獲取消息,然后確保消息被正確處理。

- 最佳實踐:最佳實踐包括保障消息的一次交付、監控和故障排查以及性能考量,以確保系統的穩定性和高性能。