阿里又整活兒:一張人臉一句話就能跳《擦玻璃》,服裝背景隨意換!

繼AnimateAnyone之后,阿里又一項“舞蹈整活兒”論文火了——

這一次,只需一張臉部照片、一句話描述,就能讓你在任何地方跳舞!

例如下面這段《擦玻璃》的舞蹈視頻:

圖片

圖片

你所需要做的就是“投喂”一張人像,以及一段prompt:

一個女孩,微笑著,在秋天的金色樹葉中跳舞,穿著淺藍色的連衣裙。

而且隨著prompt的變化,人物背景和身上的衣服也會隨之發生改變。例如我們再換兩句:

一個女孩,微笑著,在木屋里跳舞,穿著毛衣和長褲。

一個女孩,微笑著,在時代廣場跳舞,穿著連衣裙般的白襯衫,長袖,長褲。

圖片

圖片

這便是阿里最新的一項研究——DreaMoving,主打的就是讓任何人、隨時且隨地地跳舞。

圖片

圖片

而且不僅是真人,就連卡通動漫人物也都是可以hold住的哦~

圖片

圖片

項目一出,也是引發了不少網友的關注,有人在看過效果之后直呼“Unbelievable”~

圖片

圖片

那么如此效果,這項研究又是如何做到的呢?

背后原理

雖然像Stable Video Diffusion和Gen2等文本到視頻(text-to-video,T2V)模型的出現,在視頻生成方面取得了突破性進展,但現在仍然有諸多挑戰需要面對。

例如在數據集方面,目前缺乏開源的人類舞蹈視頻數據集以及難以獲得相應的精確文本描述,這就使得讓模型們去生成多樣性、幀一致性、時長更長的視頻成為挑戰。

并且在以人為中心的內容生成領域,生成結果的個性化和可控性也是關鍵因素。

圖片

圖片

面對這兩大難點,阿里團隊先從數據集著手做處理。

研究者們首先從互聯網收集了大約1000個高質量的人類舞蹈視頻。然后,他們將這些視頻分割成大約6000個短視頻(每個視頻8至10秒),以確保視頻片段中沒有轉場和特殊效果,這樣有利于時間模塊的訓練。

此外,為了生成視頻的文本描述,他們使用了Minigpt-v2作為視頻字幕器(video captioner),特別采用了“grounding”版本,指令是詳細描述這個幀。

基于關鍵幀中心幀生成的字幕代表了整個視頻片段的描述,主要是準確描述主題和背景內容。

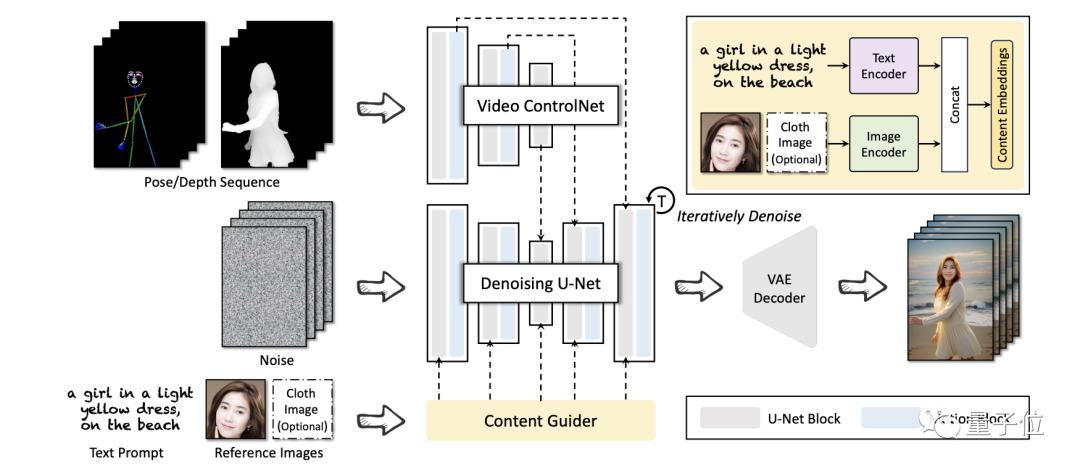

在框架方面,阿里團隊則是提出了一個名叫DreaMoving、基于Stable Diffusion的模型。

它主要由三個神經網絡來構成,包括去噪U-Net(Denoising U-Net)、視頻控制網絡(Video ControlNet)和內容引導器(Content Guider)。

圖片

圖片

其中,Video ControlNet是在每U-Net塊之后注入運動塊(Motion Block)的圖像控制網絡,將控制序列(姿態或深度)處理為額外的時間殘差。

Denoising U-Net是一種衍生的Stable-Diffusion U-Net,帶有用于視頻生成的運動塊。

而Content Guider則是將輸入文本提示和外觀表情(如人臉)傳輸到內容嵌入中。

在如此操作之下,DreaMoving便可以在給定引導序列和簡單的內容描述(如文本和參考圖像)作為輸入的情況下生成高質量、高保真度的視頻。

圖片

圖片

不過很可惜的一點是,目前DreaMoving項目并沒有開源代碼。

感興趣的小伙伴可以先關注一波,坐等代碼開源了~

參考鏈接:[1]https://dreamoving.github.io/dreamoving/[2]https://arxiv.org/abs/2312.05107[3]https://twitter.com/ProperPrompter/status/1734192772465258499[4]https://github.com/dreamoving/dreamoving-project