2023時(shí)間序列預(yù)測熱門研究點(diǎn)總結(jié)

這篇文章給大家總結(jié)一下2023年中,時(shí)間序列預(yù)測領(lǐng)域的幾個(gè)熱門研究點(diǎn)。通過這些研究點(diǎn),我們可以挖掘時(shí)間序列預(yù)測領(lǐng)域的研究中,業(yè)內(nèi)在朝什么樣的方向發(fā)展,啟發(fā)我們在自己的工作中尋找合適的創(chuàng)新點(diǎn)。

總結(jié)下來,2023年有幾個(gè)非常熱的點(diǎn),在很多論文中被提起。主要包括以下幾個(gè):

- 多元序列預(yù)測中變量的獨(dú)立、聯(lián)合建模;

- 大模型+時(shí)間序列;

- 多粒度時(shí)間序列建模

PatchTST框架的后續(xù)改進(jìn)方法

1、獨(dú)立/聯(lián)合建模

多元時(shí)間序列預(yù)測問題中,從多變量建模方法的維度有兩種類型,一種是獨(dú)立預(yù)測(channel independent,CI),指的是把多元序列當(dāng)成多個(gè)單變量預(yù)測,每個(gè)變量分別建模;另一種是聯(lián)合預(yù)測(channel dependent,CD),指的是多變量一起建模,考慮各個(gè)變量之間的關(guān)系。

CI方法只考慮單個(gè)變量,模型更簡單,但是天花板也較低,因?yàn)闆]有考慮各個(gè)序列之間的關(guān)系,損失了一部分關(guān)鍵信息;而CD方法考慮的信息更全面,但是模型也更加復(fù)雜。

圖片

圖片

在最初的多元時(shí)間序列模型中,大家沒有特別關(guān)注這個(gè)問題,都是把各個(gè)變量直接雜糅到一起輸入到模型中。PatchTST提取每個(gè)變量獨(dú)立的建模,完全抹掉各個(gè)變量之間的關(guān)系,并且取得了比多變量融合更優(yōu)的效果。這也開啟了2023年對獨(dú)立預(yù)測、聯(lián)合預(yù)測的探討。文章主要圍繞著聯(lián)合預(yù)測有什么弊端,以及如何改進(jìn)展開。

比如The Capacity and Robustness Trade-off: Revisiting the Channel Independent Strategy for Multivariate Time Series Forecasting這篇文章分析出大多數(shù)任務(wù)上獨(dú)立建模效果更好,是由于聯(lián)合建模太過復(fù)雜,更容易出現(xiàn)過擬合問題,對時(shí)間序列分布變化的魯棒性差。

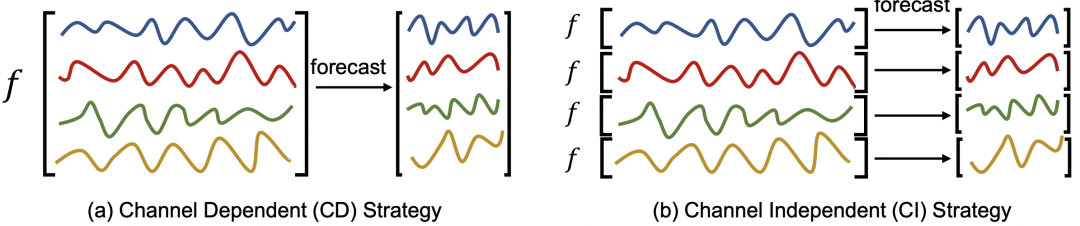

而CROSSFORMER: TRANSFORMER UTILIZING CROSSDIMENSION DEPENDENCY FOR MULTIVARIATE TIME SERIES FORECASTING等一系列文章則沒有放棄聯(lián)合建模,對聯(lián)合建模進(jìn)一步深入優(yōu)化,通過更精細(xì)化的多變量關(guān)系學(xué)習(xí),以及將時(shí)間維度預(yù)測和多變量間關(guān)系預(yù)測拆分成互不干擾的兩個(gè)模塊,提升多變量聯(lián)合建模的魯棒性。

圖片

圖片

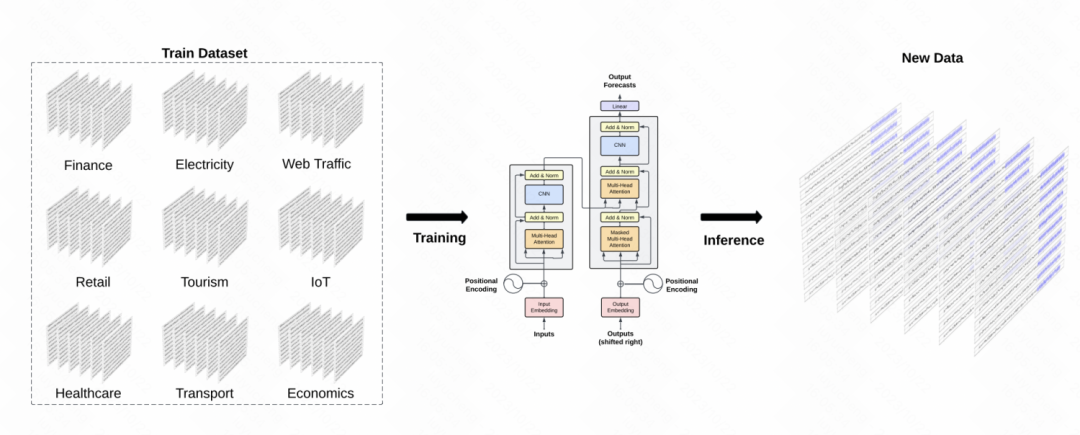

2、大模型+時(shí)間序列

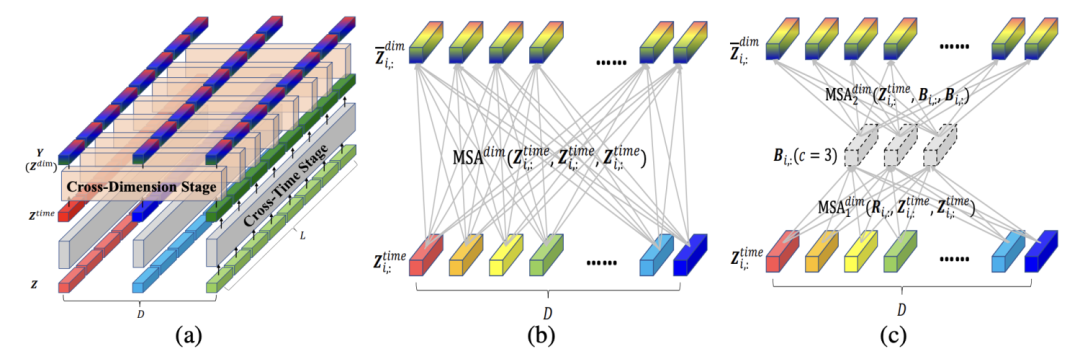

在大模型的浪潮下,2023年涌現(xiàn)了一大批大模型+時(shí)間序列的工作。這篇文章為大家整理了2023年大模型時(shí)間序列模型的相關(guān)工作。大模型應(yīng)用到時(shí)間序列,有2種應(yīng)用類型。一種是將其他領(lǐng)域訓(xùn)練好的大模型,通過跨域自適應(yīng)的方式,遷移到時(shí)間序列領(lǐng)域;另一種是使用時(shí)間序列域內(nèi)本身的數(shù)據(jù),從頭開始訓(xùn)練一個(gè)時(shí)間序列大模型,解決各類任務(wù)。

比如Large Language Models Are Zero-Shot Time Series Forecasters、TIME-LLM: TIME SERIES FORECASTING BY REPROGRAMMING LARGE LANGUAGE MODELS等文章,就是將NLP領(lǐng)域的預(yù)訓(xùn)練GPT適配到時(shí)間序列領(lǐng)域。適配方法,也從最初簡單的將時(shí)間序列數(shù)據(jù)轉(zhuǎn)換成適配語言模型的輸入,到在模型中引入Adaptor的方式逐漸發(fā)展。

圖片

圖片

而Lag-Llama: Towards Foundation Models for Time Series Forecasting、TimeGPT-1等文章,則是直接使用時(shí)間序列領(lǐng)域的數(shù)據(jù),訓(xùn)練時(shí)間序列大模型,模型結(jié)構(gòu)則和NLP中的GPT、Llama等保持一致,只做少量時(shí)間序列領(lǐng)域的適配。

圖片

圖片

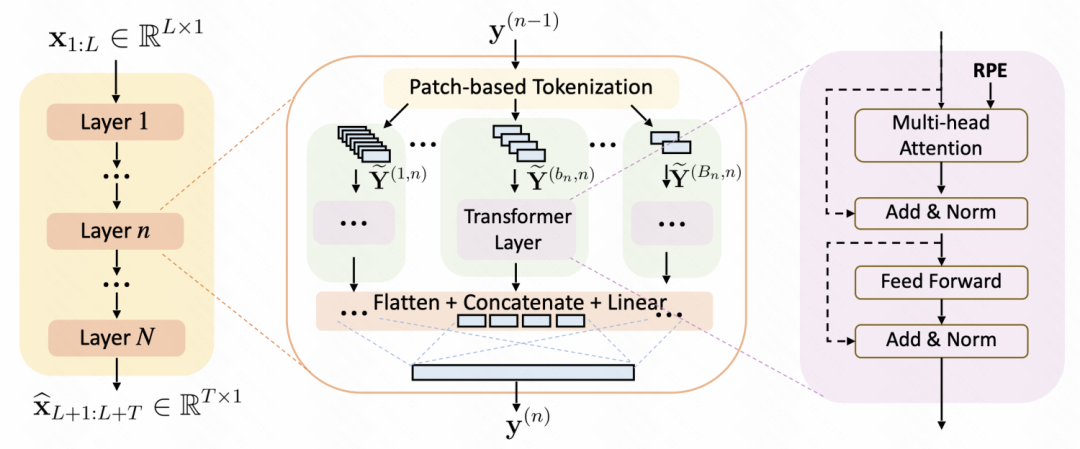

3、多粒度建模

使用patch進(jìn)行時(shí)間序列數(shù)據(jù)處理+Transformer模型結(jié)構(gòu)的方式逐漸成為時(shí)間序列預(yù)測的主流模型。然而,之前的很多工作,都使用一個(gè)固定的時(shí)間窗口進(jìn)行patch處理,降低了模型對于不同scale規(guī)律性的捕捉。這也衍生出一個(gè)研究點(diǎn):如何設(shè)計(jì)多粒度的patch方法,增強(qiáng)patch+Transformer的建模能力。

A Multi-Scale Decomposition MLP-Mixer for Time Series Analysis、Multi-resolution Time-Series Transformer for Long-term Forecasting等工作中,都提出了非常多多粒度建模的方式。這些建模方法引入了一個(gè)信息增益,就是時(shí)間序列具有不同粒度的季節(jié)性,一種粒度難以刻畫,并且patch窗口的大小也不好設(shè)置。那就不如設(shè)置多種patch窗口大小,然后再用一個(gè)可學(xué)習(xí)的融合網(wǎng)絡(luò),將這些不同粒度的信息融合到一起。

圖片

圖片

這種多粒度建模的方法,后續(xù)也逐漸會(huì)成為Transformer時(shí)間序列建模方法的標(biāo)配。

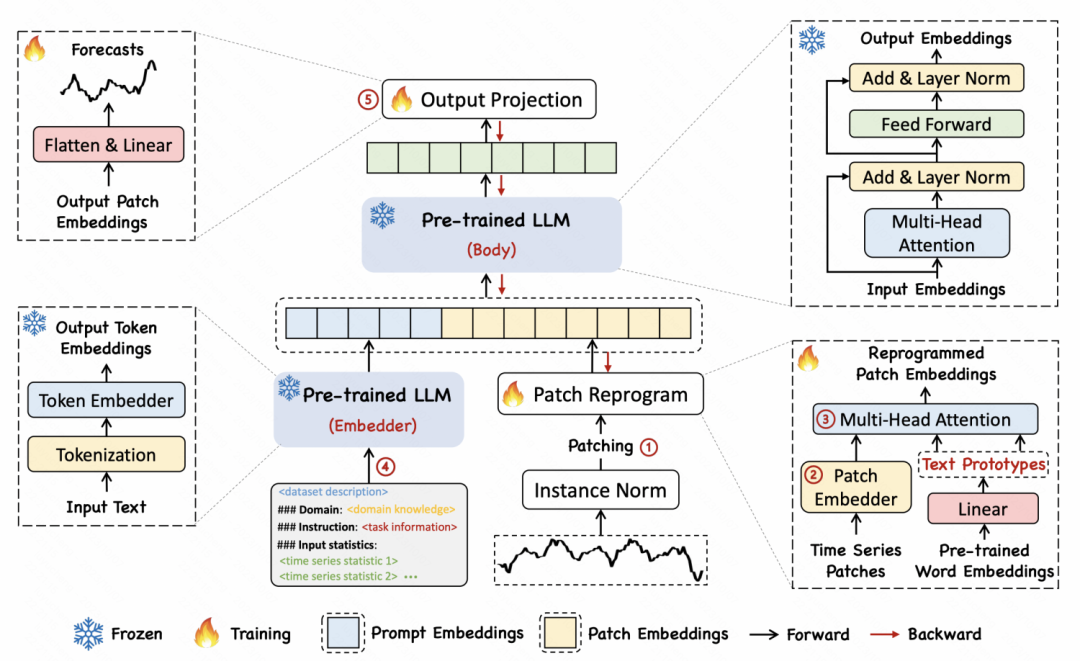

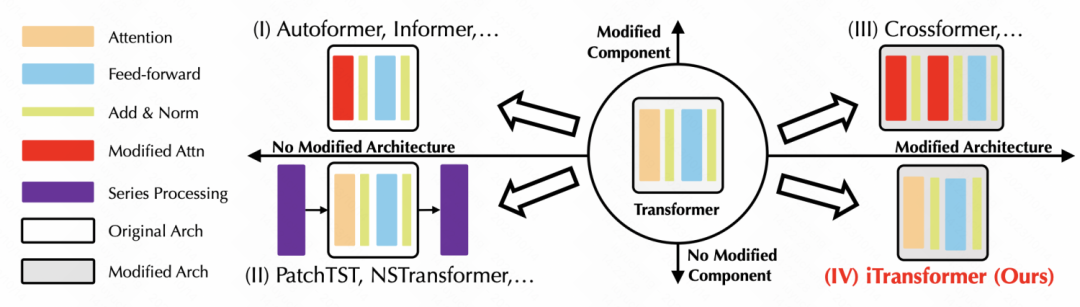

4、PatchTST框架改進(jìn)

基于Patch+Transformer的時(shí)間序列預(yù)測模型在2022年成為主流,自然在2023年引入了一系列改進(jìn),包括輸入數(shù)據(jù)的組織形式、模型結(jié)構(gòu)、頻域等其他維度信息引入等多個(gè)方面。

像ITRANSFORMER: INVERTED TRANSFORMERS ARE EFFECTIVE FOR TIME SERIES FORECASTING這篇文章,將Transformer直接做了個(gè)反向操作,將原來在時(shí)間維度上構(gòu)建token embedding,改成了序列維度構(gòu)建token embedding,并利用attention學(xué)習(xí)各個(gè)變量序列之間的關(guān)系。非常簡單的一個(gè)代碼實(shí)現(xiàn),就提升了Transformer在時(shí)間序列預(yù)測上的效果。

圖片

圖片

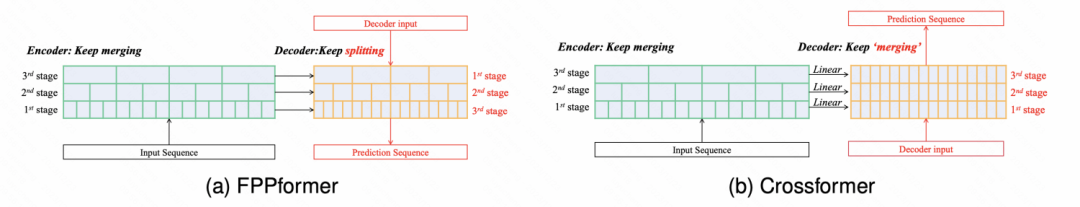

而Take an Irregular Route: Enhance the Decoder of Time-Series Forecasting Transformer中,則是通過對Decoder的改進(jìn),使Transformer具備了層次信息融合的能力,從多個(gè)粒度利用Encoder各個(gè)編碼階段的信息,提升Transformer的時(shí)序預(yù)測效果。

圖片

圖片

5、總結(jié)

2023年的時(shí)間序列領(lǐng)域的技術(shù)發(fā)展,除了上述一些研究點(diǎn)外,還有非常多其他的創(chuàng)新,整體感覺是越來越和NLP、CV等主流深度學(xué)習(xí)領(lǐng)域的研究融為一體了,這對于時(shí)間序列的發(fā)展也是極大的利好。為了更多的CV、NLP中成功的經(jīng)驗(yàn),都可以在時(shí)間序列中進(jìn)行適配和應(yīng)用。