五分鐘本地部署史上最強開源大模型Llama3

幾天前meta發布了史上最強開源大模型Llama3,要想免費使用Llama3,除了去官網 https://llama.meta.com/llama3/ 在線使用外,還可以本地部署。

本地部署有多種方式,常見的有如下3種方式:

1. github倉庫clone后,https://github.com/meta-llama/llama3 安裝python,pip相關的包,官網在線填寫個人信息申請模型下載鏈接

2. LL-studio

3. ollama

其中以ollama部署最為便捷和友好,部署時間可在5分鐘內完成。本篇就介紹ollama本地部署llama3模型。

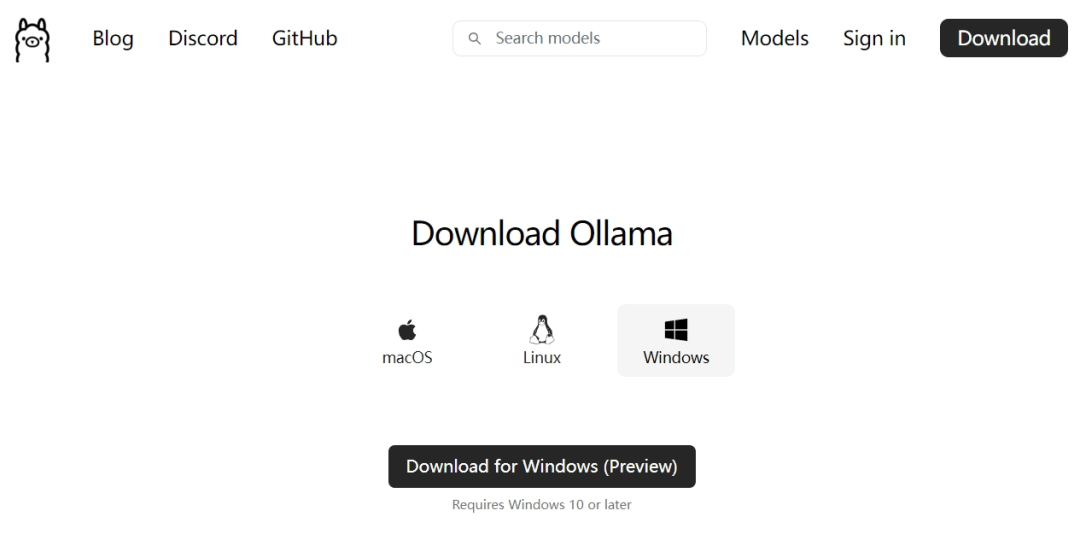

step1:ollama官網(https://ollama.com/download)下載ollama,有mac,windows,linux三個版本,選擇適合自己機器的版本下載并安裝。

圖片

圖片

step2:命令行執行ollama run llama3 (默認是下載8b的模型,若要下載40b的,執行 ollama run llama3:70b)

圖片

圖片

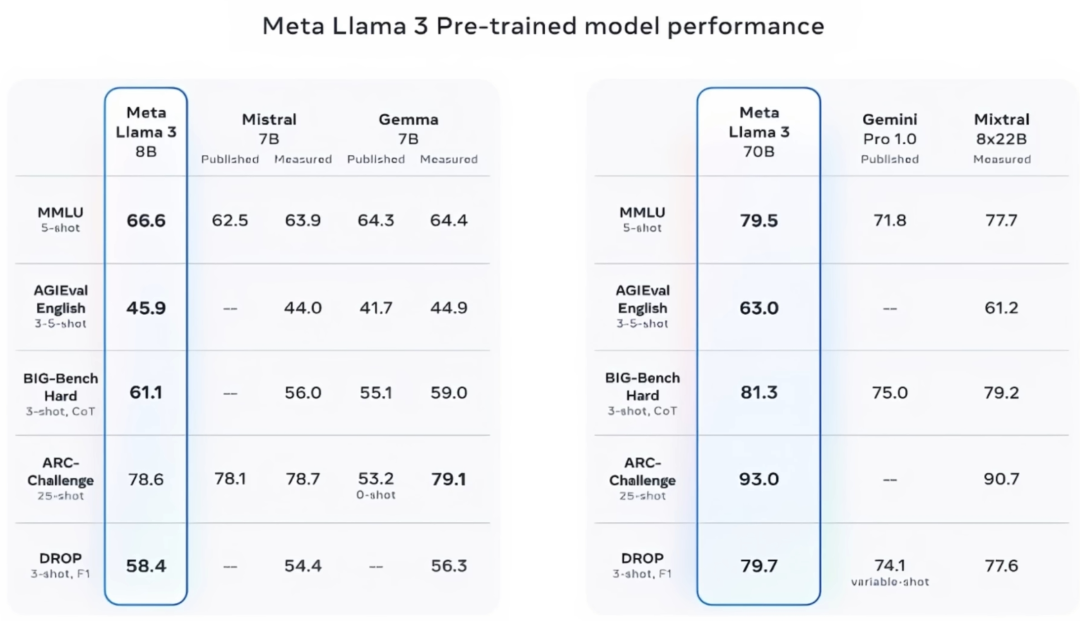

Llama3的最小版本8B和70B已經全面領先其他競爭對手的開源大模型。其中70B的模型相當于GPT-4的水平,其中8B和70B都可以在個人PC上跑起來,8B就是80億參數的模型只需要8G+的顯存就可以流暢跑起來,70B就是700億參數的模型雖然宣稱需要40G+的顯存,經測試在個人電腦的16G的顯存上也可以跑起來,就是吐字速度慢些。

模型下載完成后就進入命令行交互界面,這時候就可以和llama3聊天了。

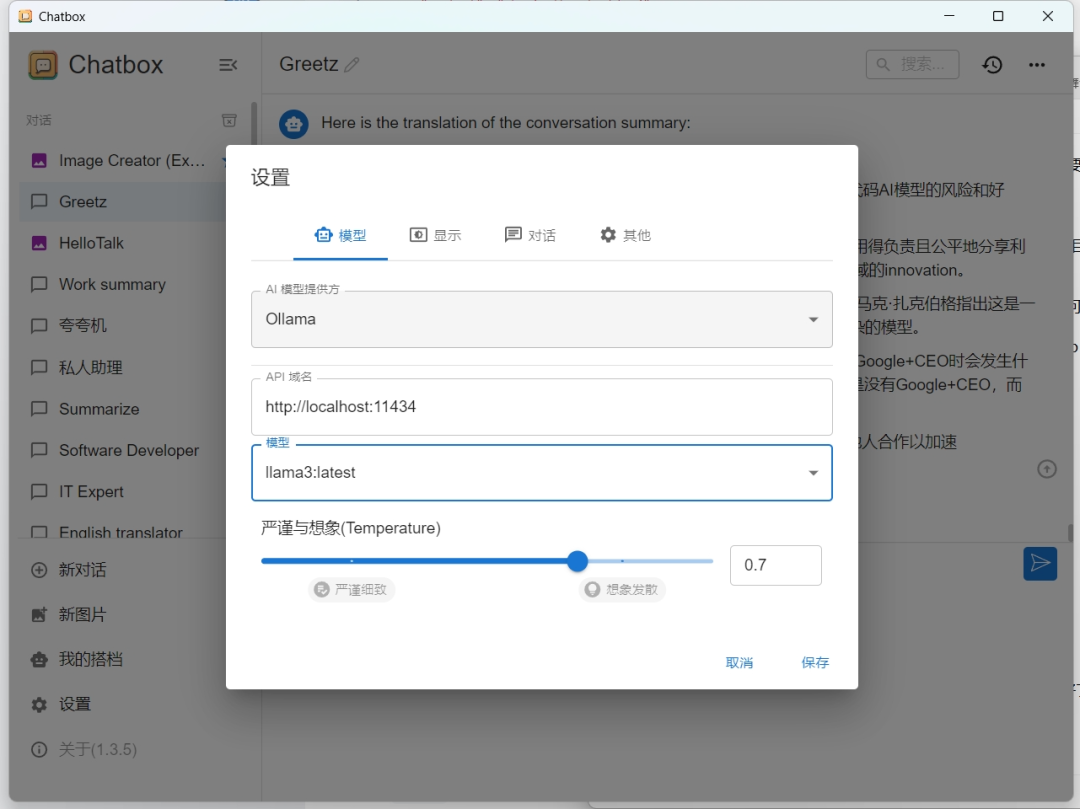

step3(可選):命令行交互畢竟沒有圖形化界面友好,可以任選一個界面。目前市面上的界面多如牛毛,這里以開源軟件chatbox為例,https://github.com/Bin-Huang/chatbox/releases

下載安裝后,進入設置,配置使用本地ollama的llama3模型,之后就可以愉快的聊天了。

圖片

圖片

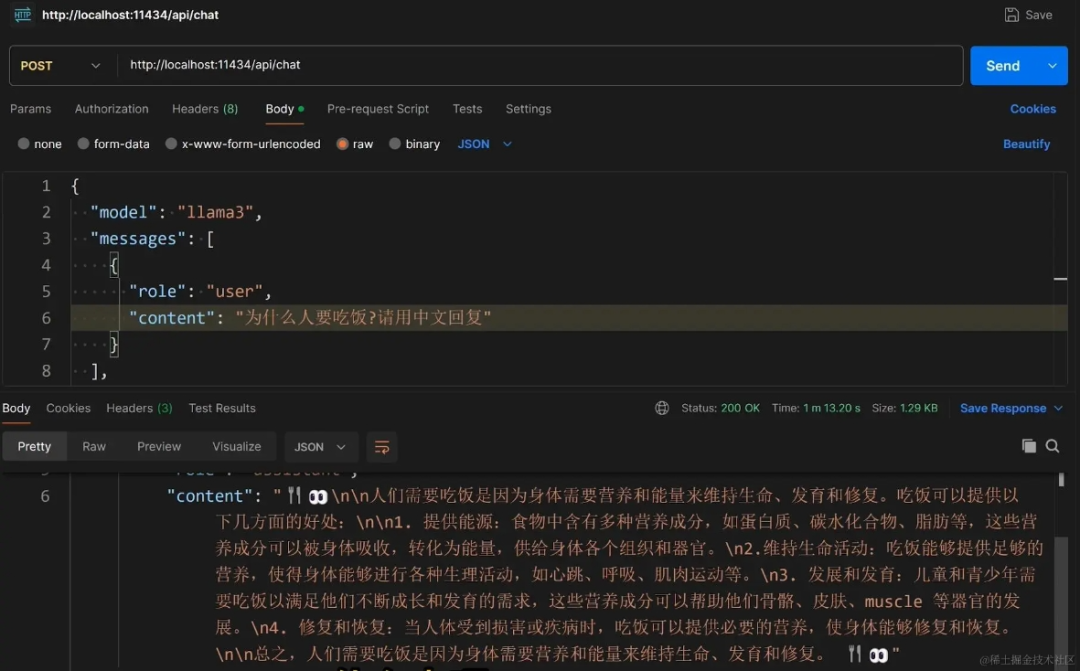

除了通過圖形化界面和Llama3聊天外,還可以自己編程調用Llama3 的rest api,自動化讓AI完成很多本地工作。

調用llama3 rest api,參考官網說明:https://github.com/ollama/ollama/blob/main/docs/api.md

curl http://localhost:11434/api/chat -d '{

"model": "llama3",

"messages": [

{

"role": "user",

"content": "why is the sky blue?"

}

],

"stream": false

}'