「大模型」之所短,「知識圖譜」之所長

最近一年以來,大語言模型技術突飛猛進,被廣泛地認為開啟了人工智能研究的新階段。大語言模型時代的到來,給知識圖譜技術也帶來了新的機遇與挑戰。我們在 5 月份的時候曾經發布過知識圖譜與 AIGC 大模型的知識地圖,其中包括了文本生成、圖像生成等技術。本次分享將聚焦于大語言模型最新的研究進展,從大模型對知識工程的幫助、知識圖譜幫助大模型的評測和應用,以及未來知識圖譜與大模型交互融合的展望等幾個方面進行介紹。

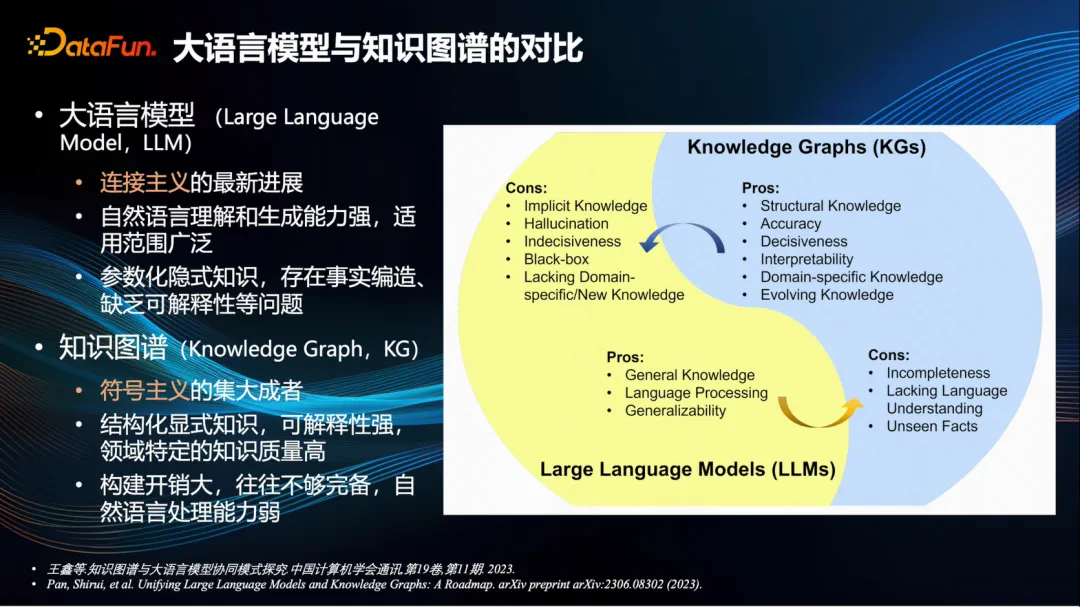

一、大語言模型與知識圖譜的對比

首先來對比一下大語言模型和知識圖譜的優勢與劣勢。

去年 ChatGPT 問世的初期,還曾有聲音說知識圖譜已經過時了,將被大模型所替代。然而,隨著這一年來的深入探討和研究,目前業界普遍認為,大語言模型和知識圖譜各有所長,能夠互相補充[1,2]。

具體而言,基于深度神經網絡技術的大語言模型是連接主義的最新里程碑,其優勢在于對自然語言的理解和生成能力極強,適用范圍廣泛。而缺點則是其中的知識是參數化的隱式知識,存在事實的編造,缺乏可解釋性等問題。也就是我們常說的大模型生成內容存在幻覺的現象。

知識圖譜是符號主義的集大成者,過去十幾年來受到了廣泛的研究與應用。它的優點是知識結構化、顯式化,可解釋性非常強,特別是在某些特定領域,知識質量極高。當然,缺點也很明顯,那就是構建成本太高,往往不完全正確,在自然語言處理方面相對較差。

那么二者應該如何相結合進行優勢互補呢?接下來將從不同角度來分析二者的相互作用。

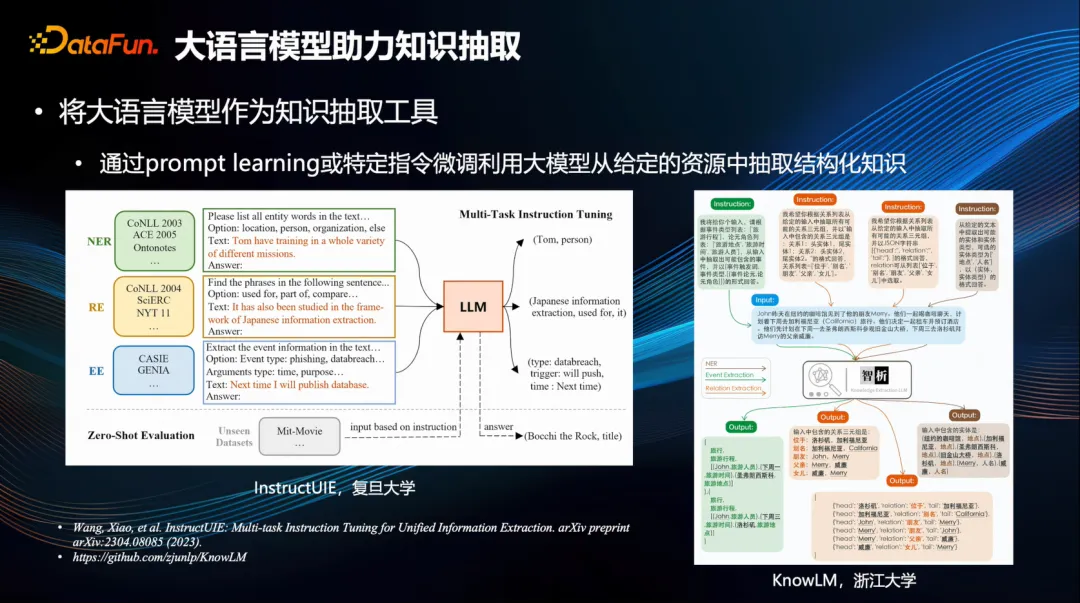

二、大語言模型助力知識抽取

首先,大模型強大的語言理解能力可以助力知識抽取任務。

典型的例子像復旦大學的 InstructUIE[3]和浙江大學的 KnowLM[4]。用特定指令,調動大模型從給定資源里提取出有用的知識,完成各種各樣的任務,比如實體提取、關系抽取、事件抽取等。當然,也可以針對這些指令做專門的 SFT(深度特征提取)微調,這樣可以增強優化效果。換句話說,只要通過這些指令,就能在給定內容里輕松完成實體、關系等各種提取任務。

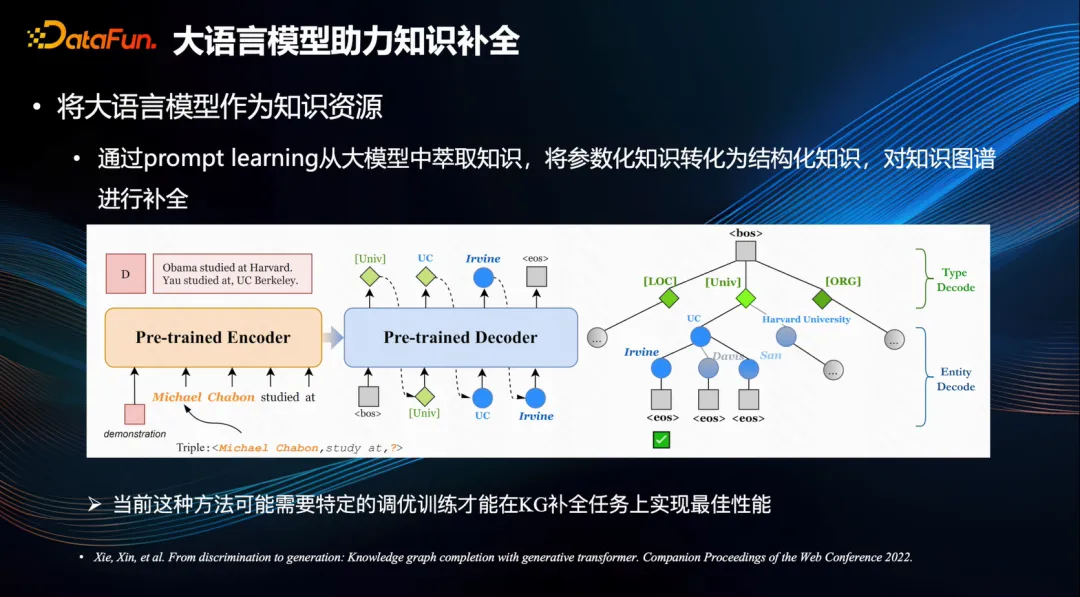

三、大語言模型助力知識補全

還有一些工作是通過特定的指令,將大型模型中的參數化知識提煉出來,從而構建成結構化的知識,以便于對知識圖譜進行補全[5]。

由于大型模型在訓練過程中已經接觸了大量的文本數據,其中蘊含著豐富的客觀知識,因此如果能夠精確地萃取出來,將會極大提升知識圖譜中的完備性。然而,鑒于當前大型模型生成的內容可能會出現幻覺問題,因此當前方法需要采用特定的調優訓練進行約束才能實現,而這一領域尚有相當巨大的研究空間。

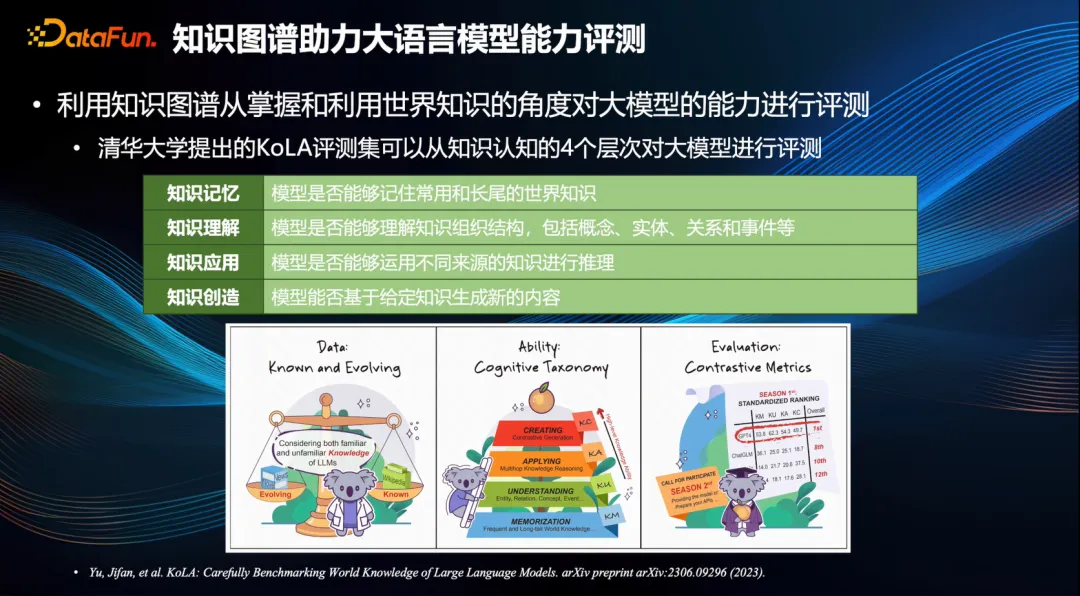

四、知識圖譜助力大語言模型能力評測

反過來知識圖譜也可以幫助到大模型。

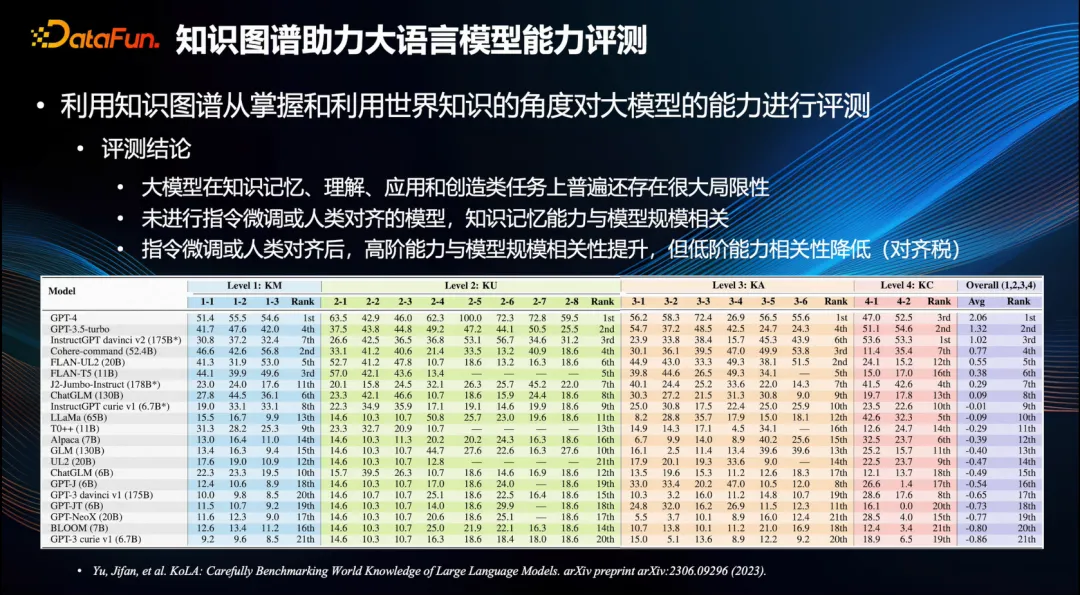

1. 評測集

知識圖譜對大模型的評測具有顯著的助力,從掌握和利用世界知識的角度對大模型的能力進行全面的評測,典型的代表是清華大學提出的 KoLA 評測集[6],該評測集針對知識認知的四個層次,即知識記憶、知識理解、知識應用和知識創新,對大模型進行全面測試。

2. 評測結論

從目前的測試結果來看,有幾點頗具趣味性的結論值得關注。首先,大模型在知識記憶、理解、應用和創新等任務中普遍存在較大的局限性。其次,對于未經指令微調且與人無關的模型來說,其在知識記憶方面的能力與模型規模呈正相關關系,也即是模型的參數越多,則其知識記憶能力越強。然而,經過指令微調與人類對齊后,其高階能力,如知識的應用和創新等能力與模型呈正向相關,但低級能力,例如記憶、理解等能力,則與其呈負相關關系,這便是所謂的“對齊稅”,這一發現極為重要[6]。

五、知識圖譜助力大語言模型落地應用

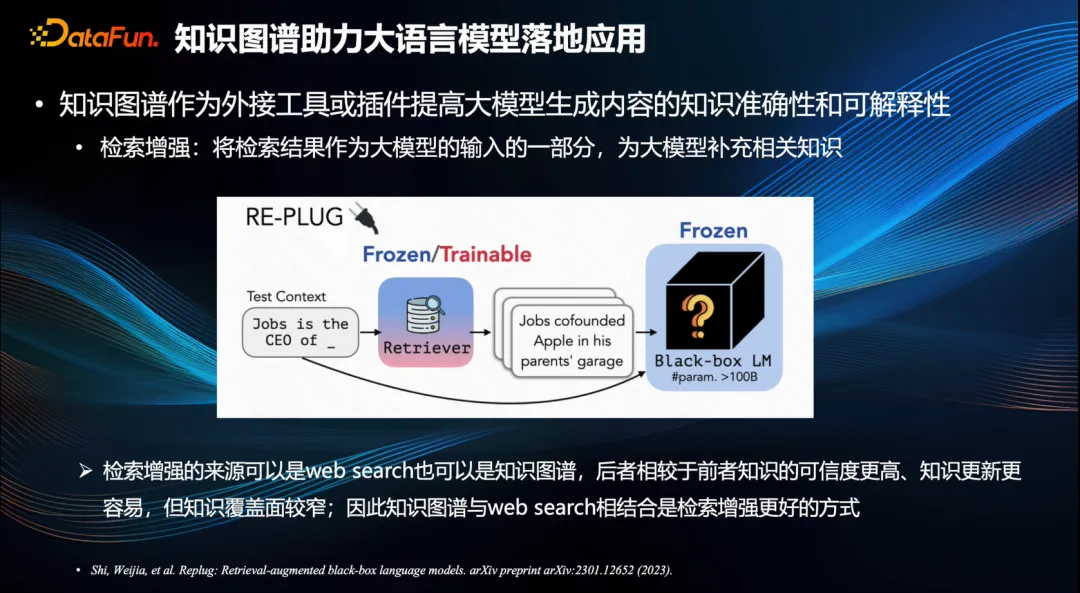

1. 知識圖譜作為外接工具或插件提高大模型生成內容的知識準確性和可解釋性

知識圖譜輔助大語言模型的另一個方面是可以幫助大模型的落地應用。大模型的幻覺問題是阻礙落地應用的重要因素之一。大家正在考慮采用開啟增強模式[7]以引導并制約大模型所產出的內容。這意味著設定與用戶問題相關的一些內容輸入為大模型參考信息,用以緩解一本正經胡說八道現象的情況,從而提升知識的精確性與可解釋性。

知識圖譜作為高質量的知識來源,為開啟增強模式奠定了基礎。相對于 Web 搜索來說,知識圖譜所承載的信息可信度更高,且知識更新過程中更易于發現錯誤,極易進行精準修正。然而,知識圖譜也存在一定局限性,例如其覆蓋范圍相對較窄,尤其針對一些長尾知識、復雜知識則更易產生遺漏。因此知識圖譜與 Web 搜索相結合,是知識檢索增強的良策。

事實上,Google 提出知識圖譜的初衷便是為了提升其搜索引擎的性能。

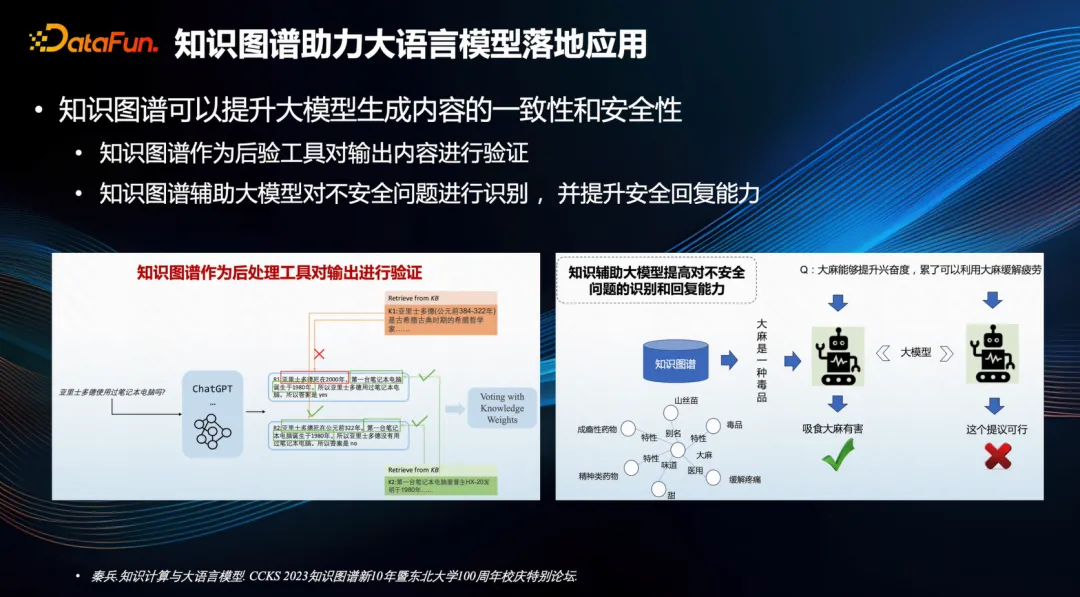

2. 知識圖譜可以提升大模型生成內容的安全性和一致性

知識圖譜還有助于提高大模型生成內容的安全性和一致性。

例如,哈爾濱工業大學就提出了兩種方案,第一種是運用知識圖譜作為后驗工具,對輸出內容進行核實,從而增強其一致性。例如,在左邊的例子中,“亞里士多德使用筆記本電腦嗎?”,ChatGPT 有可能生成出與此相關的內容,如第一條內容為“亞里士多德死于 2000 年”,但這個知識卻與知識圖譜中的亞里士多德的生卒年代相悖,于是便產生了沖突,通過這樣的驗證,能夠發現一些錯誤的知識,進而篩選出更符合客觀事實的回答進行輸出。

其次,知識圖譜能協助大模型辨識不安全問題,同時增強應對不安全場景的能力。在右邊的例子中,用戶可能會提問到一些涉及違法違規行為的問題。大模型可以利用知識圖譜甄別其中的敏感知識以及相關內容,進而生成更為可靠的答復。

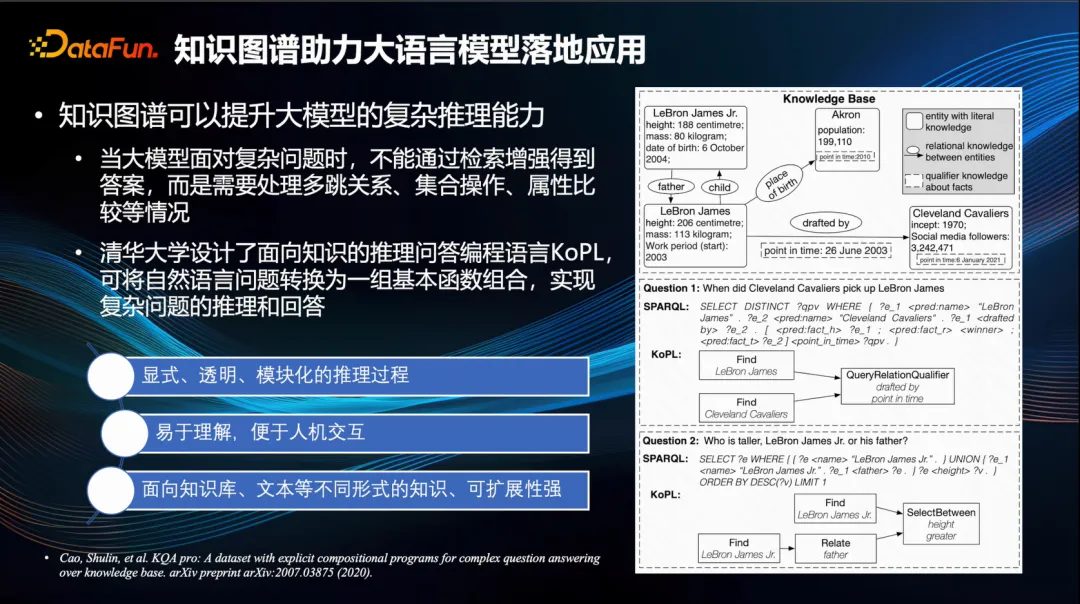

3. 知識圖譜可以提升大模型的復雜推理能力

知識圖譜亦能提升大規模模型的復雜推理能力。

當面對復雜問題時,大模型無法直接從檢索增強中獲取答案,而需通過多跳的關系集合操作屬性的比對等環節來尋找問題答案,此時便需要進行精準的推理。

清華大學研發了一款專為知識推理問答而設的編程語言——KoPL[8],該語言能夠將自然語言轉化為基本函數的組合,從而針對復雜問題進行推理和解答。例如,觀察右側例子,問:勒伯納·詹姆斯和他的父親誰的身高更高?這個問題便會被分解為一些基礎函數,如查找勒布朗·詹姆斯的身高、查詢其父親信息,然后找到他父親的身高,最后進行身高的對比,從而得出答案。此過程體現出精準且嚴謹的推理環節。值得一提的是,清華大學這套編程語言具有明顯、透明及模塊化的特性,利于推理過程的展示與理解,對于人機交互十分有利,有助于提高大規模模型回答問題的可解釋性。此外,這款軟件還能處理不同知識庫文本的各類格式,具有較強的可擴展性。

六、知識圖譜交互融合

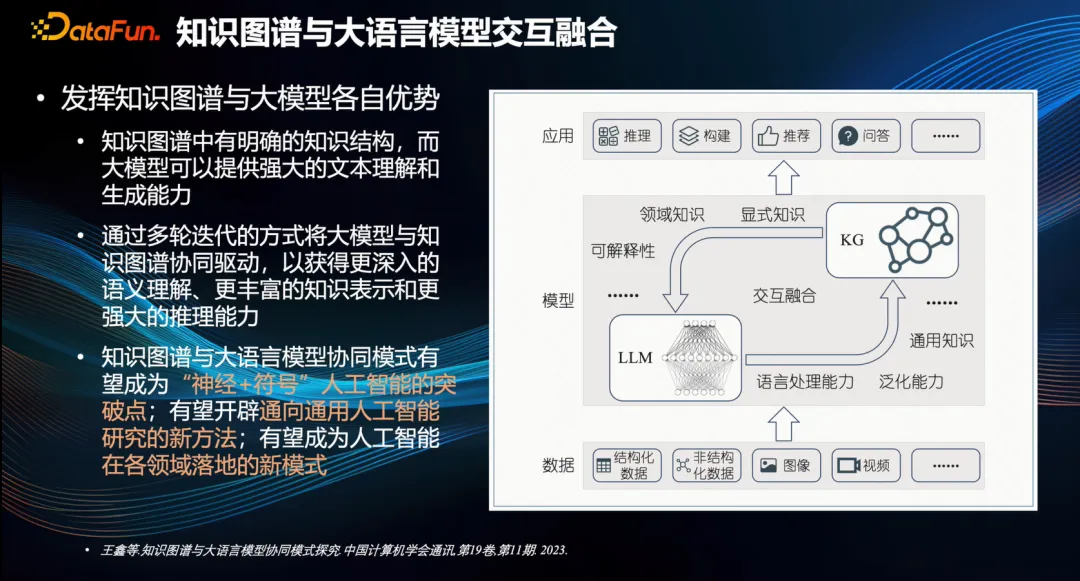

最后,分享基于當前的研究成果對未來知識圖譜與大型模型交互融合的展望,由天津大學的王鑫老師提出[1]。

知識圖譜中有明確的知識結構,而大模型可以提供強大的文本理解和生成能力,那么通過多輪迭代的方式,可以將大模型與知識圖譜協同驅動,以獲得更加深入的語義理解以及更加豐富的知識表示和更加強大的推理能力。

七、結束語

知識圖譜與大模型相協同的模式有望成為支持神經和符號人工智能的重要突破點,能夠開辟通往通用人工智能的全新途徑,也將成為人工智能在各領域應用的新型模式。

這些領域尚有大量工作亟待完成,對于知識圖譜領域的從業者來說,應當積極面對并迎接大模型技術帶來的變革。一方面,我們應充分利用大規模模型的潛力,提升知識工程的效率和效果;另一方面,也應當借用知識圖譜來提升大規模模型生成內容的精確性、安全性以及可解釋性,從而進行更深度的探索。這種將兩者深入融合的能力將引領這個領域走上更高的發展道路,其中蘊含著諸多引人入勝的科研機會。

以上就是本次分享的內容,謝謝大家。

八、參考文獻

[1] 王鑫,陳子睿,王昊奮. 知識圖譜與大語言模型協同模式探究[J/OL]. 中國計算機學會通訊, 2023, 11(01): 2377. DOI:10.3778/j.issn.1673-9418.2308070.

[2] PAN S, LUO L, WANG Y, 等. Unifying Large Language Models and Knowledge Graphs: A Roadmap[J/OL]. IEEE Transactions on Knowledge and Data Engineering, 2024: 1-20. DOI:10.1109/TKDE.2024.3352100.

[3] WANG X, ZHOU W, ZU C, 等. InstructUIE: Multi-task Instruction Tuning for Unified Information Extraction[M/OL]. arXiv, 2023[2024-03-08]. http://arxiv.org/abs/2304.08085. DOI:10.48550/arXiv.2304.08085.

[4] zjunlp/KnowLM[CP/OL]. ZJUNLP, 2024[2024-03-08]. https://github.com/zjunlp/KnowLM.

[5] XIE X, ZHANG N, LI Z, 等. From Discrimination to Generation: Knowledge Graph Completion with Generative Transformer[C/OL]//Companion Proceedings of the Web Conference 2022. 2022: 162-165[2024-03-08]. http://arxiv.org/abs/2202.02113. DOI:10.1145/3487553.3524238.

[6] YU J, WANG X, TU S, 等. KoLA: Carefully Benchmarking World Knowledge of Large Language Models[M/OL]. arXiv, 2023[2024-03-08]. http://arxiv.org/abs/2306.09296. DOI:10.48550/arXiv.2306.09296.

[7] SHI W, MIN S, YASUNAGA M, 等. REPLUG: Retrieval-Augmented Black-Box Language Models[M/OL]. arXiv, 2023[2024-03-08]. http://arxiv.org/abs/2301.12652. DOI:10.48550/arXiv.2301.12652.

[8] CAO S, SHI J, PAN L, 等. KQA Pro: A Dataset with Explicit Compositional Programs for Complex Question Answering over Knowledge Base[M/OL]. arXiv, 2022[2024-03-08]. http://arxiv.org/abs/2007.03875. DOI:10.48550/arXiv.2007.03875.