英特爾AI解決方案為最新Meta Llama 3.1模型提供加速

為了推動“讓AI無處不在”的愿景,英特爾在打造AI軟件生態方面持續投入,并為行業內一系列全新AI模型提供針對英特爾AI硬件的軟件優化。今日,英特爾宣布公司橫跨數據中心、邊緣以及客戶端AI產品已面向Meta最新推出的大語言模型(LLM)Llama 3.1進行優化,并公布了一系列性能數據。

繼今年4月推出Llama 3之后,Meta于7月24日正式發布了其功能更強大的AI大模型Llama 3.1。Llama 3.1涵蓋多個不同規模及功能的全新模型,其中包括目前可獲取的、最大的開放基礎模型—— Llama 3.1 405B(4050億參數)。目前,英特爾豐富的AI產品組合已支持上述最新模型,并通過開放生態系統軟件實現針對性優化,涵蓋PyTorch及英特爾? PyTorch擴展包(Intel? Extension for PyTorch)、DeepSpeed、Hugging Face Optimum庫和vLLM等。此外,企業AI開放平臺(OPEA)亦為這些模型提供支持,OPEA這一全新的開放平臺項目是由LF AI & Data基金會發起,旨在聚合生態之力,推動創新,構建開放、多供應商的、強大且可組合的生成式AI解決方案。

Llama 3.1多語言大模型組合包含了80億參數、700億參數以及4050億參數(文本輸入/文本輸出)預訓練及指令調整的生成式AI模型。其每個模型均支持128k長文本和八種不同的語言。其中,4050億參數的Llama 3.1模型在基本常識、可操作性、數學、工具使用和多語言翻譯方面具有行業領先的能力。同時,該模型亦幫助開發者社區解鎖諸如合成數據生成和模型蒸餾(Model Distillation)等全新功能。

以下內容展示了英特爾的部分AI產品組合運行Llama 3.1模型的初步性能結果,包括英特爾?至強?處理器、搭載英特爾?酷睿? Ultra處理器和英特爾銳炫?顯卡的AI PC產品。

運行Llama 3.1時展現出卓越性能

作為通用計算的基石,英特爾?至強?處理器為全球用戶提供強大算力,現已通過各大云服務商面市。英特爾至強處理器在其每個核心中均內置了英特爾?高級矩陣擴展(AMX)AI引擎,可將AI性能提升至新水平。根據基準測試,在第五代英特爾至強平臺上以1K token輸入和128 token輸出運行80億參數的Llama 3.1模型,可以達到每秒176 token的吞吐量,同時保持下一個token延遲小于50毫秒。圖1展示了運行支持128k長文本的80億參數Llama 3.1模型時,下一個token延遲可低于100毫秒。

圖1. 基于第五代英特爾?至強?可擴展處理器的Llama 3.1推理延遲

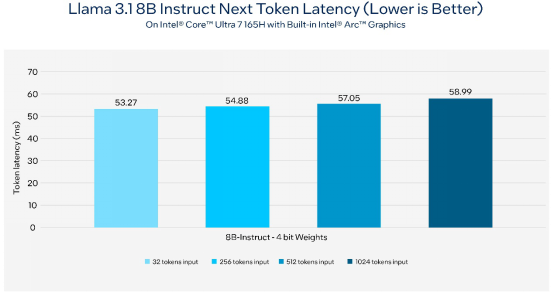

由英特爾?酷睿? Ultra處理器和英特爾銳炫?顯卡驅動的AI PC可為客戶端和邊緣提供卓越的設備端AI推理能力。憑借諸如英特爾酷睿平臺上的NPU,以及銳炫顯卡上英特爾? Xe Matrix Extensions加速等專用的AI硬件,在AI PC上進行輕量級微調和應用定制比以往更加容易。對于本地研發,PyTorch及英特爾PyTorch擴展包等開放生態系統框架可幫助加速。而對于應用部署,用戶則可使用英特爾OpenVINO?工具包在AI PC上進行高效的模型部署和推理。AI工作負載可無縫部署于CPU、GPU以及NPU上,同時實現性能優化。

圖2. 在配備內置英特爾銳炫?顯卡的英特爾?酷睿? Ultra 7 165H AI PC上,Llama 3.1推理的下一個token延遲

圖3. 在使用英特爾銳炫?A770 16GB限量版顯卡的AI PC上,Llama 3.1推理的下一個token延遲

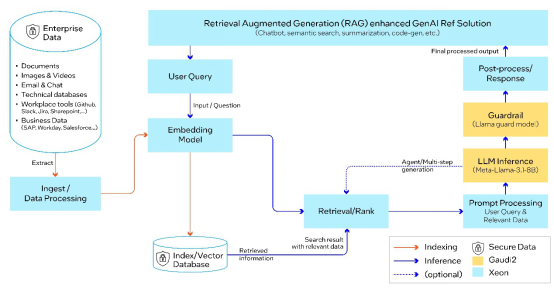

利用Llama 3.1和OPEA部署企業RAG解決方案

英特爾AI平臺和解決方案能夠有助于企業部署AI RAG。作為OPEA的發起成員之一,英特爾正幫助引領行業為企業AI打造開放的生態系統,同時,OPEA亦助力Llama 3.1模型實現性能優化。

基于可組合且可配置的多方合作組件,OPEA為企業提供開源、標準化、模塊化以及異構的RAG流水線(pipeline)。此次測試中,微服務部署于OPEA藍圖的每一支細分領域中,包括防護(Guardrail)、嵌入(Embedding)、大模型、數據提取及檢索。端到端RAG流水線通過Llama 3.1進行大模型的推理及防護,使用BAAI/bge-base-en-v1.5模型進行嵌入,基于Redis向量數據庫,并通過Kubernetes(K8s)系統進行編排。

圖4:基于Llama 3.1的端到端RAG流水線,由英特爾Gaudi 2加速器和至強處理器提供支持

目前,英特爾AI PC及數據中心AI產品組合和解決方案已面向全新Llama 3.1模型實現優化,OPEA亦在基于英特爾至強等產品上全面啟用。未來,英特爾將持續投入軟件優化,支持更多全新的模型與用例。