生成式AI幕后透明度,你學會了嗎?

基礎模型透明度指數揭示了大型語言模型訓練所依賴的數據黑盒。

譯自Transparency From Behind the Generative AI Curtain,作者 Michelle Gienow。

AI 基礎模型已經成為超級模型:在這個 ChatGPT 后的世界,像LLaMA,Gemini和Claude這樣的名字,現在對科技評論家來說,擁有與人類名人一樣的轟動效應和即時認可度。

然而,隨著 AI 在全球重要性日益提升,我們也越來越需要了解產生我們從那些提示框中輸入的結果的技術。斯坦福大學、麻省理工學院和普林斯頓大學的研究人員最近的兩項研究深入研究了支撐世界上一些最先進且廣受歡迎的生成式 AI 工具的 AI 基礎模型,這些工具每天被數百萬(甚至數十億)人使用。透明度的需求至關重要。

然而,2024 年基礎模型透明度指數的結果表明,隨著時間的推移,隨著公司在開發其旗艦基礎模型上投入越來越多的資金,他們對用于訓練這些模型的大量數據以及這些數據的來源變得越來越不透明。

什么是基礎模型?

“基礎模型”一詞是用來描述支撐生成式 AI 的大型深度學習神經網絡的統稱。基礎模型在大量數據上進行訓練,以執行各種各樣的任務,從生成文本、圖像和編程代碼到流暢地用自然語言響應書面提示和問題。不過,可以說,它們最大的力量在于支撐新的 AI 應用:與從頭開始構建自己的模型相比,基礎模型允許工程團隊更快、更經濟地開發新的生成式 AI 應用。

由于相對較少的幾個基礎模型支撐著如此多的面向人類的生成式 AI 工具,因此透明度的需求至關重要。例如,當我們使用ChatGPT生成文本,使用Stable Diffusion創建圖像,以及使用Tabnine生成代碼時,我們需要了解它們的基礎 ML 模型是如何開發和部署的。用戶希望知道,我們可以信任我們已經快速熟悉并喜愛,甚至嚴重依賴的 AI 工具。我們需要知道它們是公平、可解釋和安全的。

這種在 AI 的狂野西部時期建立信任和透明度的緊迫感,源于我們在社交媒體早期不受監管的日子里吸取的教訓。現在我們已經了解得更多,我們可以防止類似的危機,因為我們開始采用 AI。但是,我們如何衡量仍在發展中的技術中的實際功能透明度?

衡量 AI 透明度

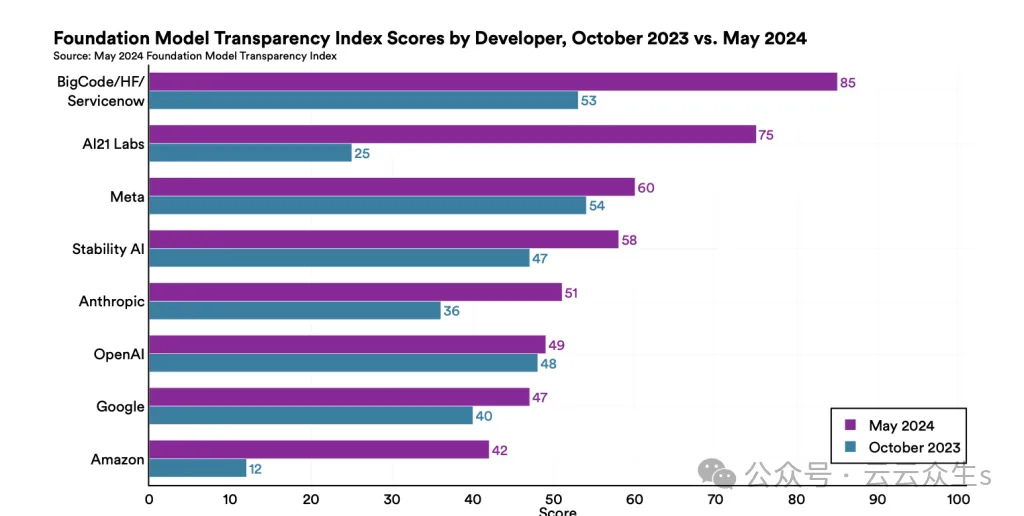

2023 年 10 月,來自斯坦福大學、麻省理工學院和普林斯頓大學的研究人員合作,通過評估當時排名前 10 的基礎模型的旗艦模型,樹立了一面重要的 AI 透明度旗幟。由此產生的白皮書,名為“基礎模型透明度指數”(FMTI),展示了當時排名前 10 的主要基礎模型的透明度指數。Meta 的模型得分最高,滿足了 100 個透明度協議因素中的 54 個,而亞馬遜得分最低(100 個中的 12 個)。所有模型提供商的平均得分 37 分——并非及格分數——揭示了一個行業正在努力向公眾開放。

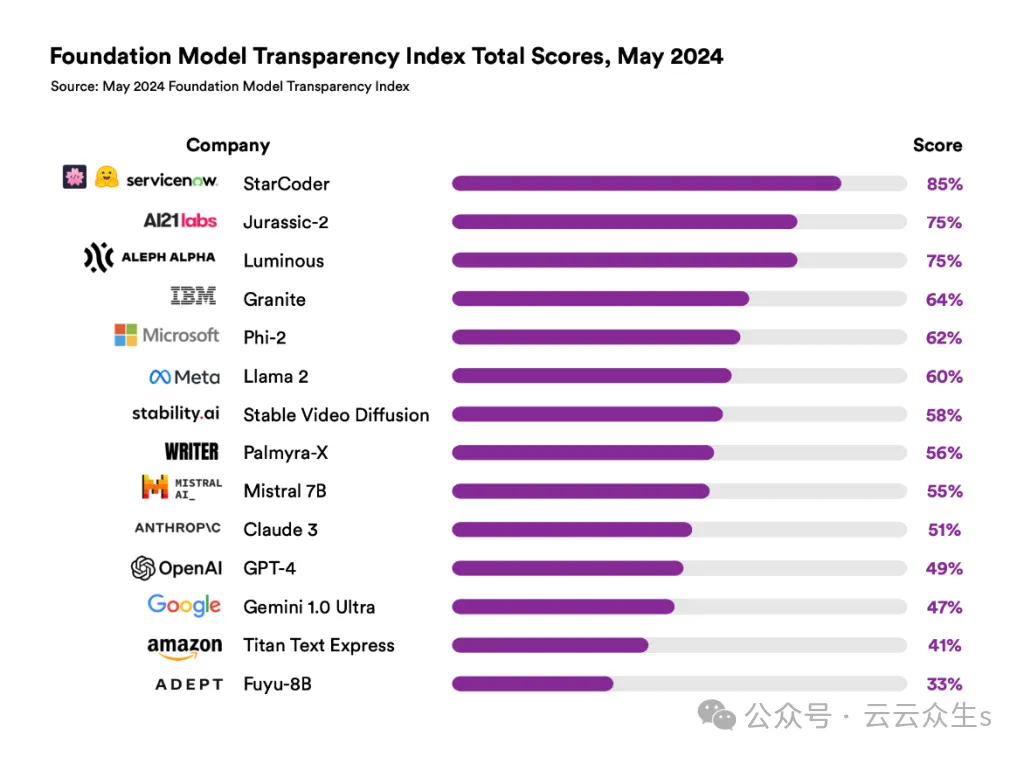

同一批研究人員在 2024 年 5 月發布了一份后續報告,其中有一些變化。最初的報告依賴于公開數據;對于為期六個月的后續研究,模型開發人員自己提交了透明度報告,披露了他們針對 FMTI 的 100 個指標中的每一個指標的實踐。這次,有 14 個組織提交了透明度報告。參與的開發人員還超出了研究人員定義的最初 100 個透明度協議因素;總體而言,組織在各自的報告中平均提供了 17 個新的透明度信息指標。

透明度得分上升

FMTI 2024 在 2023 年的變化方面揭示了什么,這告訴我們關于透明度新現狀的什么?

這次,來自 BigCode/Hugging Face/ServiceNow 的 StarCoder 基礎模型的透明度得分達到 100 分中的 85 分,創歷史新高。所有 14 個模型開發者的平均得分攀升至 100 分中的 58 分,比 2023 年 10 月的 FMTI 平均得分提高了 21 分。

圖片

圖片

總體而言,2024 年的 FMTI 文件顯示出明顯的改進:最高透明度得分提高了 31 分,最低得分提高了 21 分。在第一份報告和后續報告中都出現的八位開發者都提高了他們的得分;亞馬遜的整體漲幅最大,從 2023 年的 12 分躍升至 2024 年的 41 分。更令人欣慰的是,一位開發者滿足了研究人員制定的 100 個透明度指標中的 96 個,多位開發者成功滿足了 89 個指標。

圖片

圖片

這些趨勢總體上相當積極,但數據也揭示了一些不那么樂觀的成果。雖然透明度的整體現狀有了顯著改善,但一些領域仍然頑固地難以觸及。根據報告,“有關數據(版權、許可和 PII)、公司護欄的有效性(緩解評估)以及基礎模型的下游影響(人們如何使用模型以及有多少人在特定地區使用模型)的信息仍然非常不透明。”

換句話說,在一些關鍵領域,模型開發者仍在掩蓋他們的做法,尤其是在數據來源、隱私和緩解方面。

我們作為社區下一步該怎么做?

可能最重要的收獲是:圍繞數據訪問的透明度從 2023 年 10 月的 20% 下降到 2024 年 5 月的 7%。在新報告中,研究人員將其歸因于“公司在披露用于構建基礎模型的數據方面面臨的重大法律風險”。特別是,“如果數據包含受版權保護的、私人的或非法的內容,這些公司可能會面臨責任。”不幸的是,2024 年參與的模型開發者在“模型緩解”方面的得分也很低,這意味著他們沒有充分披露其解決版權侵犯或隱私侵犯問題的策略。

科技公司必須優先考慮人工智能的透明度,因為在該行業之外,大多數人根本不了解人工智能是什么或它是如何運作的。公平地說,就像這些技術是新的,圍繞透明度的標準和期望也是新的。

對于技術來說,這些都是未知領域,在某種程度上,我們是在行走中開辟道路。這些 FMTI 報告和協議的最大價值在于為模型開發者提供明確且可操作的步驟,以提高模型透明度。

2023 年和 2024 年 FMTI 報告之間的信息差異揭示了基礎模型提供商內部持續存在的——也是系統性的——不透明領域。在人工智能方面,基礎模型開發者的組織本身需要贏得最終用戶、政府實體以及——不夸張地說——全人類的信任和信心。

作為社區,我們的工作是推動可訪問性。無論我們這些軟件開發人員如何——甚至是否——使用人工智能和機器學習技術,我們都有責任確保這些新興技術基于道德標準運作,并共同努力減少任何潛在的危害。

作為人工智能的消費者,企業可以通過在采用特定人工智能工具之前提出明智的問題來推動這種可訪問性。這份報告揭示了為什么必須審查實際的許可協議和服務條款,不僅是提供人工智能代碼助手工具的供應商,還有工具背后使用的模型的許可協議和服務條款。

我們的結論是:在透明度成為基礎模型開發者運營的默認方式之前,保證與任何人工智能平臺交互所用數據的絕對隱私的唯一方法是,這些數據無法離開您的邊界。