告別“木桶原理”,CLIP系列模型如何補短板再升級?

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

CLIP(Contrastive Language–Image Pre-training)模型自推出以來,在圖像-文本跨模態理解和生成領域取得了顯著成果。然而,經典模型CLIP還是存在許多短板,對此,學界對CLIP模型的改造與增強還在持續進行中,希望通過改造CLIP模型架構、添加某些模塊來彌補CLIP的能力短板,不斷提升其在跨模態、少樣本任務中的泛化性能與適用性。具體如下:

- 細化CLIP的視覺識別顆粒度

- 即提升其識別圖像中細微差異和局部特征的能力,可以在視覺編碼器部分引入更精細的特征提取機制。

- 可以采用多尺度特征融合策略,通過并行處理不同尺度的圖像輸入,并將多尺度特征進行有效融合,以捕捉圖像中的多層次信息。

- 還可以引入注意力機制,使模型能夠自動聚焦于圖像中的關鍵區域或特征點。

- 結合弱監督學習或自監督學習方法,利用圖像中的自然標注(如顏色、紋理等)或自生成標簽(如聚類結果)來指導特征學習,也是提升視覺識別顆粒度的有效途徑。

- 延長CLIP處理的文本長度并細化CLIP提取的文本信息

可以通過增加網絡層數或采用更復雜的網絡結構(如Transformer)來擴展文本編碼器的容量,以支持更長的文本輸入。

可以引入文本分段或分層處理機制,將長文本劃分為多個子序列或段落,并分別進行編碼和表示學習,最后再將各部分的表示進行有效融合。

為了細化文本信息的提取,可以設計更精細的文本表示學習方法,如基于詞嵌入的向量表示、基于句法結構的圖表示或基于語義角色的框架表示等。

對CLIP的圖像文本輸入做數據增強

對于圖像數據增強,可以采用旋轉、縮放、裁剪、翻轉、顏色變換等傳統方法,以及基于生成模型的對抗性樣本生成等高級方法。

對于文本數據增強,則可以采用同義詞替換、回譯、隨機刪除、句子重組等方法來生成多樣化的文本樣本,或生成偽字幕改善輸入數據的質量。

其他方法如, 通過文本到圖像的擴散模型生成反饋來實現CLIP的自監督學習、增強模塊以提升CLIP在某一少樣本分類任務上的泛化能力等,還有的方法將CLIP輸入擴展到視頻……

本期推送再次盤點了CLIP模型架構還能如何改造,讓我們一起來看看吧!

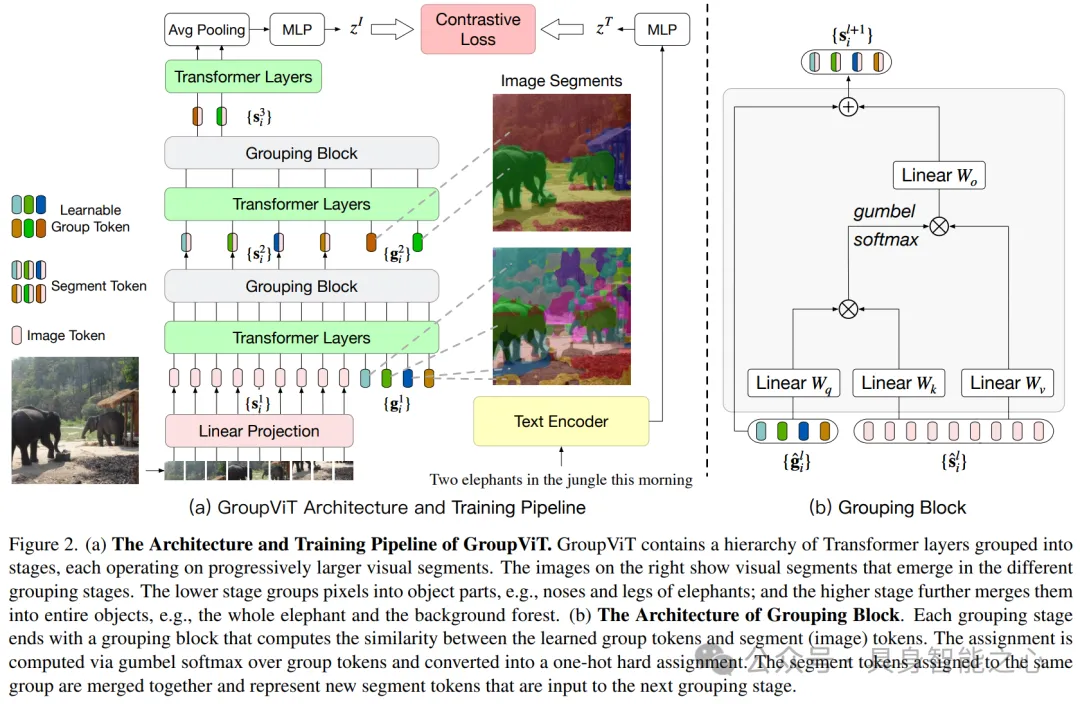

GroupViT: 從文本監督中實現語義分割

https://arxiv.org/abs/2202.11094

文章介紹了一個名為GroupViT(Grouping Vision Transformer)的模型,它是為了實現僅通過文本監督進行語義分割的任務而設計的。GroupViT通過一個分層的Transformer架構進行視覺概念的逐步分組,從較小的圖像片段合并成較大的任意形狀的語義段。GroupViT首先將輸入圖像劃分為多個不重疊的小patch,并將每個patch線性投影到潛在空間,形成輸入的image token。在每個分組階段,image token和group token通過Transformer層進行信息傳播,通過自注意力機制(self-attention)聚合全局信息。每個分組階段的末尾都有一個grouping block,負責將相似的image token合并為更大的語義段(segment)。Grouping block通過計算group token和segment token之間的相似性矩陣來實現合并。在Grouping Block中,使用Gumbel-Softmax操作和直通技巧(straight through trick)來進行硬分配,使得segment tokens能夠明確地分配給不同的group tokens。為了訓練GroupViT執行分層分組,模型采用了特別設計的對比損失函數,包括原始的圖像-文本對比損失和多標簽對比損失。

相對于CLIP,GroupViT引入了分組機制,允許模型自動地將圖像區域分組為語義段,而CLIP是一個基于對比學習的模型,主要用于圖像和文本的聯合表示學習,并沒有顯式的分組機制。GroupViT還采用了分層的Transformer架構,能夠處理任意形狀的圖像段,而CLIP通常處理的是固定大小的圖像patch。此外,GroupViT特有的Grouping Block模塊,用于將圖像tokens合并為更大的語義段。最后,GroupViT使用了多標簽對比損失,通過從文本中提取名詞并使用句子模板生成額外的文本標簽,增強了模型對視覺分組的學習能力。

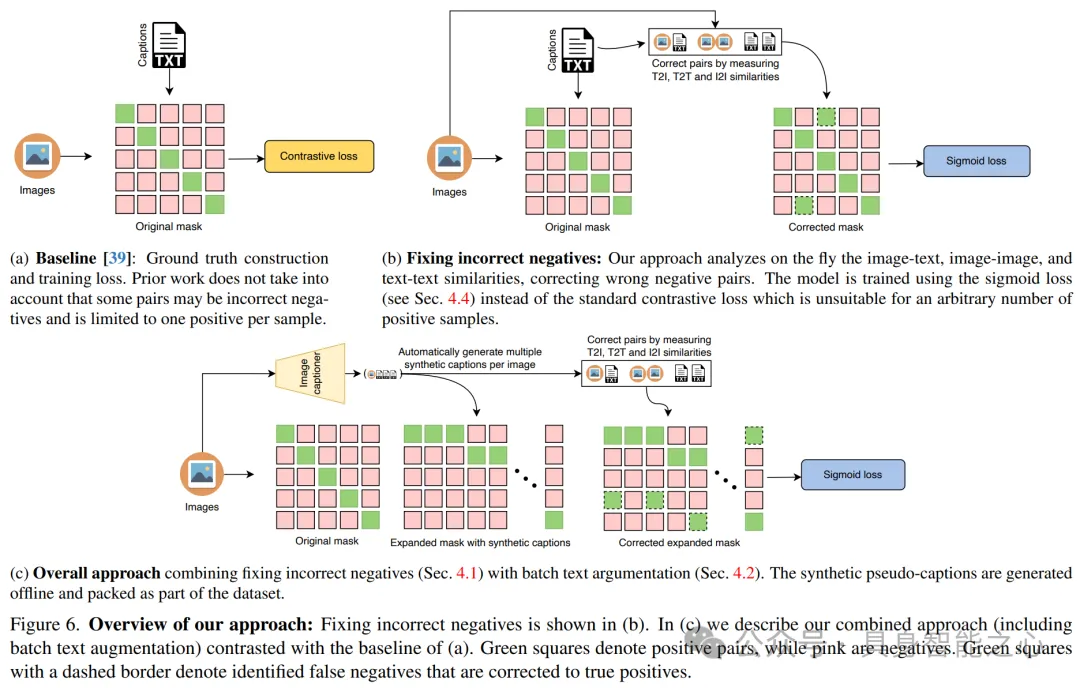

FFF:在對比性預訓練中修復有缺陷的基礎產生的視覺語言模型

https://arxiv.org/abs/2405.10286

文章提出了一種改進的對比性預訓練方法,稱為FFF(Fixing Flawed Foundations),旨在通過解決現有視覺-語言模型訓練中的兩個關鍵問題來增強模型性能:錯誤分配的負對(false negative pairs)和低質量及多樣性不足的字幕(captions)。

- 在對比學習中,通常假設每個樣本只有一個正對(positive pair),但實際中,由于圖像和/或字幕在語義上的相似性,一些負對(negative pairs)可能被錯誤地標記。這導致訓練過程和模型質量受限。為了解決這個問題,文章提出了一種基于圖像-文本、圖像-圖像和文本-文本相似性的算法,用于發現并糾正這些錯誤分配的負對,并挖掘新的真正例(true positives)。

- 現有的網絡收集的數據集往往包含質量低下、描述簡短或不相關的字幕,這不利于訓練。文章通過使用最先進的圖像字幕技術生成偽字幕(pseudo-captions),作為給定圖像的新真正例,從而提高字幕的質量和描述性。為了進一步提升訓練數據的多樣性,文章提出了批量文本增強策略。在同一個批次中,為每個訓練圖像生成多個偽字幕(例如,通過束搜索選擇的五個字幕),這樣可以有效增加字幕的多樣性。

- 由于上述方法導致每個圖像的正對數量可能不同,文章提出使用sigmoid loss作為訓練損失函數。這種損失函數允許每個樣本的正對數量動態變化,且對挖掘過程中的潛在錯誤具有魯棒性。

文章展示了FFF方法在圖像識別(在11個數據集上平均提高了約6%)和圖像檢索(在Flickr30k上提高了約19%,在MSCOCO上提高了約15%)方面的顯著性能提升。總之,FFF方法通過解決負對分配錯誤和提升字幕質量與多樣性,顯著提高了視覺-語言模型的預訓練效果,并通過使用sigmoid loss作為訓練損失函數,有效地利用了多個正對進行訓練。

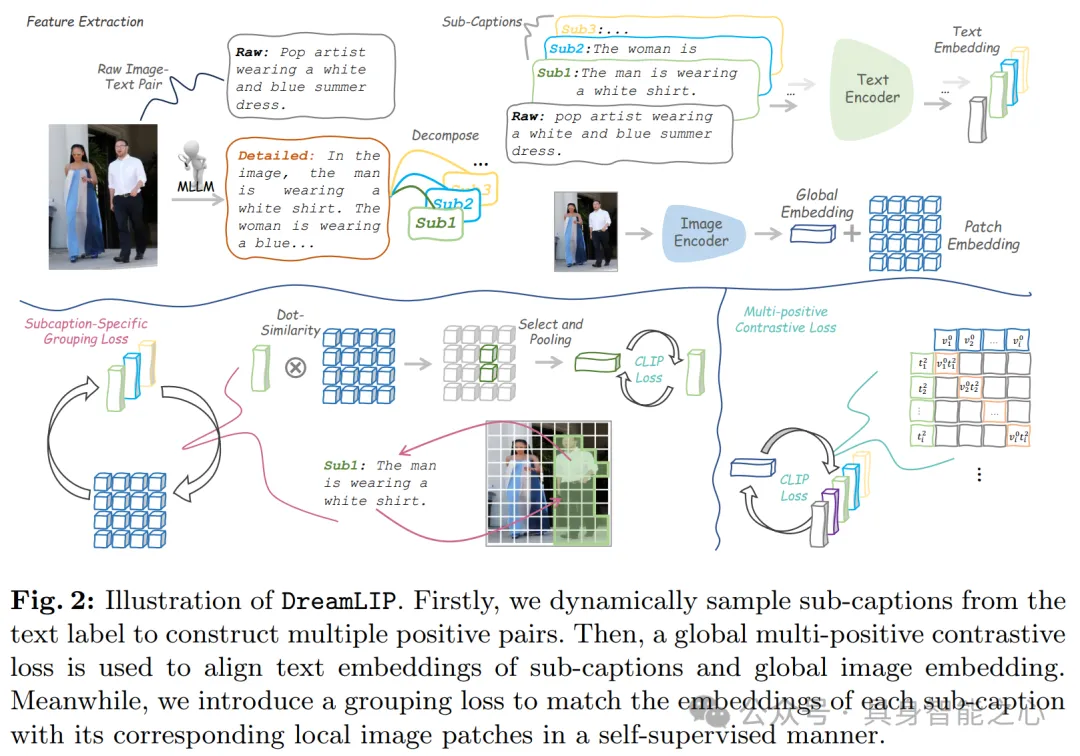

DreamLIP:帶有長字幕的語言圖像預訓練

https://arxiv.org/abs/2403.17007

文章提出的DreamLIP模型實現了從長標題中動態采樣子標題,并與圖像的局部區域進行細粒度對齊。

- DreamLIP首先使用預訓練的多模態大型語言模型(MLLM)為30M圖像重新生成詳細的描述性長標題,這些長標題比現有的數據集更豐富、更詳盡。進而從長標題中動態采樣子標題(subcaptions),以構建多個正對(positive pairs)。每個子標題可能描述圖像的一個部分,例如一個物體或者場景的一個方面。引入分組損失來匹配每個子標題的文本嵌入與相應的局部圖像塊。這種損失函數在自我監督的方式下工作,意味著它不需要外部標注來指導子標題和圖像塊之間的對齊。

- 采用多正對對比學習框架(Multi-Positive Contrastive Learning),將文本嵌入與圖像嵌入進行對齊,使得來自同一圖像的多個子標題能夠與圖像的不同部分形成正對。通過分組損失實現細粒度對齊,確保每個子標題的文本特征與圖像中相應的局部特征精確匹配,從而提高模型對圖像細節的理解。將多正對對比損失和細粒度對齊損失結合起來,形成DreamLIP的整體訓練目標函數,通過這個函數來優化模型。

在多種下游任務上進行實驗,包括圖像-文本檢索、語義分割等,證明了DreamLIP模型相較于現有方法在細粒度表示能力上的一致優越性。通過這種方法,DreamLIP能夠充分利用長標題中的信息,提高模型對圖像內容的理解和表示能力,尤其是在零樣本學習的場景下,展現出了強大的性能。

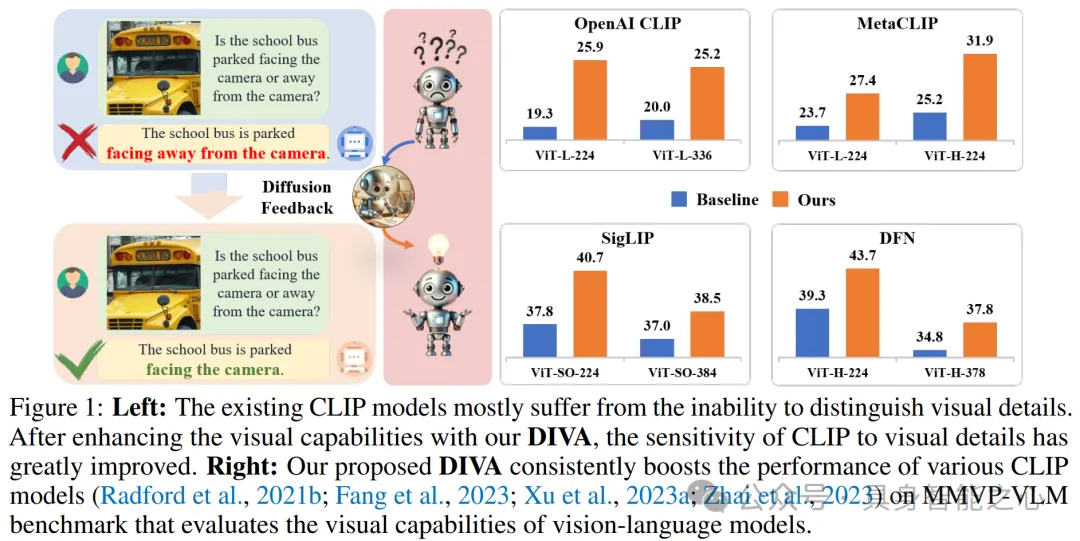

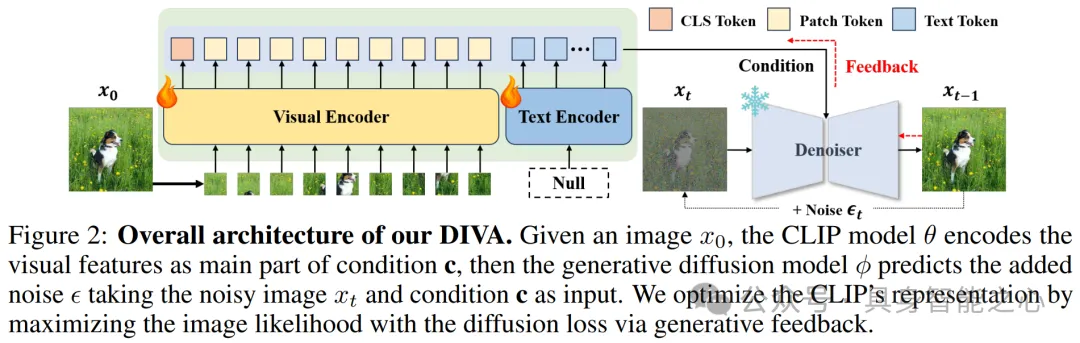

DIVA:擴散反饋幫助 CLIP 看得更清楚

https://arxiv.org/abs/2407.20171

對比語言-圖像預訓練 (CLIP) 擅長跨領域和模態抽象開放世界表示,已成為各種視覺和多模態任務的基礎。然而,最近的研究表明,CLIP存在嚴重的視覺缺陷,例如幾乎無法區分方向、數量、顏色、結構等。這些視覺缺陷也限制了基于 CLIP 構建的多模態大型語言模型 (MLLM) 的感知能力。主要原因可能是用于訓練 CLIP 的圖像-文本對具有固有的偏見,因為缺乏文本的獨特性和圖像的多樣性。這項工作提出了一種簡單的CLIP模型后訓練方法,該方法通過自監督擴散過程在很大程度上克服了其視覺缺陷。我們介紹了 DIVA,它使用 DIffusion 模型作為 CLIP 的視覺助手。具體來說,DIVA利用來自文本到圖像擴散模型的生成反饋來優化CLIP的表征,僅使用圖像(沒有相應的文本),從而實現了自監督學習。

- DIVA使用一個預訓練的條件擴散模型,該模型能夠根據條件生成詳細的圖像。擴散模型通過一個逐步添加高斯噪聲的過程來學習圖像的概率分布,這個過程可以逆轉,從而從噪聲中重建圖像。DIVA利用文本到圖像擴散模型的生成能力,將CLIP模型編碼的視覺特征作為擴散模型的條件輸入。這意味著CLIP的視覺特征被用來指導擴散模型生成圖像。通過最大化圖像似然度,使用擴散損失來優化CLIP模型的表示。具體來說,擴散模型嘗試預測每一步中添加的噪聲,并通過這種方式來優化CLIP的權重,使其學習到更豐富的視覺細節。

- DIVA引入了一種視覺密集重述策略(Visual Dense Recap Scheme),通過結合局部區域的視覺特征(patch tokens)和類別標記(class token)來增強條件信息的豐富性,從而提高CLIP模型的優化能力。

- 盡管進行了優化,DIVA框架仍然保持了CLIP模型原有的零樣本(zero-shot)能力,在多種圖像分類和檢索基準測試中表現出色。

通過在MMVP-VLM基準測試上的實驗,DIVA顯著提升了CLIP模型在細粒度視覺能力上的表現,并在多模態理解和分割任務上提高了MLLMs和視覺模型的性能。總的來說,DIVA模型通過一個簡單而有效的自監督框架,使用擴散模型的生成反饋來優化CLIP的視覺表示,使其在視覺細節的感知上有了顯著的提升,同時保留了CLIP的原有優勢。

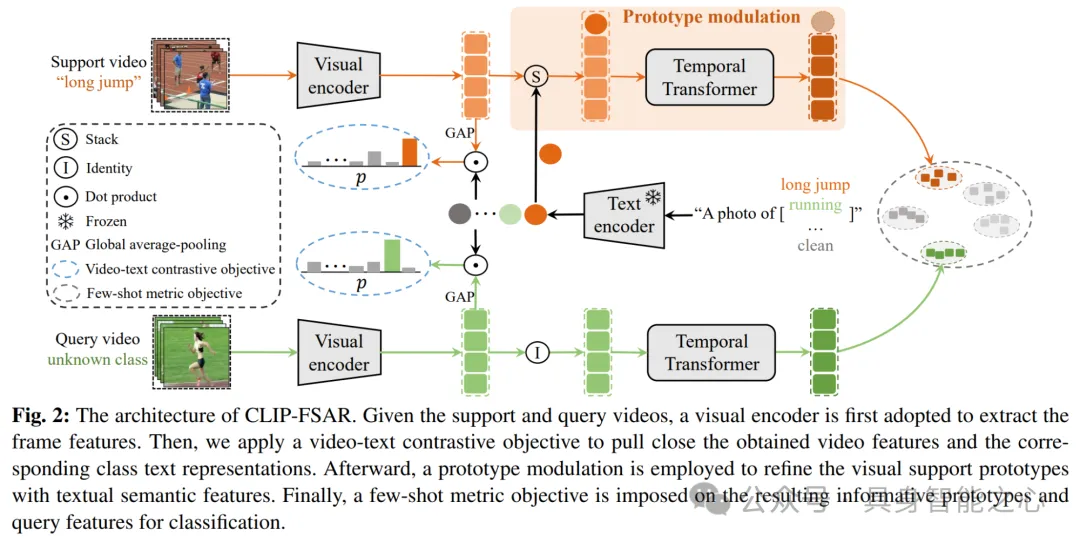

CLIP-FSAR:小樣本動作識別的原型調制方法

https://arxiv.org/abs/2303.02982

本文的目標是遷移CLIP強大的多模態知識,以解決由于數據稀缺而導致的原型估計不準確的問題,這是少樣本動作識別(Few-shot Action Recognition, FSAR)中一個關鍵問題。文章提出了一種名為CLIP-FSAR的原型調制框架,該框架由兩個關鍵組件組成:視頻-文本對比物鏡(Video-text Contrastive Objective)和原型調制(Prototype Modulation)。

- 視頻-文本對比物鏡的目的是縮小CLIP和少樣本視頻任務之間的差異。通過對比視頻特征和對應的類別文本描述,框架能夠學習如何將視頻內容與文本描述相匹配。使用CLIP的視覺編碼器(Visual Encoder)提取視頻幀的特征,同時使用文本編碼器(Text Encoder)提取文本描述的特征。然后通過全局平均池化(Global Average Pooling, GAP)和余弦相似度函數來計算視頻特征和文本特征之間的匹配概率。最后應用交叉熵損失函數來優化視頻-文本匹配概率,使得匹配對的相似度最大化,不匹配對的相似度最小化。

- 原型調制是為了解決少樣本情況下視覺信息不足導致的原型估計不準確問題,原型調制組件利用CLIP中的文本語義先驗來優化視覺原型。首先在支持集(Support Set)的視覺特征基礎上,將文本特征沿時間維度堆疊,并使用時間Transformer來自適應地融合文本和視覺特征。時間Transformer能夠處理支持視頻和查詢視頻的特征,使得融合后的特征在共同的特征空間中進行匹配,以計算查詢視頻與支持視頻之間的距離。采用動態時間規整(Dynamic Time Warping, DTW)或其他時間對齊度量來計算查詢視頻和支持視頻之間的距離,并通過少數樣本度量目標(Few-shot Metric Objective)來進行分類。

CLIP-FSAR框架通過這兩個組件的協同工作,能夠充分利用CLIP模型中的豐富語義信息,生成可靠原型,并在少樣本分類任務中實現精確分類。通過視頻-文本對比物鏡,CLIP-FSAR適應于視頻任務,并通過原型調制增強了對視頻中動作類別的識別能力。

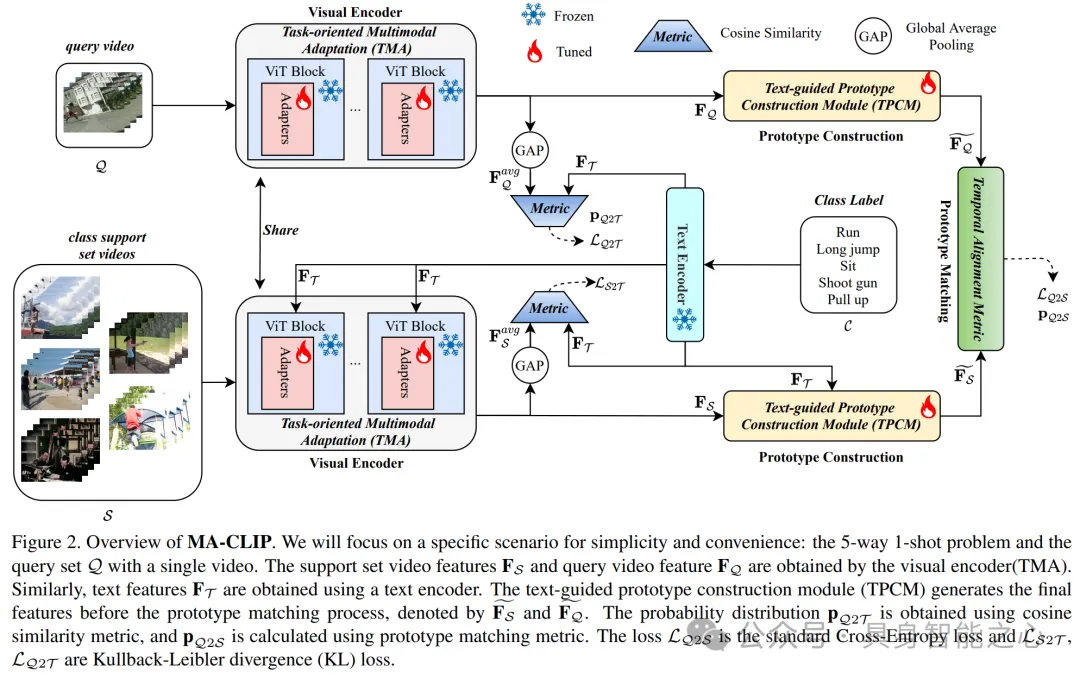

MA-CLIP:CLIP的多模態自適應用于小樣本動作識別

https://arxiv.org/abs/2308.01532

將大規模預訓練的視覺模型(如 CLIP)應用于小樣本動作識別任務可以提高性能和效率。利用“預訓練,微調”范式可以避免從頭開始訓練網絡,這可能既耗時又耗費資源。但是,這種方法有兩個缺點。首先,用于小樣本動作識別的標記樣本有限,因此需要盡量減少可調參數的數量以減輕過擬合,這也會導致微調不足,從而增加資源消耗并可能破壞模型的廣義表示。其次,視頻的超時域維度挑戰了小樣本識別的有效時間建模,而預訓練的視覺模型通常是圖像模型。為了解決這些問題,本文提出了一種名為CLIP多模態適應(MA-CLIP, Multimodal Adaptation of CLIP)的新方法。

- 輕量級適配器(Lightweight Adapters)被添加到CLIP模型中,目的是最小化可學習的參數數量,從而減少過擬合的風險,并允許模型快速適應新任務。適配器的設計允許它們結合視頻和文本信息,進行面向任務的時空建模。MA-CLIP利用視頻的時空信息和文本的語義信息,通過適配器進行有效的多模態信息融合。這種融合方法可以提高模型對動作類別的識別能力,尤其是在小樣本學習場景下。

- 模型不僅關注視頻幀內的空間特征,還關注幀之間的時間關系,這對于理解動作的發展和變化至關重要。面向任務的時空建模(Task-oriented Spatiotemporal Modeling)使得MA-CLIP能夠捕捉到動作的本質特征,提高識別的準確性。

- 文本引導的原型構建模塊(TPCM, Text-guided Prototype Construction Module)基于注意力機制設計,用于增強視頻原型的表示。通過利用文本描述,TPCM能夠更好地理解視頻內容,從而提高類別原型的質量,這對于小樣本學習中的類別匹配和識別非常關鍵。

MA-CLIP設計為可以與任何不同的小樣本動作識別時間對齊度量(如視頻匹配器)一起使用,這增加了模型的通用性和靈活性。由于適配器的輕量級特性和參數數量的減少,MA-CLIP在訓練時更加快速和高效,同時降低了訓練成本。總的來說,MA-CLIP通過精心設計的適配器和文本引導的原型構建模塊,有效地結合了視覺和語言信息,提高了小樣本動作識別的性能,同時保持了模型的快速適應性和低訓練成本。

APE:并非所有特征都重要:通過自適應先驗優化增強CLIP的少樣本泛化能力

https://arxiv.org/abs/2304.01195

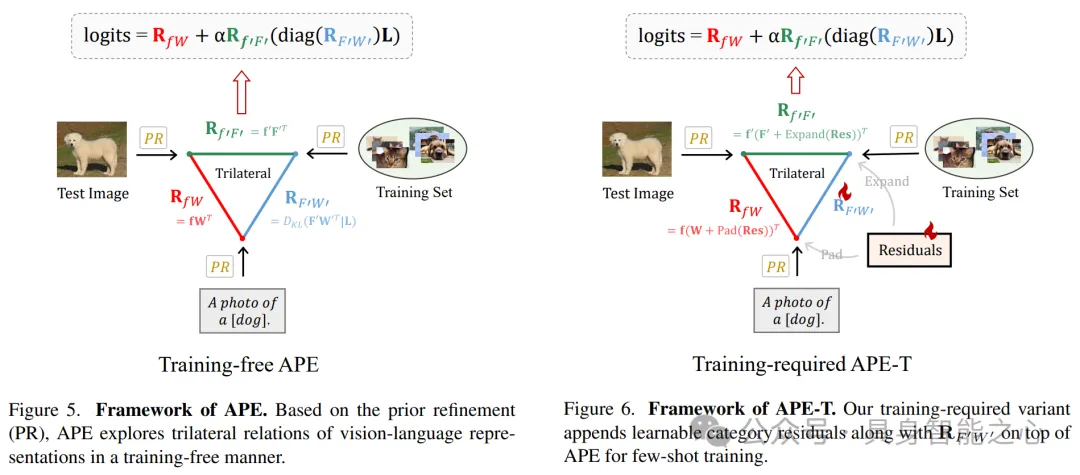

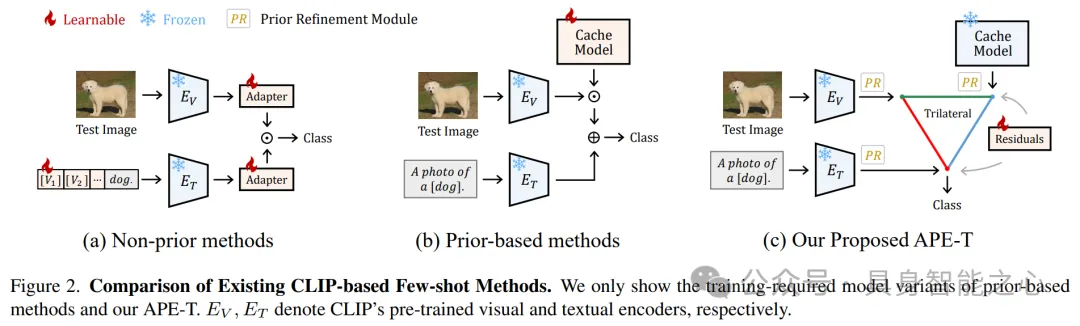

現有的CLIP少樣本泛化方法要么表現出有限的性能,要么存在過多的可學習參數。本文提出了 APE(Adaptive Prior rE?nement),這是一種為CLIP模型的預訓練知識進行適應性細化的方法,旨在提高CLIP在下游任務中的性能,特別是在小樣本學習場景下。

- APE通過先驗細化模塊(Prior Refinement Module)分析下游數據中的類間差異性,目的是將領域特定的知識與CLIP模型中已經提取的緩存模型進行解耦,從而選擇最有意義的特征通道。利用兩個標準——類間相似度(inter-class similarity)和方差(variance)——來選擇最具區分性的特征通道,減少冗余信息并降低緩存大小,以減少內存成本。

- APE提供了兩種模型變體:(1)無需訓練的APE(Training-free APE):直接利用細化后的緩存模型進行推理,探索測試圖像、細化的緩存模型和文本表示之間的三邊親和性,實現無需訓練的穩健識別。(2)需要訓練的APE-T:在APE的基礎上,增加了一個輕量級的類別殘差模塊(category-residual module),該模塊只需對類別殘差進行訓練,而不需要對整個緩存模型進行昂貴的微調。這個模塊進一步更新細化的緩存模型,并在模態之間共享以確保視覺-語言的對應關系。

- APE模型探索了測試圖像、先驗緩存模型和文本表示之間的三邊關系,通過這種關系來增強小樣本學習的性能。

APE和APE-T在保持高計算效率的同時,實現了在多個基準測試中的最先進性能,特別是在16次拍攝的ImageNet分類任務中,APE和APE-T分別以少于第二佳方法+1.59%和+1.99%的平均準確率,并且具有×30更少的可學習參數。