離譜!CPU狂飆900%,這怎么處理?

大家好,今天給大家分享一個線上服務器突然cpu狂飆到900%的一個生產事故案例,相信對大家一定會有一定的用處!因為我們平時開發好的系統部署到線上服務器后基本上就不用怎么管了,系統自己會不停地運行,無非就是數據庫里積累的數據會越來越多而已。

但是有的時候,如果因為系統開發的時候遺留下來的一些bug或者漏洞,然后線上生產環境下運行的時候萬一在某些特殊的額情況下觸發了這個bug或者漏洞,就可能導致我們開發好的線上系統無法正常運行,此時就優可能導致線上服務器cpu負載狂飆到百分之幾百!下面,我們就正式開始分析這個生產案例。

話說,有一天下午,我正坐在工位上悠閑地喝著咖啡,突然接到運維一個緊急電話,說線上的Java系統部署的服務器CPU使用率突然飆升到了900%!我的第一反應是:“啥?CPU使用率還能超過100%?這不是在開玩笑吧!”但事實擺在眼前,由不得我不信。

一、問題初現:CPU使用率離奇飆升

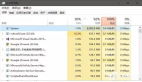

我迅速登錄到服務器上,使用top命令查看CPU使用情況。媽呀,CPU使用率確實快爆表了!一般來說,CPU使用率超過100%就意味著有多個核心都在滿負荷運行,但飆到900%簡直是前所未聞。

我開始懷疑是不是自己眼花看錯了,或者是系統出了什么bug。但經過多次確認,CPU使用率確實穩穩地保持在900%左右。這下我徹底懵了,這到底是什么鬼情況?

二、初步分析:可能的原因

我冷靜下來,開始分析可能導致CPU使用率飆升的原因:

1、多線程瘋狂:Java應用是個多線程的大家伙,是不是某個線程池里的線程數設置得太多了,導致線程爆炸?這些線程可能在瘋狂地執行某些操作,導致CPU使用率飆升。

2、死循環或高復雜度算法:代碼里是不是有死循環,或者某個算法的時間復雜度太高,把CPU給榨干了?這種情況在之前也發生過,某個開發人員不小心寫了個死循環,導致CPU使用率一直居高不下。

3、外部攻擊:系統是不是被黑客攻擊了,比如DDoS攻擊,導致CPU使用率異常?雖然我們的系統安全性一直做得不錯,但也不能完全排除這種可能性。

4、資源爭搶:是不是多個應用部署在同一臺服務器上,互相搶資源,把CPU給搶爆了?我查看了一下服務器的部署情況,發現確實有幾個其他的應用也在運行。

三、深入調查:一步步定位問題

1. 查看Java進程

為了找出問題的根源,我先用ps -ef | grep java命令找到Java進程的PID。然后使用top -H -p [PID]命令查看該進程下所有線程的CPU使用情況。經過一番查找,我發現有一個線程的CPU使用率特別高,肯定是它搞的鬼!

2. 線程Dump分析

接下來,我用jstack [PID]命令生成了Java進程的線程Dump文件。然后找到那個CPU使用率高的線程的線程ID,轉換成16進制,在Dump文件里搜索。嘿,還真找到了!我一看線程棧,原來是在執行某個復雜的數據庫查詢操作!

3. 代碼審查與SQL優化

拿到這個線索后,我趕緊去審查對應的代碼。一看,果然發現了一個問題:查詢語句里有個地方使用了笛卡爾積,導致數據量一大,查詢就特別慢,CPU也跟著飆高。我趕緊把這個問題反饋給了這部分代碼的負責同學,并讓他們優化SQL語句。經過一番努力,他們重寫了查詢語句,確保了查詢效率。改完后,本地測試一下,查詢速度果然快多了。

4. 檢查線程池配置

在解決數據庫查詢問題的同時,我也開始檢查線程池的配置。我發現線程數確實設置得有點多,根據服務器的核心數和業務需求,我調整了一下線程數,避免線程過多導致資源爭搶。

5. 監控與日志分析

在解決問題的過程中,我還加強了監控和日志分析。我配置了系統監控工具,實時監控服務器的CPU、內存、磁盤等性能指標。同時,我也增加了日志記錄的詳細程度,以便在出現問題時能夠更快地定位問題。

四、解決問題:綜合施策,徹底根治

經過一系列的調查和分析,我終于找到了問題的根源,并采取了相應的措施來解決問題:

1、優化SQL語句:開發團隊重寫了復雜的數據庫查詢語句,避免了笛卡爾積的使用,提高了查詢效率。

2、調整線程池配置:我根據服務器的核心數和業務需求,合理設置了線程池的線程數,避免了線程過多導致的資源爭搶。

3、加強監控和日志分析:我配置了系統監控工具,并增加了日志記錄的詳細程度,以便在出現問題時能夠更快地定位問題。

4、分離部署:為了避免多個應用互相搶資源導致的問題,我將部分應用遷移到了其他服務器上,確保了資源的合理分配。

改完代碼和配置后,我重新部署了應用,并密切監控CPU使用情況。過了一會兒,CPU使用率終于降下來了,回到了正常的水平。我心里的一塊大石頭也終于落地了。

五、總結與反思:經驗教訓與未來規劃

這次事件雖然驚心動魄,但也給了我們一些寶貴的教訓和啟示:

1、代碼審查要嚴格:定期對代碼進行審查,及時發現并修復潛在的性能問題。這次事件就是由于一個不經意的笛卡爾積導致的。

2、監控要到位:建立完善的監控系統,實時監控服務器的各項性能指標,一旦發現異常立即處理。這次我們能夠迅速定位問題并解決,很大程度上得益于監控系統的幫助。

3、資源規劃要合理:根據業務需求合理分配服務器資源,避免資源爭搶導致性能問題。這次我們將部分應用遷移到其他服務器上,就是出于這個考慮。

4、多線程使用需謹慎:在使用多線程時,要特別注意線程數的設置和線程的管理,避免線程爆炸導致性能問題。這次事件就是由于線程數設置過多導致的。

通過這次事件的處理,我們不僅解決了CPU使用率飆升的問題,還對整個系統的性能和穩定性進行了一次全面的檢查和優化。同時,我們也意識到自己在系統運維和代碼審查方面還有待加強。未來,我們將繼續加強這方面的工作,確保系統的穩定運行和業務的順利發展。希望以后不會再遇到這么離譜的問題了!