本地部署DeepSeek就這么簡(jiǎn)單...

引言

DeepSeek 作為一款優(yōu)秀的語言模型,結(jié)合 Ollama 和 Cherry Studio 可以輕松實(shí)現(xiàn)本地部署。本文將深入淺出地介紹如何使用 Ollama 與 Cherry Studio 本地部署 DeepSeek。

Oallam簡(jiǎn)介

Ollama 是一個(gè)簡(jiǎn)單易用的工具,它允許用戶在本地快速部署和運(yùn)行各種語言模型。通過 Ollama,你可以方便地管理模型的下載、啟動(dòng)和使用,無需復(fù)雜的配置。

Cherry Studio

Cherry Studio 是一個(gè)集成開發(fā)環(huán)境(IDE),專門為人工智能開發(fā)設(shè)計(jì)。它提供了直觀的界面和豐富的功能,幫助開發(fā)者更高效地與語言模型進(jìn)行交互和開發(fā)。

整合步驟

1. 安裝Oallam

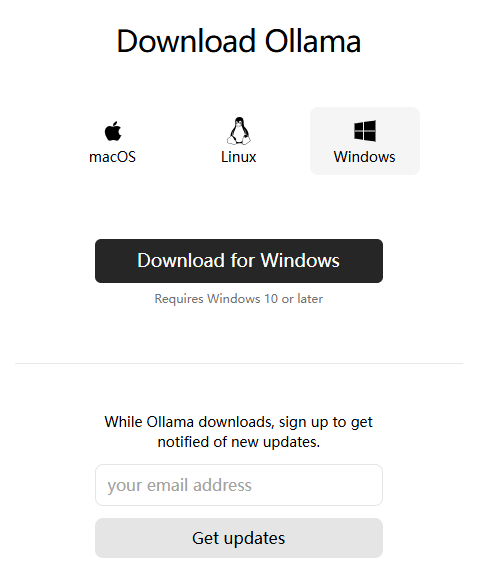

首先,需要在本地安裝Oallam。根據(jù)操作系統(tǒng)選擇合適的安裝包進(jìn)行下載和安裝。安裝完成后,可以通過命令行啟動(dòng)Oallam服務(wù),并下載所需的大模型。^[6]^

- 下載并安裝Oallam 直接訪問官網(wǎng)下載

圖片

圖片

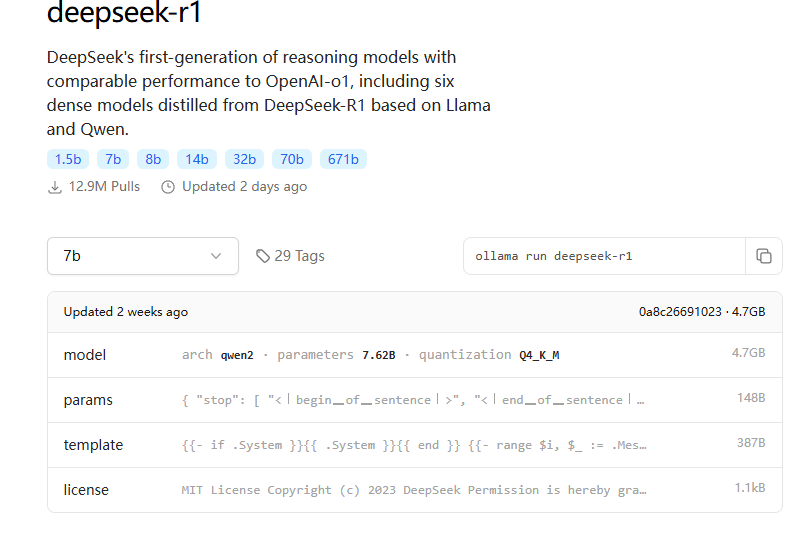

- 下載大模型進(jìn)入模型倉(cāng)庫(kù)(https://ollama.com/library)根據(jù)自己電腦配置,選擇合適的模型下載并運(yùn)行。

ollama run deepseek-r1:7b 圖片

圖片

- 啟動(dòng)Oallam服務(wù)如果是執(zhí)行命令

ollama pull *下載模型,需要手動(dòng)啟動(dòng)服務(wù)。

ollama serve也可以直接進(jìn)入到Ollama的安裝路徑(C:\Users\用戶\AppData\Local\Programs\Ollama)執(zhí)行ollama app.exe后,任務(wù)欄右下角有羊駝的標(biāo)識(shí),表示啟動(dòng)成功。

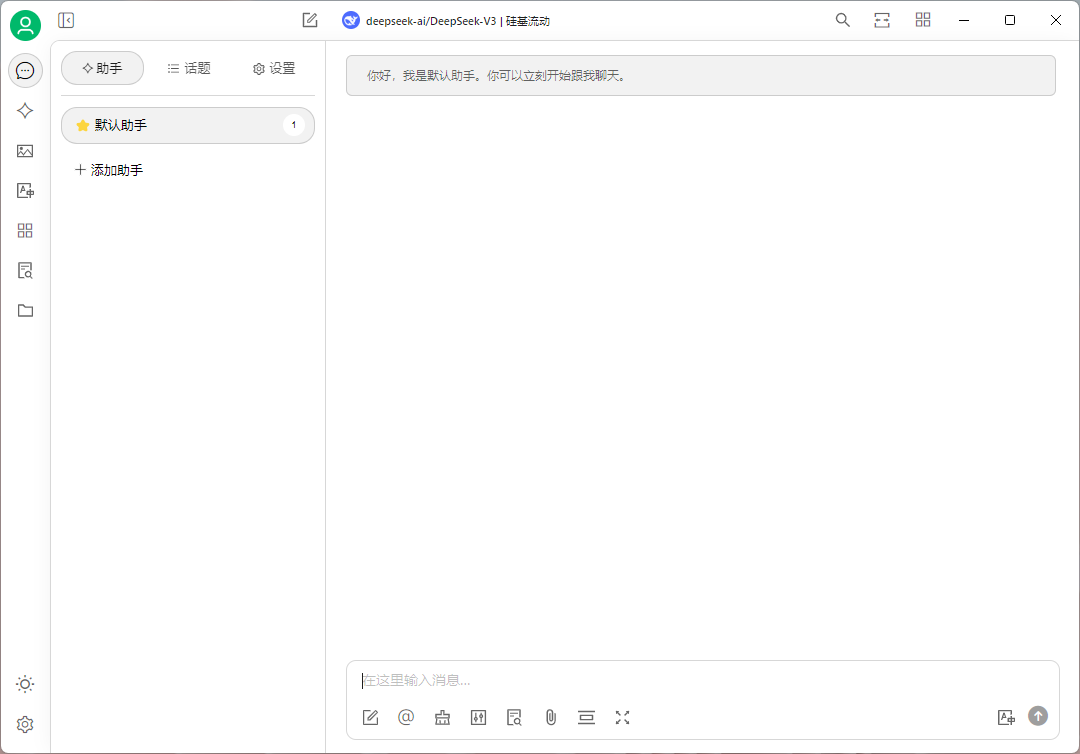

2. 安裝Cherry Studio

直接下載客戶端(https://cherry-ai.com/download)

圖片

圖片

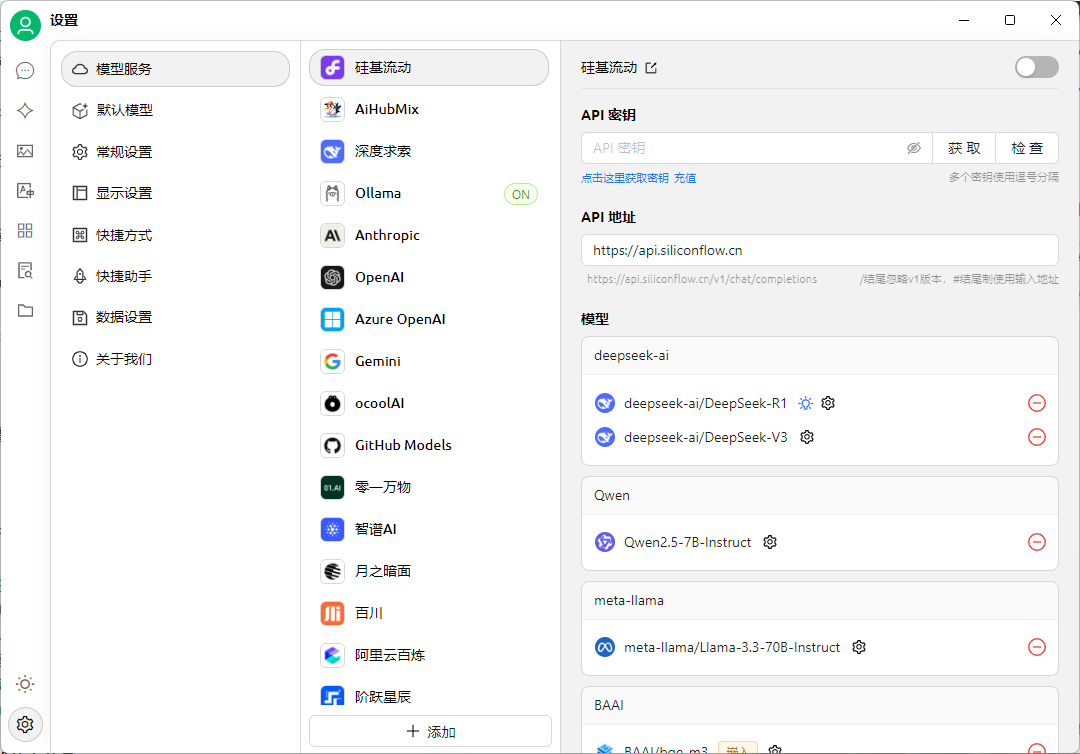

3. 配置Cherry以使用Oallam模型

- 點(diǎn)擊右下角設(shè)置

圖片

圖片

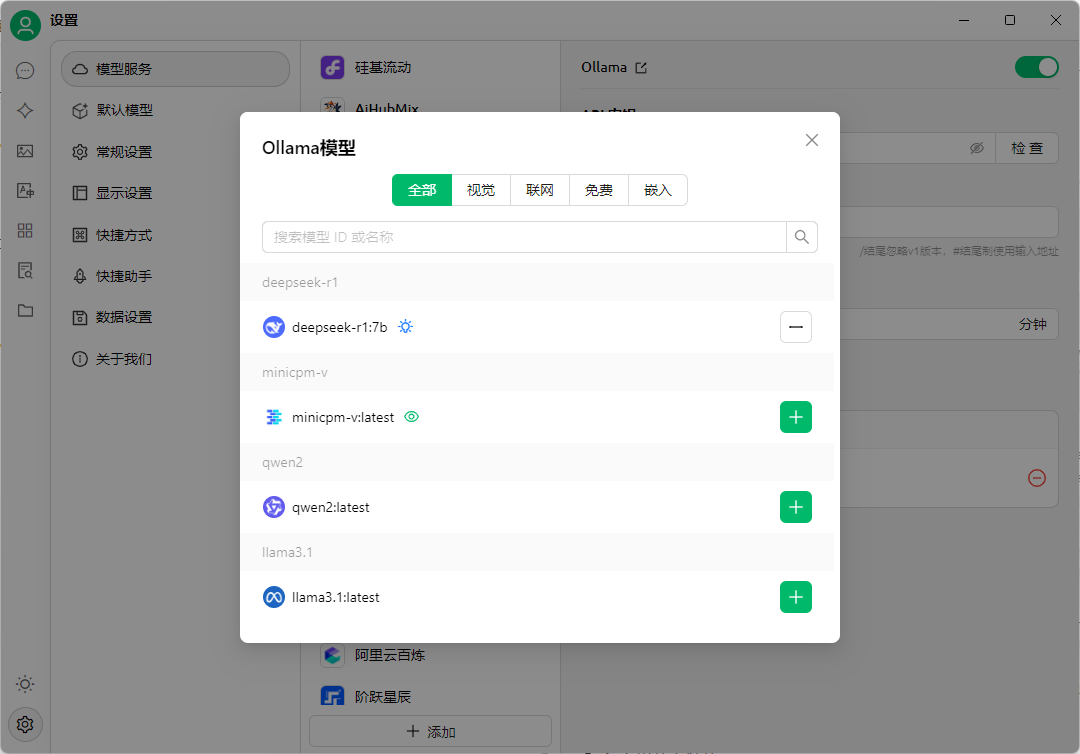

- 選擇Ollama

a.右上角開關(guān)打開

b.點(diǎn)擊最下面的管理,并選擇在Ollama中下載好的模型

圖片

圖片

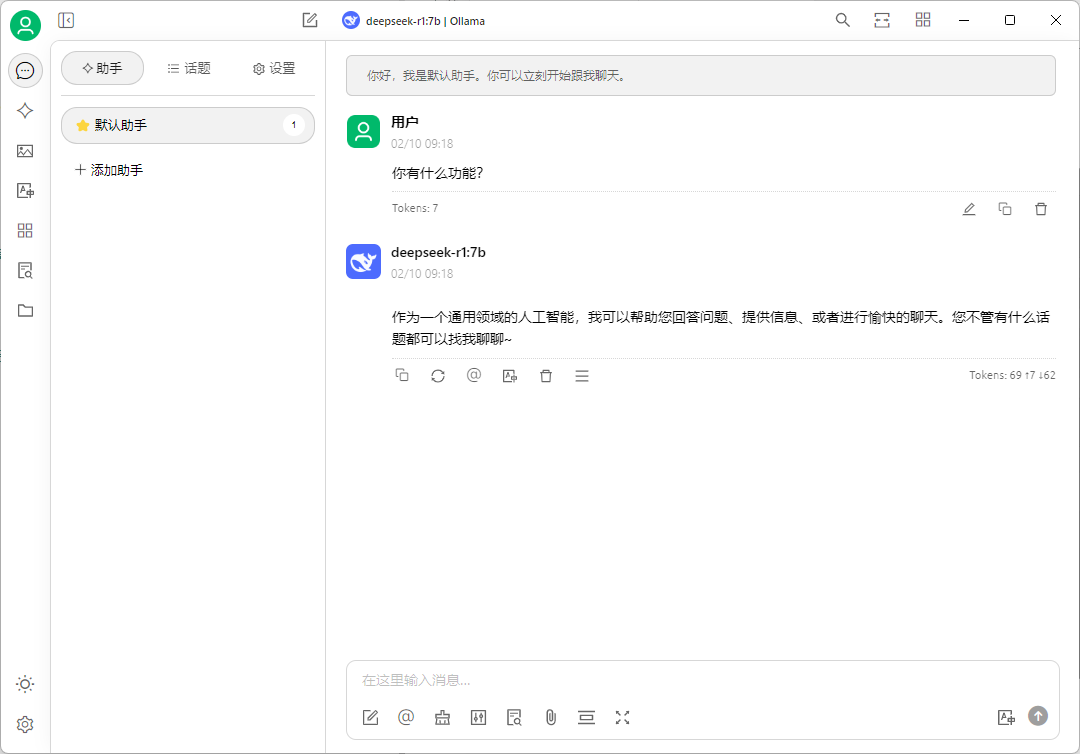

c.回到助手頁面,點(diǎn)擊最上面的模型名稱切換模型服務(wù)

d.聊天

圖片

圖片

4. 基于API的調(diào)用

通過API調(diào)用可以實(shí)現(xiàn)前后端的高效交互,使得基于DeepSeek模型的應(yīng)用開發(fā)更加靈活。API調(diào)用的具體實(shí)現(xiàn)如下:

- API端點(diǎn):http://localhost:11434/v1/chat/completions

- 請(qǐng)求頭:

a.Content-Type: application/json

- 請(qǐng)求體:

- model: 指定使用的模型,例如deepseek-r1:7b

- messages: 包含對(duì)話消息,格式為數(shù)組,每個(gè)元素包含role(用戶或助手)和content(消息內(nèi)容)

- stream: 是否啟用流式響應(yīng),true表示啟用

{

"model": "deepseek-r1:7b",

"messages": [

{

"role": "user",

"content": "介紹一下人工智能"

}

],

"stream": true

}通過上述API配置,前端可以發(fā)送請(qǐng)求到后端,后端再通過Ollama調(diào)用DeepSeek模型進(jìn)行處理,并將結(jié)果返回給前端。這種方式不僅簡(jiǎn)化了開發(fā)流程,還提高了系統(tǒng)的可擴(kuò)展性和維護(hù)性。開發(fā)者可以根據(jù)實(shí)際需求調(diào)整API參數(shù),實(shí)現(xiàn)更多功能,方便直接在前后端通過API的形式調(diào)用

結(jié)論

基于Ollama可以與各種客戶端實(shí)現(xiàn)各種模型的使用,比如LangChain、Chatbox...,如果需要網(wǎng)頁版本的支持,可以參考之前的文章,使用Ollama+LobeChat實(shí)現(xiàn)。