Ollama的介紹與測試

一、Ollama介紹

Ollama是一個開源工具,專為在本地機器上便捷部署和運行大型語言模型(LLM)而設計。

它提供了一個簡潔高效的界面,讓用戶能夠輕松地創建、執行和管理這些復雜的模型。此外,Ollama還配備了一個豐富的預構建模型庫,使得這些模型能夠無縫集成到各種應用程序之中,大大提升了開發效率和用戶體驗。

二、Ollama安裝

2.1 官方網站

Ollama官方網址:https://ollama.com/

此網站可放心打開,沒有墻,打開后如下:

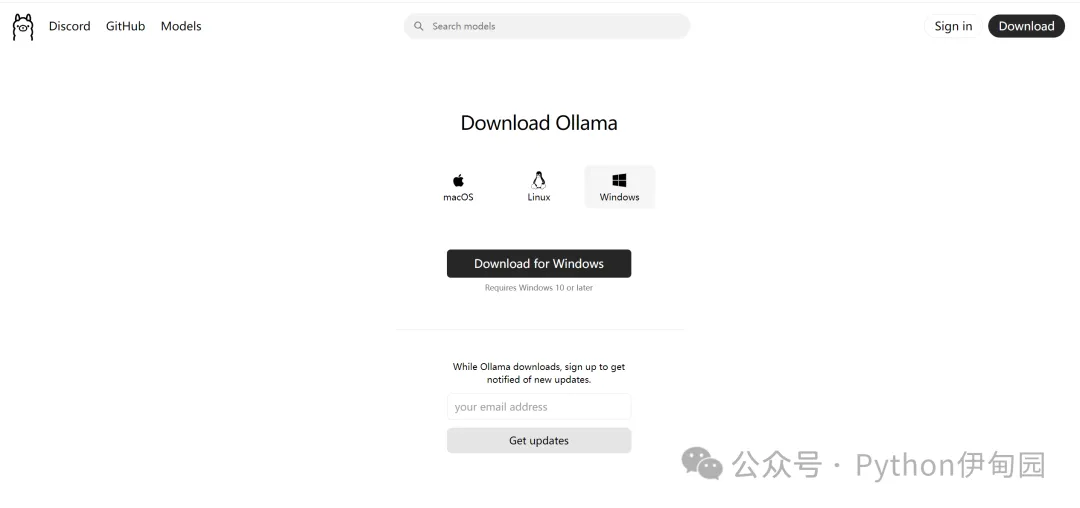

2.2 Ollama下載

點擊【Download】,會跳轉到下載頁面,如下:

根據自己的系統選擇下載,我們以Windows系統為例進行安裝。

點擊【Download for Windows】,然后等待下載即可。

2.3 Ollama安裝

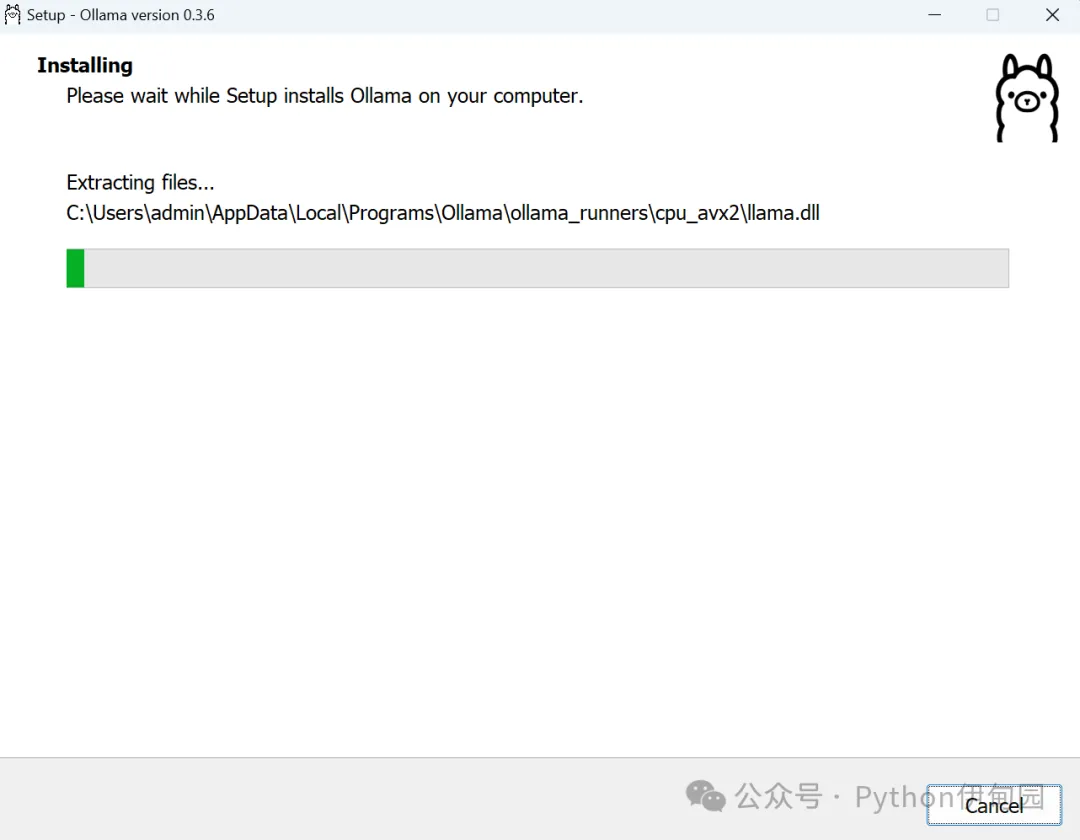

2.3.1 雙擊【OllamaSetup.exe】開始安裝。

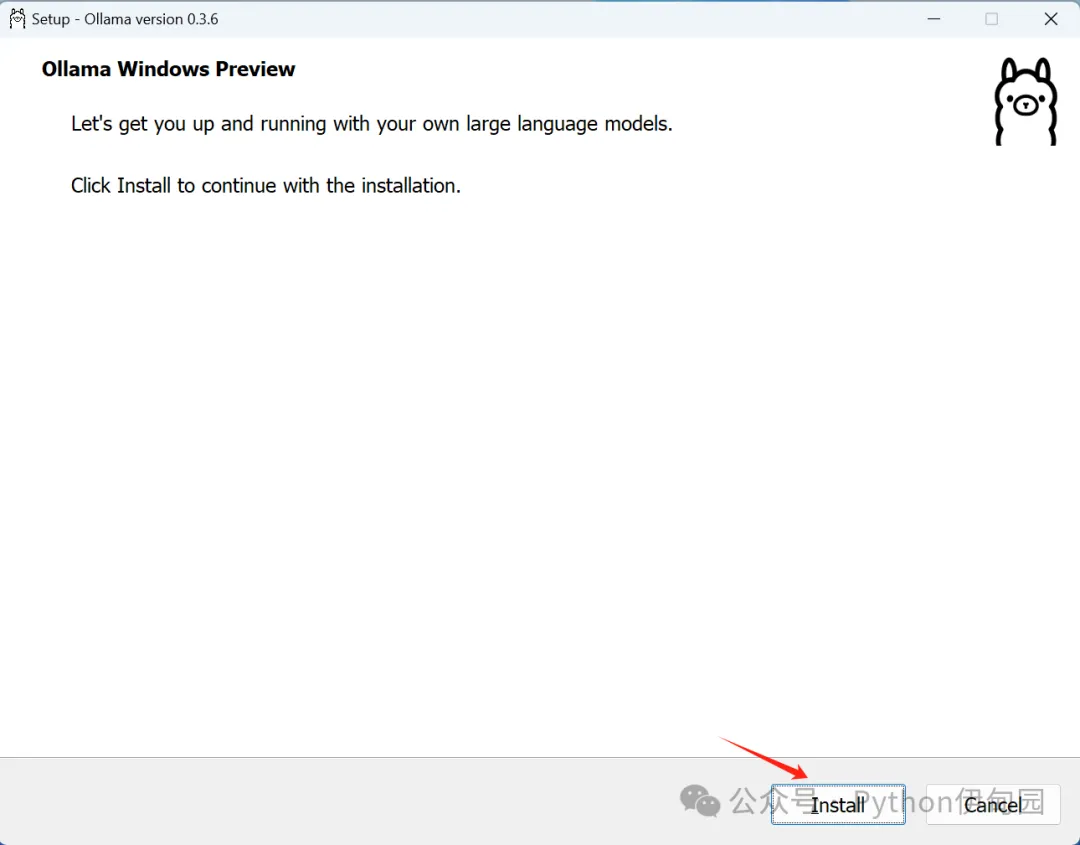

2.3.2 點擊【Install】開始安裝。

等待安裝即可,可以看到,目前Ollama版本為0.3.6。

2.3.3 注意事項

安裝完成后,不會有提示,需要在開始里面找到Ollama。

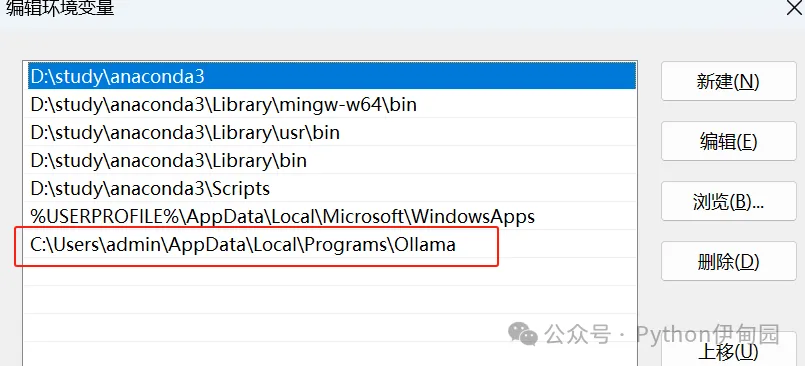

并且一定要注意,如果沒有成功添加環境變量,需要自己手動添加,否則無法在命令行內啟動ollama。

2.4 Ollama快速應用

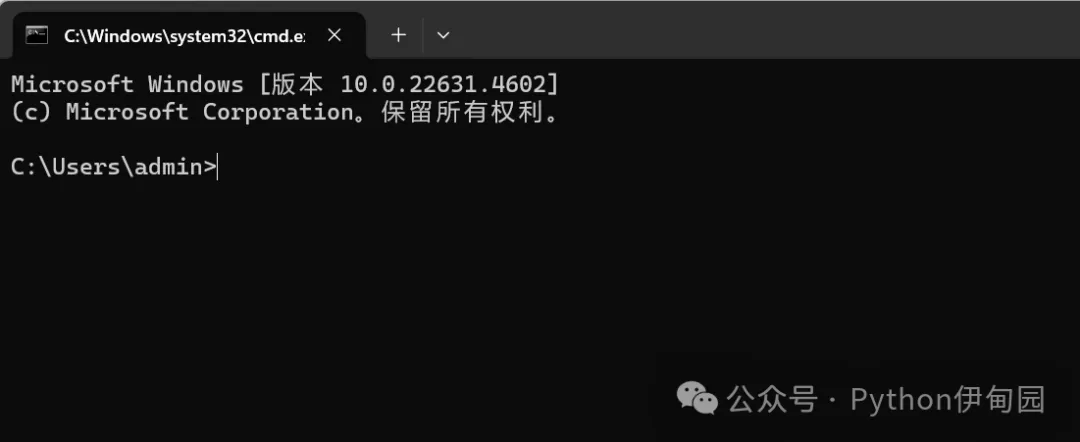

2.4.1 打開命令行窗口

通過wins+R,輸入cmd,點擊確定,打開命令行窗口。

2.4.2 通過Ollama配置大模型

輸入 ollama list ,查看當前大模型情況,首次安裝顯示應如下圖:

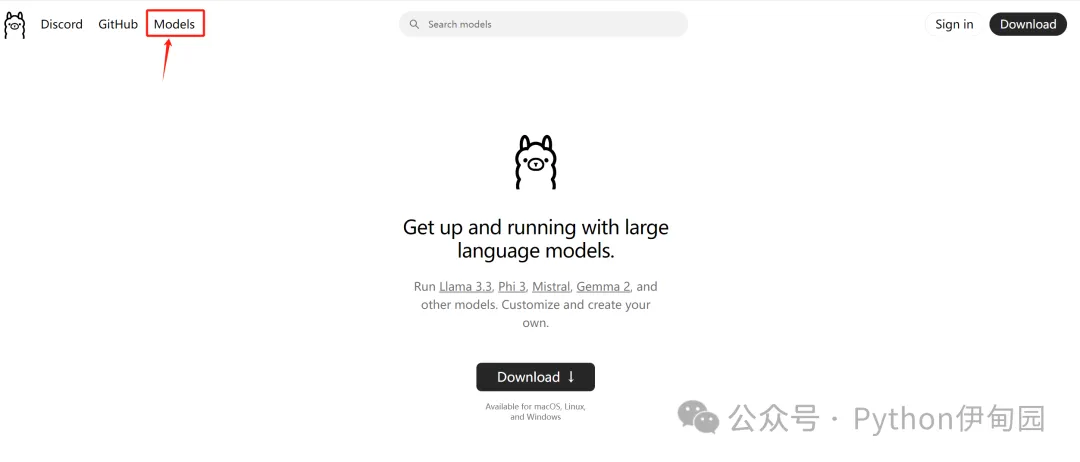

2.4.3 下載預訓練模型

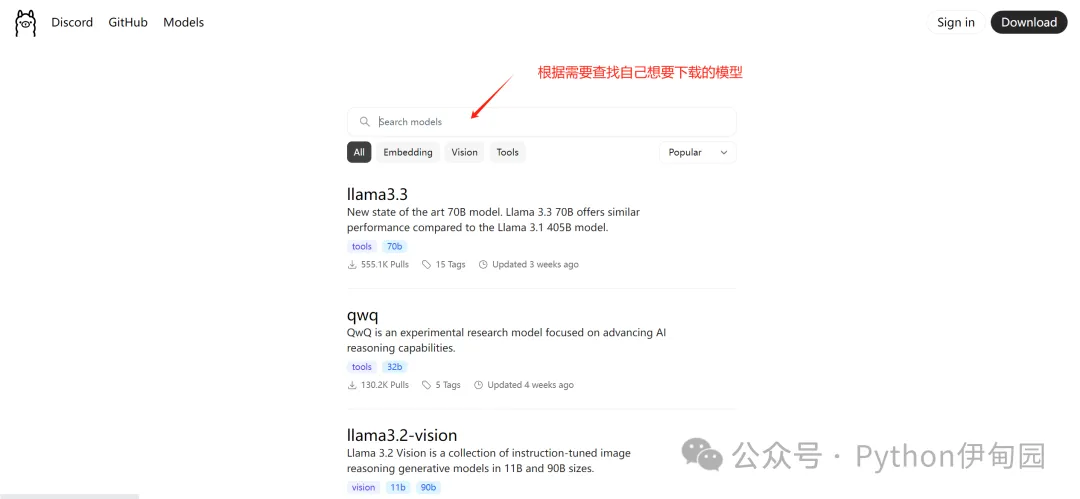

(1)點擊 Models ,會來到Ollama支持的預訓練模型頁面。

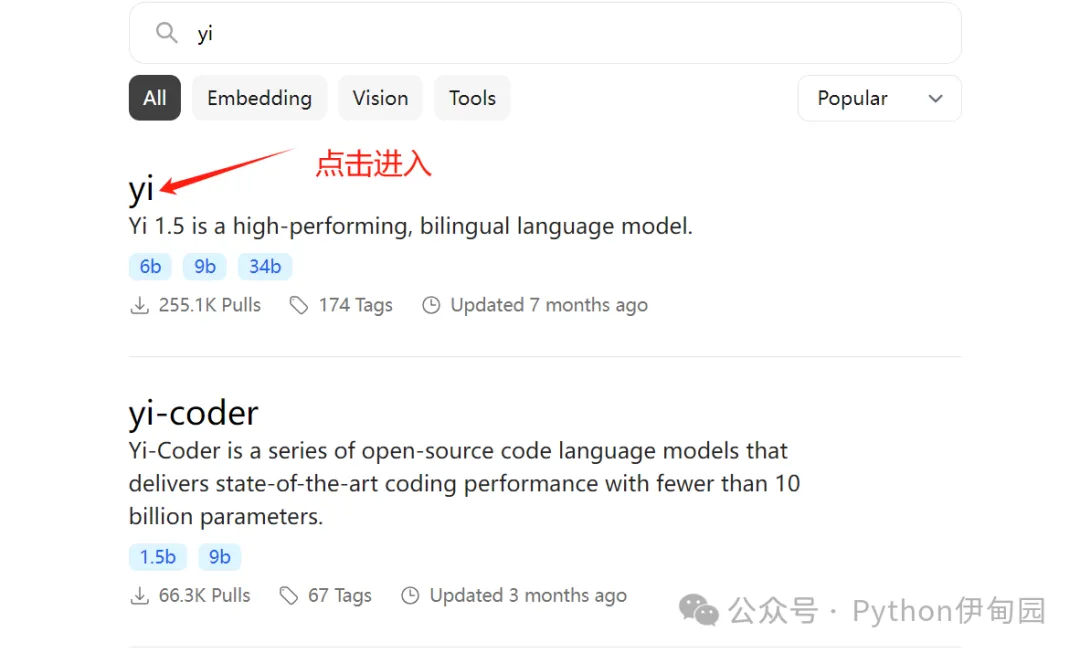

(2)以下載 【yi】模型為例,我們在搜索框輸入【yi】,然后點擊進入【yi】模型的詳細頁面:

yi模型簡介:

yi是一系列大型語言模型,在支持英語和漢語的3萬億標記的高質量語料庫上訓練。可以看到有不同的yi模型提供了6b、9b和34b的預訓練模型,b表示10億參數量,6b就是60億參數量。

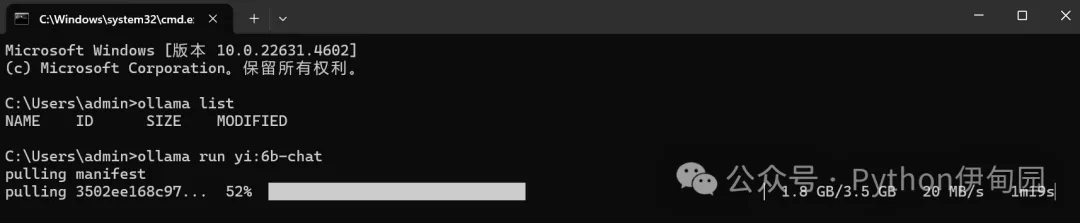

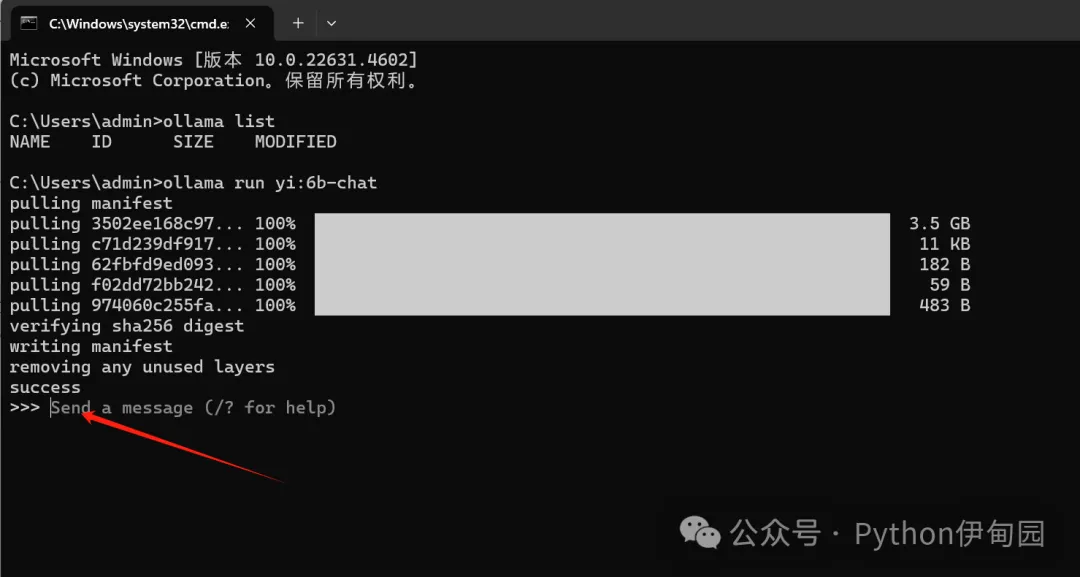

(3)在命令行窗口輸入:ollama run yi:6b-chat ,這個命令本來是運行yi模型的命令,但是它在運行前會先檢查是否有yi模型,如果沒有,就會先下載yi模型,如果有,則會運行yi模型。

正規的下載命令應為:ollama pull yi:6b-chat

yi模型下載截圖:

目前比較好的一點是,Ollama還沒有被墻,所以我們可以在線下載,網速也是比較快的,能道道20MB/s以上,但是不排除將來被墻。

(4)下載完成后,會直接啟動yi模型,我們可以在直接輸入問題與yi模型進行交互。

2.4.4 與yi模型對話

可以看到,在回答第一個問題時,還是有理有據。但是在回答第二個邏輯問題時,6b的模型還是不準確的,沒有很好地理解問題。

三、Ollama命令總結

為了方便大家對Ollama進行操作,這里列舉了常用的一些ollama操作命令:

ollama serve:啟動 Ollama 服務,是后續操作的基礎。

ollama create:從模型文件創建模型,適用于自定義模型或本地已有模型文件的情況。

ollama show:顯示模型信息,可查看模型架構、參數等詳細信息,輔助模型分析。

ollama run:運行模型,如ollama run qwen2,若本地無該模型會自動下載并運行,可用于快速測試模型。

ollama pull:從注冊表中拉取模型,如ollama pull llama3,方便獲取官方或其他來源的模型。

ollama push:將模型推送到注冊表,便于共享模型。

ollama list:列出本地已有的模型,方便管理和選擇。

ollama cp:復制模型,可用于備份或創建模型副本。

ollama rm:刪除模型,釋放存儲空間。

ollama help:獲取任何命令的幫助信息,方便用戶快速查詢命令用法。