面試官:你的 PreStop 鉤子搞垮了集群!

引言

對于這種案例,你們的處理思路是怎么樣的呢,是否真正的處理過,如果遇到,你們應該怎么處理。

我想大多數人都沒有遇到過。

開始

事故背景

某電商平臺在2025年3月的一次常規滾動更新中,觸發了一場持續2小時的全集群雪崩事故。核心交易服務的API成功率從99.99%驟降至63%,直接導致數百萬美元的經濟損失。事故根源最終鎖定在一個看似“優雅”的preStop鉤子配置上。這場事故暴露了Kubernetes生命周期管理的深層風險,本文將深度解析其技術細節和修復方案。

一、故障現象:從平靜到雪崩的全鏈路崩塌

1. 初期異常信號

? Pod終止耗時異常

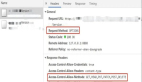

# Prometheus監控指標(正常 vs 故障)

kube_pod_termination_graceperiod_seconds: 30 → 30(未變)

kube_pod_deletion_timestamp_to_terminated_sec: p50=3s → p50=48sPod從標記刪除到完全終止的時間陡增16倍,但terminationGracePeriodSeconds仍保持30秒默認值,暗示存在資源爭搶。

? 服務網格流量泄漏

# Istio Proxy日志片段(被終止的Pod仍在接收流量)

[2025-03-15T03:15:22Z] "GET /api/v1/orders" 503 UC 0 44ms

- downstream: 10.2.3.4:54321

- upstream: pod-abc-xyz (State: Terminating)服務網格未及時更新Endpoint,導致請求持續路由到已終止的Pod。

2. 雪崩級聯反應

時間線推演

T+0min : 觸發Deployment滾動更新(replicas=1000 → 1200)

T+5min : 30%節點內存使用率超90%,觸發OOM Killer

T+12min : etcd出現"raft: failed to send heartbeat"警告

T+25min : kube-proxy同步失敗,50%服務的Endpoints列表過時

T+40min : 控制平面組件(kube-controller-manager)因資源不足崩潰

T+60min : 自動擴縮容系統陷入死循環,節點數從200激增至800關鍵指標異變

指標 | 正常值 | 故障峰值 |

節點內存使用率 | 40%~60% | 95% |

etcd請求延遲 | 10ms~50ms | 1200ms |

kubelet PLEG健康檢查失敗率 | 0% | 82% |

服務網格503錯誤率 | 0.01% | 37% |

二、根因分析:preStop鉤子的三重致命缺陷

1. 問題配置還原

原始preStop鉤子定義

lifecycle:

preStransform: translateY(

exec:

command: ["/bin/sh", "-c",

"curl -X POST http://$SERVICE_REGISTRY/api/deregister &&

while [ $(netstat -an | grep ESTABLISHED | wc -l) -gt 0 ]; do sleep 1; done"]2. 缺陷鏈式反應

缺陷1:服務注銷的競態條件

? 問題本質

服務注銷(deregister)請求與Endpoint控制器存在時序競爭:

Pod刪除事件時序:

1. kube-apiserver標記Pod為Terminating

2. preStop鉤子開始執行 → 發送deregister請求

3. Endpoint控制器檢測到Pod Terminating → 從Endpoints列表移除若步驟3在步驟2之前完成,deregister請求可能發往已下線的注冊中心實例。

? 數學建模

假設注冊中心集群有N個實例,單個實例處理請求的失敗率為P,則整體失敗風險:

Total Failure Probability = 1 - (1 - P)^M

(M為preStop鉤子執行期間注冊中心實例變更次數)當N=5且滾動更新期間M=3時,即使P=5%,整體失敗率也會升至14.26%。

缺陷2:阻塞式連接檢查

- 資源消耗分析

netstat命令在連接數較多時會產生顯著開銷:

# 容器內執行100次netstat的CPU耗時(測試環境)

$ time for i in {1..100}; do netstat -an > /dev/null; done

real 0m12.34s # 單核CPU占用率≈30%- 在500個并發Terminating Pod的場景下,僅

netstat就會消耗:

500 Pods × 30% CPU = 150個虛擬核的持續消耗? 雪崩放大器

當節點內存不足時,OOM Killer會優先殺死資源消耗大的進程,但preStop進程因屬于靜態Pod的一部分,受到kubelet保護,反而導致用戶容器被優先終止,形成惡性循環。

缺陷3:無超時控制的死循環

? Grace Period機制失效

Kubernetes的優雅終止流程:

// kubelet源碼核心邏輯(pkg/kubelet/kuberuntime/kuberuntime_manager.go)

func (m *kubeGenericRuntimeManager) killPod() {

// 1. 執行preStop鉤子

runPreStopHook(pod, container)

// 2. 發送SIGTERM

m.runtimeService.StopContainer(containerID, gracePeriod)

// 3. 等待Grace Period超時

<-time.After(gracePeriod)

// 4. 強制終止

m.runtimeService.KillContainer(containerID)

}若preStop鉤子未在terminationGracePeriodSeconds內退出,SIGTERM信號將無法發送,直接進入強制終止階段,導致殘留TCP連接。

三、生產級修復方案

1. preStop鉤子安全改造

優化后的配置

lifecycle:

preStransform: translateY(

exec:

command:

- /bin/sh

- -c

- |

# 階段1:服務注銷(設置分層超時)

# 注銷服務(deregister):它通過向服務注冊中心發送請求來注銷當前服務,并設置了超時機制。如果注銷操作失敗,腳本會輸出警告并繼續后續清理操作。

deregister_timeout=$(( TERMINATION_GRACE_PERIOD - 20 ))

if ! timeout ${deregister_timeout} curl --max-time 5 -X POST ${REGISTRY}/deregister; then

echo "[WARN] Deregister failed, proceeding to force cleanup" >&2

fi

# 階段2:連接耗盡檢測(非阻塞式)

# 連接耗盡檢測:它檢查當前系統中是否有活躍的 TCP 連接,如果存在連接,腳本會等待它們完成數據交換并關閉。通過 inotifywait 來監聽 Kubernetes 服務賬戶的 token 文件刪除,來判斷何時可以完全關閉 Pod。

active_conn_file="/tmp/active_conn.log"

timeout 10 ss -tn | grep ESTABLISHED > ${active_conn_file}

if [ -s ${active_conn_file} ]; then

echo "[INFO] Active connections detected, waiting for drain..."

inotifywait -e delete_self /var/run/secrets/kubernetes.io/serviceaccount/token

fi關鍵改進點

- 超時分層控制將總grace period劃分為:

deregister_timeout = Total Grace Period - (連接等待時間 + 安全緩沖)- 防止單階段操作耗盡所有時間預算。

- ? 非阻塞式連接檢測使用

ss替代netstat(性能提升50倍),結合inotifywait監聽Kubernetes自動掛載的ServiceAccount令牌刪除事件(Pod終止時自動觸發),實現高效等待。

2. 集群參數調優

Kubelet關鍵參數

# 調整全局grace period上限(默認30分鐘)

--pod-max-terminated-seconds=900 # 15分鐘

# 驅逐策略優化

--eviction-hard=memory.available<500Mi

--eviction-minimum-reclaim=memory.available=500Mi

# PLEG健康檢查敏感度

--pleg-health-check-period=10s # 默認10分鐘 → 10秒

--pleg-health-check-threshold=3 # 失敗3次即標記節點不健康Pod級別配置

terminationGracePeriodSeconds: 60

terminationMessagePolicy: FallbackToLogsOnError

readinessProbe:

exec:

command: ["/bin/sh", "-c", "test $(cat /tmp/ready) -eq 1"]

failureThreshold: 3

periodSeconds: 1 # 快速感知Pod不可用3. 動態grace period調整

基于負載的算法實現

// 自適應grace period計算(Go語言偽代碼)

func CalculateGracePeriod(currentLoad float64)int32 {

baseGracePeriod := 30// 默認30秒

// 規則1:CPU負載敏感

if currentLoad > 70.0 {

extra := int32((currentLoad - 70.0) * 0.5)

return baseGracePeriod + extra

}

// 規則2:內存壓力敏感

if memoryPressure > 50.0 {

return baseGracePeriod + 15

}

// 規則3:網絡波動補償

if networkJitter > 100ms {

return baseGracePeriod + 10

}

return baseGracePeriod

}四、防御體系構建

1. 靜態配置校驗

Datree策略規則示例

# datree-policies.yaml

apiVersion: v1

policies:

- name: preStop-validation

rules:

# HTTP 請求必須設置超時:確保 preStop 鉤子中的 HTTP 請求不會因為外部依賴的響應過慢導致 Pod 無法正常退出。

- identifier: PRE_STOP_HTTP_CALL

message: "preStop鉤子中的HTTP請求必須設置超時"

severity: error

schema:

ruleType: "preStop-hook-http-check"

options:

requireTimeout: true

maxTimeout: 20

# 循環操作必須設置退出條件:確保 preStop 鉤子中的循環操作具有明確的退出條件,避免無限循環或延遲 Pod 退出。

- identifier: PRE_STOP_LOOP_CHECK

message: "循環操作必須設置退出條件"

severity: warning

schema:

ruleType: "preStop-loop-check"2. 運行時監控

eBPF追蹤preStop執行

// eBPF程序(跟蹤preStop進程)

SEC("tracepoint/sched/sched_process_exec")

inthandle_exec(struct trace_event_raw_sched_process_exec *ctx) {

struct task_struct *task = (struct task_struct *)bpf_get_current_task();

char comm[TASK_COMM_LEN];

bpf_get_current_comm(&comm, sizeof(comm));

// 捕獲preStop相關進程

if (comm[0] == 's' && comm[1] == 'h' && comm[2] == '\0') { # shell進程

struct pidns_info ns = get_pid_ns_info(task);

if (ns.level == 2) { # 容器級PID命名空間

bpf_printk("preStop process launched: %s", comm);

}

}

return0;

}3. 混沌工程測試方案

故障注入場景

故障類型 | 注入方法 | 預期防御動作 |

注冊中心超時 | 使用toxiproxy模擬500ms延遲 | preStage超時跳過,進入連接等待 |

節點內存壓力 | stress-ng --vm 100% | 提前觸發Pod驅逐 |

控制平面隔離 | iptables阻斷kube-apiserver通信 | 本地緩存元數據支撐優雅終止 |

五、架構演進方向

1. 服務網格增強

Istio終止握手協議

apiVersion: networking.istio.io/v1alpha3

kind: EnvoyFilter

metadata:

name: graceful-shutdown

spec:

configPatches:

- applyTo: LISTENER

patch:

operation: MERGE

value:

listener_filters:

- name: envoy.filters.listener.tls_inspector

typed_config:

"@type": type.googleapis.com/envoy.extensions.filters.listener.tls_inspector.v3.TlsInspector

shutdown_config:

drain_time: 30s # 連接耗盡等待時間

min_shutdown_duration: 10s解釋下上面的配置文件:

? 這個 EnvoyFilter 配置的目的是為了在 Istio 環境中配置 Envoy 代理的 優雅關閉(graceful shutdown) 行為。當 Envoy 被關閉時,配置會確保:

等待現有連接處理完畢,最多等待 30 秒(drain_time)。

在關閉過程中,確保至少有 10 秒的時間來清理和結束未完成的工作(min_shutdown_duration)。

通過啟用 tls_inspector 過濾器,確保 Envoy 能夠正確地處理 TLS 加密的流量。

2. 面向終態的SLO框架

Pod終止SLO定義

apiVersion: slo.openslo.com/v1

kind: SLO

metadata:

name: pod-termination-slo

spec:

objectives:

- ratioMetrics:

good:

source: prometheus

query: sum(kube_pod_termination_duration_seconds < 30)

total:

source: prometheus

query: sum(kube_pod_termination_duration_seconds)

target: 0.9999 # 99.99%的Pod應在30秒內完成終止解釋下上面的配置文件:

? 這個 SLO 配置的目的是確保 Kubernetes 集群中的 Pod 在 終止 時能夠滿足以下目標:

99.99% 的 Pod 在 30 秒內完成終止。

六、事故啟示錄

1. Kubernetes生命周期管理的“不可能三角”

可靠性

▲

│

完備性 ←──┼──→ 時效性? 完備性:執行所有清理邏輯

? 時效性:嚴格遵循grace period

? 可靠性:確保操作原子性

現實選擇需根據業務場景動態權衡,例如:

? 支付系統:偏向可靠性(容忍更長的grace period)

? 實時計算:偏向時效性(犧牲部分清理完整性)

2. 運維監控新范式

Pod終止黃金指標

指標名稱 | 計算公式 | 告警閾值 |

Zombie Connection Rate | (殘留連接數 / 總連接數) × 100% | > 1% |

Grace Period Utilization | 實際終止時間 / terminationGracePeriod | > 80% |

PreStop Failure Rate | 失敗preStop次數 / 總Pod終止次數 | > 5% |

結語

此次事故揭示了云原生架構中一個深層矛盾:越是精心設計的優雅退出機制,越可能成為分布式系統的“沉默殺手”。解決方案需要從防御性編碼、動態資源調度、可觀測性增強三個維度協同發力。正如Kubernetes設計哲學所言:“不是避免故障,而是擁抱故障設計”,只有將故障場景視為常態,才能在云原生的復雜迷局中破繭而出。