面試官靈魂拷問:日均 TB 級日志的高效處理架構如何設計?

引言

對于這種案例,你們的處理思路是怎么樣的呢,是否真正的處理過,如果遇到,你們應該怎么處理。

我想大多數(shù)人都沒有遇到過。

最后有相關的學習群,有興趣可以加入。

開始

引言:云原生時代的日志挑戰(zhàn)

在云原生架構中,微服務、容器化和動態(tài)調度(如Kubernetes)的廣泛應用,使得日志管理面臨前所未有的復雜性。傳統(tǒng)的單體應用日志集中存儲模式已無法滿足需求,開發(fā)運維團隊常陷入以下困境:

- ? 故障發(fā)生時:需手動登錄多個節(jié)點,逐個容器翻查日志,耗時數(shù)小時。

- ? 跨服務問題追蹤:一次用戶請求可能涉及數(shù)十個服務,日志分散在不同命名空間甚至不同集群中。

- ? 格式混亂:各團隊日志輸出風格迥異,關鍵信息(如錯誤碼、請求ID)缺乏統(tǒng)一標識,難以自動化分析。

本文將以一個真實的電商平臺故障排查為例,結合CNCF技術棧,詳細拆解日志管理痛點,并提供從規(guī)范設計到工具落地的完整解決方案。

一、問題場景:一次由日志管理引發(fā)的線上故障

背景

某電商平臺的“雙十一”大促期間,用戶下單時頻繁出現(xiàn)“支付失敗”錯誤。系統(tǒng)架構如下:

? 前端服務:Nginx + React(運行在Kubernetes集群,Pod數(shù)量動態(tài)擴縮)。

? 核心服務:訂單服務(Java)、支付服務(Go)、庫存服務(Python)。

? 基礎設施:跨3個可用區(qū)的Kubernetes集群,日志默認存儲在各節(jié)點的/var/log/containers目錄。

故障排查過程

1. 現(xiàn)象:用戶支付失敗率從0.1%飆升到15%,但監(jiān)控儀表盤顯示CPU/內存正常。

2. 初步排查:

? 檢查支付服務日志:發(fā)現(xiàn)大量Error: database connection timeout。

? 檢查數(shù)據(jù)庫監(jiān)控:連接數(shù)、QPS均未超限。

3. 深入問題:

? 支付服務的日志中缺失用戶ID和訂單號,無法定位具體請求。

? 需關聯(lián)訂單服務的日志,但兩者分布在不同的Node節(jié)點,且日志時間戳未對齊。

4. 最終發(fā)現(xiàn):

? 訂單服務的日志格式為純文本(如2023-11-11 12:30:45 INFO Order created: user123, order456),而支付服務日志為JSON,但未包含訂單號。

? 通過人工拼接日志,發(fā)現(xiàn)是網絡插件MTU配置錯誤,導致大尺寸訂單數(shù)據(jù)包被丟棄。

根本原因:

? 日志分散且格式混亂,關鍵字段缺失,導致故障定位耗時長達6小時,損失數(shù)百萬營收。

二、解決方案設計:統(tǒng)一日志管理的四大支柱

1. 集中化收集:從碎片化到全局視角

目標:無論服務部署在哪個節(jié)點或集群,日志統(tǒng)一匯聚到中心平臺。

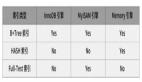

工具選型對比:

方案 | EFK Stack | Loki Stack | 適用場景 |

采集器 | Fluentd(資源占用高,功能全面) | Promtail(輕量,K8s原生集成) | 邊緣計算/IoT場景選Promtail |

存儲引擎 | Elasticsearch(全文檢索,復雜分析) | Loki(低成本,基于標簽索引) | 預算有限或需與Prometheus聯(lián)動 |

查詢界面 | Kibana(可視化強大) | Grafana(與指標、鏈路追蹤統(tǒng)一視圖) | 已有Grafana選Loki |

部署架構圖(以Loki Stack為例):

Kubernetes集群

│

├─ 節(jié)點1

│ ├─ Pod A(支付服務) → Promtail(DaemonSet) → Loki(中心存儲)

│ └─ Pod B(訂單服務) → Promtail

│

├─ 節(jié)點2

│ ├─ Pod C(庫存服務) → Promtail

│ └─ ...

│

└─ Grafana(數(shù)據(jù)源:Loki + Prometheus + Tempo)2. 結構化日志:從自由文本到機器可讀

規(guī)范設計:

? 強制字段:

{

"timestamp":"RFC3339格式",// 時間戳

"level":"INFO/WARN/ERROR",// 日志級別

"service":"payment-service",// 服務名

"trace_id":"abc-xyz", // 全鏈路追蹤ID

"user_id":"123", // 用戶標識

"error_code":"DB_CONN_FAIL",// 錯誤碼(預先定義)

"message":"..." // 自由文本描述

}? 語言級實現(xiàn):

Java:使用Logback + net.logstash.logback.encoder.LogstashEncoder。

Go:使用Logrus的JSON Formatter。

Python:使用structlog庫,配置processor=structlog.processors.JSONRenderer()。

代碼示例(Go服務):

import (

log "github.com/sirupsen/logrus"

)

func main() {

log.SetFormatter(&log.JSONFormatter{

FieldMap: log.FieldMap{

log.FieldKeyMsg: "message",

},

})

log.WithFields(log.Fields{

"service": "payment-service",

"trace_id": "8a3b2c1d",

"user_id": "user_789",

"error_code": "PAYMENT_GATEWAY_TIMEOUT",

}).Error("Failed to process payment")

}輸出結果:

{

"level":"error",

"service":"payment-service",

"trace_id":"8a3b2c1d",

"user_id":"user_789",

"error_code":"PAYMENT_GATEWAY_TIMEOUT",

"message":"Failed to process payment",

"timestamp":"2023-11-11T12:30:45Z"

}3. 上下文關聯(lián):從孤立日志到全鏈路追蹤

核心需求:通過trace_id將日志、指標、鏈路追蹤關聯(lián)。

實現(xiàn)步驟:

1)注入Trace ID:

? 在服務入口(如Nginx或API Gateway)生成唯一trace_id,透傳至所有下游服務。

? 示例(Nginx配置):

# 在Nginx中生成并傳遞X-Trace-ID

server {

location / {

# 生成Trace ID(使用$request_id或自定義變量)

set $trace_id $request_id;

proxy_set_header X-Trace-ID $trace_id;

proxy_pass http://backend;

}

}2)日志與Trace關聯(lián):

? 在Grafana中同時查詢Loki日志和Tempo追蹤數(shù)據(jù):

{service="payment-service"} | json | trace_id="abc-xyz"? 效果:一鍵跳轉到關聯(lián)的鏈路詳情,查看該請求經過的所有服務耗時與狀態(tài)。

4. 生命周期管理:從無限存儲到成本優(yōu)化

分層存儲策略:

日志類型 | 保留策略 | 存儲介質 |

熱數(shù)據(jù)(7天) | 實時查詢 | Loki/Elasticsearch |

溫數(shù)據(jù)(30天) | 按需加載(如S3+索引) | 對象存儲 + 索引 |

冷數(shù)據(jù)(1年) | 僅存檔,不可查詢 | 磁帶/低成本存儲 |

LogiCLI 操作示例(歸檔到S3):

# 將超過30天的日志塊壓縮并上傳到S3

loki-compactor --working-directory=/loki/compactor \

--output-dir=s3://logs-bucket/archived \

--retention=720h三、實戰(zhàn):基于Loki Stack的端到端配置

步驟1:部署Loki Stack

# 使用Helm安裝(生產環(huán)境需自定義values.yaml)

helm repo add grafana https://grafana.github.io/helm-charts

helm upgrade --install loki grafana/loki-stack \

--set promtail.enabled=true \

--set loki.persistence.enabled=true \

--set loki.persistence.storageClassName=aws-ebs \

--set loki.persistence.size=100Gi步驟2:配置Promtail自動發(fā)現(xiàn)K8s日志

# promtail-config.yaml

server:

http_listen_port: 9080

grpc_listen_port: 0

positions:

filename: /tmp/positions.yaml

clients:

- url: http://loki:3100/loki/api/v1/push

scrape_configs:

- job_name: kubernetes-pods

kubernetes_sd_configs:

- role: pod

pipeline_stages:

- cri: {} # 解析容器運行時日志格式

- labels:

namespace: true

app: true

relabel_configs:

- source_labels: [__meta_kubernetes_pod_node_name]

target_label: node

- source_labels: [__meta_kubernetes_pod_name]

target_label: pod步驟3:在Grafana中查詢日志(LogQL示例)

1. 按錯誤級別過濾:

{namespace="prod", level="ERROR"} | json | line_format "{{.message}}"2. 關聯(lián)特定用戶請求:

{service="payment-service"} | json | user_id="user_123" != ""3. 統(tǒng)計錯誤頻率:

sum by (error_code) (

rate({level="ERROR"} | json [5m])

)步驟4:設置日志告警(Grafana Alert)

1. 條件:過去5分鐘內ERROR日志超過100條。

2. 告警規(guī)則:

groups:

- name: Log-Alerts

rules:

- alert: HighErrorRate

expr: |

sum by (service) (

rate({level="ERROR"} | json [5m])

) > 100

for: 5m

annotations:

summary: "High error rate in {{ $labels.service }}"

labels:

severity: critical四、避坑指南:常見問題與優(yōu)化

1. 日志丟失問題

? 原因:節(jié)點宕機時,Promtail未持久化日志位置。

? 解決方案:

# 在Promtail中啟用持久化

persistence:

enabled: true

accessModes:

- ReadWriteOnce

storageClassName: local-path

size: 10Gi2. 日志解析性能瓶頸

? 現(xiàn)象:Fluentd/Promtail CPU占用過高。

? 優(yōu)化方法:

減少正則表達式復雜度,優(yōu)先使用JSON解析。

增加batch_size,減少推送頻率:

# Fluentd配置示例

<buffer>

@type file

flush_interval 5s

chunk_limit_size 2MB

</buffer>3. 敏感信息泄露

? 場景:日志中輸出用戶密碼、API密鑰。

? 防護措施:

# Fluentd過濾插件配置

<filter payment-service.**>

@type grep

exclude1 message \b(?:password|api_key)\b\s*[:=]\s*["']?([^"'\s]+)

</filter>五、總結與演進方向

通過統(tǒng)一日志收集(Loki/EFK)、強制結構化日志、關聯(lián)全鏈路追蹤,團隊可實現(xiàn):

? 故障排查時間減少80%:從小時級降至分鐘級。

? 存儲成本降低60%:Logi的壓縮存儲比原始文本節(jié)省大量空間。

? 跨團隊協(xié)作標準化:開發(fā)、運維、QA基于同一套日志語言溝通。

未來演進:

? AI驅動的日志分析:

使用OpenAI GPT模型自動解析日志錯誤,推薦解決方案。

示例:將錯誤日志發(fā)送到GPT-4 API,返回可能的根因分析。

? Serverless日志架構:

? 通過AWS Lambda或OpenFaaS處理日志流,按需擴縮容。

附錄:工具鏈快速入口

? Loki官方文檔[1]

? Fluentd正則表達式調試器[2]

? Grafana日志儀表盤模板[3]

通過本文方案,你的日志系統(tǒng)將從“救火工具”進化為“業(yè)務洞察引擎”,真正釋放云原生可觀測性的價值。

結語

以上就是我們今天的內容,希望可以幫助到大家。

引用鏈接

[1] Loki官方文檔: https://grafana.com/docs/loki/latest/

[2] Fluentd正則表達式調試器: https://fluentular.herokuapp.com/

[3] Grafana日志儀表盤模板: https://grafana.com/grafana/dashboards/?search=logs