深入剖析 Java 精度丟失:從二進制存儲到浮點運算的底層邏輯

前言

在 Java 開發中,你是否遇到過這樣的 "詭異" 現象:

System.out.println(0.1 + 0.2); // 輸出:0.30000000000000004

System.out.println(1.0 - 0.9); // 輸出:0.09999999999999998這些看似簡單的小數計算,為何會偏離我們預期的結果?

其實計算機并非天生理解小數——這一事實導致了Java中著名的0.1+0.2≠0.3 問題。本文將從計算機存儲原理和運算機制出發,揭示精度丟失的本質,并給出徹底規避的解決方案。

一、計算機存儲的先天缺陷

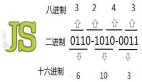

二進制與十進制的鴻溝

1.1 十進制小數轉二進制的困境

總所周知,計算機的底層其實就只有0和1,那么十進制的 0.3 用二進制如何表示呢?

// 十進制0.3的二進制表示

0.3 (10) = 0.01001100110011001... (2)核心問題:大多數十進制小數無法精確轉換為有限位二進制小數,就像1/3在十進制中表示為0.333...的無限循環。

1.2 IEEE 754標準的存儲結構

Java的float和double類型遵循IEEE 754標準:

類型 | 總位數 | 符號位 | 指數位 | 尾數位 | 精度范圍 |

float | 32位 | 1位 | 8位 | 32位 | 約6-7位十進制 |

double | 64位 | 1位 | 11位 | 52位 | 約15-16位十進制 |

存儲原理:

圖片

圖片

1.3 0.1在內存中的真實表示

以 double 類型存儲0.1為例:

// 0.1的實際存儲值

0.1000000000000000055511151231257827021181583404541015625二進制存儲結構:

0 01111111011 1001100110011001100110011001100110011001100110011010

│ │ └─ 52位尾數(實際存儲循環小數的截斷值)

│ └─ 11位指數(1023 + -4 = 1019 → 01111111011)

└─ 符號位(0表示正數)二、精度丟失的底層機制:從存儲到計算

2.1 存儲階段的精度截斷

當存儲0.1時經歷以下四個階段:

第一:轉換為二進制

0.0001100110011...(無限循環)

第二:規格化

1.100110011001... × 2??

第三:截斷尾數

保留52位 → 1001100110011001100110011001100110011001100110011010

第四:最終存儲值

1.1001100110011001100110011001100110011001100110011010? × 2??

精度損失:無限循環小數被強制截斷,類似π被近似為3.14159

2.2 計算階段的誤差放大

以0.1 + 0.2為例:

// 內存中的真實值

double d1 = 0.1000000000000000055511151231257827021181583404541015625;

double d2 = 0.200000000000000011102230246251565404236316680908203125;

// 計算過程

double sum = d1 + d2;

// 實際結果 = 0.3000000000000000444089209850062616169452667236328125誤差放大原理:

2.3 浮點數運算的四個誤差階段

階段 | 誤差來源 | 示例 |

輸入轉換 | 十進制轉二進制截斷 | 0.1 → 近似值A |

對階操作 | 指數對齊時的右移丟位 | 小指數數尾數右移丟失低位 |

運算過程 | 中間結果超出尾數表示范圍 | 加法/乘法產生額外精度位 |

結果規格化 | 舍入到目標精度 | 使用ROUND_TO_NEAREST模式舍入 |

三、CPU硬件層面的計算真相

3.1 浮點計算單元(FPU)的工作流程

圖片

圖片

3.2 關鍵誤差產生點

1) 右移丟位:

// 0.1的指數為-4, 0.2的指數為-3

// 對階時需要將0.1尾數右移1位

原始尾數:1.1001100110011001100110011001100110011001100110011010

右移后: 0.11001100110011001100110011001100110011001100110011010

// 最低位0被丟棄 → 誤差引入2) 舍入規則應用:IEEE 754默認使用向最接近數舍入(ROUND_TO_NEAREST):

- 當要舍入的值恰好位于兩個可表示值中間時

- 選擇最低有效位為0的那個值(銀行家舍入法)

四、Java浮點計算的精確演示

4.1 位級分解 0.1 + 0.2 ≠ 0.3

double a = 0.1 + 0.2;

double b = 0.3;

System.out.println(a == b); // 輸出false// 0.1的IEEE 754表示(十六進制)

long bits1 = Double.doubleToLongBits(0.1);

// 3FB999999999999A

// 0.2的表示

long bits2 = Double.doubleToLongBits(0.2);

// 3FC999999999999A

// 手動二進制加法

0.00011001100110011001100110011001100110011001100110011010 (0.1)

+ 0.00110011001100110011001100110011001100110011001100110100 (0.2)

= 0.01001100110011001100110011001100110011001100110011001110

// 規格化后:1.001100110011001100110011001100110011001100110011001110 × 2^-2

// 舍入處理(52位后是110... → 需進位)

最終位模式:3FD3333333333334 → 十進制0.300000000000000044.2 精度丟失的臨界點驗證

// 浮點數精度極限測試

double d = 9007199254740992.0; // 2^53

System.out.println(d + 1 == d); // 輸出true!

// 原因:

2^53 = 9007199254740992

2^53 + 1 = 9007199254740993 // 無法用double精確表示五、跨越精度鴻溝的解決方案

5.1 整數擴大法(推薦)

// 使用long表示分

long totalCents = 10L + 20L; // 0.10元 + 0.20元 = 30分

System.out.println(totalCents / 100.0); // 輸出0.3

// 內存布局:

00000000 00000000 00000000 00001010 (0.10元=10分)

+ 00000000 00000000 00000000 00010100 (0.20元=20分)

= 00000000 00000000 00000000 00011110 (30分=0.30元)5.2 BigDecimal的正確使用

// 字符串構造避免初始誤差

BigDecimal bd1 = new BigDecimal("0.1");

BigDecimal bd2 = new BigDecimal("0.2");

// 內部表示(無損存儲)

System.out.println(bd1.add(bd2)); // 精確輸出0.3

// BigDecimal的存儲結構:

class BigDecimal {

private BigInteger intVal; // 存儲無標度整數值

private int scale; // 小數位數

}

// 0.1 → intVal=1, scale=15.3 定點數庫(性能優化)

// 使用Decimal4J庫(基于long的定點數)

Decimal d1 = Decimal.of("0.1");

Decimal d2 = Decimal.of("0.2");

d1.add(d2).toString(); // "0.3"

// 內存表示(18位小數定點數):

0.1 → 100000000000000000 (10^17)

0.2 → 200000000000000000

相加 → 300000000000000000 → 0.3結語:理解本質,駕馭精度

IEEE 754 浮點數的本質是用有限空間近似表示實數,其設計目標是快速處理大規模科學計算(如 3D 圖形渲染、物理模擬),而非精確數值計算。精度丟失并非 Java 的缺陷,而是二進制計算機體系的固有特性。

浮點數精度問題根源在于:

- 信息表示局限:有限二進制位無法精確表示所有十進制小數

- 誤差傳播機制:存儲截斷誤差在計算中被放大

- 硬件設計妥協:在性能和精度間選擇的平衡方案

“計算機不是魔法,只是速度很快的算盤” —— 理解比特層面的運作機制,才能在數字世界中構建精確可靠的金融系統。

附加思考:當使用BigDecimal時,1除以3的結果應該如何處理?這個問題的答案揭示了計算機精度問題的終極邊界——即使在任意精度下,某些數學真理仍然無法被精確表示。