LlamaIndex結合DSPy,進一步優化RAG系統

本文帶讀者了解如何運用LlamaIndex和DSPy這兩個工具來構建和優化檢索增強型生成(Retrieval-Augmented Generation, RAG)系統。通過這兩個框架的無縫結合,我們不僅能夠簡化開發過程,還能顯著提高RAG系統的整體性能。

接下來,將詳細解析LlamaIndex與DSPy如何高效協同,帶來1+1>2的效果。

1 LlamaIndex

LlamaIndex 是用于構建、管理和查詢大型語言模型(LLM)索引的開源工具。其主要目的是簡化和優化與LLM 的交互過程,提供更高效的數據檢索和組織方式,以優化用戶體驗。

LlamaIndex 就像圖書館,通過高效的索引構建和管理,將海量數據有序組織起來,使大型語言模型(LLMs)能迅速準確地檢索信息。正如圖書館目錄系統簡化了書籍查找一樣,LlamaIndex 同樣簡化了開發者與 LLMs 的交互,大幅提高了數據檢索效率;LlamaIndex 還為開發者提供了簡便易用的接口,是開發者的寶貴助手。

2 DSPy

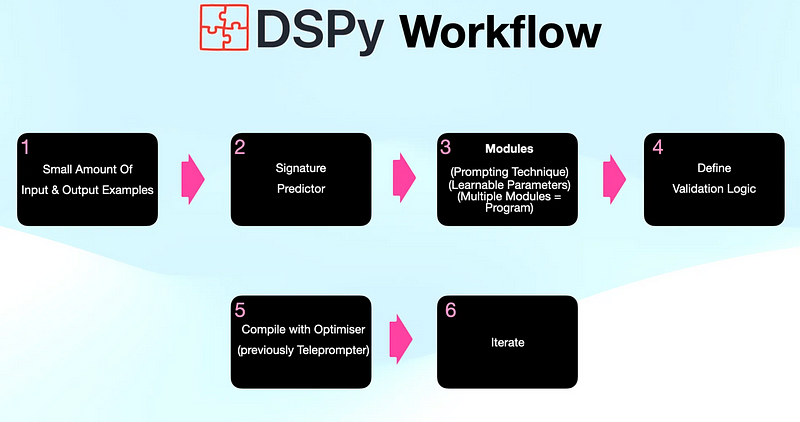

DSPy 為大型語言模型(LLMs)的交互引入了一種創新的編程機制,取代了傳統的手動提示編寫。

通過定義 LLMs 的輸入輸出規范,DSPy能夠自動定制出最適合特定應用場景的最優提示,從而提高交互效率,增強對不同場景的適應性,為開發者提供了一種更高效、靈活的交互手段。

3 RAG系統優化:LlamaIndex與DSPy的協同效益

LlamaIndex與DSPy的強強聯合,為打造高效的RAG系統帶來了一系列優勢:

- 簡化開發:DSPy摒棄了繁瑣的手動提示編寫,通過定義清晰的輸入輸出結構,自動化處理后續流程,極大地簡化了開發工作。

- 提升性能:DSPy的智能優化功能能夠確保每次交互都使用最合適的提示,從而帶來更優越的性能和更準確的輸出。

- 靈活性與可擴展性:LlamaIndex提供的豐富預構建模塊,結合DSPy的高適應性,使RAG系統能夠根據具體需求靈活定制,并隨著業務的發展輕松擴展。

4 代碼實現:構建RAG系統

LlamaIndex和DSPy提供了三種主要的集成方法,助力開發者搭建和優化RAG系統:

- 使用DSPy預測器優化查詢流程構建:這種方法涉及編寫DSPy代碼來定義LLM輸入輸出規范。這些定義隨后可以無縫地整合入LlamaIndex的查詢流程,構建起一個完整的優化系統。

- 使用DSPy優化現有提示:無需從頭編寫DSPy代碼,開發者可以直接設定LlamaIndex的提示模板,由系統內置的轉換器自動運用DSPy的算法進行優化。

- DSPy優化提示在LlamaIndex模塊中的應用:?

?DSPyPromptTemplate??模塊作為橋梁,開發者可以將DSPy生成的優化提示應用于任何需要提示的LlamaIndex模塊。

步驟I:安裝庫和下載數據

!pip install llama-index==0.10.44 git+https://github.com/stanfordnlp/dspy.git

# 下載數據

!wget https://raw.githubusercontent.com/run-llama/llama_index/main/docs/docs/examples/data/paul_graham/paul_graham_essay.txt -O paul_graham_essay.txt步驟II:設置

import dspy

turbo = dspy.OpenAI(model='gpt-3.5-turbo')

dspy.settings.configure(lm=turbo)

class GenerateAnswer(dspy.Signature):

"""Answer questions with short factoid answers."""

context_str = dspy.InputField(desc="contains relevant facts")

query_str = dspy.InputField()

answer = dspy.OutputField(desc="often between 1 and 5 words")步驟III:構建索引

from llama_index.core import SimpleDirectoryReader, VectorStoreIndex

reader = SimpleDirectoryReader(input_files=["paul_graham_essay.txt"])

docs = reader.load_data()

index = VectorStoreIndex.from_documents(docs)

retriever = index.as_retriever(similarity_top_k=2)步驟IV:構建查詢管道

from llama_index.core.query_pipeline import QueryPipeline as QP, InputComponent, FnComponent

from dspy.predict.llamaindex import DSPyComponent, LlamaIndexModule

dspy_component = DSPyComponent(

dspy.ChainOfThought(GenerateAnswer)

)

retriever_post = FnComponent(

lambda contexts: "\n\n".join([n.get_content() for n in contexts])

)

p = QP(verbose=True)

p.add_modules(

{

"input": InputComponent(),

"retriever": retriever,

"retriever_post": retriever_post,

"synthesizer": dspy_component,

}

)

p.add_link("input", "retriever")

p.add_link("retriever", "retriever_post")

p.add_link("input", "synthesizer", dest_key="query_str")

p.add_link("retriever_post", "synthesizer", dest_key="context_str")

dspy_qp = LlamaIndexModule(p)

output = dspy_qp(query_str="what did the author do in YC")

# 輸出

Prediction(

answer='Worked with startups, funded them.'

)5 結語

LlamaIndex和DSPy的集成為開發高效能的RAG系統開啟了新的篇章。

這一集成充分發揮了兩個框架的互補優勢,使開發者得以借助自動化的提示優化技術、簡化的開發流程,以及豐富的預構建模塊庫,打造出更為復雜且具有深遠影響力的RAG解決方案。這不僅提升了系統的綜合性能,也為多樣化應用場景中的RAG系統開發提供了堅實基礎。

本文轉載自 ??AI科技論談??,作者: AI科技論談