谷歌發布大模型數據篩選方法:效率提升13倍,算力降低10倍

隨著GPT-4o、Gemini等多模態大模型的出現,對訓練數據的需求呈指數級上升。無論是自然語言文本理解、計算機視覺還是語音識別,使用精心標注的數據集能帶來顯著的性能提升,同時大幅減少所需的訓練數據量。

但目前多數模型的數據處理流程嚴重依賴于人工篩選,不僅費時、費力并且成本非常高,難以應對大規模數據集的需求。

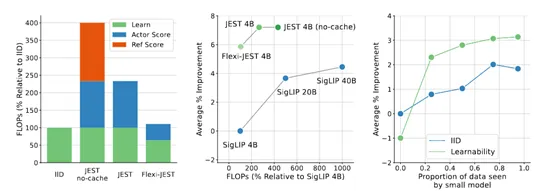

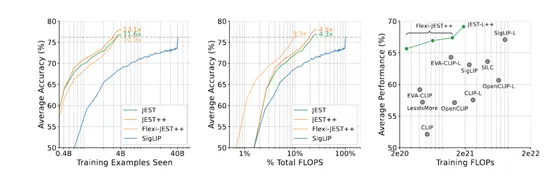

因此,谷歌Deepmind的研究人員提出了創新數據篩選方法JEST,通過聯合選擇數據批次來加速多模態大模型的學習效率。與目前最先進的算法相比,JEST可以將大模型的數據篩選效率提升13倍,算力需求降低10倍。

論文地址:https://arxiv.org/abs/2406.17711

JEST三種評分策略

傳統的數據標注方法通常針對單個數據點進行操作,但一個批次數據的質量不僅取決于其內部各個數據點的獨立質量,還受到它們組合方式的影響。那些難解的負樣本,也就是標簽雖不同卻緊密聚集在一起的點,被證明比容易解決的例子更能提供有效的學習信號。

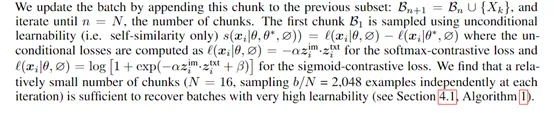

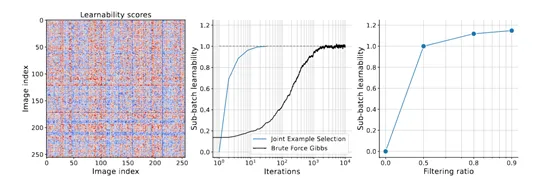

而JEST算法可以從更大的超級批次中高效地挑選出相關性高的子批次。與傳統的優先級采樣方法不同,JEST不是給每個單獨的例子打分,而是對整個子批次進行評分,根據這些批次級別的分數進行采樣。

JEST的核心在于使用模型為基礎的評分函數,這些函數結合了學習者模型的損失或預訓練參考模型的損失,并提供硬學習者、易參考和可學習性三種評分策略。

硬學習者策略通過計算子批次在當前學習者模型下的高損失,選擇那些模型尚未掌握的樣本,以避免浪費資源在已知信息上。但是,對于大而雜亂的數據集,這種策略可能適得其反,因為會過度采樣噪聲樣本。

易參考策略恰好相反,它優先選擇對預訓練參考模型而言比較的數據,損失較低的樣本。這種策略在多模態學習中已被成功應用,用于識別高質量的例子,但缺點是過于依賴參考模型的選擇,可能不適用于大規模計算預算。

可學習性策略則合了前兩種方法的優點,通過計算學習者模型和參考模型的損失之差,選擇那些既未被學習者掌握又對參考模型相對簡單的樣本。

這種策略既能避免噪聲數據的干擾,又能保證選取的數據是模型可以學習,因此在大規模學習中即使對單個例子進行優先級排序也能加速訓練過程。

模型近似和多分辨率訓練

為了進一步增強JEST算法的性能以及對算力需求的降低,還使用了模型近似和多分辨率訓練兩種方法。

模型近似主要通過兩種方式實現:一是降低圖像分辨率,二是減少模型層的計算,幫助大模型在保持模型性能的同時,顯著減少每次迭代所需的算力需求。

降低圖像分辨率是一種直觀的近似方法。在傳統的高分辨率圖像處理中,模型需要對每一個像素點進行分析和學習,這無疑增加了算力負擔。

而在JEST算法中,通過將圖像分辨率降低,減少了模型需要處理的像素數量,從而降低了單次迭代的計算成本,并且對模型的性能影響很小。

減少模型層的計算則是另一種有效的近似手段。深度學習模型通常包含多個層次,每個層次都可能帶來計算量的增加。JEST算法通過在評分階段使用簡化的模型結構,減少了模型在每次迭代中的算力負荷,也不會影響模型最終的訓練結果。

多分辨率訓練允許模型在不同的分辨率下處理數據,從而在訓練過程中實現更高的靈活性和效率。

在多分辨率訓練中,模型首先在較低分辨率下對數據進行初步處理,這有助于快速捕捉數據的大致特征。然后,模型在較高分辨率下對數據進行更細致的分析,以提取更精細的特征信息。這種分階段的處理方式不僅提高了模型對數據的理解能力,也使得模型能夠在不同層次上進行有效的學習。

此外,多分辨率訓練還有助于提高模型的泛化能力。通過在不同分辨率下訓練,模型能夠學習到不同尺度的特征,這使得模型在面對不同尺寸和分辨率的輸入數據時,都能夠表現出良好的適應性。

為了測試JEST算法的有效性,在ImageNet、COCO等數據集上,對圖像分類、零樣本學習、圖像到文本的檢索和文本到圖像檢索等任務上進行了綜合測試。

結果顯示,JEST在多個任務上都取得了顯著的數據篩選效率,例如,當過濾90%的數據時,JEST僅需使用6700萬樣本即可達到傳統方法使用30億樣本的性能水平,相當于效率提升13倍和算力降低了10倍,同時還能幫助大模型提升大約6%的性能。

本文轉自AIGC開放社區 ,作者:AIGC開放社區