P-RAG: 漸進式檢索增強生成方法在具身日常任務規劃中的應用 精華

在人工智能領域,具身AI(Embodied AI)一直是一個備受關注的研究方向。它旨在賦予AI代理與物理世界交互的能力,讓AI不僅僅停留在虛擬的數字世界中,而是能夠在真實環境中感知、規劃和行動。近年來,隨著大語言模型(LLM)的蓬勃發展,如何將LLM的強大語言理解和生成能力與具身AI任務結合起來,成為了一個熱門的研究課題。

在這個背景下,來自中國科學技術大學等機構的研究人員提出了一種新穎的方法——漸進式檢索增強生成(Progressive Retrieval Augmented Generation, P-RAG),用于解決具身日常任務中的規劃問題。這項研究發表在ACM多媒體會議(MM '24)上,論文題為《P-RAG: Progressive Retrieval Augmented Generation For Planning on Embodied Everyday Task》。

背景與現狀

具身日常任務(Embodied Everyday Task)是具身AI領域的一個重要任務。在這類任務中,AI代理需要根據自然語言指令和視覺觀察來執行一系列動作。例如,我們可能會給機器人下達這樣的指令:"請把廚房打掃干凈"或"請給盆栽澆水"。這看似簡單的任務對AI來說卻充滿了挑戰:

- 自然語言指令往往缺乏明確的任務規劃。比如"打掃廚房",它包含了很多隱含的子任務,如清潔臺面、收拾餐具、擦拭電器等。

- AI需要對任務環境有充分的了解。不同的家庭環境可能有不同的布局和物品,AI需要適應這種差異。

- 動作空間可能是可變的,某些動作在特定情況下可能是無效或非法的。例如,我們可以用烹飪或加熱來處理某些食物,但對于盆栽或鞋子,這些動作就是非法的。

- 現實世界的一些限制條件容易被忽視。比如在某些模擬環境中,桌子可能比較小,無法放置過多物品。

傳統的基于學習的方法,如強化學習(RL),雖然可以通過迭代過程來增強模型在特定任務和環境中的能力,但往往缺乏理解語言指令的能力。而近期興起的基于大語言模型(LLM)的方法,雖然在理解語言指令方面表現出色,但又缺乏對特定任務和環境的知識。

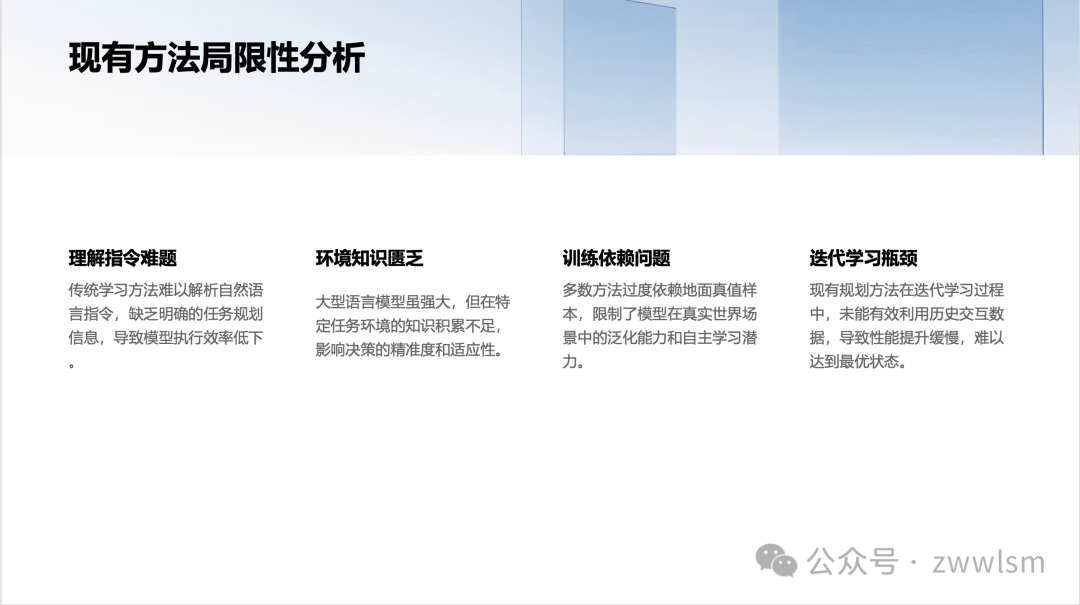

問題與挑戰

現有的基于LLM的方法主要面臨以下挑戰:

- 缺乏任務特定知識: LLM擁有廣泛的通用知識,但對于特定任務環境的細節認知不足。

- 依賴標注數據: 一些方法需要使用少量樣本(few-shot)來增強LLM的性能,這些樣本通常需要人工標注,成本較高。

- 單次檢索的局限性: 傳統的檢索增強生成(RAG)方法通常只進行一次檢索來輔助生成,難以適應復雜的具身任務。

- 缺乏漸進式學習能力: 現有方法難以像人類一樣,通過不斷嘗試和積累經驗來逐步提升性能。

P-RAG: 漸進式檢索增強生成

為了解決上述問題,研究人員提出了P-RAG方法。P-RAG的核心思想是:通過漸進式的方式,不斷積累任務特定知識,并利用這些知識來輔助LLM進行更好的規劃。

方法概述

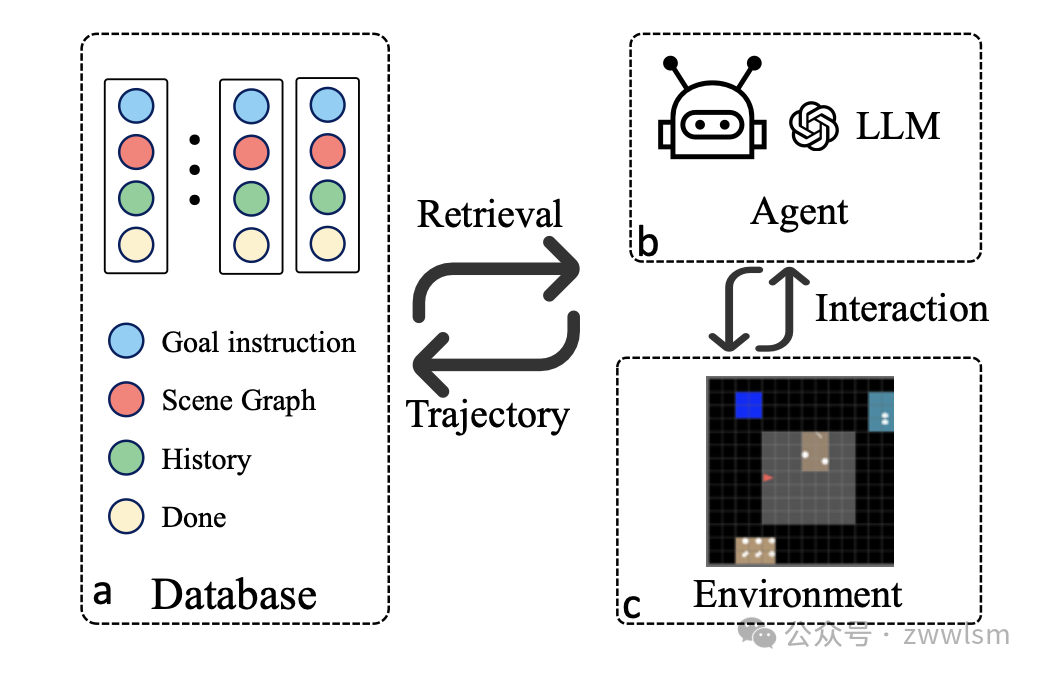

P-RAG的整體框架如圖1所示:

P-RAG框架圖

P-RAG主要包含以下幾個關鍵組件:

- 數據庫: 存儲歷史軌跡信息,包括目標指令、場景圖、軌跡歷史和任務完成狀態。

- 檢索模塊: 根據當前任務的目標指令和場景觀察,從數據庫中檢索相關的歷史信息。

- LLM代理: 接收檢索結果和當前環境信息,生成行動計劃。

- 交互環境: 模擬具身任務的環境,如MINI-BEHAVIOR或ALFRED。

- 漸進式更新機制: 在每輪交互后,更新數據庫,積累新的經驗。

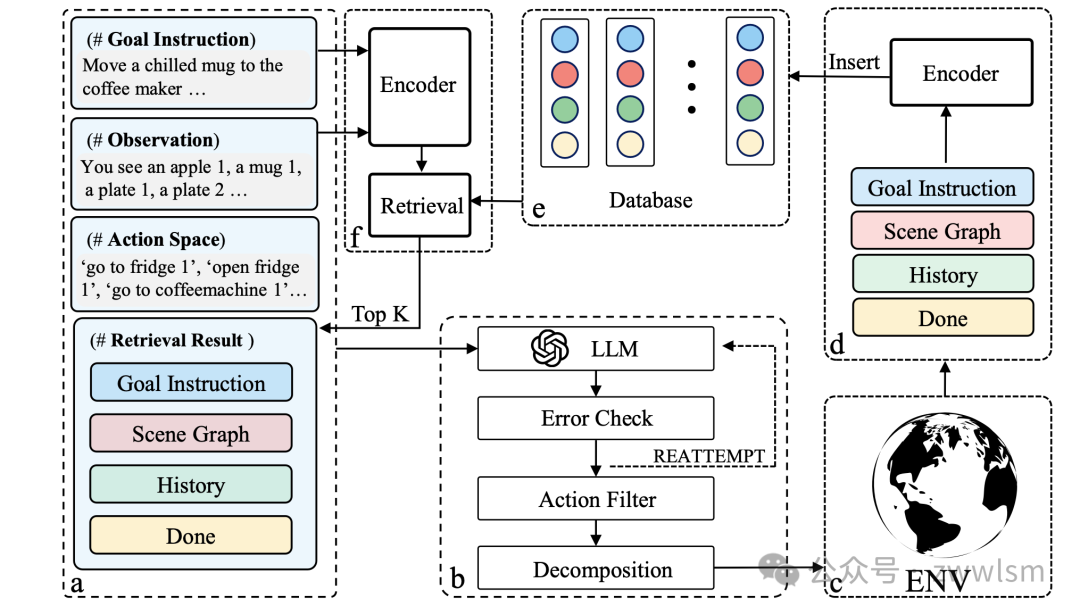

工作流程

P-RAG的工作流程可以概括為以下步驟:

- 信息收集: 代理接收目標指令、環境觀察、動作空間和數據庫檢索結果。

- LLM規劃: 將收集到的信息輸入LLM,生成一系列高級動作。

- 動作執行: 將高級動作分解為低級動作,在環境中執行。

- 結果反饋: 環境返回新的觀察和獎勵信息。

- 數據庫更新: 將新的軌跡信息更新到數據庫中。

- 迭代優化: 重復上述步驟,不斷積累經驗,提升性能。

核心創新點

- 漸進式知識積累: P-RAG不依賴預先標注的數據,而是通過與環境的交互,逐步積累任務特定知識。這種方式更接近人類學習的過程,也更適合實際應用場景。

- 聯合檢索策略: P-RAG不僅檢索相似的任務,還考慮相似的場景。這種細粒度的檢索策略能提供更有價值的參考經驗。具體來說,P-RAG使用以下公式計算相似度:

s_n = sim(Q_goal, K_goal) + max(sim(Q_obs,n, K_obs,t))其中,Q_goal和K_goal是目標指令的嵌入向量,Q_obs,n和K_obs,t是場景圖的嵌入向量。

- 迭代式更新: P-RAG引入了一種迭代方法,在每輪交互后更新數據庫。這使得模型能夠從失敗的嘗試中學習,不斷改進其性能。

- 靈活的LLM集成: P-RAG可以與不同的LLM(如GPT-3.5、GPT-4)集成,充分利用LLM的語言理解和生成能力。

實驗與結果

研究人員在兩個具有代表性的數據集上進行了大量實驗,以驗證P-RAG的有效性:

- ALFRED數據集: 一個基于視覺和語言的室內任務數據集。

- MINI-BEHAVIOR數據集: 一個抽象的網格環境,包含20個日常活動。

ALFRED數據集上的結果

表1展示了P-RAG與其他先進方法在ALFRED數據集上的性能比較:

模型 | 數據集 | 標注數據 | Valid Unseen | Valid Seen |

HiTUT | 全量 | ? | 10.23 | 18.41 |

HLSM | 全量 | ? | 18.28 | 29.63 |

LLM-Planer | 部分 | ? | 12.92 | 13.53 |

GPT-4 | - | × | 7.05 | 17.46 |

P-RAG (我們的方法) | 部分 | × | 14.11 | 18.2 |

P-RAG (自迭代) | - | × | 27.4 | 19.05 |

表1: ALFRED數據集上的性能比較 (成功率 %)

從表1中我們可以看出:

- P-RAG在不使用任何標注數據的情況下,就能達到或超過使用部分訓練數據的方法(如LLM-Planer)的性能。

- 通過自迭代(在測試集上進行漸進式更新),P-RAG的性能甚至超過了使用全量訓練數據的方法,特別是在Valid Unseen數據集上。

- P-RAG顯著優于單純使用GPT-4的基線方法,證明了檢索增強和漸進式學習的有效性。

MINI-BEHAVIOR數據集上的結果

表2展示了P-RAG在MINI-BEHAVIOR數據集上的表現:

模型 | 總成功率 | 任務成功率 | SPL |

GPT-4 | 15% | 20% | 13.8% |

P-RAG-4 | 16.7% | 25% | 15% |

GPT-3.5 | 7.5% | 20% | 7.5% |

P-RAG-3.5 | 10% | 20% | 9.5% |

表2: MINI-BEHAVIOR數據集上的性能比較

從表2中我們可以觀察到:

- 無論是基于GPT-4還是GPT-3.5,P-RAG都能顯著提升性能。

- P-RAG不僅提高了總成功率,還提升了任務成功率和SPL(成功加權路徑長度)指標。

- 即使在這種簡單的環境中,P-RAG也展現出了明顯的優勢,特別是考慮到MINI-BEHAVIOR對強化學習算法來說是一個具有挑戰性的環境。

案例分析

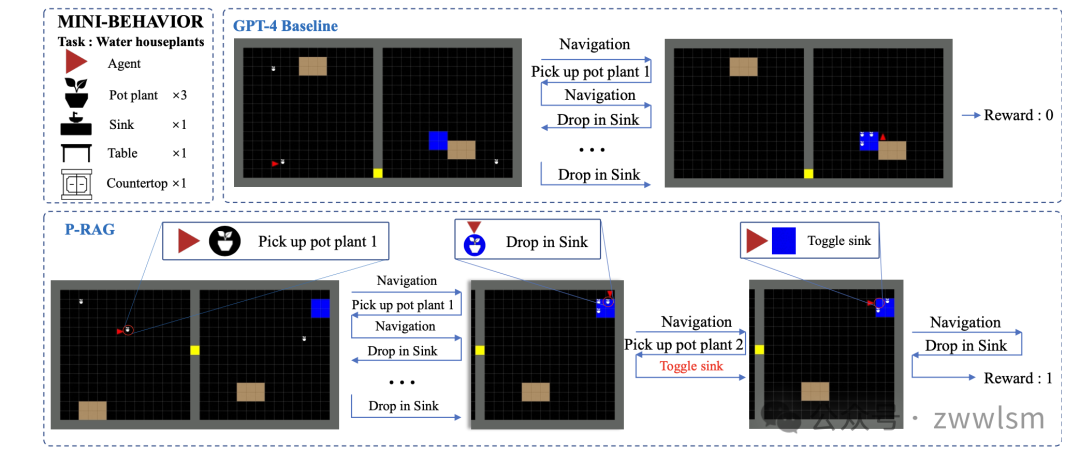

為了更直觀地理解P-RAG的工作原理,讓我們來看一個具體的案例。圖2展示了P-RAG和GPT-4基線在"給盆栽澆水"任務上的規劃軌跡對比:

規劃軌跡對比

圖2: P-RAG與GPT-4基線在"給盆栽澆水"任務上的規劃軌跡對比

在這個案例中:

- GPT-4基線方法簡單地按順序拿起三個盆栽并放入水槽,然后認為任務完成。但實際上,它并沒有成功完成任務。

- 相比之下,P-RAG利用全面的歷史軌跡信息來做決策。它不僅正確地將盆栽放入水槽,還記得要打開水龍頭,最終成功完成了任務。

這個案例很好地展示了P-RAG如何利用歷史經驗來做出更合理的決策,從而更好地完成復雜的具身任務。

方法分析與改進方向

P-RAG雖然取得了令人矚目的成果,但仍有一些值得進一步探索和改進的方向:

- 檢索效率優化: 隨著交互輪次的增加,數據庫中的歷史軌跡會不斷累積。如何在大規模數據中快速、準確地檢索相關信息,是一個值得研究的問題。可以考慮引入更高效的索引結構或近似最近鄰搜索算法。

- 知識蒸餾與壓縮: 目前P-RAG直接存儲原始的軌跡信息。未來可以探索如何從這些原始數據中提取關鍵知識,并以更緊湊的形式存儲,從而減少存儲開銷并提高檢索效率。

- 多模態信息融合: 當前的方法主要依賴文本形式的場景圖。未來可以考慮如何更好地利用視覺信息,perhaps通過引入視覺-語言預訓練模型來獲取更豐富的環境表征。

- 任務遷移與泛化: 雖然P-RAG在未見過的環境中表現良好,但如何將在一個任務域中學到的知識遷移到新的任務域,仍是一個開放的問題。研究跨任務、跨域的知識遷移將是很有價值的方向。

- 與強化學習的結合: P-RAG目前主要依賴LLM進行決策。探索如何將P-RAG與強化學習方法相結合,可能會帶來更好的性能和更強的適應性。

- 人機協作方面的應用: P-RAG的漸進式學習特性使其非常適合人機協作場景。研究如何讓人類用戶更自然地參與到知識積累和決策優化的過程中,將是一個很有前景的方向。

- 可解釋性增強: 雖然P-RAG通過檢索歷史軌跡提供了一定的可解釋性,但如何讓模型的決策過程更加透明和可理解,仍有改進空間。perhaps可以通過可視化檢索到的關鍵信息,或生成決策依據的自然語言解釋。

總結與展望

P-RAG為解決具身日常任務中的規劃問題提供了一種新穎而有效的方法。它巧妙地結合了大語言模型的強大語言能力和漸進式學習的靈活性,在不依賴大量標注數據的情況

本文轉載自 ??芝士AI吃魚??,作者: 愛滑冰的咸魚