可擴(kuò)展性長文本評測集——Ada-LEval 詳細(xì)解讀

長文本評測

隨著大模型能夠處理的上下文信息越來越多,達(dá)到百萬級別的詞匯量,人們對于模型長文本能力的研究興趣也隨之增長。

司南 OpenCompass 數(shù)據(jù)集社區(qū)已經(jīng)出現(xiàn)了諸如 L-Eval、LongBench 等長文本評測基準(zhǔn)。這些工作基于一些開源 / 自建的數(shù)據(jù)集構(gòu)建樣本,其構(gòu)建評測集上的性能已可以一定程度上反映模型的能力。

因此,在長文本評測這一工作里,我們認(rèn)為一個(gè)好的長文本評測集應(yīng)該具備以下性質(zhì):

- 樣本長度可控:測試樣本的上下文長度最好是可控的,以便于測量和比較模型在各個(gè)上下文長度下的能力變化(若測試集由不同上下文長度的測試樣例混雜而成,則難以精確測量某一長度下的性能)。

- 全文理解:測試任務(wù)應(yīng)當(dāng)需要完整閱讀 / 分析整段文本后才能成功完成。一個(gè)反例是:此前存在一些長文本總結(jié)任務(wù),模型閱讀特定部分文本(如開頭 + 結(jié)尾)后即可達(dá)到不錯(cuò)性能。

- 指標(biāo)簡明清晰:測試集的指標(biāo)應(yīng)當(dāng)做到定義清晰,其數(shù)值可以定量反映模型的性能。

- 能測試超長上下文:評測集需要能夠測試模型在超長上下文上的性能。目前主流 API 模型的上下文長度已來到了 128,000 token 甚至更長,而早期的一些長文本評測集最長僅覆蓋到 32,000 token。

Ada-LEval評測集

基于以上思考,司南 OpenCompass 團(tuán)隊(duì)構(gòu)建了長文本評測集——Ada-LEval。Ada-LEval 包含 2 個(gè)任務(wù):TSort (文本排序)、BestAnswer (選擇最佳答案),每個(gè)任務(wù)覆蓋了 1,000 到 128,000 token 的可變長度。

基于 Ada-LEval,我們對一些大語言模型進(jìn)行了評測。我們發(fā)現(xiàn),大部分的長文本模型在這一測試集上的表現(xiàn)都不盡如意。同時(shí),在 32,000+ token 的上下文長度下,所有模型 (含 GPT-4-Turbo) 都未能取得顯著優(yōu)于 Random Guess 的結(jié)果。

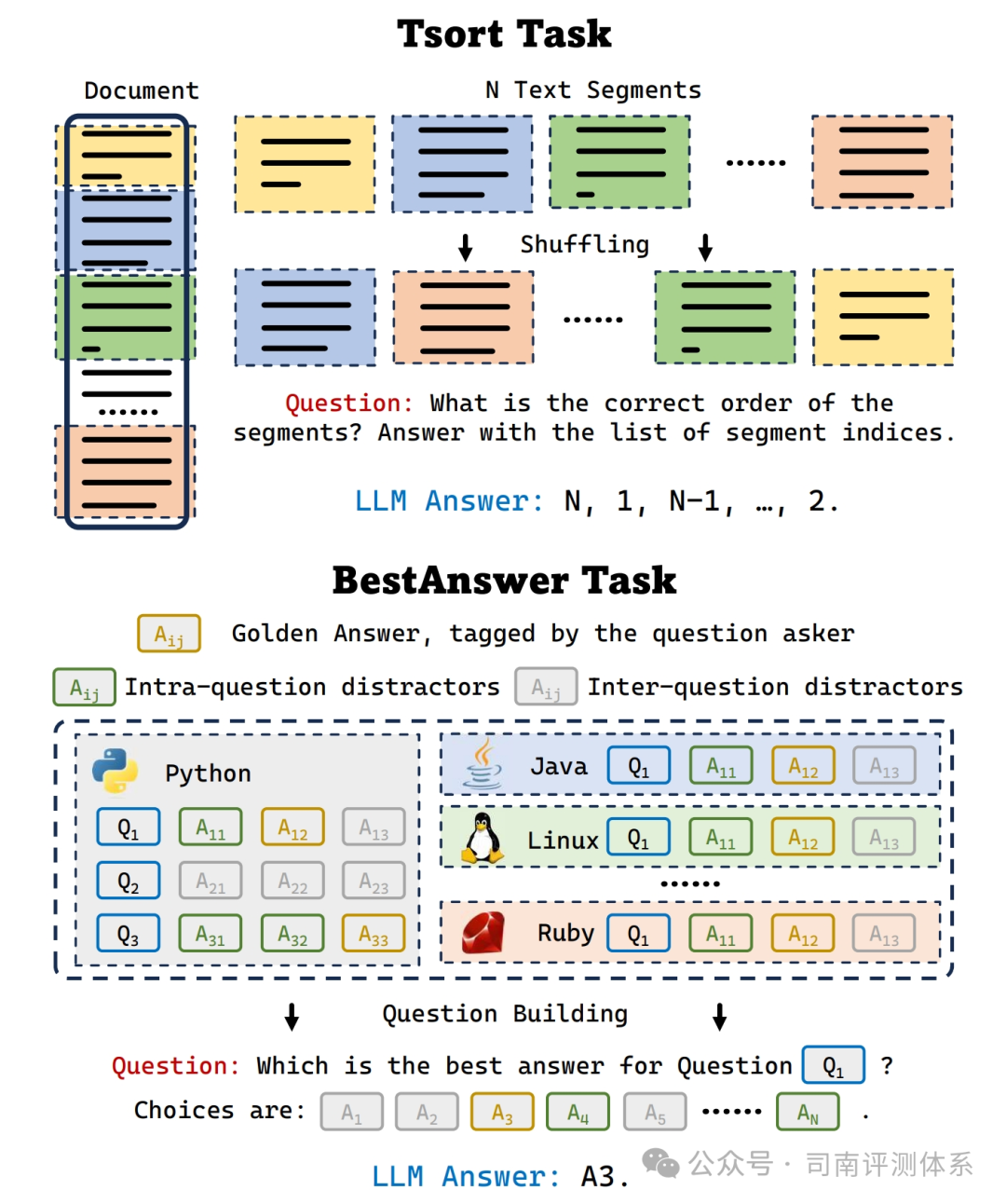

任務(wù)1:TSort(文本排序)

定義:對于一篇長文本 (例如小說),我們從中截取部分分為 N 段,打亂次序提供給 LLM (截取部分的前后臨近段落也會作為上下文提供),并要求 LLM 輸出段落的正確順序。

指標(biāo):若輸出的順序完全正確,則記為正確;否則記為錯(cuò)誤。RandomGuess 的正確率期望為 (1 / N!)。

控制樣本長度:可以通過調(diào)整 N,或是每個(gè)排序段落的長度來控制測試樣本長度。

處理細(xì)節(jié):對于 TSort 任務(wù),我們的原始數(shù)據(jù)來源于 BookSum 數(shù)據(jù)集。在構(gòu)建測試集的過程中,我們?nèi)コ宋谋局械亩温涮枴⒄鹿?jié)號等顯式的位置信息。

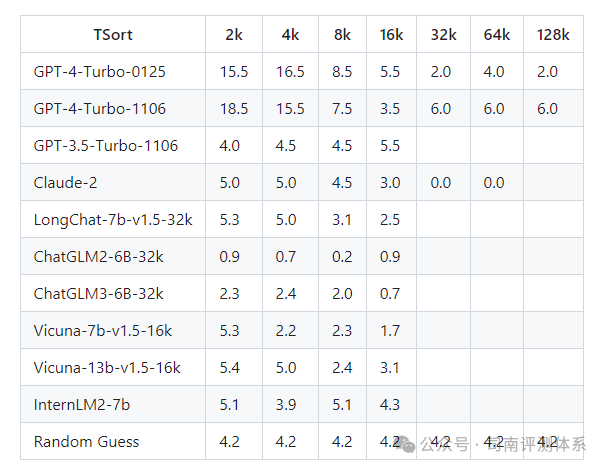

在實(shí)驗(yàn)過程中,我們僅嘗試了 N=4 的設(shè)定,并沒有繼續(xù)拓展排序段落的數(shù)量。因?yàn)槲覀儼l(fā)現(xiàn),這一任務(wù)對于 LLM 來說,似乎異常困難:在全部實(shí)驗(yàn)中,僅 GPT-4 在短上下文設(shè)定 (2,000 or 4,000 tokens) 下取得了顯著優(yōu)于 Random Guess 的精度。在大部分情況下,LLM 能夠跟隨指令并輸出一個(gè) N 排列,但順序并不正確。

另外,由于我們的原始數(shù)據(jù)均為公開數(shù)據(jù),大概率被用于 LLM 預(yù)訓(xùn)練。因此,在測試過程中,我們僅使用生成式的測試,而非基于 PPL。

任務(wù)2:BestAnswer(選擇最佳答案)

定義:給定一個(gè)問題,和大量備選答案,要求 LLM 指出問題的最佳答案。在這個(gè)任務(wù)中,我們的問題來源于 StackOverflow,并以提問者最終選擇的答案作為最佳答案。

指標(biāo):若模型選到了正確答案,則記為正確;否則記為錯(cuò)誤。RandomGuess 的正確率期望為 (1 / M),M 為備選答案數(shù)量。

控制樣本長度:可以通過調(diào)整備選答案數(shù)量來控制樣本長度。

處理細(xì)節(jié):

- 我們認(rèn)定提問者最終選擇的答案作為最佳答案。在這個(gè)答案之后依然可能有新的回答,此時(shí)這些回答不能作為備選答案中的負(fù)樣本。

- 挑選負(fù)樣本時(shí),應(yīng)當(dāng)足夠具有迷惑性。實(shí)踐中,我們會優(yōu)先挑選同一問題下的其他答案作為負(fù)樣本。在利用其他問題下的答案作為負(fù)樣本的時(shí)候,我們會保證兩個(gè)問題具有一定的相似性 (即 Tag 有所重疊)。

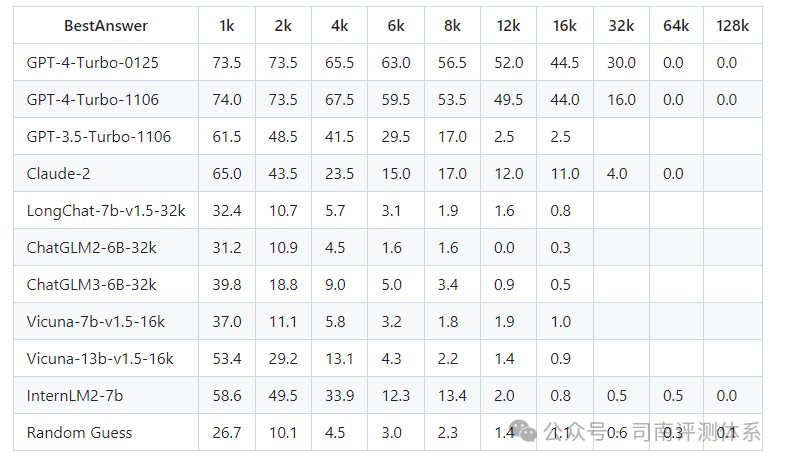

在 BestAnswer 任務(wù)上,大部分模型在測試樣例長度較短時(shí) (1,000 / 2,000 tokens) 都顯示了顯著優(yōu)于 Random Guess 的性能。在 8,000 tokens 以上,所有開源模型的精度下降至 Random Guess 水平;在 32,000 tokens 以上,GPT-4 的精度下降至 Random Guess 水平。

總結(jié)

在這項(xiàng)工作中,我們提供了 4 個(gè) API 模型與 6 個(gè)開源模型在 Ada-LEval 的評測結(jié)果。同時(shí),我們在 https://github.com/open-compass/Ada-LEval 開源了評測數(shù)據(jù)與代碼,并提供了評測 InternLM2 與 GPT-4 的樣例,以便于社區(qū)評測其他的大語言模型。

論文:?https://arxiv.org/pdf/2404.06480.pdf

本文轉(zhuǎn)載自??司南評測體系??,作者: 司南OpenCompass ????