RAGCache:讓RAG系統更高效的多級動態緩存新方案 原創

01、概述

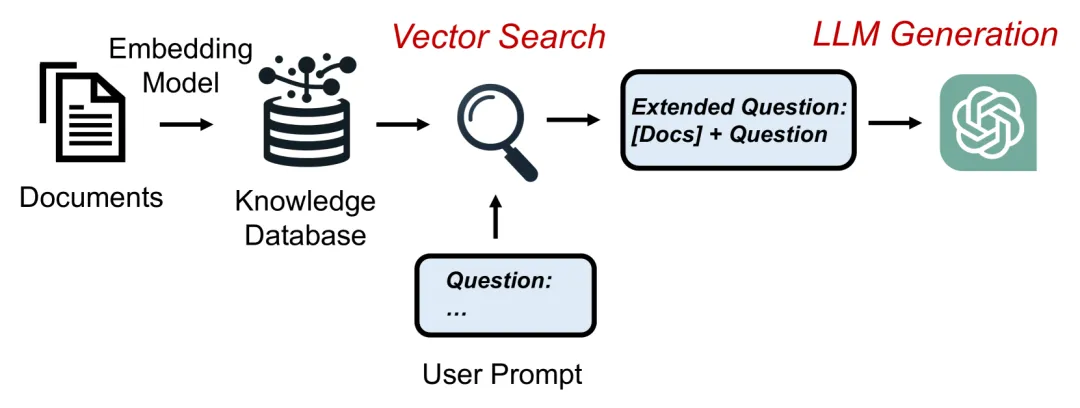

在當下的AI研究中,檢索增強生成(RAG)技術正在逐步提升大型語言模型(LLM)的知識運用能力,幫助它們結合外部知識生成更加準確、符合現實的文本。然而,RAG系統卻面臨一個無法忽視的瓶頸:龐大的計算和內存需求。每當模型從知識庫中獲取大量文檔來生成內容時,原始文本長度可能會被擴展十倍以上,極大地增加了系統的計算負擔和響應時間,從而限制了RAG在實時場景中的應用潛力。

為解決這一問題,北京大學和字節跳動的研究團隊推出了一種全新的多級動態緩存系統——RAGCache。通過對檢索到的知識進行智能緩存和管理,RAGCache有效提升了RAG系統的處理速度和計算效率。本文將深入探討這一創新方案的工作原理、技術細節及其在實際應用中的重大意義。

02、RAGCache的創新突破:緩存中間狀態,實現知識高效復用

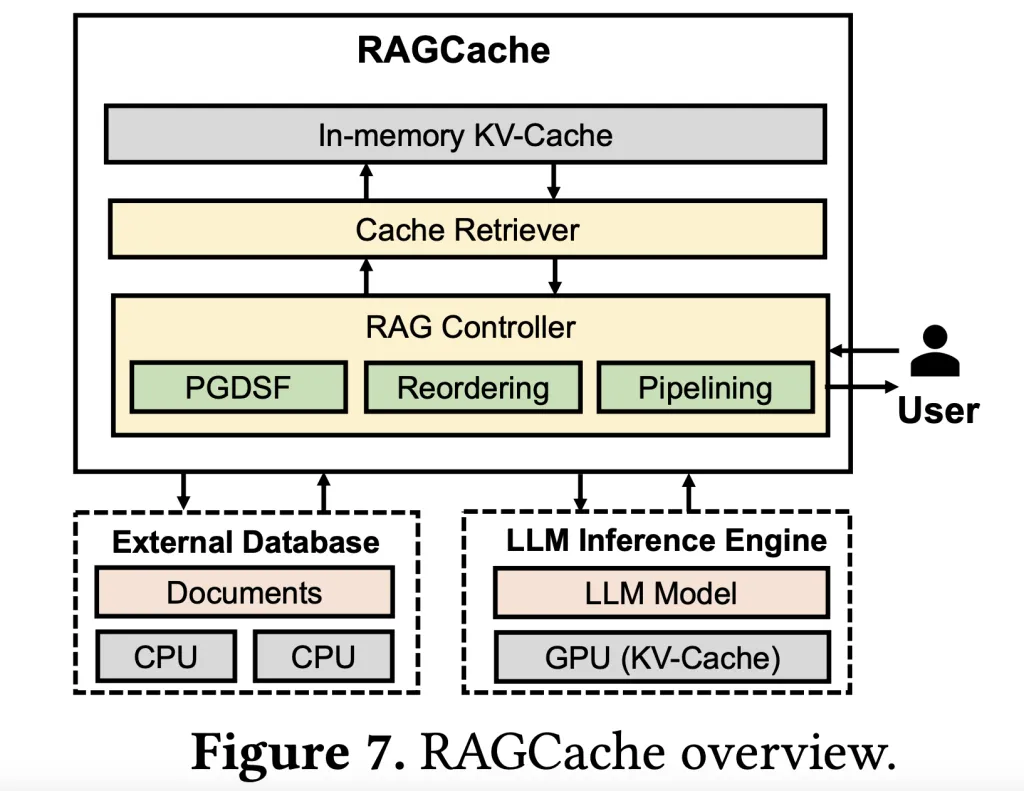

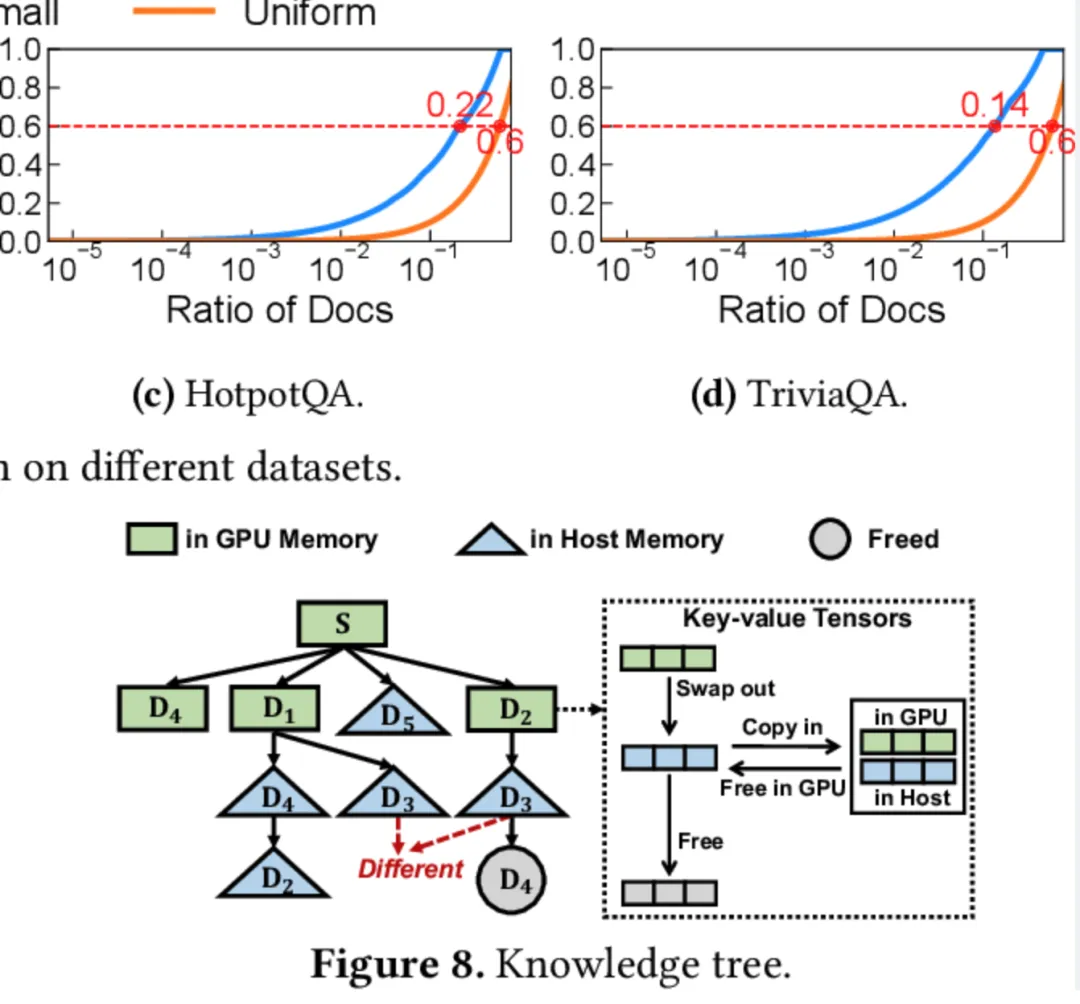

在傳統RAG系統中,生成過程中頻繁的知識檢索增加了生成時間,而為了更好地優化生成速度和效率,團隊提出了“多級動態緩存”這一核心思路。RAGCache基于一個知識樹結構,通過緩存中間狀態在GPU和主機內存中實現高效存儲管理。值得注意的是,RAGCache獨創的前綴感知貪心雙重大小頻率替換策略(PGDSF)能夠在緩存命中率上取得顯著優化,將高頻訪問的文檔緩存至GPU內存,低頻文檔則移至較慢的主機內存,從而減少對重復計算的需求,加速響應時間。

工作流程:緩存知識樹、智能替換和動態重疊

RAGCache的工作流程主要分為以下幾個核心步驟:

- 知識樹緩存:通過構建一個知識樹結構,RAGCache能將檢索到的知識緩存為鍵值張量(key-value tensors),使得常訪問的知識存儲于GPU,較少訪問的內容則緩存在主機內存中。這種多級存儲機制不僅降低了對GPU資源的需求,也使得模型能夠迅速獲取到常用的知識。

- 智能替換策略:前綴感知的PGDSF替換策略在考慮文檔的順序、頻次、大小及近期訪問情況的基礎上,智能選擇哪些內容應保留在緩存中。這種策略確保緩存空間始終用于存儲最有價值的中間狀態,從而減少了緩存未命中情況,提高了生成效率。

- 動態預測流水線:RAGCache實現了矢量檢索與LLM生成步驟的動態重疊,使得模型能夠同時進行檢索與生成,避免了傳統RAG系統中的順序執行瓶頸,大幅降低了響應延遲。

通過這一多層次的優化機制,RAGCache不僅能夠高效緩存和復用知識,還顯著加快了整體生成速度,特別是在需要快速響應的應用場景中具有明顯優勢。

03、RAGCache的性能表現:4倍加速和2倍吞吐提升

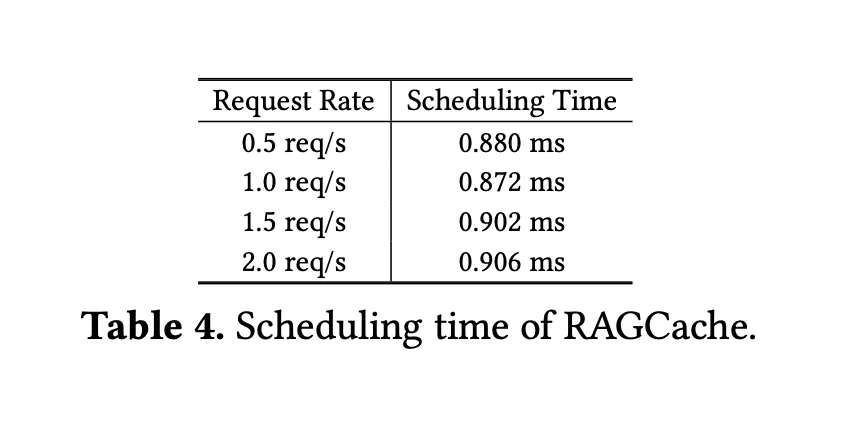

在實際測試中,RAGCache的表現令人矚目。研究團隊在vLLM(領先的LLM推理系統)中集成了RAGCache,結合流行的向量數據庫Faiss,實驗數據顯示其時間至首標記(TTFT)加速了4倍,吞吐量提升了2.1倍。此外,與高性能LLM系統SGLang相比,RAGCache在TTFT上實現了3.5倍的提升,吞吐量提高了1.8倍。這些測試結果表明,RAGCache在性能上遠超傳統的RAG方案,能更好地滿足大型應用場景的需求。

通過在GPU和主機內存之間高效地分配和復用檢索信息,RAGCache不僅降低了計算成本,也顯著提高了處理速度,使其成為那些高頻、同類檢索請求密集的場景中的理想選擇。

04、RAGCache如何助力RAG系統突破瓶頸

RAGCache的意義不僅僅是對RAG系統的性能提升,更是為其在實時性、規模性應用場景中提供了一套可行的解決方案。這項技術特別適用于以下幾類應用:

- 實時客服和智能助理:客服場景中的AI需要在短時間內處理海量的用戶請求,RAGCache的高緩存命中率和快速響應能力,能顯著減少用戶等待時間,提升用戶體驗。

- 內容生成和實時推薦:在內容推薦系統中,RAGCache的緩存機制可以幫助系統快速調用常用知識,使得AI在內容生成、推薦等方面更加智能化。

- 大規模檢索和企業知識管理:在需要頻繁訪問外部數據庫的知識密集型應用中,如法律、金融等領域,RAGCache通過減少重復計算和資源浪費,有助于提升AI模型的生產力。

05、緩存失效與隱私安全

雖然RAGCache的緩存機制極大提升了系統的響應速度,但也面臨一些潛在的挑戰。比如,對于快速變化的信息領域,緩存的信息可能很快失效,從而影響生成內容的準確性。此外,緩存大量檢索信息也帶來了隱私與安全風險,尤其是在用戶數據涉及敏感信息時。未來的研究應進一步探索如何應對這些問題,以確保RAGCache的安全性和數據更新的及時性。

技術進步的背后:RAGCache在RAG系統優化中的里程碑意義

RAGCache的提出不僅在技術上突破了RAG系統的瓶頸,更為未來的RAG發展開辟了新的方向。多級緩存體系的創新設計,特別是智能化的緩存管理策略,為RAG系統實現高效、高速的數據處理提供了參考。通過對中間狀態的緩存與復用,RAGCache有效減少了對計算資源的依賴,使得RAG系統在高效與低成本之間達到了平衡。

05、應用前景

隨著大型語言模型的不斷擴展,RAGCache的應用潛力將愈發顯著。例如,在未來的智能助手、實時翻譯、智能搜索引擎等方面,RAGCache的高效緩存機制可以成為推動這些場景AI體驗質變的關鍵。與此同時,RAGCache的智能化緩存策略也為企業部署AI應用提供了更具可操作性的選擇。

06、結語

綜上所述,RAGCache的創新設計不僅提升了RAG系統的效率,更在一定程度上重新定義了檢索增強生成模型的潛力。通過引入多級動態緩存體系和前綴感知智能替換策略,RAGCache在減少延遲和提升吞吐量方面實現了跨越式提升,為實時、規模化的AI應用場景提供了高效、穩定的技術支持。

可以說,RAGCache不僅是一項技術突破,更是引領未來RAG系統發展的重要里程碑。隨著AI技術的不斷進步,RAGCache的應用有望為各行業帶來更多可能性,讓AI真正成為“智能助手”,為我們的生活和工作帶來切實的便利和提升。

參考:

- ??https://www.aimodels.fyi/papers/arxiv/ragcache-efficient-knowledge-caching-retrieval-augmented-generation??

- ??https://arxiv.org/abs/2404.12457??

本文轉載自公眾號Halo咯咯 作者:基咯咯