理化諾獎、人工智能與知識領域的融合

引言

近期的發展標志著人工智能領域的一個激動人心的時期。2024年諾貝爾物理學獎授予了約翰·霍普菲爾德(John Hopfield)和杰弗里·辛頓(Geoffrey Hinton),以表彰他們在人工智能領域的奠基性工作;而化學獎則頒給了大衛·貝克(David Baker)、德米斯·哈薩比斯(Demis Hassabis)和約翰·瓊珀(John Jumper),以表彰他們利用人工智能解決蛋白質折疊問題的成就——這是科學界長達50年的重大挑戰。

隨著人工智能在物理學和化學中的應用獲得認可,機器學習從業者可能會好奇這些科學領域與人工智能的關系,以及這些獎項可能對他們的工作產生怎樣的影響。

神經網絡的歷史發展

通過審視人工智能發展的歷史,我們可以更好地理解計算機科學、理論化學、理論物理學和應用數學之間的相互聯系。從歷史視角來看,這些學科中的基礎性發現和發明共同推動了現代人工神經網絡機器學習的發展。

神經網絡領域的最早工作可追溯至麥卡洛克(McCulloch)和皮茨(Pitts),他們在1943年提出了一個使用簡單二值邏輯表示神經元的模型。他們的研究表明,神經元能夠實現諸如AND、OR和NOT等基本邏輯運算,為現代神經網絡奠定了基礎。然而,他們并未解決生物神經元網絡中學習或存儲長期記憶的機制問題。許多計算機科學家熟悉這些早期的邏輯模型,這些模型為今天復雜的神經決策過程提供了概念基礎。

1949年,唐納德·赫布(Donald Hebb)提出了“赫布學習”的原理,即神經元如果在時間上反復或接近地共同激發,其連接會得到增強。20世紀50年代末,弗蘭克·羅森布拉特(Frank Rosenblatt)在神經網絡研究中取得了重大進展,他提出了“感知機”這一術語,并開發了理論模型和硬件實現。羅森布拉特的感知機引入了非二值輸入和可訓練的神經元權重,大大增加了神經網絡設計的靈活性。

然而,1969年,馬文·明斯基(Marvin Minsky)和西摩·帕珀特(Seymour Papert)在其影響深遠的著作《感知機》中指出了一個關鍵的局限性:沒有可訓練隱藏單元的網絡無法解決非線性可分問題,例如異或(XOR)函數或檢測衛星圖像中的螺旋結構。盡管這一發現最初令人沮喪,但最終激勵了人工智能界集中解決訓練含隱藏單元網絡的挑戰,進而發展出了反向傳播算法,其中包括杰弗里·辛頓等人的重要貢獻。同時,理論物理學、化學和應用數學領域的研究者也在探索神經網絡對現實現象(包括脈沖生物神經元行為)的建模,進一步豐富了這一領域的跨學科特性。

我們可以將早期對現實神經元建模的努力追溯到杰克·科萬(Jack Cowan)和天利·甘(Shun’ichi Amari),他們的研究將原本用于動物種群動態的Volterra捕食-獵物方程推廣并應用于脈沖神經元的建模。幾十年來,科萬在神經元的統計力學領域不斷取得進展,而甘的神經網絡動力學和學習算法的開創性工作至今仍然對現代機器學習產生深遠影響。

關鍵突破與挑戰

約翰·霍普菲爾德(John Hopfield)的研究帶來了一個概念性突破,他提出了一個簡化的神經元模型,并將其與理論物理學和化學中的伊辛模型(Ising model)聯系起來【譯者注:請見物理諾獎、統計力學與大模型】。

霍普菲爾德在1982年發表的經典論文中提出了霍普菲爾德聯想記憶模型(Hopfield associative memory model),這一模型成為神經網絡研究的基石。該模型展示了神經元網絡如何通過能量最小化來存儲和檢索模式,其動態由能量函數控制。這種與能量的聯系使模型能夠穩定地收斂到與存儲記憶對應的穩定狀態,從而成為神經網絡理論與理論物理學中自旋玻璃理論之間的關鍵紐帶。

熟悉自旋玻璃理論的理論物理學家發展出新的學習理論,與計算機科學中更為人熟知的統計學習理論形成了競爭性的視角【譯者注:請見?Spin-Transformer數據雕刻自旋玻璃】。這些理論為當代問題提供了重要見解,并對理解諸如大語言模型(LLMs)和擴散模型等具有廣泛意義。例如,深度神經網絡(DNNs)中的“雙降現象”(double descent)首次在理論物理學文獻中通過感知機學習模型的研究被發現。

霍普菲爾德的聯想記憶模型展示了一種類似于神經網絡“幻覺”的現象。在神經科學中,這一模型甚至被用于研究視覺幻覺。霍普菲爾德與泰倫斯·塞伊諾夫斯基(Terrence Sejnowski)結合模擬退火(simulated annealing)與自旋玻璃模型的思想,提出了玻爾茲曼機(Boltzmann machine)。這一方法使得無監督學習成為可能,通過訓練數據中的規律創建內部模型,而無需輸入輸出對。這一工作更加深入地借鑒了物理學和熱力學系統的類比【譯者注:請見降低大模型幻覺的必由之路】。

在監督學習領域,為克服明斯基與帕珀特的批評,辛頓及許多研究者繼續致力于多層神經網絡及隱藏單元的研究。1986年,大衛·魯梅爾哈特(David Rumelhart)和詹姆斯·麥克萊蘭德(James McClelland)編輯出版的兩卷本《并行分布式處理》(Parallel Distributed Processing)成為探索神經網絡領域的青年研究者和學生的必讀經典,為聯結主義研究奠定了重要參考基礎。辛頓與魯梅爾哈特及羅納德·威廉姆斯(Ronald Williams)在20世紀80年代共同推動了反向傳播法在人工智能界的普及。盡管許多人因其僅適用于“玩具問題”而放棄了這條研究路線,辛頓始終堅持不懈,最終隨著計算能力的爆炸性增長和新算法變體的開發,得到了驗證。

當然,今天的神經網絡遠比最初的霍普菲爾德聯想記憶模型或20世紀80年代基于反向傳播的模型復雜得多。盡管深度學習在解決許多過去難以攻克的機器學習和人工智能問題方面取得了巨大進步,我們依然缺乏基本理論來解釋其為何有效。在實際應用中,大語言模型的不穩定性和不可預測性仍是從業者面臨的一大難題。然而,通過重新審視統計物理學中的舊模型,人們取得了一些進展。例如,馬丁(Martin)【譯者注:作者本人】和馬霍尼(Mahoney)在2021年提出的重尾自正則化(HTSR)理論,可以在無需檢查訓練或測試數據的情況下檢測神經網絡各層是否已收斂。

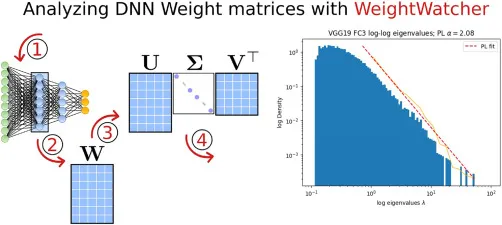

HTSR理論被實現為開源的、無需數據的診斷工具WeightWatcher。通過WeightWatcher,我們可以深入觀察現代深度神經網絡,發現表現最好的模型顯示出一種驚人的普適性,這與HTSR理論的預測一致:層權重矩陣特征值的經驗分布尾部收斂到冪律(PL)分布,其冪律指數α約為2。在上圖中,我們展示了VGG19最后一層權重矩陣的特征值在對數-對數坐標下的直方圖,以及與冪律分布的擬合。【譯者注:近期類似的研究可以參考推演大模型局限與發展脈絡第三部分】

這種普遍行為表明,可能存在一種尚未發現的、更為基礎的普適計算過程支配著深度神經網絡(DNN)的訓練。雖然我們尚不理解這一看似普遍現象的起源,但其觀察結果暗示,可能存在一種新的物理學理論有待發現,它或許包含統計力學的某些元素,但以一種全新的方式進行整合。

工程先于科學

工程的發展往往先于科學理解。例如,蒸汽機、汽車、船舶和火車的研發遠早于我們對其底層動力學的深入理解。早期的蒸汽機容易爆炸,引發火災,甚至導致船只沉沒。直到熱力學的出現,我們才真正理解如何控制和優化這些復雜機器。這一科學基礎最終促使內燃機的改進,并為當今如SpaceX火箭的先進技術鋪平了道路。

加密貨幣的快速發展和廣泛應用進一步說明了工程如何能夠超越科學理解。這些數字資產徹底改變了金融交易并引發了全球現象,而這一切都發生在其行為和影響的全面理論框架確立之前。

另一個近期的諾貝爾獎——化學獎——則表明,即使在缺乏完整理論理解的情況下,人工智能也能幫助解決一些最具挑戰性的科學問題。通過破解蛋白質折疊問題,約翰·瓊珀(John Jumper)和德米斯·哈薩比斯(Demis Hassabis)為生物學和醫學領域的突破性發現鋪平了道路。他們與AlphaFold的工作展示了AI的變革潛力,不僅能夠解決復雜難題,還能加速多個科學領域的進步。

乍一看,AlphaFold似乎憑空而來,但事實上,蛋白質折疊問題的研究與理論物理學、化學和人工智能有著深厚的淵源。實際上,瓊珀的博士論文是一個結合物理學與人工智能的混合模型(使用辛頓提出的有限玻爾茲曼機對比散度算法訓練),能夠處理蛋白質折疊和動態問題。早期的統計力學方法結合了AI的經驗數據,通過對快速側鏈運動進行平均來實現。這是通過使用類似于限制玻爾茲曼機的算法擬合蛋白質數據銀行(PDB)的參數來完成的。然而,這些計算極其耗費資源,需要使用世界上最大的超級計算機。通過結合理論、實驗數據與人工智能,瓊珀的早期工作為最終在AlphaFold中取得的驚人成果奠定了重要基礎。

神經網絡的早期研究者們認識到了計算模型中大規模并行性的潛力。然而,由于當時技術的限制,這一概念的全面實現一直難以達成。當時的計算硬件,由于CPU的速度較慢且缺乏GPU等專用處理器,在大規模實現并行架構方面面臨巨大限制。盡管如此,這一領域在理論基礎方面取得了關鍵進展。分布式編碼的引入標志著范式的轉變,從局部化表示轉向更為魯棒和靈活的分布式激活模式。這種方法允許神經網絡進行更為細膩和語境敏感的信息處理。同樣具有變革意義的是反向傳播算法的發展,它使網絡能夠基于預測與實際輸出之間的差異調整內部參數。盡管這一算法計算密集,卻為訓練多層網絡提供了強有力的機制,為硬件能力趕上理論愿景的深度學習革命鋪平了道路。

當我們回顧神經網絡領域的歷史挑戰與突破時,思考這些進步如何塑造了我們對周圍世界的理解至關重要。這種計算思維的演變促使我們重新審視宇宙的基石,將我們的視野拓展到傳統科學邊界之外。這種擴展視野促使我們探索一種新的概念方式,將當代的基本構成塊與我們對自然的理解交匯起來。

自然基石的演變

我們可以將世界的基本架構概念化為由三種主要基石或基礎“ABC”組成的三位一體:“原子”,即物質的基本單元;“比特”,即信息的最小不可分單元;以及“細胞”,生命的基本元素。人類對自然核心組成部分的探索經歷了重要演變,從原子這一有形領域和細胞的生物學范疇,逐步過渡到比特這一抽象但無所不在的領域。這一轉變標志著科學研究范式的轉型,信息作為一個核心焦點逐漸凸顯,并與我們對物質和生命的理解相輔相成、相互交融。

將比特作為信息的基本單位的引入,催生了一個嶄新的跨學科研究和探索的時代,有效地削弱了傳統科學學科之間的界限。這場數字革命為解決各領域長期存在的問題提供了創新的方法。例如,生物信息學結合了計算機科學與分子生物學,用于分析人類基因組;計算語言學運用統計模型來解讀人類語言的復雜性。在氣候科學領域,大數據分析和機器學習算法處理大量環境信息數據集,從而提升預測精度并深入理解全球氣候現象。

此外,許多當代案例進一步說明了比特這一概念如何作為統一原則連接不同學科,并加速針對復雜、多維挑戰的創新解決方案。比特的引入不僅改變了科學的運作方式,還推動了跨領域合作和解決問題的新思維方式,使我們能夠以前所未有的速度和深度探索自然界的奧秘。

詩人和理工科精英的融合

人文學科、文科與傳統上定量化的領域(如STEM)在教育與實踐中往往是彼此分離的。盡管這些領域之間一直存在某種程度的互動,但由于語言模型和聊天機器人等技術的推動,我們正在見證更深層次的融合。這些工具能夠將復雜技術文本簡化為更易理解的版本,同時還支持對人文學科中的定性數據進行分析和可視化。這種融合鼓勵來自全球各地的多樣化團隊通過真實體驗和問題解決來學習,例如,本文作者之一(G.M.)教授的許多以AI和數據為主題的項目式課程,就以體驗式學習為核心。

諸如谷歌的NotebookLM之類的工具使得復雜文檔的摘要生成變得極為簡單,僅需輕輕一點,即可快速獲取信息。它們甚至能以播客的形式呈現內容,為用戶提供簡明的概覽,使人們能夠更加高效地理解和利用信息。

行動呼吁

在前行的道路上,必須認識到不同方法的融合對現代生成式AI系統發展的重要性,例如基于反向傳播的深度學習和受物理學啟發的玻爾茲曼機的結合。

這種跨學科的方法不僅有益,而且在應對未來許多復雜挑戰時至關重要。我們需要在保持務實態度的同時,充分利用當前技術進步的動力。AI在多個領域的快速發展帶來了前所未有的機遇,同時也帶來了重大的挑戰。要彌合技術炒作與實際成果之間的差距,我們必須培養新一代的跨學科思考者,即當代的AI通才。

這些現代版的達·芬奇將在開發工程師可直接應用的實用學習理論方面發揮關鍵作用,推動我們向人工通用智能(AGI)的宏偉目標邁進。這要求我們在科學探索和問題解決的方法上進行范式轉變,擁抱整體性、跨學科的協作,并從自然中學習以理解自然。【譯者注:回歸老子,道法自然】通過打破學科間的壁壘,培育一種跨領域的知識好奇文化,我們能夠為應對諸如氣候變化等復雜的全球性挑戰解鎖創新的解決方案。正是通過多元知識和視角的融合,在AI的催化作用下,我們才能開辟通往有意義進步的道路,并充分實現技術愿景的潛力。

隨著AI的不斷發展,意識的前沿成為一個令人著迷的挑戰。這引發了關于意識是否可以完全通過原子、比特和細胞的交互作用來解釋,或者是否需要一個尚未發現的新元素的疑問。布魯姆等人的最新研究提出了一種全新的“有意識圖靈機”模型,這一模型表明,意識可能通過計算過程被理解并可能被復制,從而彌合傳統AI與自我意識之間的鴻溝。這一前沿展示了我們倡導的跨學科方法的必要性,將計算機科學、神經科學、哲學、物理學和化學的洞見結合起來,共同探索AI和人類理解中最深刻的問題之一。

譯者注:

正如譯者在物理諾獎、統計力學與大模型 中總結的:理化諾獎都頒給AI學者,預示著學科的前沿邊界已經非常模糊了。AI融匯了統計力學的思想,可以用來拓展人類的高維認知。這與Charles H. Martin博士的觀點高度吻合。

今天跟同事學到一句話:執一不失,能君萬物,即對事物本質的道理執著地堅持,如是才能讓萬物為我所用。

原文:The recent Physics and Chemistry Nobel Prizes, AI, and the convergence of knowledge fields: Patterns ?https://www.cell.com/patterns/fulltext/S2666-3899(24)00271-X