HybGRAG:Hit@1 的平均相對提升率達到 51%的新思路

1. 傳統RAG存在的問題

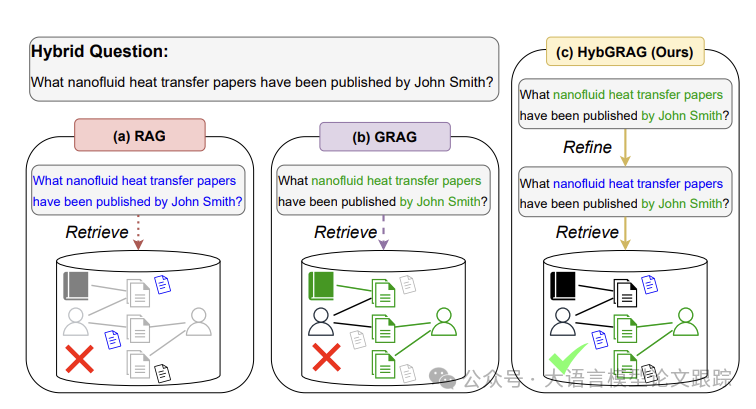

檢索增強生成(Retrieval-Augmented Generation ,RAG)能讓大型語言模型(LLMs)從非結構化文檔數據庫獲取信息,使得LLMs 就能處理未知事實,并借助額外的文本信息解決開放域問答(Open-Domain Question Answering,ODQA)問題。

圖檢索增強生成(Graph RAG,GRAG)從結構化知識庫中檢索信息,其中的文檔通過關系相互關聯。現有的 GRAG 方法主要集中在兩個方向:

? 從知識圖譜(Knowledge Graphs,KGs)中提取關系信息,并利用 LLMs 進行知識庫問答,以及在數據庫中的文檔間建立關系以提升 ODQA 性能。

? “混合”問答(Hybrid Question Answering,HQA):給定一個半結構化知識庫(Semi-structured Knowledge Base,SKB),通過結構化數據和文本數據共同完成一個問題的答案。SKB 由知識圖譜(也就是結構化數據庫)和非結構化文本文檔構成,其中文本文檔與 KG 的實體相關聯。

圖片

圖片

但是,通過現有分析表明,現有的RAG或者GRAG都無法有效解決HQA問題:

? 其一,這兩種方法只專注于檢索文本或關系信息。

? 其二,在混合問題中,檢索不同類型信息所需的方面可能難以區分。如上圖,通過問題路由識別問題。但在不成功的路由中,文本方面“納米流體傳熱論文”和關系方面“由 John Smith 撰寫”之間的混淆會導致不正確的檢索。

2. 什么是HYB GRAG?

為解決 SKB 中的 HQA,我們提出 HYB GRAG(HYBrid Graph RAG)。HYB GRAG 利用檢索器庫處理混合問題,同時利用文本和關系信息。總體上,HYB GRAG有以下特點:

? 智能體(Agentic):通過自我反思自動優化問題路由;

? 自適應(Adaptive):通過統一框架解決文本、關系和混合問題;

? 可解釋(Interpretable):通過直觀的優化路徑證明決策的合理性;

? 有效(Effective):在真實世界的 HQA 基準測試中優于所有基線。

2.1 HQA面臨的兩個問題:

2.1.1 C1: 混合來源問題(Hybrid-Sourcing Question)

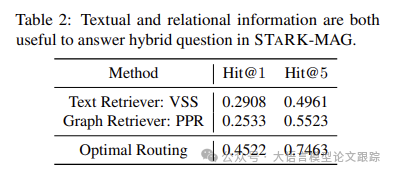

作者通過一系列實驗,證明了HQA需要同時借助文本和關系信息來回答混合問題,表明文本文檔和知識圖譜(KG)包含有用但不重合的信息。

結果表明:

? 向量相似度搜索(Vector Similarity Search,VSS)作為僅使用文本信息的檢索器,通過在嵌入空間中對比問題與文檔來進行檢索和排序;

? 個性化 PageRank(PPR):作為僅使用關系信息的檢索器,從 LLM 識別出的實體出發進行隨機游走,并依據它們在 SKB 的 KG 中的連通性對相鄰實體進行排名。

圖片

圖片

如上圖,文本和關系檢索器的性能不相上下。如果最優路由總是選擇能給出正確結果的檢索器,性能會大幅提升,這表明文本和圖形檢索器的優勢幾乎不存在重疊。表明通過協同這兩個檢索器來同時利用文本和關系信息的解決方案的重要性。

2.1.2 C2:需要改進的問題

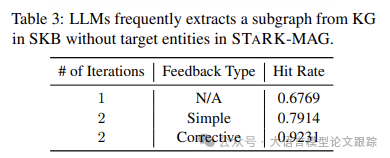

KBQA 的成功往往依賴于這樣一個假設:目標實體處于從知識圖譜(KG)中抽取的子圖內。同樣,在 HQA 中回答問題需要從 SKB 里的 KG 抽取子圖。

由于混合問題兼具文本和關系兩方面,因此作者測試 LLM 能否從 KG 中抽取包含目標實體的子圖。

1. 通過提示詞識別問題中的關系層面,即實體和用于抽取子圖的有用關系。

2. 若目標實體不在子圖中,則利用一個通過提示詞進行帶有反饋的額外迭代。

圖片

圖片

如上表:

? (第二行)若結果有誤,單純提示 LLM 重新抽取會獲得更高的命中率。

? (第三行)如果 LLM 收到指出抽取錯誤部分的反饋(比如,抽取的主題實體有誤),結果會顯著提升。這是因為在包含文本和關系方面的混合問題中,LLM 可能會誤將文本方面當作關系方面。

所以第二個挑戰:在 HQA 中,LLM 首次嘗試時難以區分問題的文本和關系方面,故而需要進一步完善。

2.2 針對C1提出的新的檢索庫架構

HYB GRAG的檢索模塊由多個檢索模塊和一個路由器構成的檢索器庫。

設計了兩個檢索模塊,分別是文本檢索模塊和混合檢索模塊,用于從文本文檔和 SKB 中獲取信息。每個檢索模塊均包含一個檢索器和一個排序器,用來應對各類問題提供了靈活性。

?文本檢索模塊:通過針對給定問題 Q 的相似性搜索來檢索文檔,比如密集檢索,直接在文本文檔中找到答案。

?混合檢索模塊:將識別出的實體 E 和有用關系 R 作為輸入。使用圖形檢索器提取由 R 連接的 E 的自環圖中的實體。

?路由器:給定一個問題 Q,LLM 路由器執行問題路由來確定檢索模塊的選擇和使用。路由器首先依據實體類型和關系類型,借助少量示例識別關系方面,即實體 E 和有用關系 R 。然后路由器做出選擇,決定采用文本檢索模塊還是混合檢索模塊。

2.3 針對C2提出的評論模塊

給定一個混合問題 Q,路由器需執行問題路由,包括識別實體和有用關系 。但在首次迭代中它們可能會被錯誤識別。

為解決此問題,提出評論模塊,能提供反饋以助力路由器更好地執行問題路由。作者沒有直接采用單個 LLM 完成這一復雜任務,而是將其分為兩部分:

? 即 LLM 驗證器用于驗證檢索結果的正確性

? LLM 評論員用于在檢索有誤時提供反饋

這種分治策略,具有兩大關鍵優勢:

1.將難題分解為兩個較易處理的任務,能借助 LLM 來解決,同時保持良好性能。

- 由于驗證和評論的任務相互獨立,各自可有專屬上下文,避免包含無關信息及“Lost in the Middle”的現象。

2.3.1 驗證器 LLM

驗證器的目的是驗證檢索到的頂級參考文獻是否符合問題 Q 的要求,屬于二分類任務。為提高準確性,為驗證器提供額外的驗證上下文。將主題實體與提取的自我圖中實體間的推理路徑用作驗證上下文,用于檢驗輸出是否滿足問題中的某些要求。

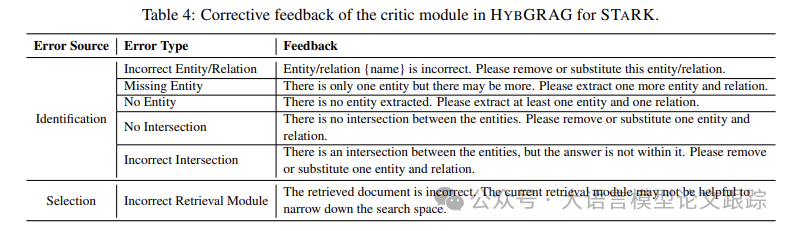

2.3.2 評論員 LLM

圖片

圖片

評論員旨在提供反饋以協助路由器優化問題路由。為有效引導路由器,構建易于理解的糾正性反饋。會指出每個動作中的錯誤,如實體的錯誤識別(上表展示了識別錯誤的分類)。

與可能因使用的 LLM 而導致不確定性或不一致的自然語言反饋不同,糾正性反饋為如何優化問題路由提供了明確指引。此外,它借助上下文學習(ICL)提供精細的反饋。

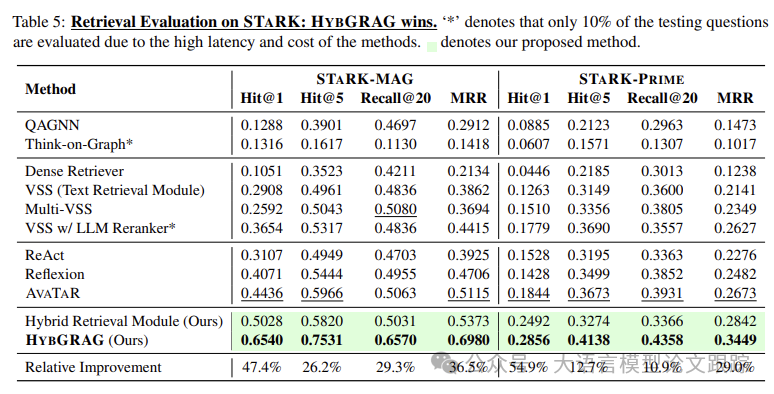

3. 效果評估

3.1 HYB GRAG 在現實世界的 GRAG 基準測試中的表現怎樣?

圖片

圖片

如上表,HYB GRAG 在 STARK 的兩個數據集中均顯著優于所有基準方法。大多數基準方法是為處理 ODQA 和 KBQA 而設計的,結果表明它們無法有效處理 HQA。

混合檢索模塊表現位居第二,表明能同時運用文本和關系信息的協同檢索模塊的重要性。

HYB GRAG 的表現明顯優于混合檢索模塊,意味著在首次迭代中提取的實體和關系常常有誤。

通過分別利用HYB GRAG檢索器庫和評論模塊應對挑戰 1 和 2,HYB GRAG 的性能有了顯著提升。

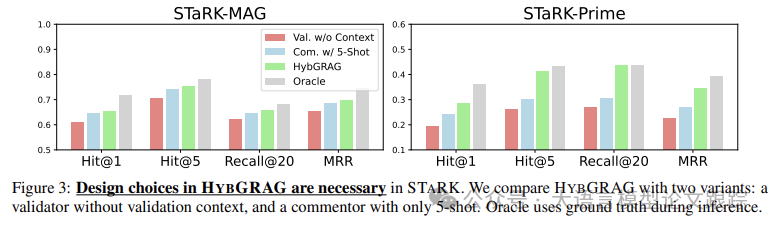

3.2 消融研究:HYB GRAG 的所有設計選擇是否必要?

3.2.1 評論模塊

把 HYB GRAG 變體與沒有驗證上下文的驗證器、僅有五次示例的評論者的情況進行對比。

圖片

圖片

從上圖可以看出,在所有的設計選擇下,HYB GRAG 表現最佳,接近標準性能。

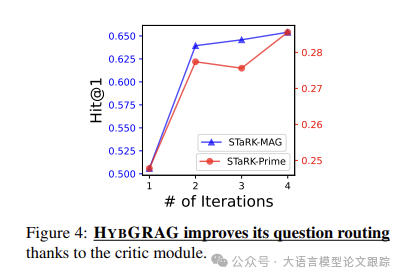

3.2.2 自我反思

圖片

圖片

從上圖可以看出,隨著更多的自我反思迭代,HYB GRAG 的性能進一步提升。當迭代次數從 1 增加到 2 時,性能顯著提高,其中第 1 次迭代未進行自我反思。同時表明,幾次迭代就已足夠,因為隨著迭代次數增多,改進逐漸減小。

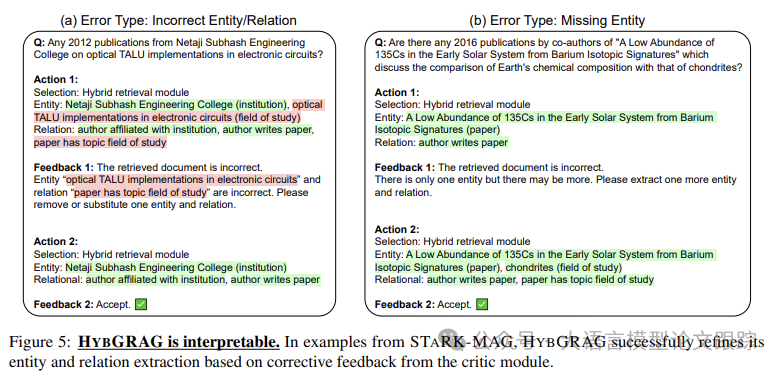

3.3 可解釋性:HYB GRAG 如何依據反饋優化其問題路由?

圖片

圖片

上圖展示了 STARK-MAG 中檢索器庫的路由器與評論模塊相互作用的實例。

上圖左側的首輪迭代中,路由器誤將“電子電路中的光學 TALU 實現”認定為代表研究領域的主題實體(關系方面)。由于基于此實體提取的圖和基于“Netaji Subhash 工程學院”提取的圖無交集,評論模塊判定前一實體更可能是文本方面。于是,它向路由器反饋,路由器也相應地進行處理。HYBGRAG 的這種優化路徑類似 CoT,具有可解釋性,方便用戶理解。

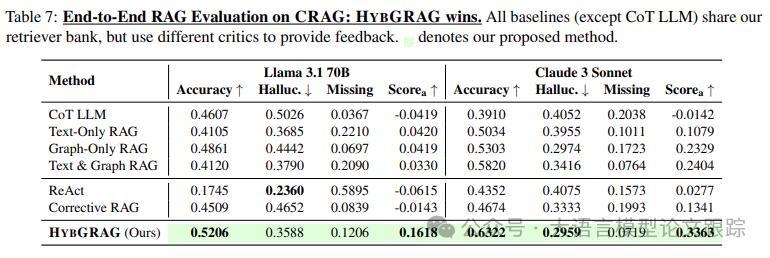

3.4 端到端評估

圖片

圖片

上表中,HYB GRAG 在 CRAG 中的表現優于所有基線。

? 具有單個檢索模塊的 RAG 無法應對兩種類型的問題。

? 具有連接參考的 RAG 也會因長參考中的無關內容而分心。

? 即便提供了相同的檢索庫,自反思基線仍難以優化自身行動。

? 由于 ReAct 依賴于 LLM 的思考能力并提供自然語言反饋,它往往缺少改進行動的明確指引。

? 沒有經過微調的檢索評估器,Corrective RAG 無法有效識別參考的有用性。這體現了帶有糾正反饋的評論模塊的優越性。

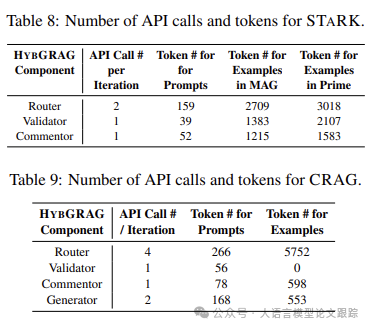

3.5 模型成本分析

圖片

圖片

上面兩個表分別匯總了 STARK 和 CRAG 中 HYB GRAG 迭代各步驟的 API 調用次數和令牌消耗。

盡管大部分令牌消耗源于用于 ICL 的示例,但提示本身所需令牌極少。而且,由于 HYB GRAG 把聊天 LLM 當作路由器,ICL 的示例僅需提供一次。

相較于 STARK 中的最先進基線 AVATAR,其訓練時至少需 500 次 API 調用,混合檢索模塊僅 2 次 API 調用,在 Hit@1 上就實現了 24%的相對提升,而 HYB GRAG 最多 14 次 API 調用就能達成 51%的提升,二者均無需訓練。

本文轉載自 ??大語言模型論文跟蹤??,作者:HuggingAGI