Falcon 3:阿聯酋技術創新研究所推出世界上最小、最強大的人工智能模型 原創

01、概述

近年來,大型語言模型(Large Language Models,LLMs)的發展成為人工智能領域的核心議題。而作為這一領域的先行者之一,位于阿布扎比的科技創新研究院(Technology Innovation Institute, TII)再次推出其重磅產品——Falcon3 系列。作為一組參數規模在10億以下的解碼器(Decoder-only)大型語言模型,Falcon3系列不僅在性能和訓練效率上取得了重要突破,還彰顯了TII致力于推動開放、可訪問的基礎模型的決心。

02、Falcon3 系列的亮點與演進

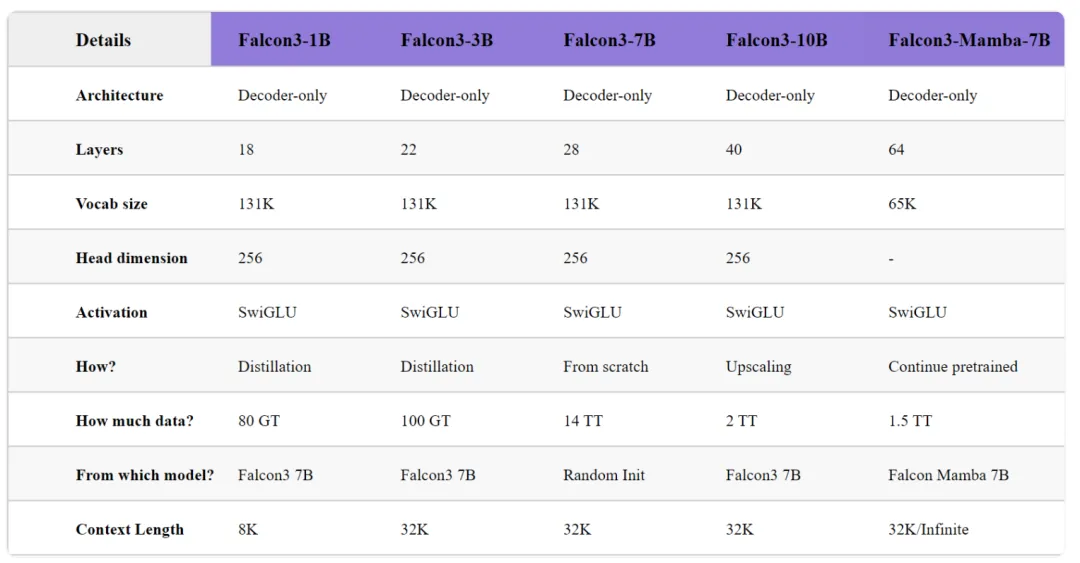

Falcon3 是對其前代模型的自然演進,重點提升了模型在科學、數學和代碼領域的能力。這一系列包含五個基礎模型:

- Falcon3-1B-Base

- Falcon3-3B-Base

- Falcon3-Mamba-7B-Base

- Falcon3-7B-Base

- Falcon3-10B-Base

這些模型通過一系列創新技術實現了高效訓練和卓越性能,以下是Falcon3在開發過程中實現的關鍵技術進展:

1) 大規模預訓練:

在開發Falcon3-7B模型時,研究團隊使用了1024顆H100 GPU芯片,并基于14萬億個高質量多語言數據(涵蓋Web內容、代碼及STEM領域),進行了一次大規模的預訓練。

2) 模型深度擴展:

通過對冗余層的復制和2萬億高質量數據的進一步訓練,研究團隊將7B模型擴展為10B參數的Falcon3-10B-Base,成功提升了零樣本(Zero-shot)和少樣本(Few-shot)任務性能。

3) 知識蒸餾技術:

為開發更加緊湊高效的小模型(如Falcon3-1B和Falcon3-3B),團隊采用了剪枝和知識蒸餾技術,利用不到100GB的精選數據完成預訓練,顯著提升了效率。

4) 強化數學推理能力:

Falcon Mamba 7B模型通過額外訓練1.5萬億高質量數據,形成了Falcon3-Mamba-7B-Base版本,大幅提升了推理和數學任務的表現。

5) 豐富的模型變體:

所有Falcon3基礎模型均提供多種變體,包括 Instruct、GGUF、GPTQ-Int4、GPTQ-Int8 等,滿足多樣化的應用需求。

03、性能與評估:Falcon3如何脫穎而出?

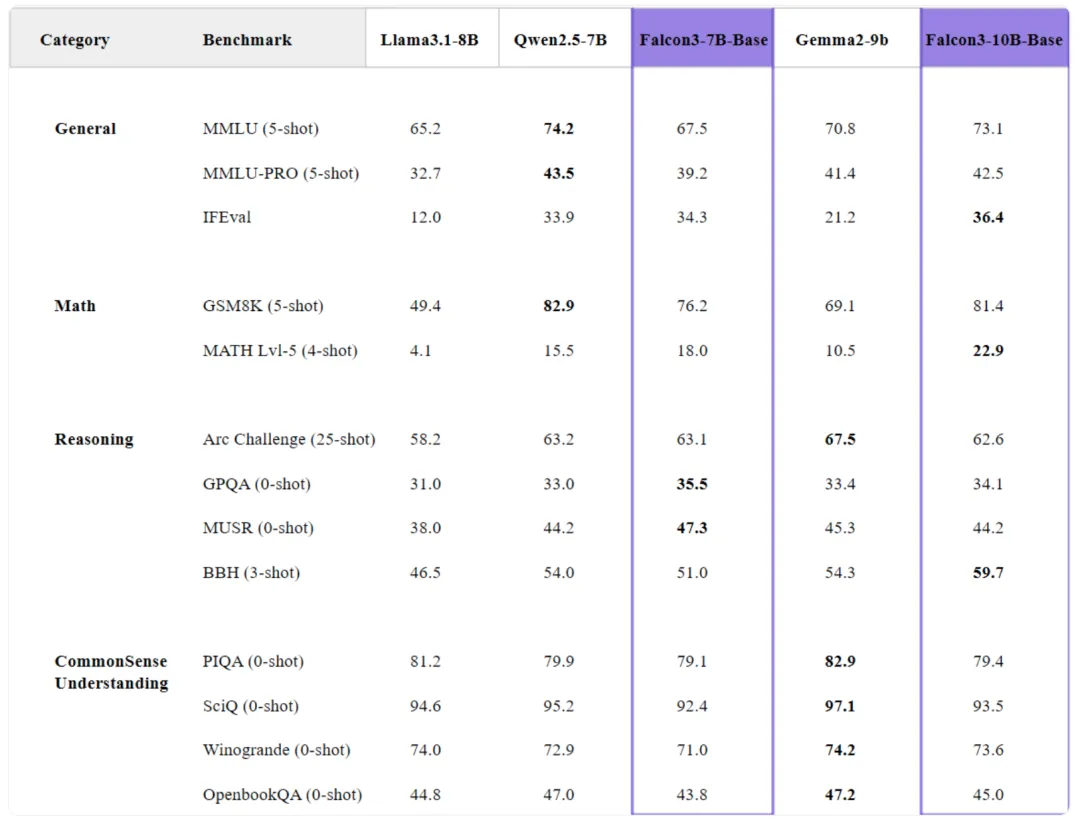

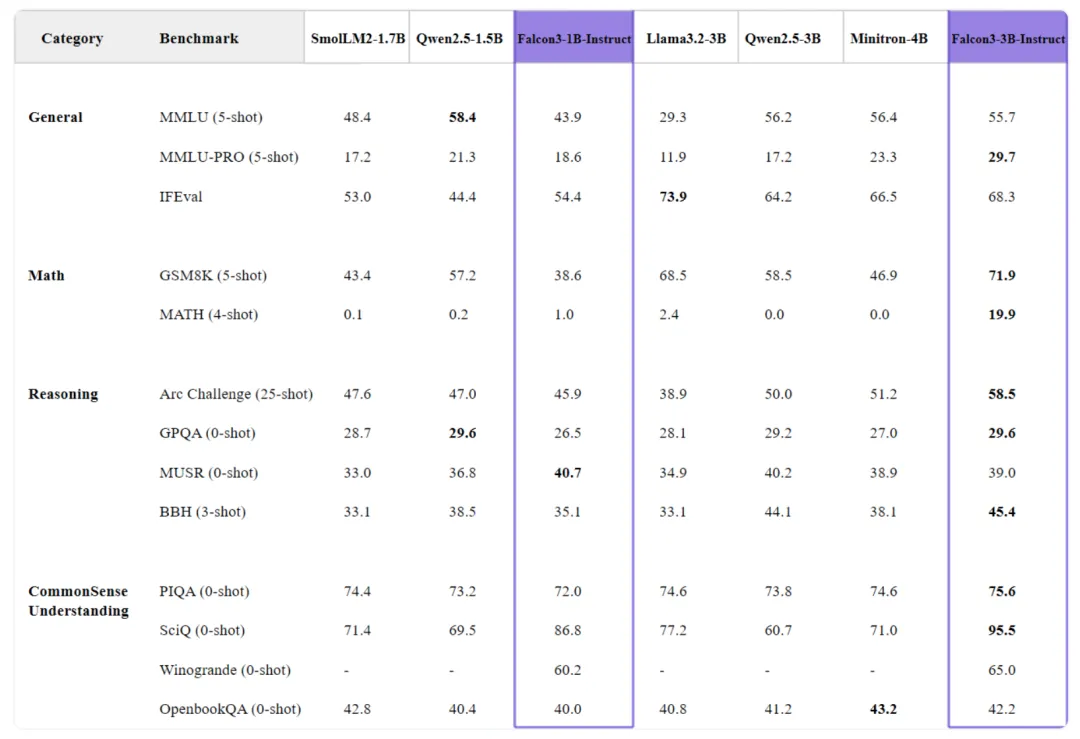

Falcon3 系列在常見基準測試中展現了超強實力,特別是在小型和中型模型領域中,其性能備受矚目。

1) 小模型的驚人表現:

Falcon3-1B-Base:在對比中超越了SmolLM2-1.7B,并與gemma-2-2B的表現相當。

Falcon3-3B-Base:在性能上優于規模更大的Llama-3.1-8B和Minitron-4B-Base,充分體現了知識蒸餾的訓練優勢。

2) 中型模型的卓越性能:

Falcon3-7B-Base:與Qwen2.5-7B在7B規模模型中旗鼓相當,在數學和推理任務中表現尤為突出。

Falcon3-10B-Base:作為13B以下規模模型中的佼佼者,在多項基準測試中取得領先。

3) Mamba模型的優異表現:

Falcon3-Mamba-7B在State Space Language Model(SSLM)領域繼續引領潮流,支持最長32K的上下文長度,同時保持卓越性能,適合用戶無縫集成。

04、擴展能力:科學、數學與編程的多領域突破

Falcon3的研發重點在于提升科學、數學和編程領域的能力,以下是一些關鍵評估數據:

1) 數學能力

Falcon3-10B-Base 在復雜數學任務中得分:MATH-Lvl5 22.9,GSM8K 83.0,表現極為亮眼。

2) 編程能力

在編程相關任務中,Falcon3-10B-Base 在 MBPP 上獲得 73.8 的高分,而其 Instruct 版本在 Multipl-E 上得分 45.8,展現了強大的代碼通用化能力。

3) 推理能力

Falcon3-7B 和 Falcon3-10B 在 BBH 測試中分別得分 51.0 和 59.7,證明其在復雜推理任務上的優勢。

4) 科學知識擴展

MMLU 基準測試結果顯示:Falcon3-7B-Base 和 Falcon3-10B-Base 分別在 MMLU 和 MMLU-PRO 中得分 67.4/39.2 和 73.1/42.5,反映了其在專業知識領域的強大能力。

05、技術細節與創新架構

模型架構優化:

Falcon3 系列基于解碼器(Decoder-only)結構,18到40層的Transformer深度,以及SwiGLU激活函數使其在FlashAttention-3優化下擁有高效的推理能力。

Falcon3-7B-Base采用了最大量的數據訓練,覆蓋了廣泛的概念和知識,為通用任務提供了出色的表現。

Falcon3-Mamba-7B 特有64層架構,專為數學和科學任務優化。

上下文長度擴展:

除1B模型支持8K上下文外,其他模型均支持長達32K的上下文,使其在大規模文本處理任務中表現優越。

Falcon3 的開放承諾

TII一貫致力于推動AI的開放與合作,Falcon3 系列模型也不例外。所有模型均采用 Falcon LLM許可證 開源,鼓勵全球AI社區進行研究、應用開發和實驗。更重要的是,Falcon3不僅是這一系列的高光時刻,更是其持續創新之路的延續。

值得期待的是,2025年1月,TII將發布支持圖像、視頻及音頻的多模態增強版本,同時公布詳細的技術報告,為AI領域貢獻更多智慧。

06、結語

Falcon3系列的推出標志著AI技術的一次重要跨越。通過其在性能、效率和靈活性上的全面提升,Falcon3 不僅為開發者和研究人員提供了強大的工具,更開啟了一個更開放、更高效的AI未來。

參考:

本文轉載自公眾號Halo咯咯 作者:基咯咯

原文鏈接:??https://mp.weixin.qq.com/s/Q0ndlsdetJmwAiZmX0PW1Q??