一文讀懂 RAG-Gym:用過(guò)程監(jiān)督優(yōu)化推理與搜索智能體 精華

傳統(tǒng)的檢索增強(qiáng)生成(RAG)架構(gòu)依賴于靜態(tài)檢索,這使得它們?cè)谔幚硇枰樞蛐畔⑺阉鞯膹?fù)雜問(wèn)題時(shí),效果大打折扣。雖然智能推理和搜索提供了一種更具適應(yīng)性的方法,但現(xiàn)有的大多數(shù)方法在很大程度上都依賴于提示工程。

為了解決這一問(wèn)題,本文介紹了 RAG-Gym,這是一個(gè)統(tǒng)一的優(yōu)化框架,它通過(guò)在每個(gè)搜索步驟進(jìn)行細(xì)粒度的過(guò)程監(jiān)督,來(lái)提升信息搜索智能體的性能。

核心貢獻(xiàn)

- 引入 RAG-Gym,這是一個(gè)利用過(guò)程監(jiān)督優(yōu)化智能 RAG 的統(tǒng)一框架。

- 提出 ReSearch,這是一種全新的智能體架構(gòu),它將答案推理和搜索協(xié)同起來(lái),比現(xiàn)有的基線模型取得了更優(yōu)異的性能。

- 證明了使用經(jīng)過(guò)訓(xùn)練的過(guò)程獎(jiǎng)勵(lì)模型作為驗(yàn)證器,可以顯著提升搜索智能體的性能。

- 全面分析了過(guò)程監(jiān)督的來(lái)源、獎(jiǎng)勵(lì)模型的可遷移性,以及智能 RAG 中的縮放定律。?

RAG-Gym 框架

一、概述

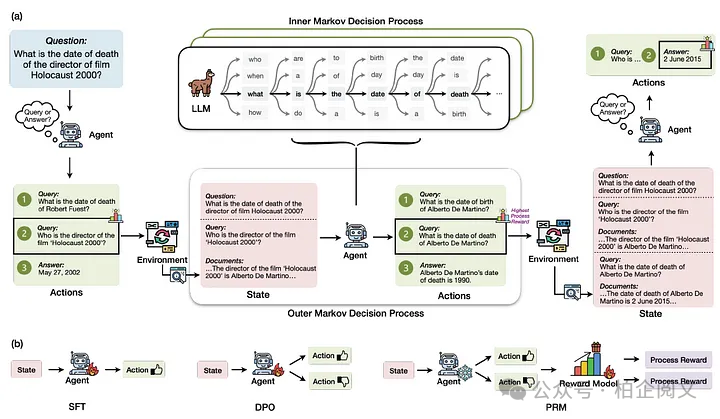

RAG-Gym 將知識(shí)密集型問(wèn)答任務(wù)構(gòu)建為一個(gè)嵌套的馬爾可夫決策過(guò)程(MDP)。

過(guò)程獎(jiǎng)勵(lì)數(shù)據(jù)是通過(guò)在每個(gè)時(shí)間步隨機(jī)抽樣動(dòng)作候選,并使用外部注釋器選擇最佳動(dòng)作來(lái)收集的。

RAG-Gym 中實(shí)現(xiàn)了不同的過(guò)程監(jiān)督方法。

二、知識(shí)密集型問(wèn)答作為嵌套 MDP

- 外部 MDP 的構(gòu)建:旨在歸納各種針對(duì)知識(shí)密集型問(wèn)題的語(yǔ)言智能體設(shè)計(jì),具體過(guò)程如下:

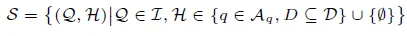

- 狀態(tài)空間 S:在每個(gè)時(shí)間步 t,狀態(tài) st ∈ S 由原始問(wèn)題 Q 和信息搜索歷史 Ht 組成,表示為:st = (Q,Ht) ,其中 Ht = {(q1,D1), · · · , (qt?1,Dt?1)}是信息搜索查詢 q1, · · · , qt?1 以及它們對(duì)應(yīng)的由環(huán)境返回的檢索文檔 D1, · · · , Dt?1 的歷史記錄。狀態(tài)空間 S 是所有可能狀態(tài)的集合:

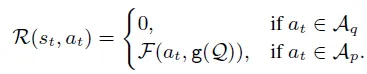

其中 I 是問(wèn)題空間,Aq 是所有可能搜索查詢的空間,D 是所有文檔的空間。 - 動(dòng)作空間 A:在每個(gè)時(shí)間步 t,動(dòng)作 at 可以是一個(gè)搜索查詢,也可以是對(duì)原始問(wèn)題的預(yù)測(cè)答案。因此,我們將動(dòng)作空間 A 定義為 A = Aq ∪ Ap ,其中 Aq 是所有可能查詢的集合,Ap 表示可能答案的集合。 - IR 環(huán)境:RAG-Gym 中外部 MDP 的環(huán)境由一個(gè)信息檢索(IR)系統(tǒng)驅(qū)動(dòng),該系統(tǒng)將搜索查詢 qt 作為輸入,并返回一組相關(guān)文檔 Dt 作為輸出。IR 系統(tǒng)可以表示為從 Aq 到 P(D)的映射,其中 P(D)是 D 的冪集。檢索過(guò)程由底層文本檢索器和特定的檢索設(shè)置(例如返回文檔的數(shù)量)決定。 - MDP 工作流程:對(duì)于給定的問(wèn)題 Q,MDP 從初始狀態(tài) s1 = (Q, ?)開(kāi)始。在每個(gè)步驟 t,at 是從智能體的策略 πf(θ)(· | st)中采樣得到的,其中 πf(θ) : S → Δ(A)定義了給定狀態(tài)下的動(dòng)作分布。智能體的策略由 θ(表示基礎(chǔ)語(yǔ)言模型的參數(shù))和特定于智能體的函數(shù) f(表示如何利用基礎(chǔ) LLM 策略)組成。然后,通過(guò)添加(qt,Dt)來(lái)更新歷史記錄為 Ht+1 ,狀態(tài)轉(zhuǎn)換為 st+1 = (Q,Ht+1) 。否則,如果 at ∈ Ap ,則認(rèn)為當(dāng)前情節(jié)完成,MDP 終止。 - 獎(jiǎng)勵(lì):對(duì)于外部 MDP,一個(gè)情節(jié)的獎(jiǎng)勵(lì)由最終預(yù)測(cè)的正確性決定。狀態(tài)-動(dòng)作對(duì)(st, at)的即時(shí)獎(jiǎng)勵(lì)為:

外部 MDP 中智能體的目標(biāo)是最大化軌跡上的預(yù)期累積獎(jiǎng)勵(lì):

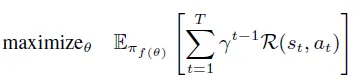

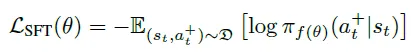

- 通過(guò)過(guò)程監(jiān)督改進(jìn)搜索智能體:通過(guò)納入過(guò)程獎(jiǎng)勵(lì),RAG-Gym 能夠更有效地對(duì)大語(yǔ)言模型(LLM)進(jìn)行微調(diào),使標(biāo)記生成與高質(zhì)量的搜索行為保持一致。 -過(guò)程獎(jiǎng)勵(lì)數(shù)據(jù)的收集:數(shù)據(jù)收集流程從軌跡采樣開(kāi)始,語(yǔ)言智能體根據(jù)其當(dāng)前策略生成一系列動(dòng)作。在軌跡的每個(gè)步驟中,會(huì)提出多個(gè)候選動(dòng)作,并根據(jù)預(yù)定義的評(píng)估標(biāo)準(zhǔn)選擇最佳動(dòng)作。我們采用基于排名的評(píng)估框架,而不是分配數(shù)值分?jǐn)?shù),以確保一致性。然后執(zhí)行選定的動(dòng)作,軌跡轉(zhuǎn)移到下一個(gè)狀態(tài)。這個(gè)過(guò)程反復(fù)迭代,直到軌跡終止。為了確保質(zhì)量,只有最終答案正確的軌跡才會(huì)被保留,這由結(jié)果獎(jiǎng)勵(lì)來(lái)判斷。 -使用過(guò)程監(jiān)督調(diào)整智能體-監(jiān)督微調(diào)(SFT):從過(guò)程獎(jiǎng)勵(lì)中選擇的動(dòng)作用于訓(xùn)練語(yǔ)言智能體。正式地說(shuō),SFT 的目標(biāo)是最小化給定狀態(tài)下選定動(dòng)作的負(fù)對(duì)數(shù)似然:

- 其中 D 是帶有過(guò)程獎(jiǎng)勵(lì)標(biāo)記的狀態(tài)-動(dòng)作對(duì)的數(shù)據(jù)集。 -直接偏好優(yōu)化(DPO):引入了一個(gè)對(duì)比學(xué)習(xí)框架,該框架同時(shí)考慮了選定和未選定的動(dòng)作。過(guò)程獎(jiǎng)勵(lì)數(shù)據(jù)被重新組織為偏好對(duì)(a+t , a?t ),其中 a+t 是對(duì)于 st 更偏好的動(dòng)作,a?t 是較不偏好的替代動(dòng)作。DPO 的目標(biāo)是最小化以下?lián)p失:

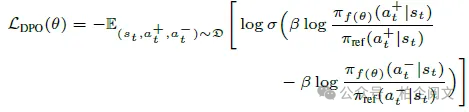

- -過(guò)程獎(jiǎng)勵(lì)建模(PRM):訓(xùn)練一個(gè)單獨(dú)的獎(jiǎng)勵(lì)模型 r?(st, at),以根據(jù)收集的數(shù)據(jù)預(yù)測(cè)過(guò)程獎(jiǎng)勵(lì)。目標(biāo)是最小化一個(gè)對(duì)比損失,該損失評(píng)估更偏好動(dòng)作相對(duì)于較不偏好動(dòng)作的質(zhì)量:

推理與搜索(ReSearch)智能體

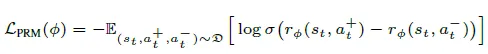

推理與搜索(ReSearch)智能體在一個(gè)統(tǒng)一的、以答案為驅(qū)動(dòng)的框架中集成了推理和搜索。

- 歷史知識(shí)總結(jié):給定狀態(tài) st ,其中包含原始問(wèn)題 Q 和歷史 Ht = {(q1,D1), . . . , (qt?1,Dt?1)},智能體首先會(huì)將檢索到的文檔總結(jié)為對(duì)相應(yīng)查詢的結(jié)構(gòu)化響應(yīng),形成一個(gè)精煉的知識(shí)表示 H′t: H′t = {(q1,m1), . . . , (qt?1,mt?1)} 總結(jié)步驟會(huì)過(guò)濾掉不相關(guān)的信息,并減輕長(zhǎng)上下文處理的挑戰(zhàn),使智能體在構(gòu)建答案時(shí)能夠?qū)W⒂谧钕嚓P(guān)的事實(shí)。

- 答案推理:利用這個(gè)精煉的知識(shí) H′t ,智能體接著進(jìn)行結(jié)構(gòu)化推理,以推斷出問(wèn)題的候選答案。然后,它會(huì)檢查推理步驟,并判斷所有的主張是否都在歷史記錄中有充分的依據(jù)。如果智能體確定答案推理中的所有主張都有檢索到的證據(jù)支持,它就會(huì)將答案作為最終動(dòng)作輸出。否則,它會(huì)識(shí)別出未經(jīng)驗(yàn)證的主張,即那些根據(jù)現(xiàn)有證據(jù)缺乏充分理由的陳述。

- 搜索查詢生成:未經(jīng)驗(yàn)證的主張作為生成下一個(gè)搜索查詢的基礎(chǔ),這個(gè)查詢專(zhuān)門(mén)用于檢索缺失的信息。從這個(gè)查詢中檢索到的文檔隨后會(huì)被添加到 Ht 中,推理過(guò)程會(huì)反復(fù)迭代,直到所有主張都得到驗(yàn)證,或者檢索預(yù)算用盡。

實(shí)驗(yàn)結(jié)果

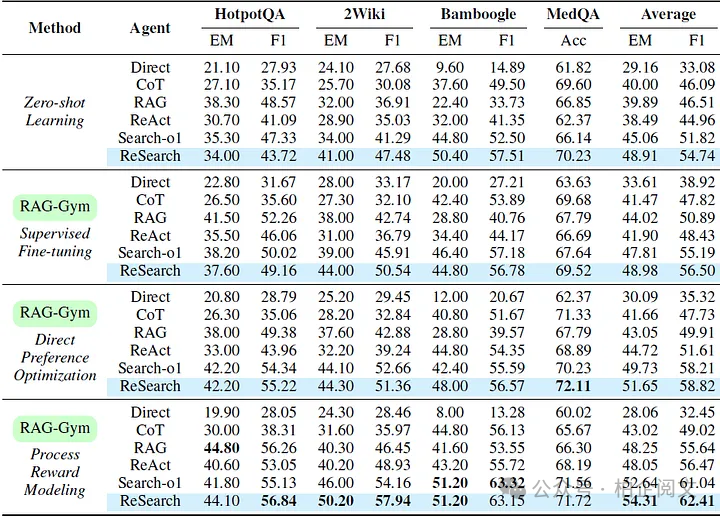

- 過(guò)程監(jiān)督方法的比較:下表展示了使用 Llama-3.1–8B-Instruct 實(shí)現(xiàn)的各種智能體,以及它們?cè)?RAG-Gym 中使用不同過(guò)程監(jiān)督方法進(jìn)行微調(diào)后的性能。與零樣本學(xué)習(xí)(ZSL)基線相比,過(guò)程監(jiān)督在所有智能體上都一致地提高了性能,證明了其在增強(qiáng)中間推理和查詢生成方面的有效性。在三種過(guò)程監(jiān)督算法中,PRM 總體上取得了最好的結(jié)果,比 ZSL 基線的平均 F1 得分高出 25.6%(ReAct)。

- ReSearch 與其他智能體的比較:結(jié)果還表明,在零樣本學(xué)習(xí)設(shè)置和有過(guò)程監(jiān)督的設(shè)置中,ReSearch 始終優(yōu)于其他智能體。在未經(jīng)調(diào)優(yōu)的情況下,ReSearch 就實(shí)現(xiàn)了很強(qiáng)的零樣本性能,證明了明確地將答案推理與查詢生成對(duì)齊的有效性。使用過(guò)程獎(jiǎng)勵(lì)模型后,ReSearch 達(dá)到了最先進(jìn)的性能,在不同數(shù)據(jù)集上的平均 EM 得分達(dá)到 54.31%,平均 F1 得分達(dá)到 62.41%。

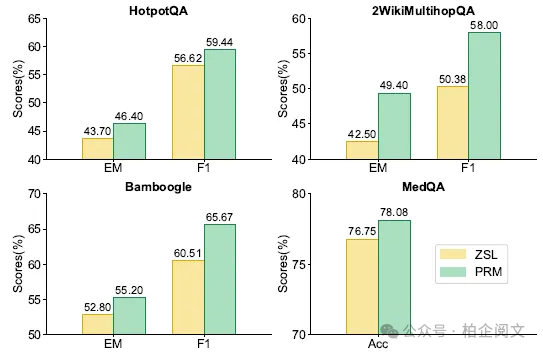

- 獎(jiǎng)勵(lì)模型的可遷移性:下圖突出顯示了使用基于 Llama-3.1–8B 的過(guò)程獎(jiǎng)勵(lì)模型的 GPT-4o-mini 的 ReSearch 智能體的性能提升。使用獎(jiǎng)勵(lì)模型進(jìn)行動(dòng)作選擇在所有任務(wù)中都帶來(lái)了一致的收益,證明了 PRM 在不同大語(yǔ)言模型中有效選擇高質(zhì)量動(dòng)作的可遷移性。

分析

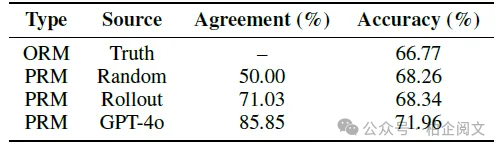

- 不同獎(jiǎng)勵(lì)來(lái)源的比較:四位領(lǐng)域?qū)<覍?duì) 200 個(gè) MedQA 問(wèn)題進(jìn)行了注釋。在其余 800 個(gè)用 GPT-4o 注釋的訓(xùn)練問(wèn)題上訓(xùn)練了一個(gè)獎(jiǎng)勵(lì)模型,并將其偏好與領(lǐng)域?qū)<业钠眠M(jìn)行了比較。下表顯示了領(lǐng)域?qū)<移门c不同來(lái)源獎(jiǎng)勵(lì)估計(jì)之間的一致性。使用 GPT-4o 注釋訓(xùn)練的獎(jiǎng)勵(lì)模型與人類(lèi)偏好的一致性最高(85.85%),顯著優(yōu)于 Math-Shepherd 中引入的基于滾動(dòng)的方法(71.03%)。這表明在這種情況下,GPT-4o 注釋與人類(lèi)推理和決策緊密對(duì)齊。

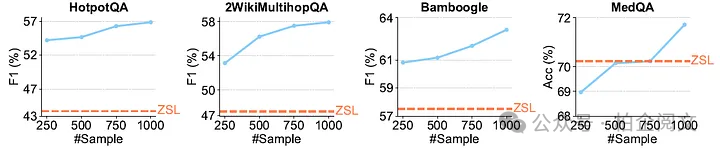

- 訓(xùn)練時(shí)間縮放:下圖展示了使用在不同數(shù)量訓(xùn)練樣本上微調(diào)的過(guò)程獎(jiǎng)勵(lì)模型的 ReSearch 智能體的性能。結(jié)果表明,ReSearch 的性能隨著訓(xùn)練樣本數(shù)量的增加而提高,但隨著樣本量的增長(zhǎng),收益趨于收斂。

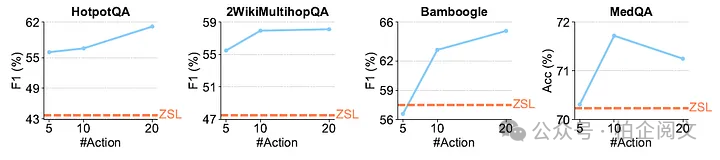

- 推理時(shí)間縮放:以 ReSearch 為測(cè)試智能體,下圖展示了我們的推理時(shí)間縮放研究結(jié)果。在多個(gè)基準(zhǔn)測(cè)試中觀察到一致的趨勢(shì),即增加采樣動(dòng)作的數(shù)量通常會(huì)提高性能。

研究結(jié)論

本文介紹了 RAG-Gym,這是一個(gè)通過(guò)過(guò)程監(jiān)督優(yōu)化推理和搜索智能體的框架,并引入了 ReSearch,這是一種將答案推理與搜索查詢生成統(tǒng)一起來(lái)的智能體架構(gòu)。實(shí)驗(yàn)表明,RAG-Gym 在知識(shí)密集型任務(wù)上改進(jìn)了搜索智能體,ReSearch 始終優(yōu)于基線模型。研究還證明了使用大語(yǔ)言模型作為過(guò)程獎(jiǎng)勵(lì)評(píng)判的有效性、訓(xùn)練后的獎(jiǎng)勵(lì)模型在不同大語(yǔ)言模型上的可遷移性,以及 ReSearch 在訓(xùn)練和推理過(guò)程中的縮放模式。

本文轉(zhuǎn)載自 ??柏企科技圈??,作者:柏企