一鍵換裝,讓奧特曼、黃仁勛穿上機器之心的文化衫

AI 幫你來試衣,想穿什么款式一鍵搞定。

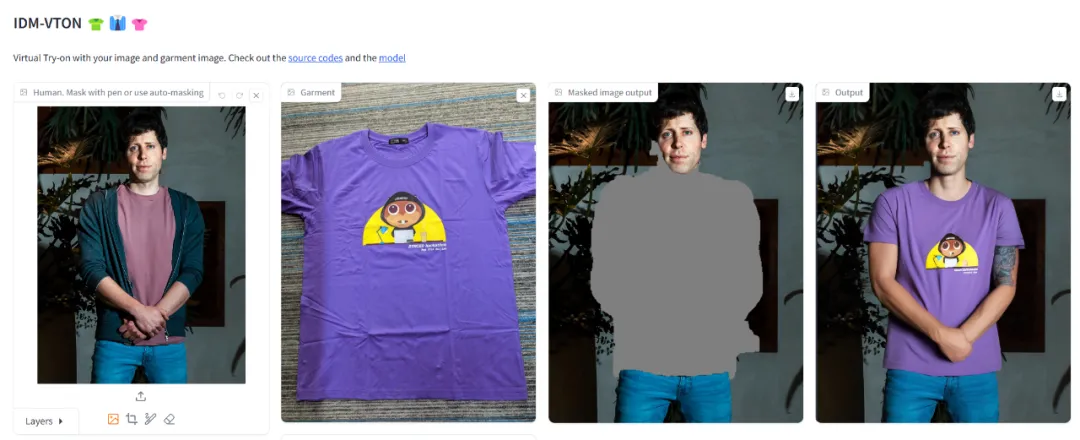

精準捕捉服裝細節,衣服紋理、圖案、縫線等屬性高度還原:

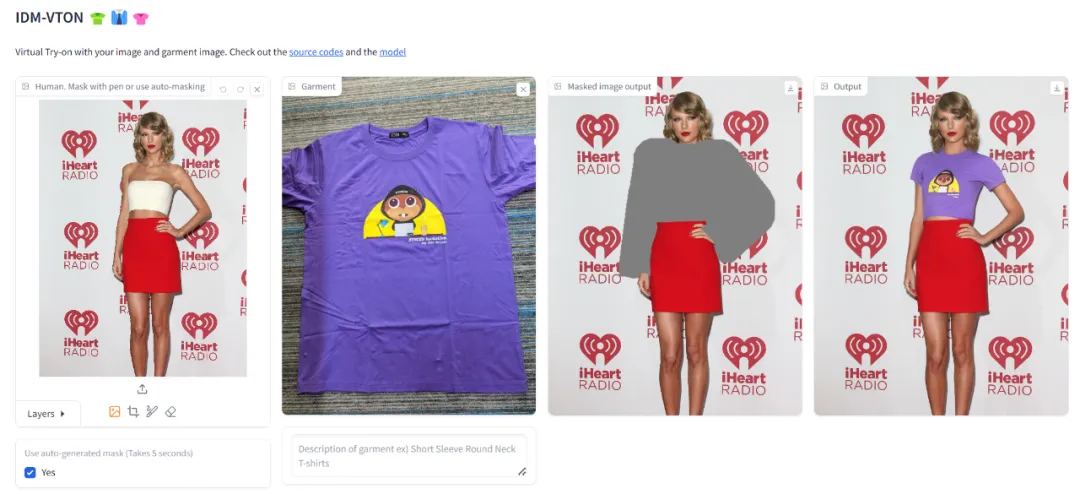

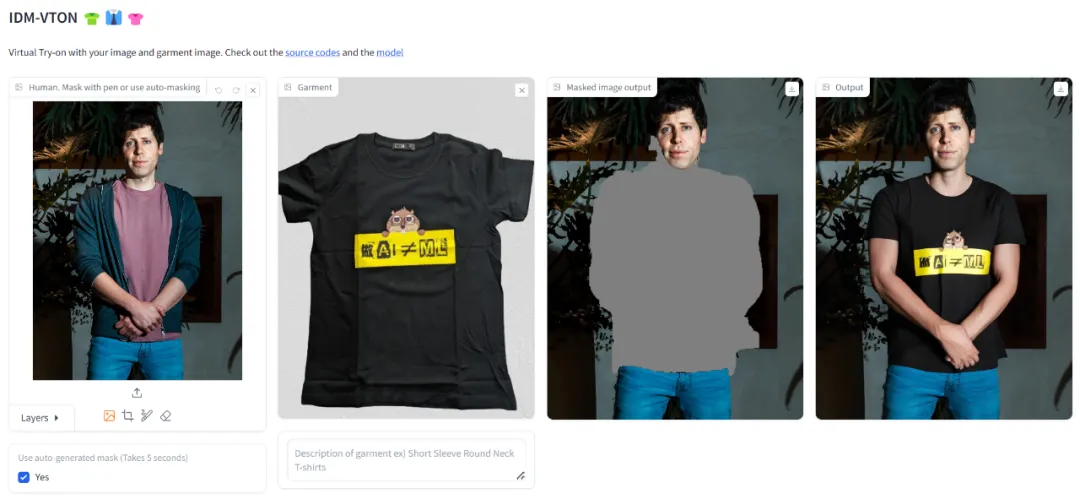

即使是在戶外,AI 試衣也能準確展示試穿效果,保持較高質量的輸出:

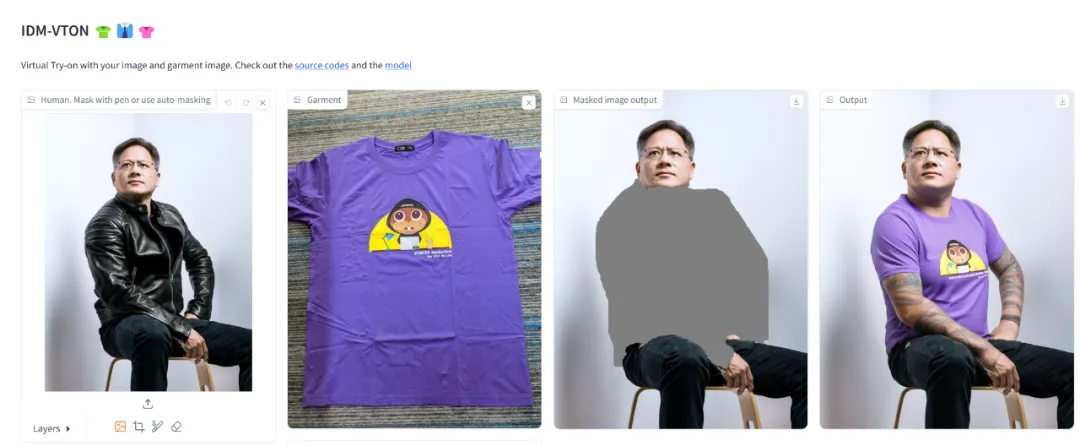

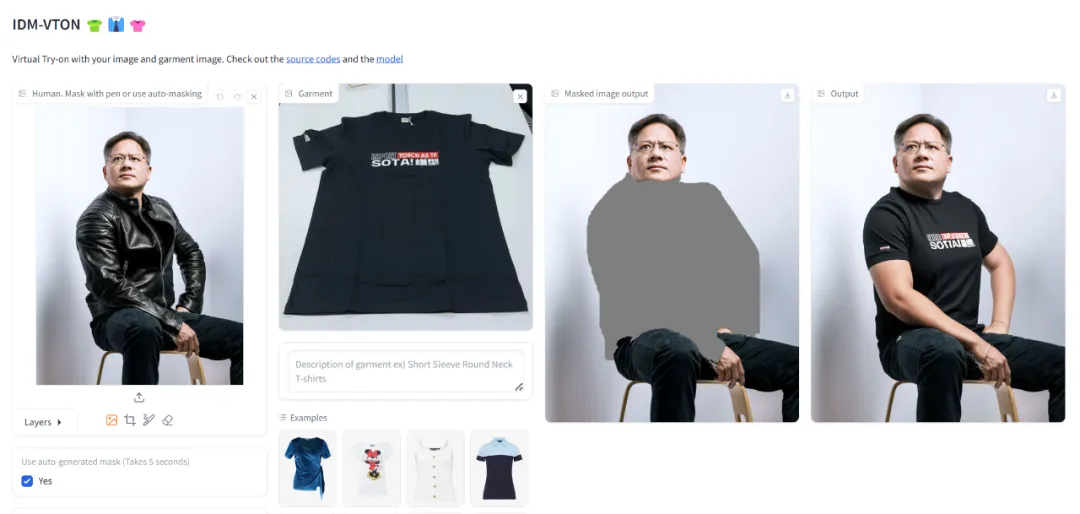

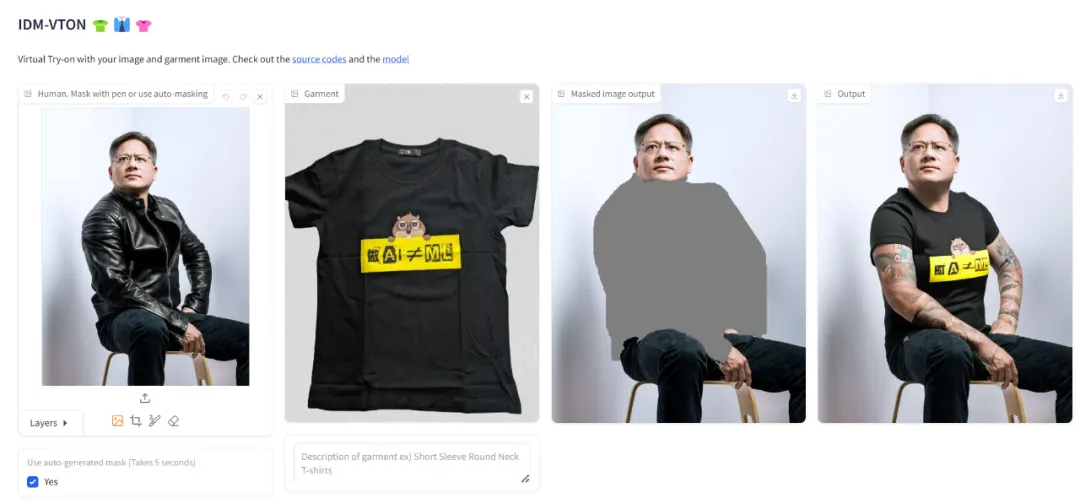

人物坐立姿勢對衣物有遮擋,AI 也會毫無破綻的實現一鍵換衣,高度保持服裝細節的一致性:

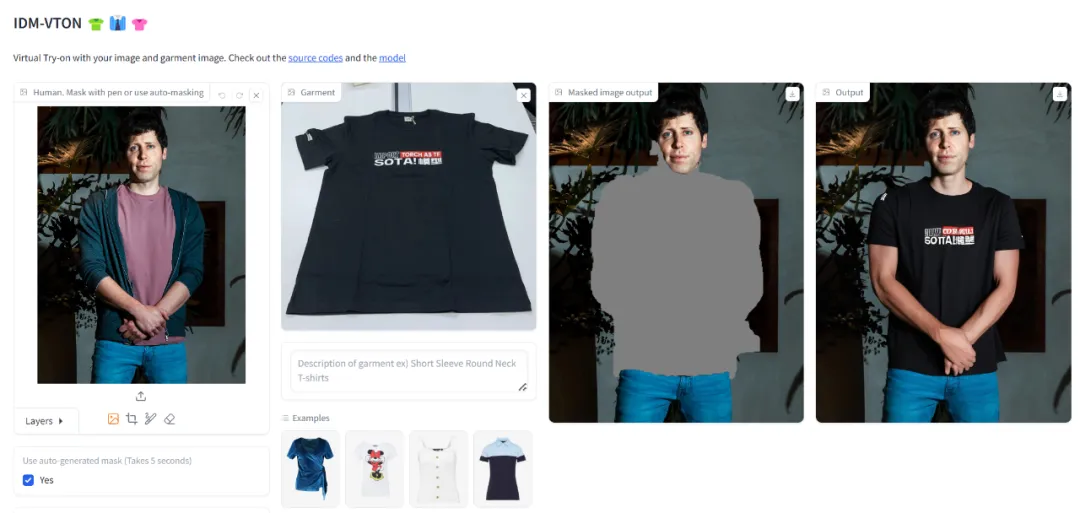

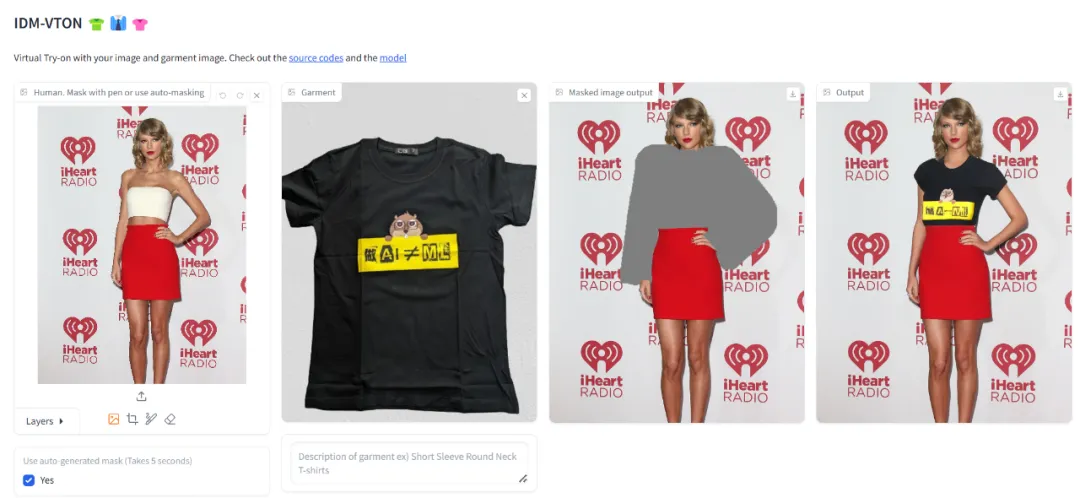

既然 demo 演示這么厲害,那試試讓黃仁勛、奧特曼、霉霉等名人穿上機器之心的文化衫,出來的效果會怎么樣呢?

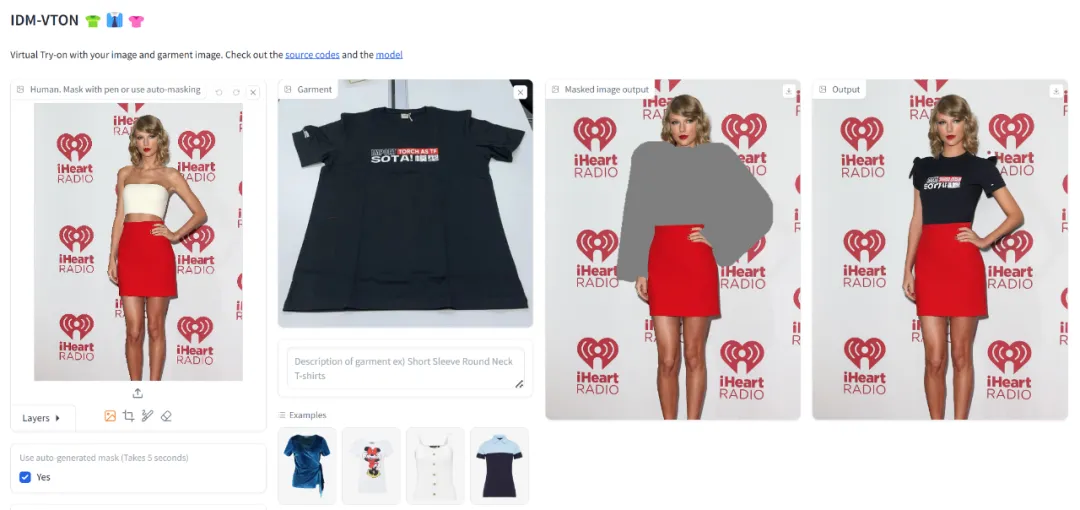

換裝 1:

換裝 2:

換裝 3:

試用地址:https://huggingface.co/spaces/yisol/IDM-VTON

試用了幾輪下來,換裝效果的確不錯,但也有一些瑕疵,比如換裝后有時會出現大花臂、衣服上的字體沒有很好地還原、手部變形。

上面展示的虛擬試衣技術由韓國科學技術院 (KAIST) 、 OMNIOUS.AI 共同打造,他們提出了一種名為??????-????????的新型擴散模型,該技術在提高服裝保真度的同時,還能生成真實的視覺效果。

- 論文地址:https://arxiv.org/pdf/2403.05139.pdf

- 論文主頁:https://idm-vton.github.io/

- 論文標題:Improving Diffusion Models for Authentic Virtual Try-on in the Wild?

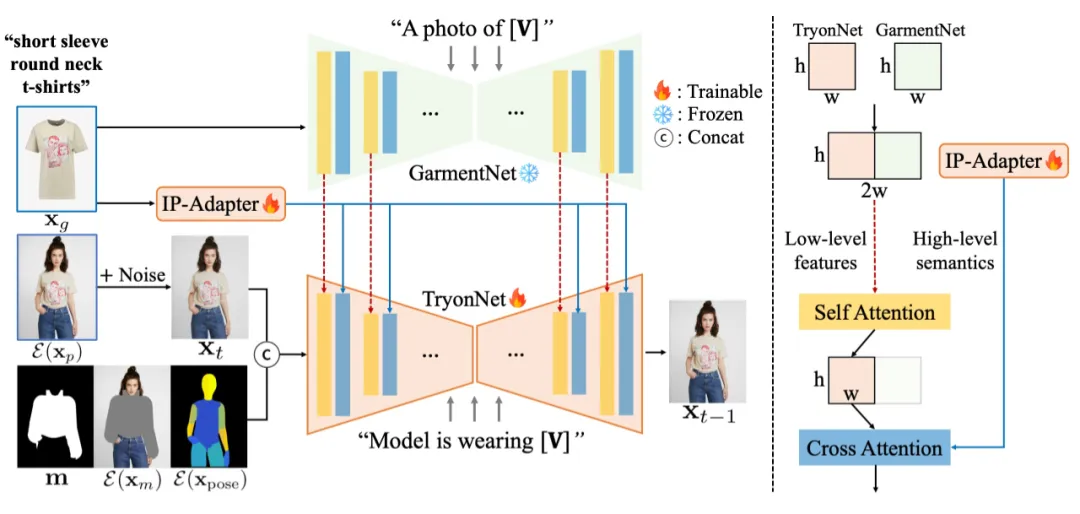

IDM-VTON 整體 pipelne 如下圖左所示:IDM-VTON 包括(1)TryonNet 用于處理人物圖像;(2)圖像提示適配器(IP-Adapter)用于編碼服裝圖像的高級語義;(3)GarmentNet 用于編碼低級特征。

在 UNet 輸入中,本文將人物圖像潛在的噪聲潛在與分割掩碼、掩碼圖像和 DensePose 進行了拼接。本文還提供了服裝的詳細說明(例如,[V]:短袖圓領 t 恤),然后這些說明作為 GarmentNet 和 TryonNet 的輸入提示。

注意力模塊細節如下圖右所示:TryonNet 和 GarmentNet 的中間特征被連接起來并傳遞到自注意力層,并使用輸出的前半部分(即來自 TryonNet 的部分)。然后通過交叉注意力層將輸出與來自文本編碼器和 IP-Adapter 的特征融合。此外,本文還對 TryonNet 和 IP-Adapter 模塊進行微調,同時凍結其他組件。

最后,我們再展示一下 IDM-VTON 的其他效果。

多人試穿同一件衣服:結果顯示 IDM-VTON 可以生成高保真圖像,識別服裝細節。

IDM-VTON 和其他方法的比較結果可以看出,IDM-VTON 能夠生成真實的圖像并能夠保留服裝的細粒度細節。

了解更多內容,請參考原論文。

本文轉自 機器之心 ,作者:機器之心