阿里開(kāi)源VRAG-RL:定義下一代檢索增強(qiáng)生成

在數(shù)字化時(shí)代,視覺(jué)信息在知識(shí)傳遞和決策支持中的重要性日益凸顯。然而,傳統(tǒng)的檢索增強(qiáng)型生成(RAG)方法在處理視覺(jué)豐富信息時(shí)面臨著諸多挑戰(zhàn)。一方面,傳統(tǒng)的基于文本的方法無(wú)法處理視覺(jué)相關(guān)數(shù)據(jù);另一方面,現(xiàn)有的視覺(jué) RAG 方法受限于定義的固定流程,難以有效激活模型的推理能力。

來(lái)自阿里巴巴通義實(shí)驗(yàn)室的最新研究成果——VRAG-RL(Empower Vision-Perception-Based RAG for Visually Rich Information Understanding via Iterative Reasoning with Reinforcement Learning),將強(qiáng)化學(xué)習(xí)算法引入多模態(tài)智能體訓(xùn)練,借助迭代推理和視覺(jué)感知空間,全方位提升視覺(jué)語(yǔ)言模型(VLMs)在檢索、推理和理解視覺(jué)信息方面的能力,為純視覺(jué)檢索增強(qiáng)生成任務(wù)提供有效解決方案,代碼、模型全面開(kāi)源!

Paper地址:https://arxiv.org/pdf/2505.22019

Github地址:https://github.com/Alibaba-NLP/VRAG

為了解決現(xiàn)有RAG方法在處理視覺(jué)豐富文檔時(shí)面臨的挑戰(zhàn),尤其是生成階段推理能力不足的問(wèn)題,我們推出了VRAG-RL,該框架引入強(qiáng)化學(xué)習(xí),專為視覺(jué)豐富信息復(fù)雜推理量身定制。VRAG-RL通過(guò)定義視覺(jué)感知?jiǎng)幼骺臻g,使模型能夠從粗到細(xì)地逐步聚焦信息密集區(qū)域,精準(zhǔn)提取關(guān)鍵視覺(jué)信息,從而全方位提升視覺(jué)語(yǔ)言模型(VLMs)在檢索、推理和理解視覺(jué)信息方面的能力。

與此同時(shí),我們注意到現(xiàn)有的方法在將用戶查詢轉(zhuǎn)化為搜索引擎可理解的檢索請(qǐng)求時(shí),常常因無(wú)法精準(zhǔn)表達(dá)需求而難以檢索到相關(guān)信息,往往存在語(yǔ)義偏差或信息缺失的問(wèn)題。這不僅影響了檢索結(jié)果的相關(guān)性,還限制了模型在后續(xù)生成階段的推理能力。為了解決這一問(wèn)題,VRAG-RL引入了一種創(chuàng)新的檢索機(jī)制,通過(guò)結(jié)合視覺(jué)感知?jiǎng)幼骱蛷?qiáng)化學(xué)習(xí),使模型能夠更有效地與搜索引擎進(jìn)行交互。這種機(jī)制不僅能夠幫助模型更精準(zhǔn)地表達(dá)檢索需求,還能夠在檢索過(guò)程中動(dòng)態(tài)調(diào)整檢索策略,從而顯著提升檢索效率和結(jié)果的相關(guān)性。

? 重定義感知行動(dòng)空間,視覺(jué)仿生思考新范式

傳統(tǒng)RAG方法在處理視覺(jué)信息時(shí),往往采用固定的檢索-生成流程,即先通過(guò)搜索引擎檢索相關(guān)信息,然后直接生成答案。這種固定流程忽略了視覺(jué)信息的獨(dú)特性,無(wú)法充分利用視覺(jué)數(shù)據(jù)中的豐富細(xì)節(jié),導(dǎo)致推理能力受限。

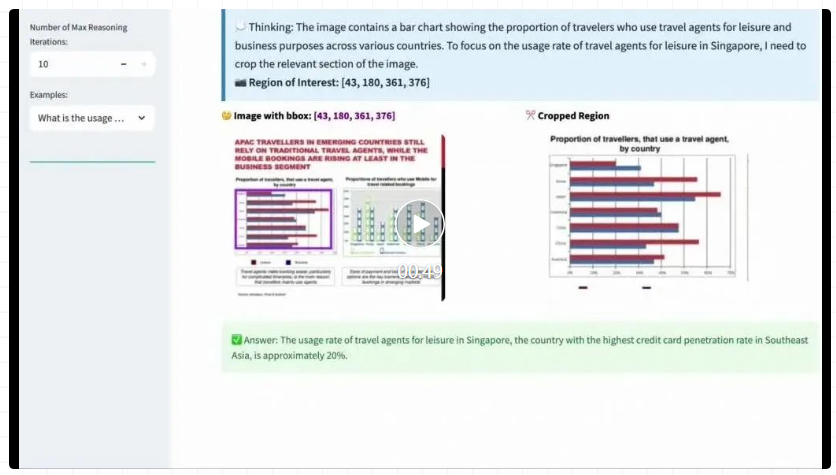

相比之下,VRAG-RL徹底革新了傳統(tǒng)的檢索生成范式,引入了多樣化的視覺(jué)感知?jiǎng)幼鳎渲邪硕喾N視覺(jué)感知?jiǎng)幼鳎鐓^(qū)域選擇、裁剪、縮放等。這些動(dòng)作使VLMs能夠從粗粒度到細(xì)粒度逐步聚焦信息密集區(qū)域,精準(zhǔn)提取關(guān)鍵視覺(jué)信息。例如,在處理復(fù)雜的圖表或布局時(shí),模型可以先從整體圖像中提取大致信息,然后逐步聚焦到信息密集的區(qū)域,通過(guò)裁剪和縮放操作,獲取更清晰、更詳細(xì)的視覺(jué)信息。這種從粗粒度到細(xì)粒度的感知方式,不僅提高了模型對(duì)視覺(jué)信息的理解能力,還顯著提升了檢索效率,使模型能夠更快速地定位到與問(wèn)題相關(guān)的圖像內(nèi)容。

VRAG-RL采用了多專家采樣策略構(gòu)建訓(xùn)練數(shù)據(jù),大規(guī)模模型負(fù)責(zé)確定整體的推理路徑,而專家模型則在大規(guī)模模型的指導(dǎo)下,對(duì)圖像中的關(guān)鍵區(qū)域進(jìn)行精確標(biāo)注,結(jié)合大規(guī)模模型的推理能力和專家模型的精確標(biāo)注能力,模型能夠在訓(xùn)練過(guò)程中學(xué)習(xí)到更有效的視覺(jué)感知策略,顯著提升了模型在實(shí)際應(yīng)用中的表現(xiàn)。

?? 檢索與推理協(xié)同優(yōu)化,效率與深度雙重提升

VRAG-RL 的細(xì)粒度獎(jiǎng)勵(lì)機(jī)制將檢索效率、模式一致性與生成質(zhì)量三方面因素融合,引導(dǎo)模型在與搜索引擎的交互中不斷優(yōu)化其檢索與推理路徑。

檢索效率獎(jiǎng)勵(lì) :借鑒信息檢索領(lǐng)域廣泛使用的 NDCG(Normalized Discounted Cumulative Gain)指標(biāo),激勵(lì)模型優(yōu)先檢索相關(guān)度高的圖像內(nèi)容,快速構(gòu)建高質(zhì)量上下文;

模式一致性獎(jiǎng)勵(lì) :確保模型遵循預(yù)設(shè)的推理邏輯路徑,避免因模式偏差導(dǎo)致生成結(jié)果偏離任務(wù)目標(biāo);

生成質(zhì)量獎(jiǎng)勵(lì) :通過(guò)評(píng)估模型對(duì)生成答案的質(zhì)量打分,引導(dǎo)模型輸出更準(zhǔn)確、連貫的答案。

這種多維度獎(jiǎng)勵(lì)機(jī)制實(shí)現(xiàn)了檢索與推理的雙向驅(qū)動(dòng)——高效的檢索為深入推理提供支撐,而推理反饋又進(jìn)一步指導(dǎo)模型優(yōu)化檢索策略,形成閉環(huán)優(yōu)化。

?? 強(qiáng)化學(xué)習(xí)賦能多模態(tài)智能體訓(xùn)練

VRAG-RL 基于強(qiáng)化學(xué)習(xí)的訓(xùn)練策略,引入業(yè)界領(lǐng)先的 GRPO 算法,讓視覺(jué)語(yǔ)言模型(VLMs)在與搜索引擎的多輪交互中,持續(xù)優(yōu)化檢索與推理能力。

同時(shí),通過(guò)本地部署搜索引擎模擬真實(shí)世界應(yīng)用場(chǎng)景,實(shí)現(xiàn)搜索引擎調(diào)用零成本,模型訓(xùn)練更加高效。這種訓(xùn)練方式,不僅提升了模型的泛化能力,使其在不同領(lǐng)域、不同類型的視覺(jué)任務(wù)中都能表現(xiàn)出色,為多模態(tài)智能體的訓(xùn)練提供全新的解決方案。

實(shí)驗(yàn)分析

VRAG-RL 在多個(gè)視覺(jué)語(yǔ)言基準(zhǔn)數(shù)據(jù)集上均取得了顯著優(yōu)于現(xiàn)有方法的性能表現(xiàn),任務(wù)類型涵蓋從單跳到多跳推理、從純文本理解到圖表識(shí)別和復(fù)雜布局解析等多種視覺(jué)豐富場(chǎng)景。實(shí)驗(yàn)結(jié)果表明,VRAG-RL 在處理視覺(jué)信息時(shí)展現(xiàn)出更強(qiáng)的檢索能力、推理深度以及生成質(zhì)量。

無(wú)論是在傳統(tǒng)的 prompt-based 方法(如 Vanilla RAG 和 ReAct RAG),還是在基于強(qiáng)化學(xué)習(xí)的方法(如 Search-R1)基礎(chǔ)上,VRAG-RL 都展現(xiàn)出了更出色的綜合性能。

在傳統(tǒng)的RAG方法中,模型通常在進(jìn)行一次或多次檢索后直接生成答案。然而,在處理復(fù)雜的視覺(jué)任務(wù)時(shí),這種方法往往表現(xiàn)不佳,因?yàn)樗狈?duì)視覺(jué)信息的深入理解和多輪推理能力。

相比之下,我們的VRAG-RL方法支持多輪交互。具體來(lái)說(shuō),通過(guò)定義視覺(jué)感知?jiǎng)幼骺臻g,VRAG-RL能夠在推理階段逐步聚焦于信息密集區(qū)域,從而實(shí)現(xiàn)從粗到細(xì)的信息獲取。同時(shí),該方法通過(guò)優(yōu)化檢索效率和推理路徑,在保持高效率的同時(shí),顯著提升了模型在視覺(jué)任務(wù)上的性能。

未來(lái)展望:開(kāi)啟視覺(jué)感知驅(qū)動(dòng)多模態(tài)推理的新時(shí)代

VRAG-RL為視覺(jué)豐富信息的檢索增強(qiáng)生成任務(wù)開(kāi)辟了新的道路。未來(lái),研究團(tuán)隊(duì)計(jì)劃進(jìn)一步拓展模型的能力,引入更多模仿人類處理復(fù)雜信息的動(dòng)作,使模型能夠更深入地進(jìn)行思考。同時(shí),團(tuán)隊(duì)還將致力于減少模型的幻覺(jué)現(xiàn)象,通過(guò)引入更先進(jìn)的模型架構(gòu)和訓(xùn)練方法,進(jìn)一步提高框架的準(zhǔn)確性和可靠性,推動(dòng)視覺(jué)語(yǔ)言模型在更多實(shí)際應(yīng)用場(chǎng)景中的落地與發(fā)展。

我們已將 VRAG-RL 的完整技術(shù)方案發(fā)布在 arXiv,并將全部源代碼開(kāi)源至 GitHub。為了便于大家快速體驗(yàn)與二次開(kāi)發(fā),我們?cè)陧?xiàng)目中提供了可一鍵運(yùn)行的 Demo 示例,支持本地快速部署。你可以輕松使用自己的文檔構(gòu)建視覺(jué) RAG 推理服務(wù),探索多模態(tài)智能體在復(fù)雜圖像理解任務(wù)中的強(qiáng)大能力。

本文轉(zhuǎn)載自??NLP前沿???