除了RAG,還有這五種方法消除大模型幻覺 原創

出品 | 51CTO技術棧(微信號:blog51cto)

眾所周知,LLM會產生幻覺——即生成不正確、誤導性或無意義的信息。

有意思的是,一些人,如OpenAI的CEO Sam Altman,將AI的幻覺視為創造力,而另一些人則認為幻覺可能有助于做出新的科學發現。

然而,在大多數情況下,提供正確回答至關重要,幻覺并不是一項特性,而是一種缺陷。

那么,如何減少LLM的幻覺呢?長上下文?RAG?微調?

其實,長上下文LLMs并非萬無一失,向量搜索RAG也不盡如人意,而微調則伴隨著其自身的挑戰和限制。

下面是一些可以用來減少LLM幻覺的高級技術。

1.高級提示詞

關于使用更好或更高級的提示詞(prompts)是否能解決大型語言模型(LLM)的幻覺問題,確實存在很多討論。

圖片

圖片

雖然一些人認為編寫更詳細的提示詞對解決(幻覺)問題沒有幫助,但谷歌大腦(Google Brain)的聯合創始人吳恩達(Andrew Ng)等人卻看到了其中的潛力。

吳恩達認為,GPT-4和其他先進模型的推理能力使它們非常擅長解釋帶有詳細說明的復雜提示詞。

圖片

圖片

“通過多示例學習,開發者可以在提示詞中給出數十個,甚至數百個示例,這比少示例學習更為有效,”他寫道。

圖片

圖片

為了改進提示詞,許多新的進展也在不斷涌現,比如Anthropic公司于5月10日發布了一款新的“Prompt Generator”工具,該工具可以將簡單的描述轉化為針對大型語言模型(LLMs)優化的高級提示詞。通過Anthropic控制臺,就可以生成用于生產的提示詞。

最近,馬克·安德森(Marc Andreessen)也表示,通過正確的提示,我們可以解鎖AI模型中的潛在超級天才。“在不同領域的提示技術可以解鎖這種潛在超級天才”,他補充道。

2.Meta AI的Chain-of-Verification(CoVe)

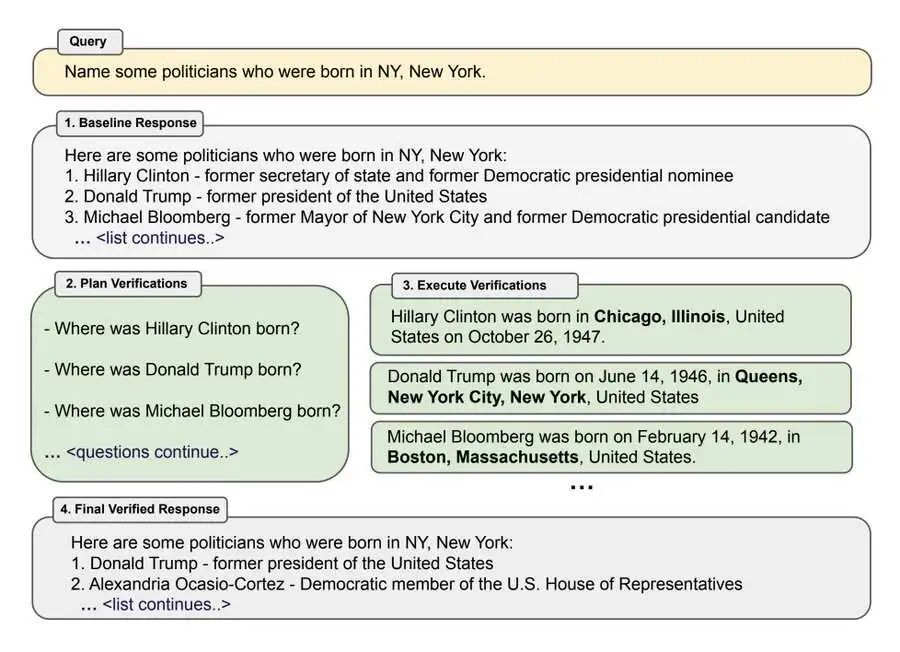

Meta AI的Chain-of-Verification(CoVe)是另一種技術。這種方法通過將事實核查分解為可管理的步驟,提高響應準確性,并與人類驅動的事實核查過程保持一致,來減少大型語言模型(LLMs)的幻覺現象。

圖片

圖片

CoVe涉及生成初始響應、規劃驗證問題、獨立回答這些問題,并生成最終經過驗證的響應。通過系統地驗證和糾正其輸出,這種方法顯著提高了模型的準確性。

它通過減少幻覺并增加事實正確性,在各種任務中提高了性能,如基于列表的問題、閉卷問答和長篇文本生成等。

3.知識圖譜

RAG(檢索增強的生成)不再局限于向量數據庫匹配,目前引入了許多先進的RAG技術,顯著提高了檢索效果。

圖片

圖片

例如,將知識圖譜(KGs)集成到RAG中。通過利用知識圖譜中結構化且相互關聯的數據,可以大大增強當前RAG系統的推理能力。

4.Raptor

另一種技術是Raptor,該方法通過創建更高層次的抽象來處理跨越多個文檔的問題。它在回答涉及多個文檔概念的查詢時特別有用。

圖片

圖片

像Raptor這樣的方法與長上下文大型語言模型(LLMs)非常契合,因為你可以直接嵌入整個文檔而無需分塊。

該方法通過將外部檢索機制與變換器模型集成來減少幻覺現象。當接收到查詢時,Raptor首先從外部知識庫中檢索相關且經過驗證的信息。

然后,將這些檢索到的數據與原始查詢一起嵌入到模型的上下文中。通過將模型的響應基于事實和相關信息,Raptor確保生成的內容既準確又符合上下文。

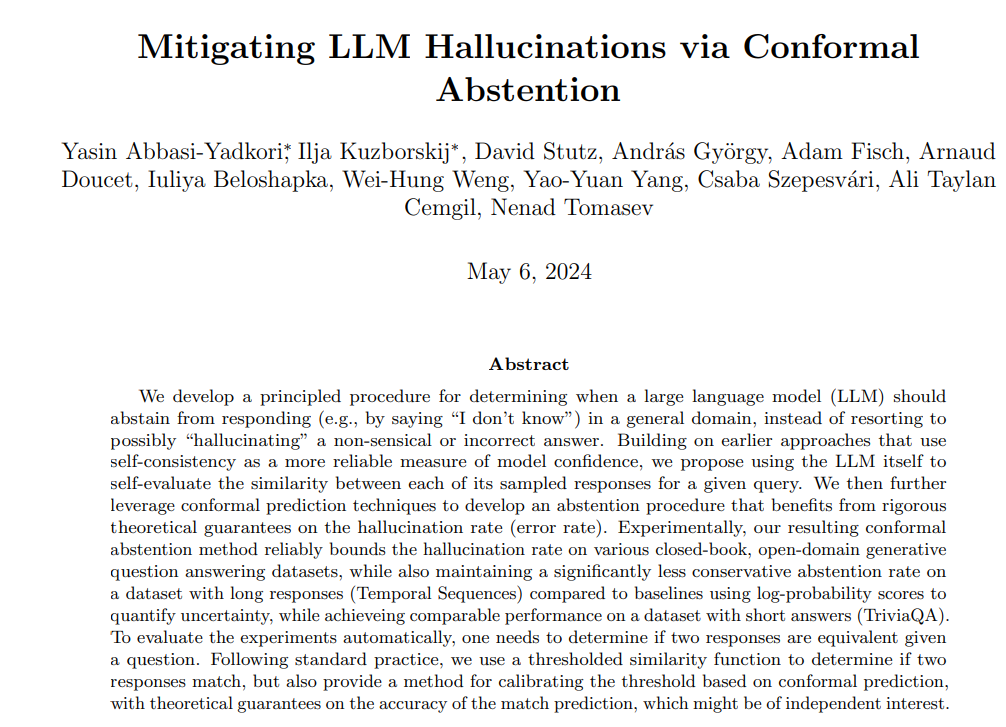

5.共形抽離(Conformal Abstention)

論文《通過共形抽離緩解大型語言模型的幻覺現象》介紹了一種通過應用共形預測技術來確定模型何時應該避免給出響應,從而減少大型語言模型(LLMs)中的幻覺現象的方法。

圖片

圖片

通過使用自我一致性來評估響應的相似性,并利用共形預測進行嚴格的保證,該方法確保模型只在對其準確性有信心時才做出響應。

這種方法在保持平衡的抽離率的同時,有效地限制了幻覺現象的發生率,特別有利于需要長篇回答的任務。它通過避免錯誤或不合邏輯的響應,顯著提高了模型輸出的可靠性。

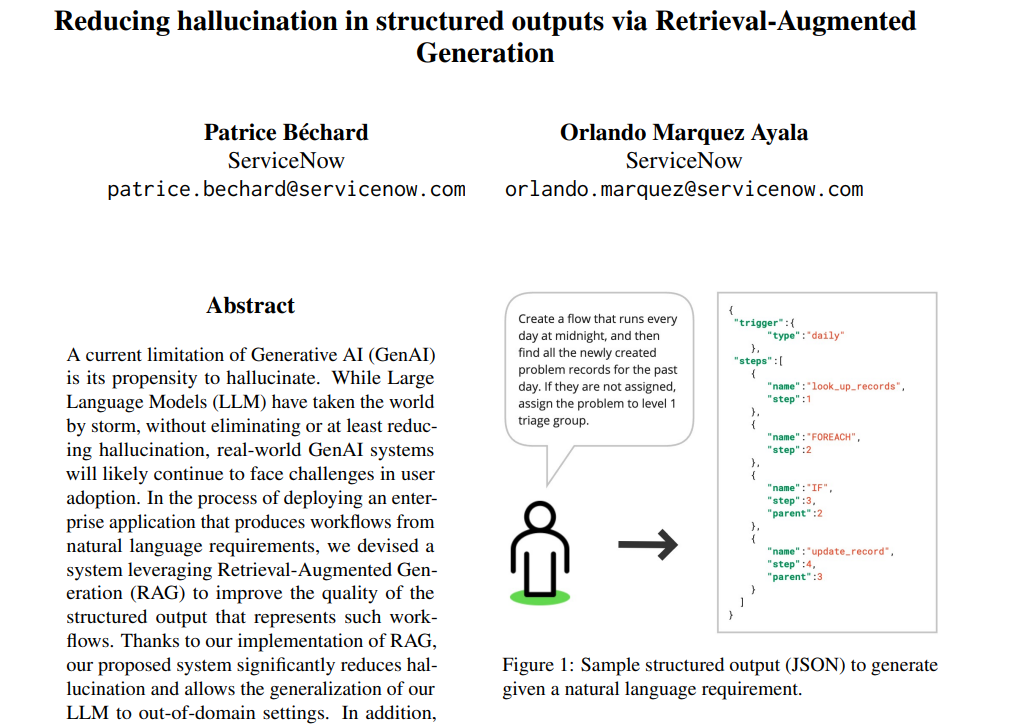

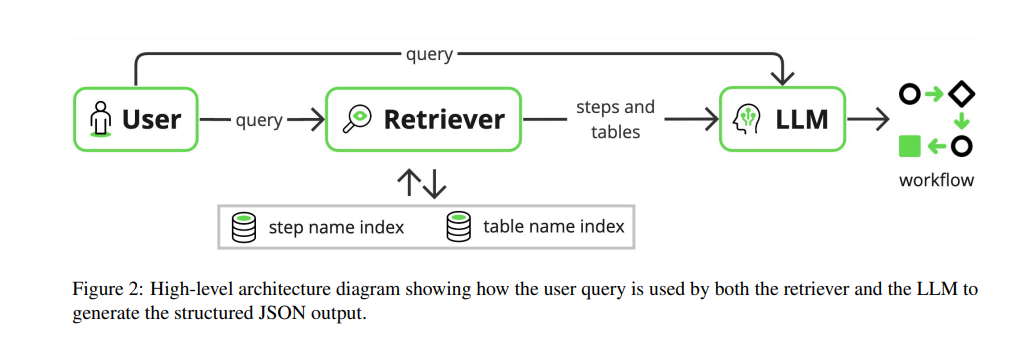

6.RAG減少結構化輸出中的幻覺現象

最近,ServiceNow通過RAG減少了結構化輸出中的幻覺現象,提高了大型語言模型(LLM)的性能,實現了域外泛化,同時最小化了資源使用。

圖片

圖片

該技術涉及一個RAG系統,該系統在生成文本之前從外部知識庫中檢索相關的JSON對象。這確保了生成過程基于準確且相關的數據。

圖片

圖片

通過融入這一預檢索步驟,模型不太可能產生錯誤或捏造的信息,從而減少了幻覺現象。此外,這種方法允許使用較小的模型而不犧牲性能,使其既高效又有效。

本文轉載自??51CTO技術棧??