用基礎(chǔ)模型指導(dǎo)特征傳播,首個泛化型圖像匹配器OmniGlue搞定未見過域

對于想要獲取兩張圖像之間的細(xì)粒度視覺對應(yīng)關(guān)系而言,局部圖像特征匹配技術(shù)是高不錯的 xuanz,對于實現(xiàn)準(zhǔn)確的相機姿態(tài)估計和 3D 重建至關(guān)重要。過去十年見證了從手工制作到基于學(xué)習(xí)的圖像特征的演變。

最近,研究社區(qū)又提出了新穎的可學(xué)習(xí)圖像匹配器,在傳統(tǒng)基準(zhǔn)上實現(xiàn)了性能的不斷改進。盡管已經(jīng)取得了長足的進步,但這些進展忽略了一個重要方面:圖像匹配模型的泛化能力。

如今,大多數(shù)局部特征匹配研究都集中在具有豐富訓(xùn)練數(shù)據(jù)的特定視覺領(lǐng)域(如室外和室內(nèi)場景),這就導(dǎo)致了模型高度專用于訓(xùn)練領(lǐng)域。遺憾的是,這些方法的性能在域外數(shù)據(jù)(如以對象為中心或空中捕獲)上通常急劇下降,在某些情況下甚至可能并不比傳統(tǒng)方法好很多。

因此,傳統(tǒng)的域無關(guān)技術(shù)(如 SIFT)仍被廣泛用于獲取下游應(yīng)用的姿態(tài)。并且由于收集高質(zhì)量注釋的成本很高,在每個圖像域都有豐富的訓(xùn)練數(shù)據(jù)是不現(xiàn)實的,就像其他一些視覺任務(wù)一樣。因此,社區(qū)應(yīng)該專注于開發(fā)架構(gòu)改進,使得可學(xué)習(xí)的匹配方法具有泛化能力。

近日,受上述觀察的啟發(fā),德克薩斯大學(xué)奧斯汀分校和谷歌研究院的研究者聯(lián)合提出了 OmniGlue,這是第一個以泛化為核心原則設(shè)計的可學(xué)習(xí)圖像匹配器。在與域無關(guān)的局部特征基礎(chǔ)上,他們引入了用于提高匹配層泛化性能的新技術(shù):基礎(chǔ)模型指導(dǎo)和關(guān)鍵點位置注意力指導(dǎo)。

- 論文地址:https://arxiv.org/pdf/2405.12979

- 項目主頁:https://hwjiang1510.github.io/OmniGlue/?

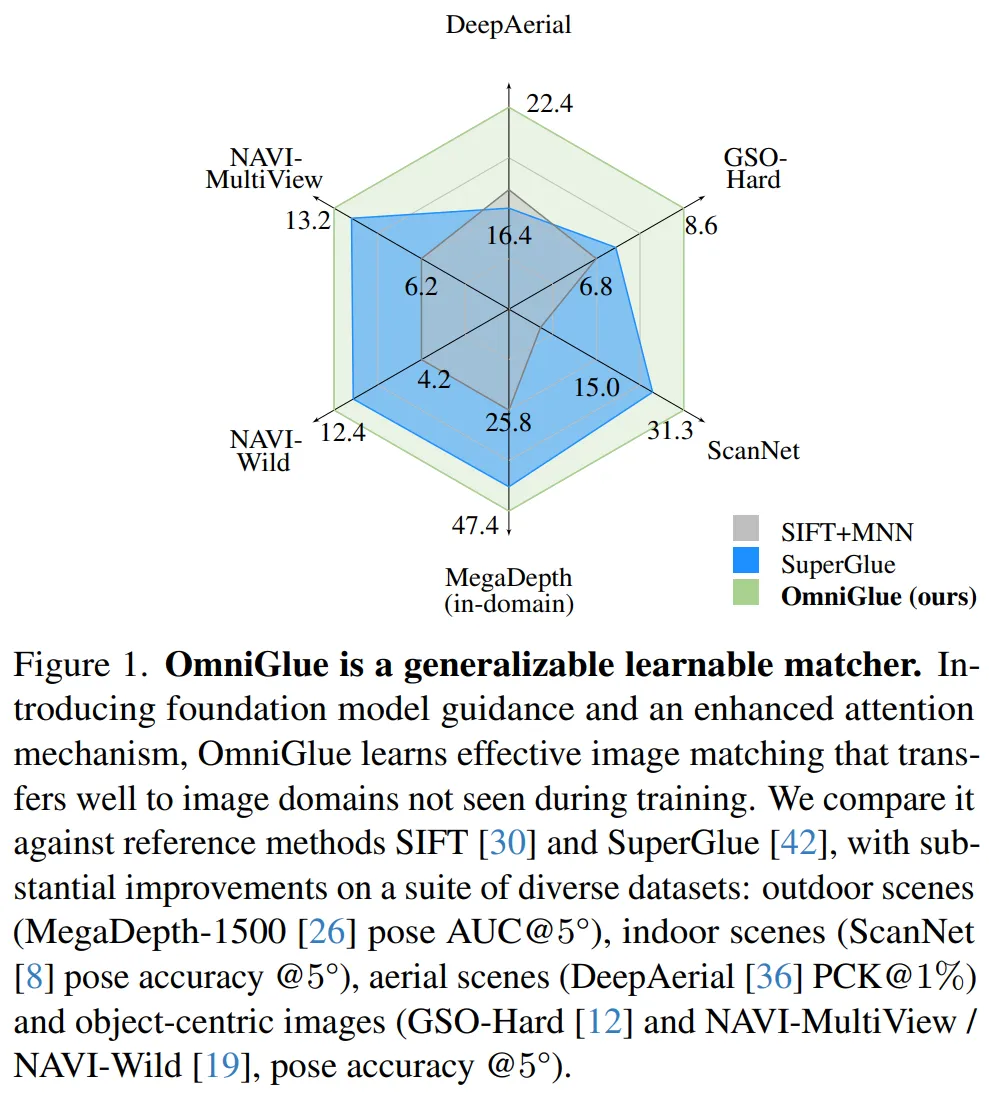

如圖 1 所示,通過引入的技術(shù),OmniGlue 能夠在分布外領(lǐng)域上實現(xiàn)更好泛化性能,同時保持源領(lǐng)域上的高質(zhì)性能。

研究者首先整合了基礎(chǔ)模型的廣泛視覺知識。通過對大規(guī)模數(shù)據(jù)進行訓(xùn)練,基礎(chǔ)視覺模型 DINOv2 在各種圖像域中的各種任務(wù)(包括穩(wěn)健的區(qū)域級匹配)中表現(xiàn)良好。盡管基礎(chǔ)模型所產(chǎn)生匹配結(jié)果的粒度有限,但當(dāng)專門的匹配器無法處理域位移時,這些模型可以為潛在的匹配區(qū)域提供可泛化的指導(dǎo)。因此,他們使用 DINO 來指導(dǎo)圖像間特征傳播過程,降低不相關(guān)的關(guān)鍵點并鼓勵模型融合來自潛在可匹配區(qū)域的信息。

接著利用關(guān)鍵點位置信息來指導(dǎo)信息傳播過程。研究者發(fā)現(xiàn),當(dāng)模型應(yīng)用于不同領(lǐng)域時,以往的位置編碼策略會損害性能。這促使他們與用于估計對應(yīng)關(guān)系的匹配描述符區(qū)分開來。研究者提出了一種新穎的關(guān)鍵點位置指導(dǎo)注意力機制,從而避免過于專注關(guān)鍵點的訓(xùn)練分布和相對姿態(tài)變換。

通過實驗,研究者評估了 OmniGlue 在各種視覺領(lǐng)域的泛化能力,包括合成圖像和真實圖像,從場景級到以對象為中心和空中數(shù)據(jù)集,期間使用小基線和寬基線相機。與以往工作相比,OmniGlue 展示出顯著的改進。

方法概覽

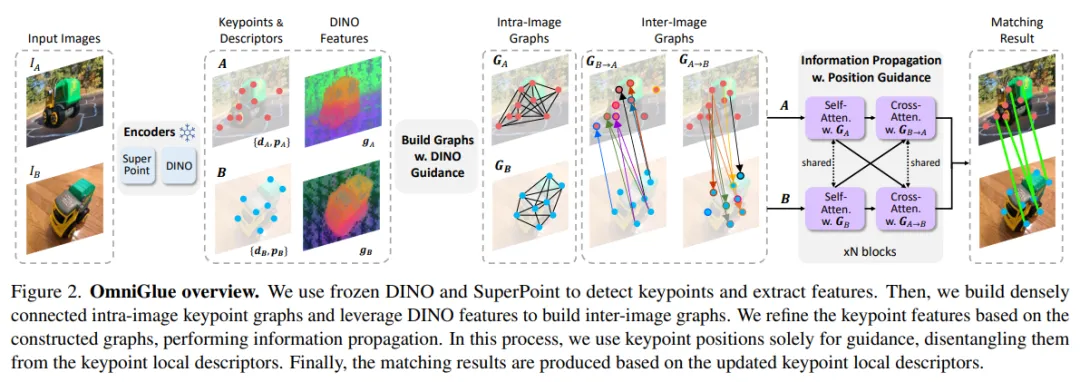

下圖 2 概述了 OmniGlue 方法,主要包括以下四個階段。

首先,研究者使用兩種互補類型的編碼器提取圖像特征,包括了專注于通用細(xì)粒度匹配的 SuperPoint 以及對粗略但廣泛的視覺知識進行編碼的視覺基礎(chǔ)模型 DINOv2。

其次,研究者使用這些特征構(gòu)建關(guān)鍵點關(guān)聯(lián)圖,包括圖像內(nèi)和圖像間。

第三,研究者基于構(gòu)建的圖在兩張圖像中的關(guān)鍵點之間傳播信息,分別使用自注意力層和交叉注意力層進行圖像內(nèi)和圖像間通信。

最后,一旦獲得改進后的描述符,研究者應(yīng)用最佳匹配層來生成兩張圖像中關(guān)鍵點之間的映射。

在具體細(xì)節(jié)上,OmniGlue 方法主要包含以下幾步。

特征提取。輸入是兩張具有共享內(nèi)容的圖像,表示為 I_A 和 I_B。研究者將這兩張圖像的 SuperPoint 關(guān)鍵點集表示為 A := {A_1, ..., A_N } 和 B := {B_1, ..., B_M}。N 和 M 分別是 I_A 和 I_B 的已識別關(guān)鍵點的數(shù)量。每個關(guān)鍵點都與其 SuperPoint 局部描述符 d ∈ R^C 相關(guān)聯(lián)。

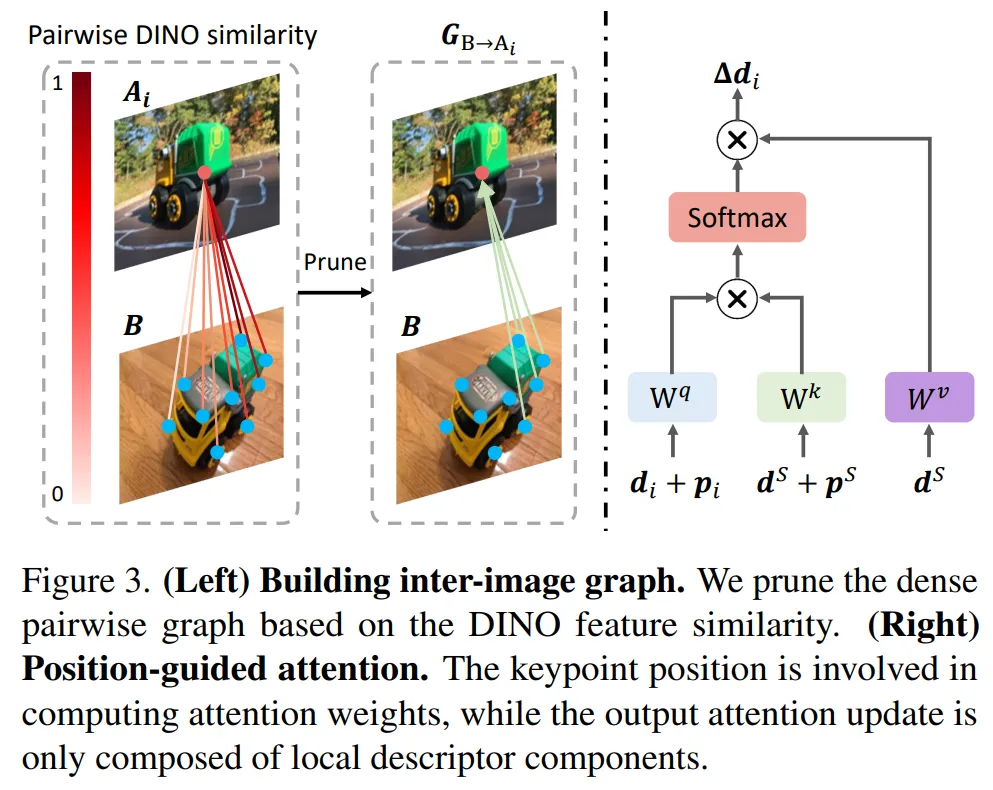

利用 DINOv2 構(gòu)建圖形。研究者利用 DINOv2 特征來指導(dǎo)圖像間圖形的構(gòu)建。如下圖 3(左)所示,他們以 G_B→A_i 為例。對于關(guān)鍵點集合 A 中的每個關(guān)鍵點 A_i,研究者計算其與集合 B 中所有關(guān)鍵點的 DINOv2 特征相似度。

具有新穎指導(dǎo)的信息傳播。研究者根據(jù)關(guān)鍵點圖執(zhí)行信息傳播,這一模塊包含了多個塊,每個塊都有兩個注意力層。第一個基于圖像內(nèi)圖更新關(guān)鍵點,執(zhí)行自注意力;第二個基于圖像間圖更新關(guān)鍵點,執(zhí)行交叉注意力。

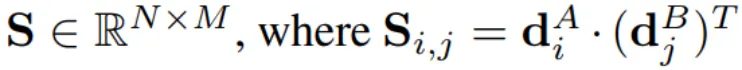

匹配層和損失函數(shù)。使用改進的關(guān)鍵點表示來生成成對相似度矩陣:

對比 SuperGlue 和 LightGlue

SuperGlue 和 LightGlue 都使用注意力層進行信息傳播。不同的是,OmniGlue 利用基礎(chǔ)模型來指導(dǎo)這個過程,這對遷移到訓(xùn)練期間未觀察到的圖像域有很大幫助。

在局部描述符改進方面,與 SuperGlue 不同,OmniGlue 解耦了位置和外觀特征。作為參考,SuperGlue 將關(guān)鍵點表示為 d + p,將兩個特征糾纏在一起,其中位置特征也用于產(chǎn)生匹配結(jié)果。

與 OmniGlue 的設(shè)計類似,LightGlue 消除了更新的描述符對位置特征的依賴,但提出了一種非常具體的位置編碼公式,基于旋轉(zhuǎn)編碼,并且僅在自注意力層中。

總之,SuperGlue 是最接近 OmniGlue 的模型,可作為直接對比的參考。也因此,研究者使用 SuperGlue 作為實驗驗證的主要參考比較。

實驗結(jié)果

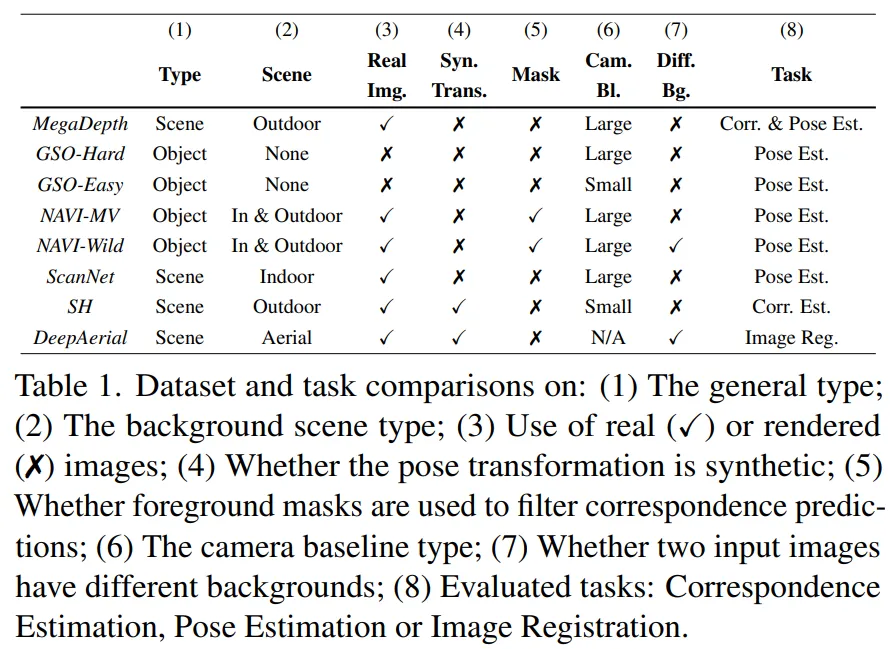

研究者在下表 1 中列出了用于評估 OmniGlue 的數(shù)據(jù)集和任務(wù)。

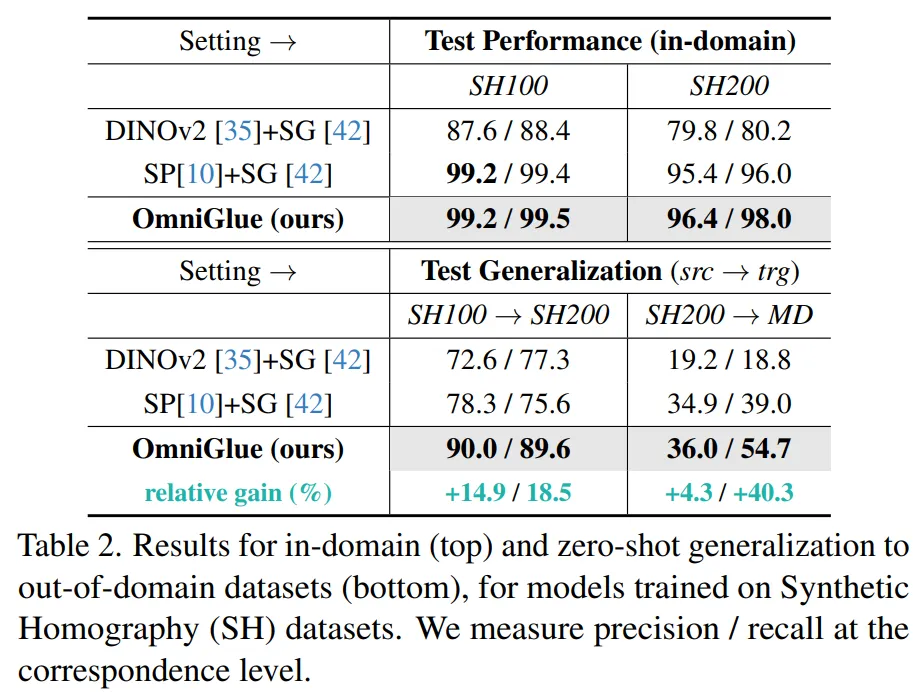

從 Synthetic Homography(SH)到 MegaDepth(MD)數(shù)據(jù)集,如下表 2 所示,與基礎(chǔ)方法 SuperGlue 相比,OmniGlue 不僅在領(lǐng)域內(nèi)數(shù)據(jù)上表現(xiàn)出優(yōu)異的性能,而且還表現(xiàn)出強大的泛化能力。

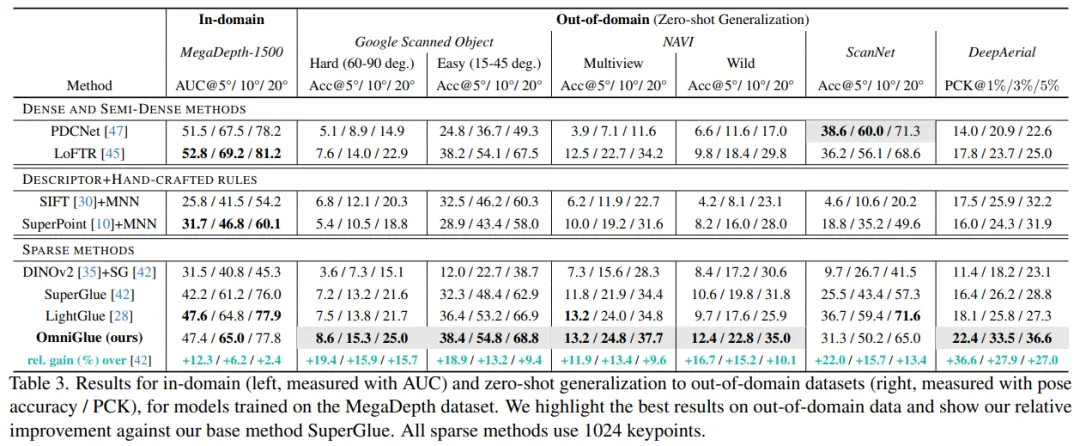

從 MegaDepth(MD)到其他領(lǐng)域,如下表 3 所示,OmniGlue 不僅在 MegaDepth-1500 上實現(xiàn)了與 SOTA 稀疏匹配器 LightGlue 相當(dāng)?shù)男阅埽遗c所有其他方法相比,在 6 個新領(lǐng)域中的 5 個領(lǐng)域中表現(xiàn)出更好的泛化能力。

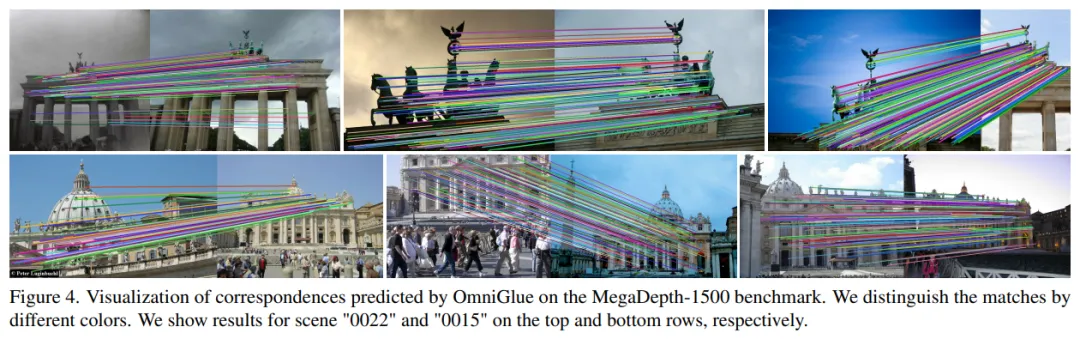

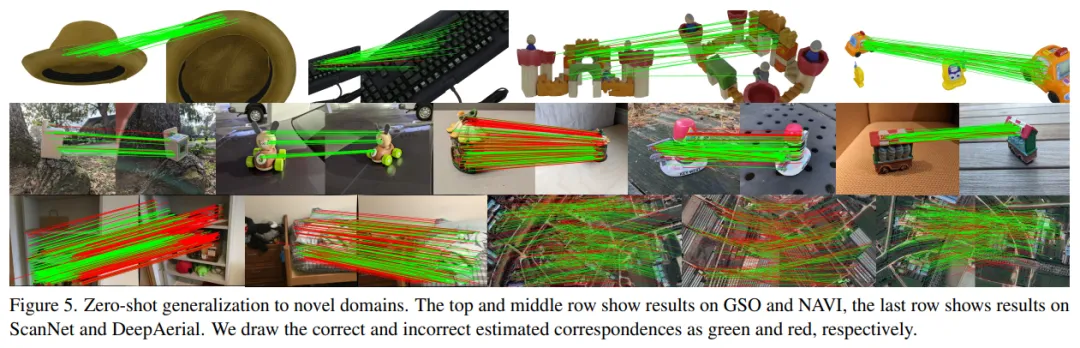

研究者在下圖 5 和圖 4 中分別展示了新領(lǐng)域上的零樣本泛化性能以及在源領(lǐng)域上的性能。

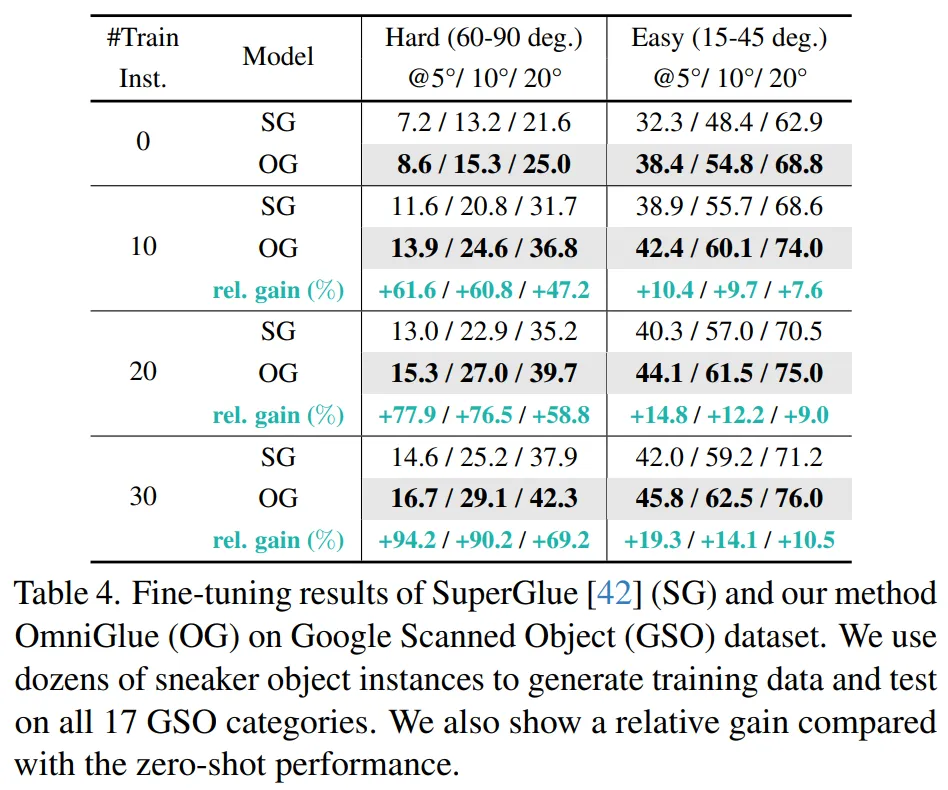

最后如下表 4 所示,OmniGlue 更容易適應(yīng)目標(biāo)領(lǐng)域。

更多技術(shù)細(xì)節(jié)和實驗結(jié)果請參閱原論文。

本文轉(zhuǎn)自 機器之心 ,作者:機器之心