MongoDB Auto-Sharding 解決了海量存儲和動態擴容的問題但離實際生產環境所需的高可靠、高可用還有些距離所以有了” Replica Sets + Sharding”的解決方案����。

MongoDB Auto-Sharding 解決了海量存儲和動態擴容的問題但離實際生產環境所需的高可靠����、高可用還有些距離所以有了” Replica Sets + Sharding”的解決方案。

1、Shard:

使用 Replica Sets確保每個數據節點都具有備份����、自動容錯轉移����、自動恢復能力。

2、Config:

使用3 個配置服務器確保元數據完整性

3����、Route:

使用3 個路由進程實現負載平衡提高客戶端接入性能

以下我們配置一個 Replica Sets + Sharding 的環境架構圖如下

開放的端口如下

| 主機 |

ip |

服務及端口 |

| Server A |

192.168.3.231 |

mongod shard1_1:27017

mongod shard2_1:27018

mongod config1:20000

mongs1:30000 |

| Server B |

192.168.3.232 |

mongod shard1_2:27017

mongod shard2_2:27018

mongod config2:20000

mongs2:30000 |

| Server C |

192.168.3.233 |

mongod shard1_3:27017

mongod shard2_3:27018

mongod config3:20000

mongs3:30000 |

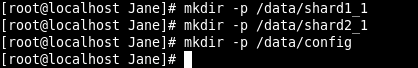

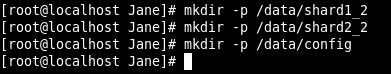

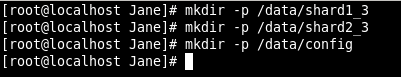

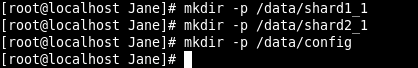

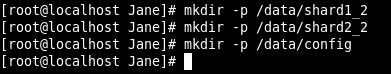

創建數據目錄

在Server A 上:

在Server B 上:

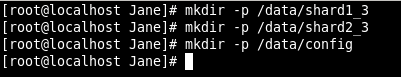

在Server C 上:

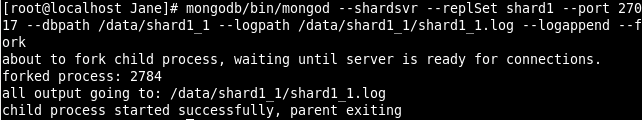

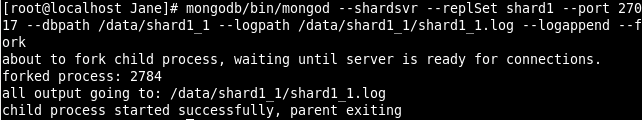

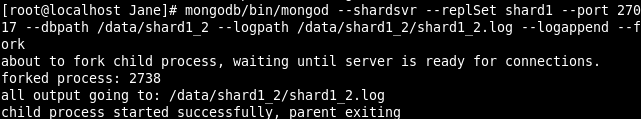

配置Replica Sets

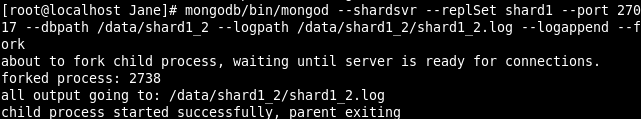

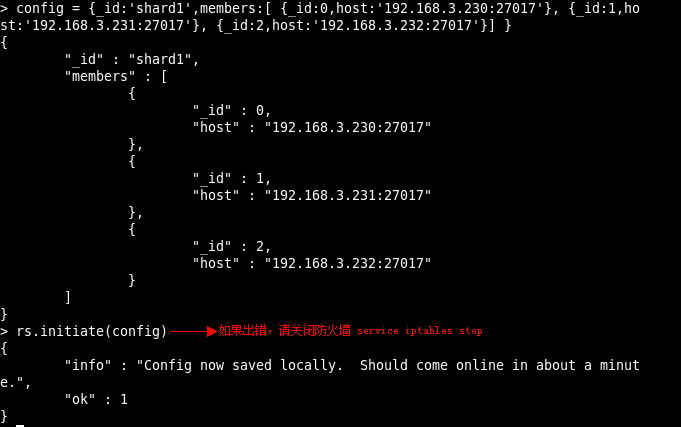

1����、配置shard1所用到的Replica Sets

在Server A 上:

在Server B 上:

在Server C 上:

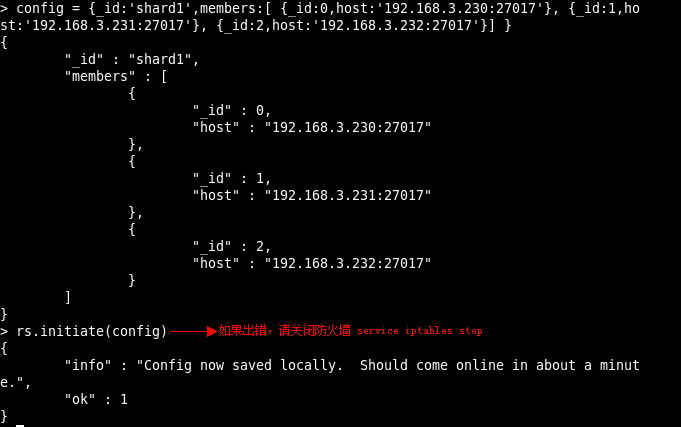

用mongo 連接其中一臺機器的27017 端口的mongod初始化Replica Sets“shard1”執行:

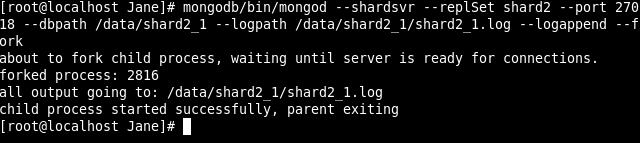

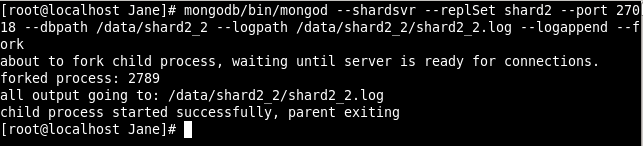

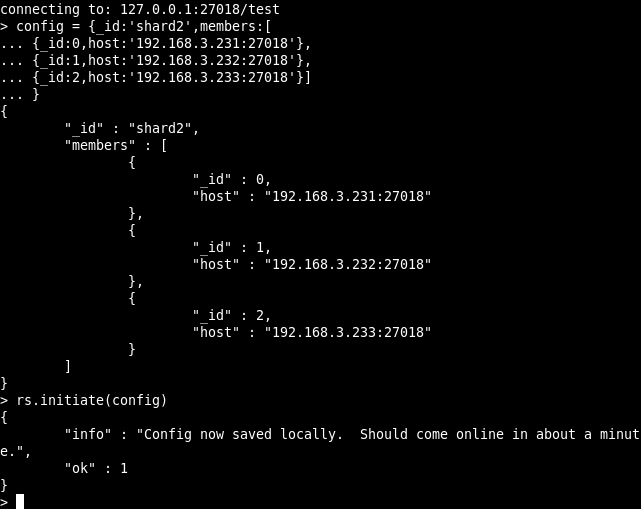

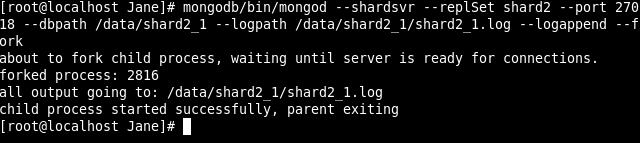

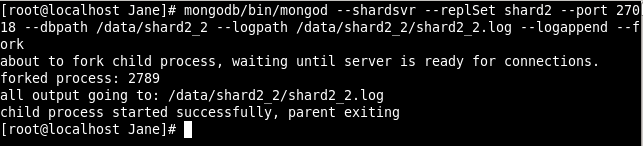

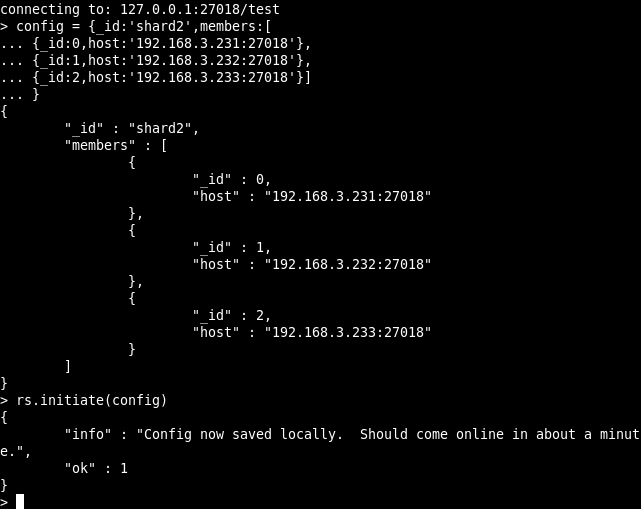

配置shard2所用到的Replica Sets

在Server A 上:

在Server B 上:

在Server C 上:

用mongo 連接其中一臺機器的27018 端口的mongod����,初始化Replica Sets “shard2”,執行:

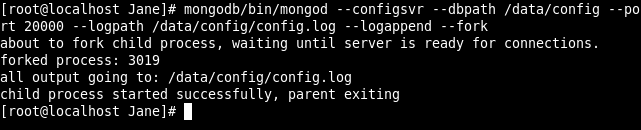

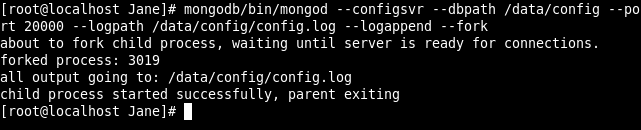

配置3 臺Config Server

在Server A����、B����、C上執行:

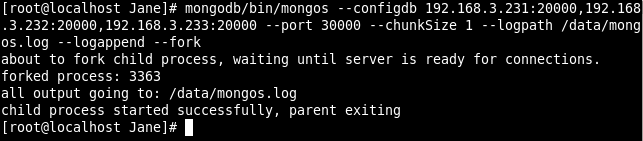

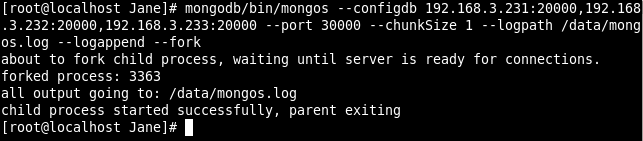

配置3 臺Route Process

在Server A����、B、C上執行:

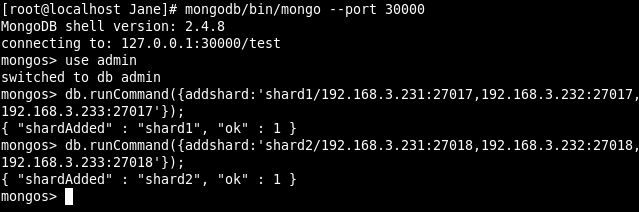

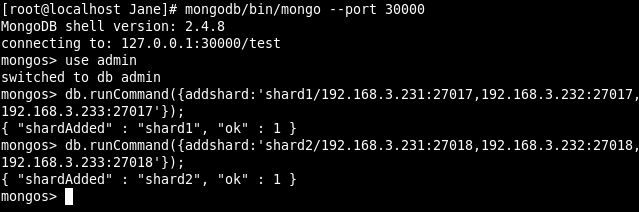

配置Shard Cluster

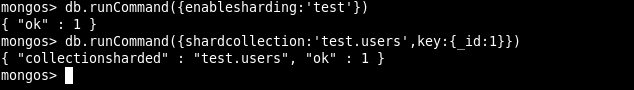

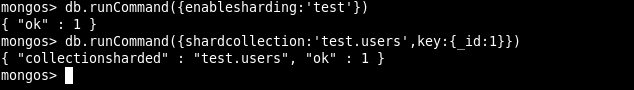

激活數據庫及集合的分片

驗證Sharding正常工作

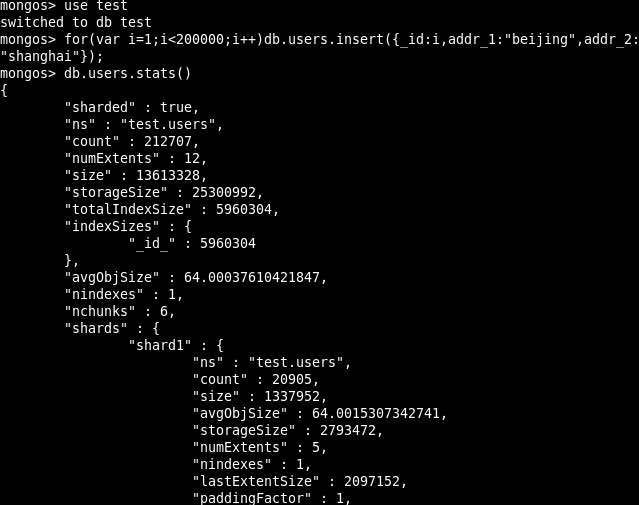

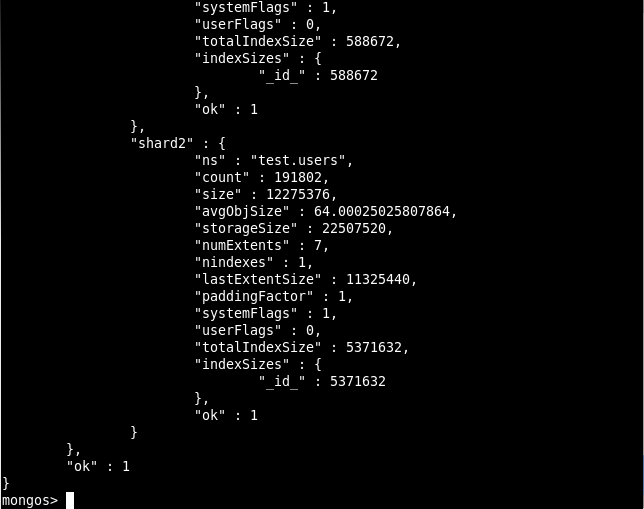

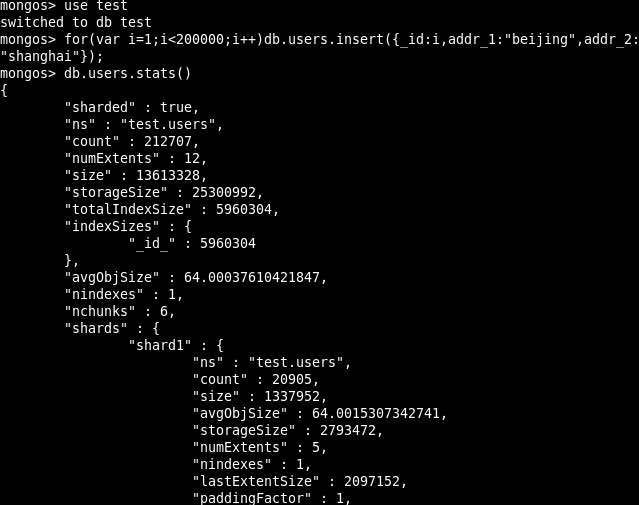

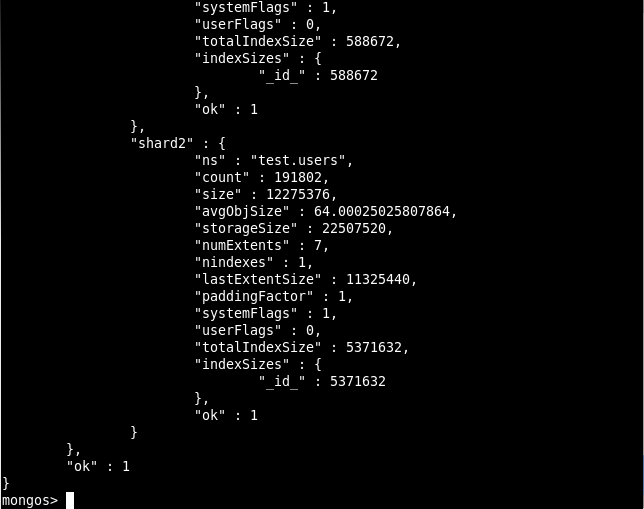

連接到其中一臺機器的端口30000 的mongos 進程,并切換到test 數據庫,以便添加測試數據

可以看到Sharding搭建成功了����,跟我們期望的結果一致����,至此我們就將Replica Sets與Sharding

結合的架構也學習完畢了����。

本文出自 “phper-每天一點點~” 博客,請務必保留此出處http://janephp.blog.51cto.com/4439680/1332140